為什么生成式 AI 現在大驚小怪?

像 Bing Ai、ChatGPT 等生成式 AI 最近因使用高級算法生成新數據而受到關注,視覺效果以及更多看起來、感覺和閱讀都像人類製作的東西。生成對抗網絡 (GAN) 是創建視覺內容的理想選擇,而生成預訓練 (GPT) 語言模型解析互聯網上已有的數據(或提供的其他專有數據集)以生成輸出,例如查詢的答案,一直到製作完整的“新”文章。在這些方面使用 AI 並不新鮮,但在它如何理解這些查詢並產生對普通用戶來說更易用、更清晰、更相關的輸出方面取得了突破,這使得生成式 AI 成為一個強大的工具。

當然,問題是 爭議多多,但現在還處於早期階段。然而,該技術非常適合創建更多數據來訓練和改進各種模型,這些模型可以快速跟踪一些需要某種形式的推理才能向前邁出最佳步驟的瑣碎或平凡的任務,甚至使全汽車成為現實,汽車驅動仿真模型通過虛擬生成和訓練的無數種新環境數據不斷進行訓練,從而構建更加可靠的預訓練模型。

全球諮詢公司 McKinsey & Company 在 更多見解,以及 可以從生成式 AI 中獲益的各個行業。

(不,本文並未涉及生成式 AI。)

進入 NVIDIA AI 基礎:使公司能夠創建內部自定義生成式 AI 模型

現在我們知道為什么生成式 AI 如此有價值和重要,這讓我們了解了 NVIDIA 大力推動使用雲服務支持企業創建自己的定制大型語言模型(LLM,ChatGPT 是一個典型示例)和視覺生成AI 應用模型。更具體地說,這些自定義生成 AI 模型是使用公司自己的專有數據開發和訓練的,用於其獨特的特定領域產品。

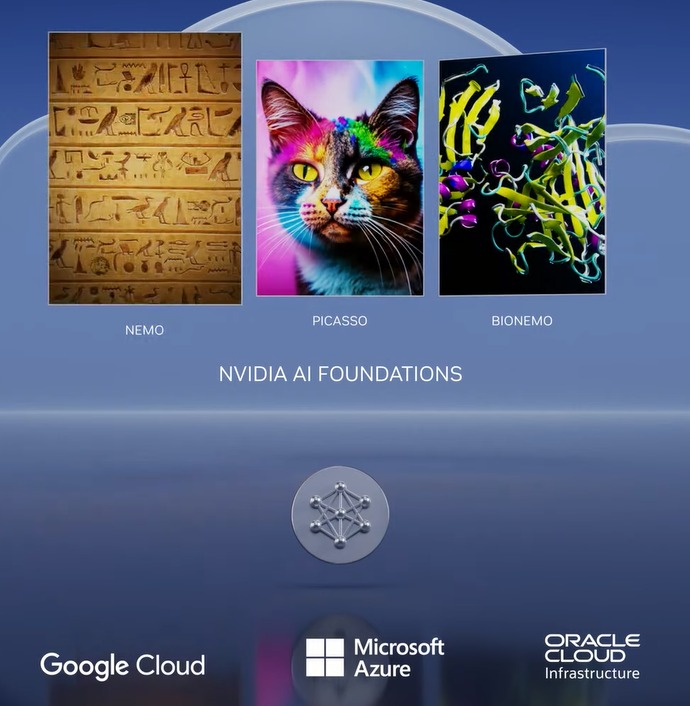

NVIDIA AI Foundations 使這成為可能,它是一組雲服務,使企業能夠構建、完善和運營此類 LLM

NVIDA NeMo 雲服務 使開發人員能夠通過定義重點領域、添加特定領域的知識和教授功能技能,使大型語言模型 (LLM) 與企業更加相關。

NVIDIA Picasso 是一種雲服務,用於構建和部署生成式人工智能圖像、視頻和 3D 應用程序,具有高級文本到圖像、文本到視頻和文本到 3D 功能通過簡單的雲 API 提高創造力、設計和數字模擬的生產力。

NVIDIA BioNeMo 是一項新的雲服務,於今天首次亮相,旨在加速生命科學研究、藥物發現、蛋白質工程以及基因組學、生物學、化學和模塊化動力學領域的研究。

這些服務在 NVIDIA DGX Cloud 上運行,可通過瀏覽器訪問。它們目前可供搶先體驗客戶使用,並處於私人預覽階段。開發人員可以通過簡單的 API 使用在每項服務上提供的這些模型,當模型準備好部署時,企業可以使用 NVIDIA AI Foundations 雲服務大規模運行推理工作負載。

行業領導者與 NVIDIA 合作,提高創意專業人士的生產力

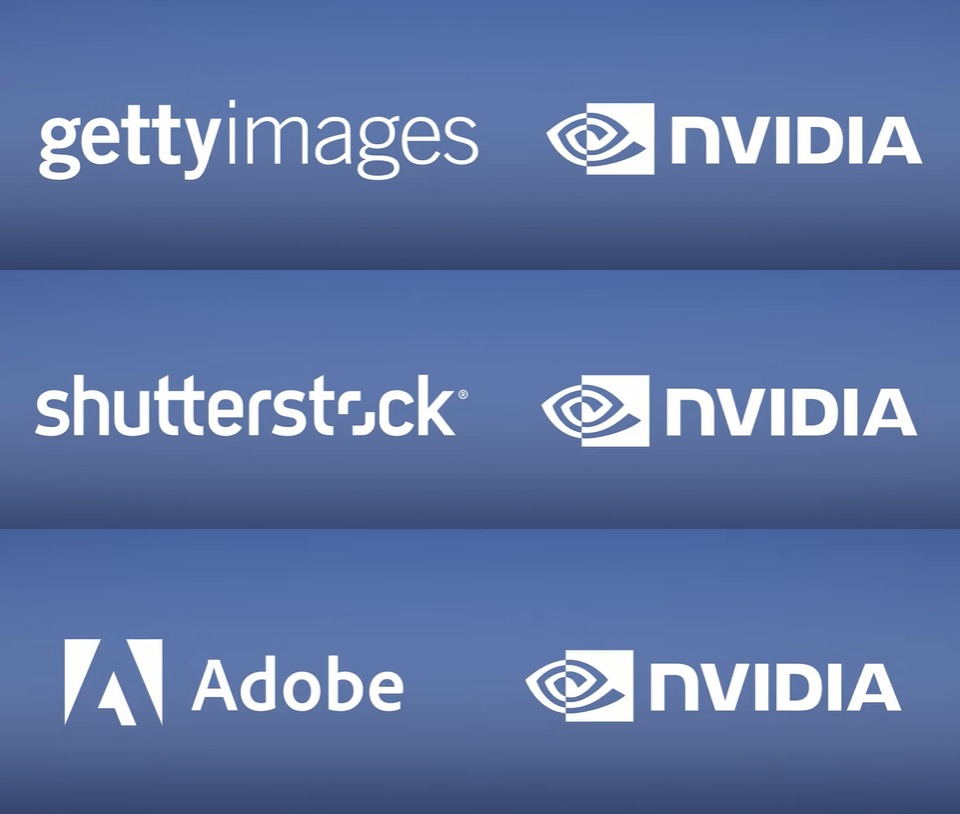

Adobe 今天宣布他們將擴大長期的研發合作夥伴關係,與 NVIDIA 一起創建下一代生成式 AI 模型。為了加快創作者和營銷者的工作流程,其中一些模型將通過 Photoshop、Premiere Pro 和 After Effects 等 Adobe Creative Cloud 旗艦產品以及 NVIDIA Picasso 聯合開發並推向市場。

NVIDIA 和 Getty Images 正在合作訓練負責任的生成文本到圖像和文本到視頻基礎模型。這些模型將允許使用簡單的文本提示創建圖像和視頻,並將在 Getty Images 的完全許可資產上進行訓練。

NVIDIA 和 Shutterstock 正在合作訓練生成文本-to-3D 基礎模型使用 NVIDIA Picasso 服務來簡化詳細 3D 模型的創建,並將構建 3D 模型所需的時間從幾天縮短到幾分鐘。

新的 GPU 為推理平台提供動力以處理各種生成 AI工作負載

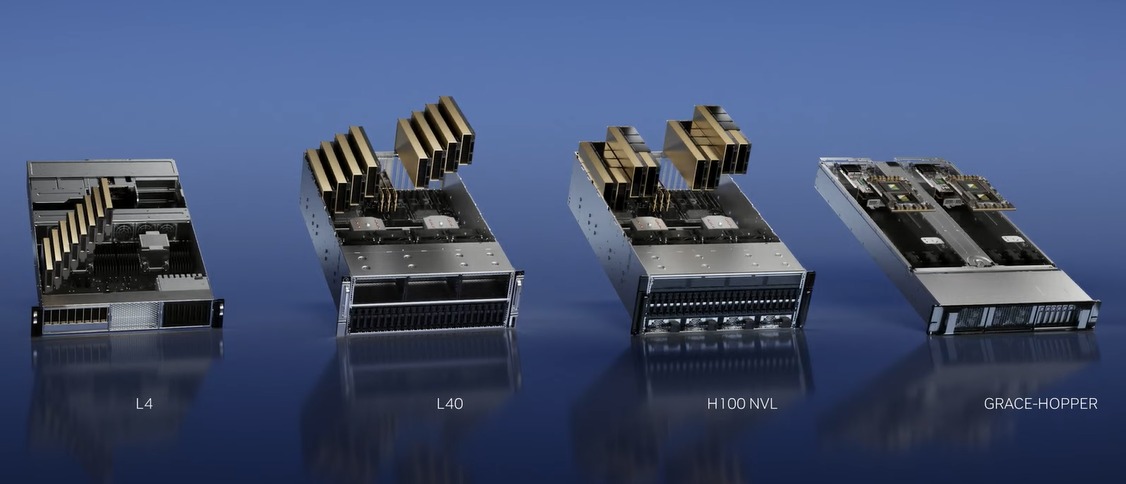

為了增強 NVIDIA 通過 NVIDIA Foundation 雲服務幫助創建新的和新興的自定義生成 AI 模型的努力,他們還推出了一系列新的 GPU 和平台,以幫助開發人員基於 NVIDIA Ada Lovelace 構建和支持這些新的 AI 應用程序, Hopper 和 Grace Hopper 處理器。

生成式 AI 的興起需要更強大的推理能力電子計算平台。生成式 AI 的應用數量是無限的,僅受限於人類的想像力。為開發人員提供最強大、最靈活的推理計算平台將加速新服務的創建,以前所未有的方式改善我們的生活。 – NVIDIA 創始人兼首席執行官黃仁勳。

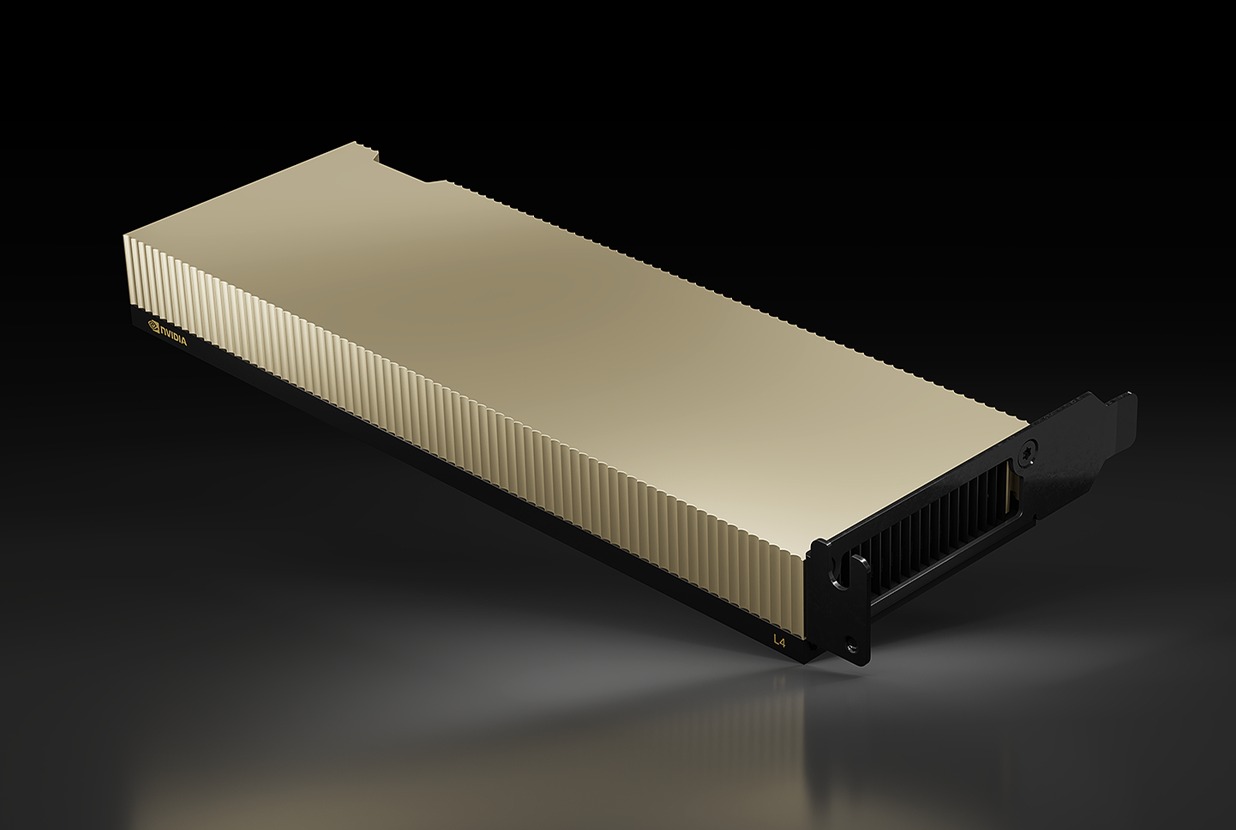

1) 用於 AI 視頻的 NVIDIA L4

新的 NVIDIA L4 是流行的 T4 GPU 的直接替代品,T4 GPU 率先使用 Tensor Core,專為 AI 推理工作負載而設計,以分析新的數據輸入以預測和預測根據預先訓練的模型估計期望的結果。

T4 由 Turing 微架構提供支持,這是第一個支持和加速光線追踪工作負載的架構。新的 L4,基於 Ada Lovelace GPU 架構(這是 GeForce RTX 40 系列的動力),支持 AI 驅動的 DLSS 3,額定實時渲染性能比 Omniverse 提高 4 倍以上,並且能夠拋出光線追踪性能提高 3 倍。

憑藉這種增強的吞吐量,L4 GPU 定位於 AI 視頻工作負載,以處理實時視頻解碼、轉碼、視頻內容審核、語言翻譯、視頻通話增強功能,例如作為背景替換、重新照明、目光接觸、增強現實等。新 GPU 的雙 AV1 編碼器也是 L4 非常適合這些 AI 視頻任務的絕佳原因。事實上,在處理 AI 視頻時,一台 8-GPU L4 服務器可以替代一百多台傳統的雙路 CPU 服務器。與舊的基礎設施相比,這大大節省了總擁有成本。

更好的是,L4 還採用相同的低調外形和略低的 72W 功率包絡設計,這使得升級現有的 T4 供電成為可能具有 L4 的服務器輕而易舉,同時大幅提高 AI 推理能力。

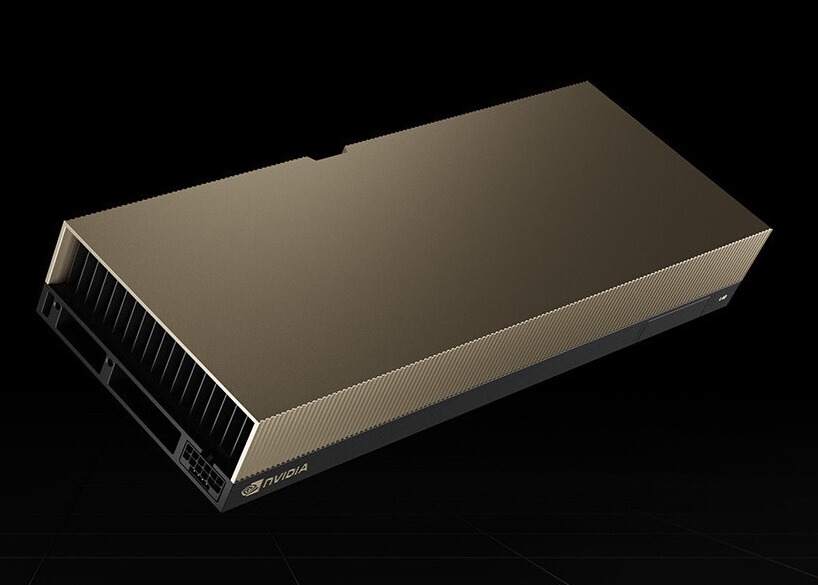

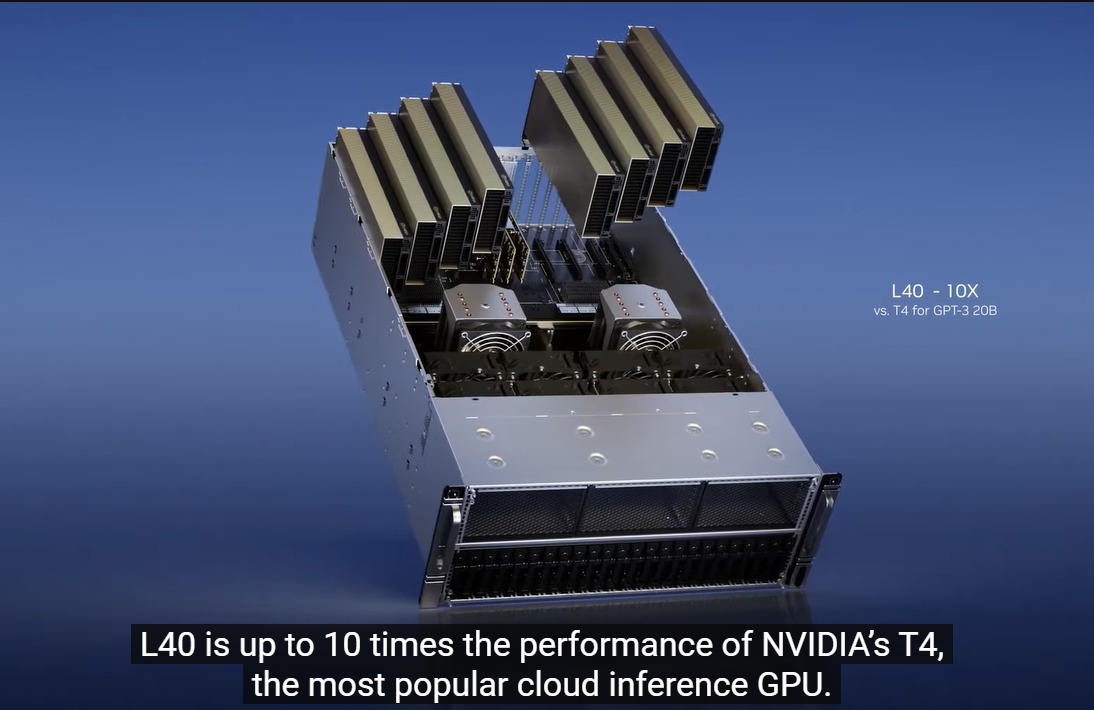

2) L40 圖像生成

L40 實際上是在 2022 年宣布的,但直到最近才看到一些行動。基於具有超過 18,000 個 CUDA 處理核心和 142 個 RT 核心的 Ada Lovelace RTX GPU,L40 具有相當大的衝擊力,因為這些規格使其遠遠領先於 RTX 4090 的性能。但與針對高時鐘速度、光柵化和光線追踪性能以及主動冷卻和更高功率預算進行優化的 RTX 4090 不同,L40 是一種被動冷卻設計,具有 300W TDP,旨在利用內部設計的氣流路徑機架式服務器。

L40 還配備 48GB 的 GDDR6 內存和 ECC,非常適合 Omniverse Enterprise、渲染、3D 圖形、NVIDIA RTX 虛擬工作站、AI 培訓和數據科學。事實上,它是用於構建大規模 Omniverse 數字雙胞胎的 NVIDIA OVX 服務器的骨幹。

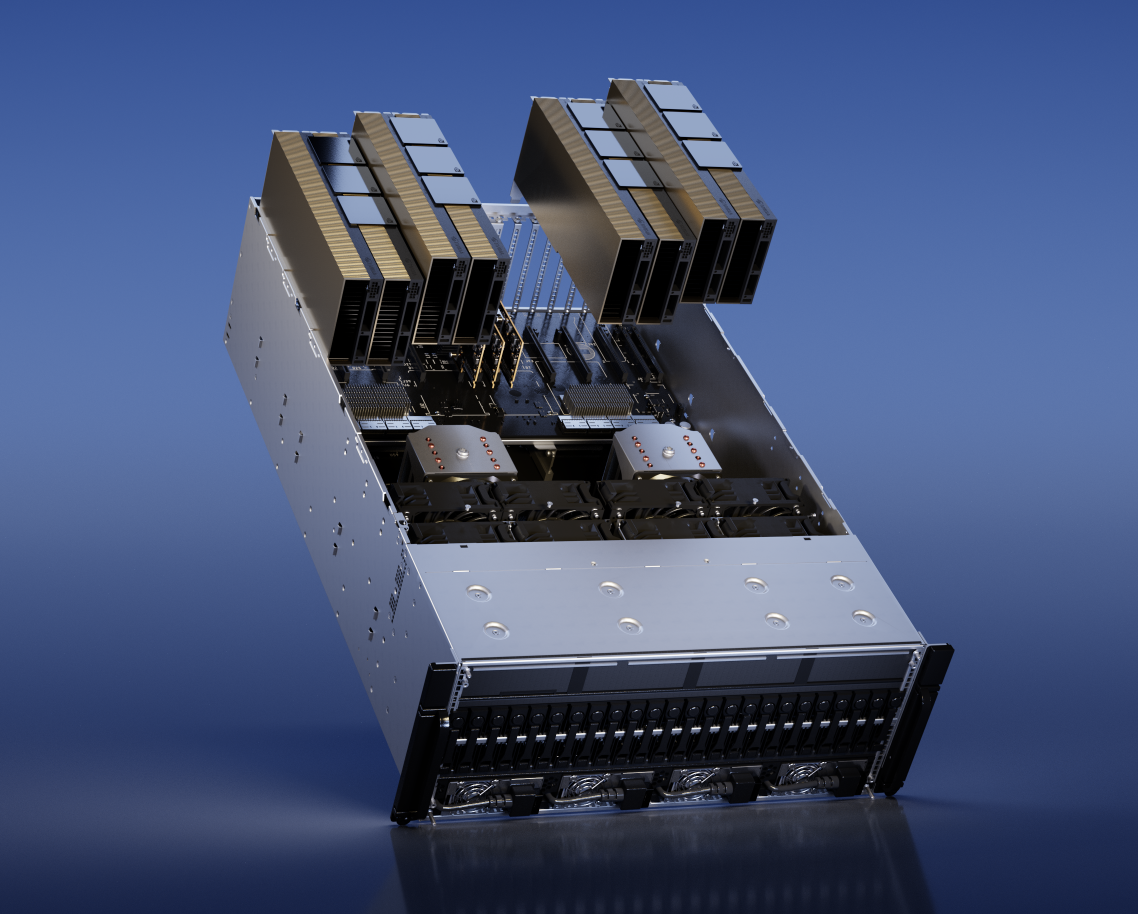

3) 用於大型語言模型 (LLM) 部署的 H100 NVL

基於 H100 的 Hopper GPU 架構是一款非常棒的產品,專注於數據中心AI 加速,因為它放棄了 RT 核心並封裝在一個更快的內存接口中以連接 HBM 內存。與 H100 一樣快,NVIDIA 已經意識到它現在需要做更多的工作才能成為大規模支持 ChatGPT 等 AI 生成服務的驅動程序。在 GTC 2023 上,NVIDIA 宣布了基於雙 PCIe 卡的 H100 NVL,它們是相互 NVLink 的。為了使其比現有的兩款 H100 PCIe 產品(它們包含 80GB 內存)更理想,新的 H100 NVL 每個都包含 94GB,總計 188GB 顯存,擁有 7.8TB/s 圖形內存帶寬。此外,H100NVL 的 GPU 配置與 H100 SXM SKU 相同,因此 H100 NVL 比 H100 PCIe 快得多,即使後者是 NVLink’ed。

根據 NVIDIA 的說法,H100配備 NVL 的服務器(配備四個 H100 NVL)比處理 GPT-3 的 HGX A100 服務器(八個 H100 SXM)快 10 倍。這是語言模型處理的顯著增加。

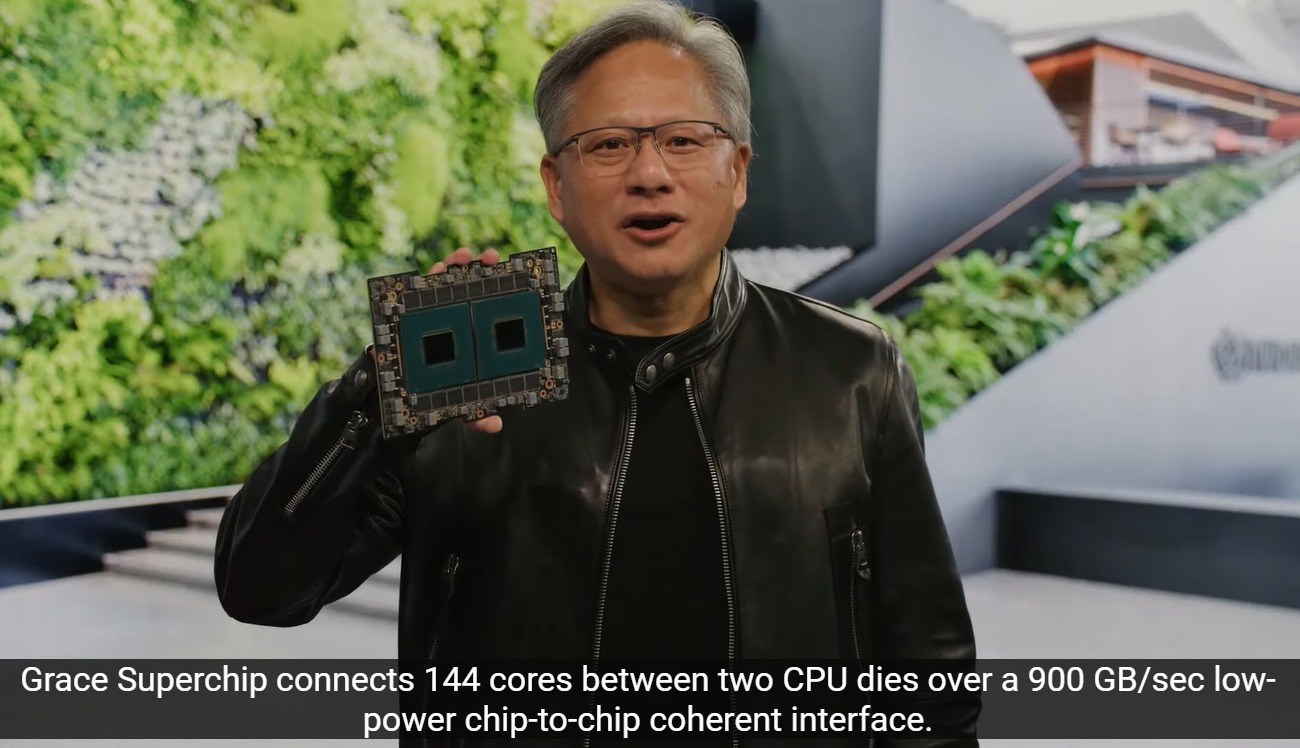

4) 用於推薦模型的 NVIDIA Grace Hopper

最後,NVIDIA 還有 Grace Hopper 超級芯片來處理 AI 數據庫和圖形推薦模型中的巨大數據集,該模塊的超快和低-延遲芯片到芯片 NVLink-C2C 可在基於 ARM 的 Grace 芯片和 Hopper GPU 之間實現超過 900GB/s 的互連帶寬。這允許在 CPU 上處理巨大的查詢,然後立即轉移到 Hopper GPU 進行推理處理,速度比 PCI Express 5.0 快七倍以上。