所有 GH100 GPU 均配備六個 HBM 內存堆棧(HBM2e 或 HBM3),每個堆棧容量為 16GB.然而,由於良率問題,NVIDIA 僅出貨常規 H100 部件並啟用了六個 HBM 堆棧中的五個,這意味著每個 GPU 標稱有 96GB 顯存,但常規 SKU 只有 80GB 可用。

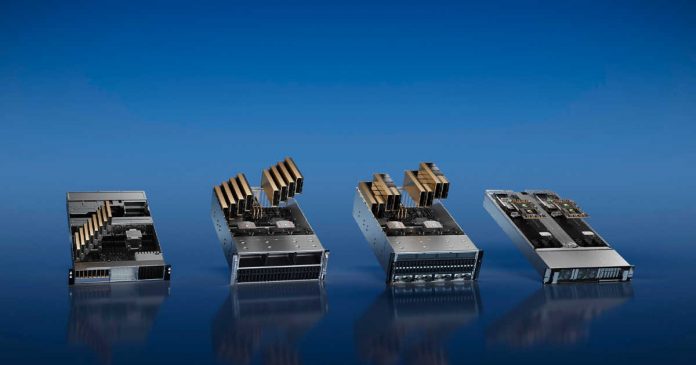

H100 NVL 將是一個特殊的 SKU,啟用所有六個堆棧,為每個 GH100 GPU 提供 14GB 內存,內存增加 17.5%。雙GPU/雙卡H100 NVL 看起來像是配置在PCIe 卡上的H100 的SXM5 版本。常規 H100 PCIe 由於 HBM2e 內存使用速度較慢、活動 SM/張量內核使用量較少以及時鐘速度較低而受到一定程度的阻礙,但 NVIDIA 為 H100 NVL 提供了張量內核。性能數據與 H100 SXM5 相當,表明該卡並沒有像普通 PCIe 卡那樣進一步降低。

H100 NVL 的一大特點是它的大內存容量,因為雙 GPU 卡提供188GB HBM3 內存(每張卡 94GB)。它還具有 7.8TB/s 的總內存帶寬和 3.9TB/s 的單板內存帶寬,使其成為 H100 系列中每個 GPU 內存最大的內存帶寬以及迄今為止所有 NVIDIA 產品中的內存帶寬。

規定這個SKU的出現,大概是預料到ChatGPT的爆款,以及後續Bing、Bard的出現對AI需求的快速增長。價格會相應上漲,但鑑於 LLM 市場的蓬勃發展,將需要為近乎完美的 GH100 封裝支付足夠高的溢價。

總而言之,H100 NVL 是NVIDIA 的 Hopper GPU 專為大型語言模型 (LLM) 而設計,例如 OpenAI 的 GPT-4。它的大容量使其成為 H100 系列和任何 NVIDIA 產品中每個 GPU 的最大內存。其增加的內存容量將有助於進一步推動 NVIDIA 的 AI 成功。 H100 NVL 是 LLM 市場向前邁出的重要一步,未來與其他 GPU 相比,看看它的性能如何將會很有趣。