Por que a IA generativa está causando tanta confusão agora?

A IA generativa, como Bing Ai, ChatGPT e mais, recentemente se destacou por usar algoritmos avançados para gerar novos dados, visuais e muito mais que parecem, sentem e lêem como se fossem produzidos por humanos. As Generative Adversarial Networks (GAN) são ideais para criar conteúdo visual, enquanto os modelos de linguagem Generative Pre-Trained (GPT) analisam os dados já disponíveis na Internet (ou outros conjuntos de dados proprietários fornecidos) para gerar uma saída, como uma resposta a uma consulta, todo o caminho para produzir’novos’artigos inteiros. O uso de IA para esses aspectos não é novo, mas os avanços na forma como ela entende essas consultas e produz uma saída muito mais utilizável, legível e identificável para o usuário comum é o que torna a IA generativa uma ferramenta potente.

As preocupações são, claro, controverso e abundante, mas ainda é cedo. No entanto, a tecnologia é muito ideal para criar mais dados para treinar e melhorar os vários modelos que podem rastrear rapidamente várias tarefas domésticas ou mundanas que exigem alguma forma de inferência para dar o próximo melhor passo à frente e até mesmo tornar os carros totalmente automotivos uma realidade. onde um modelo de simulação de direção automotiva é continuamente treinado por meio de infinitas variedades de novos dados ambientais gerados e treinados virtualmente, construindo assim um modelo pré-treinado cada vez mais sólido.

Aqui está mais leitura sobre este assunto da empresa de consultoria global McKinsey & Company para mais insights e o várias indústrias que têm a ganhar com a IA generativa.

Portanto, agora que sabemos por que a IA generativa é tão valiosa e importante, isso nos leva ao grande impulso da NVIDIA para oferecer suporte a empresas com serviços em nuvem para criar seus próprios modelos de linguagem grandes personalizados (LLMs, dos quais o ChatGPT é um excelente exemplo) e geração visual modelos para aplicações de IA. Mais especificamente, esses modelos personalizados de IA generativa são desenvolvidos e treinados com os próprios dados proprietários da empresa para suas ofertas específicas de domínio exclusivas.

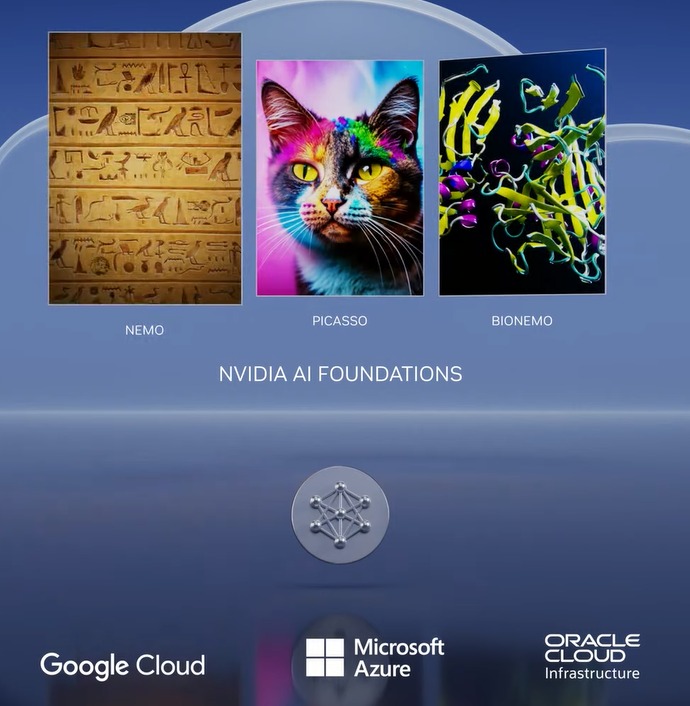

Isso é possível com NVIDIA AI Foundations, que é um conjunto de serviços em nuvem para permitir que as empresas criem, refinem e operem tais LLMs e modelos de IA generativos.

O serviço de nuvem NVIDIA NeMo permite que os desenvolvedores tornem modelos de linguagem grandes (LLMs) mais relevantes para os negócios, definindo áreas de foco, adicionando conhecimento específico do domínio e ensinando habilidades funcionais.

NVIDIA Picasso é um serviço de nuvem para criar e implantar aplicativos generativos de imagem, vídeo e 3D com inteligência artificial com recursos avançados de texto para imagem, texto para vídeo e texto para 3D para aumentar a produtividade para criatividade, design e simulação digital por meio de APIs de nuvem simples.

NVIDIA BioNeMo é um novo serviço em nuvem que estreou hoje para acelerar a pesquisa em ciências da vida, descoberta de medicamentos, engenharia de proteínas e pesquisa nas áreas de genômica, biologia, química e dinâmica modular.

Esses serviços são executados no NVIDIA DGX Cloud, que pode ser acessado por meio de um navegador. No momento, eles estão disponíveis para clientes com acesso antecipado e estão no estágio de visualização privada. Os desenvolvedores podem usar esses modelos oferecidos em cada serviço por meio de APIs simples e, quando os modelos estiverem prontos para implantação, as empresas podem executar cargas de trabalho de inferência em escala usando os serviços de nuvem NVIDIA AI Foundations.

Líderes da indústria se unem à NVIDIA para produtividade avançada para profissionais criativos

A

Adobe anunciou hoje que expandirá sua parceria de pesquisa e desenvolvimento de longa data para criar a próxima geração de modelos de IA generativa com a NVIDIA. Para acelerar os fluxos de trabalho de criadores e profissionais de marketing, alguns desses modelos serão desenvolvidos em conjunto e lançados no mercado por meio de produtos emblemáticos da Adobe Creative Cloud, como Photoshop, Premiere Pro e After Effects, bem como por meio do NVIDIA Picasso.

A NVIDIA e a Getty Images estão colaborando para treinar modelos de base geradores responsáveis de texto para imagem e texto para vídeo. Os modelos permitirão a criação de imagens e vídeos usando prompts de texto simples e serão treinados em recursos totalmente licenciados da Getty Images.

NVIDIA e Shutterstock estão colaborando para treinar um texto generativo Modelo básico-para 3D usando o serviço NVIDIA Picasso para simplificar a criação de modelos 3D detalhados e reduzir o tempo necessário para construir modelos 3D de dias para minutos.

Novas GPUs alimentam plataformas de inferência para trabalhar várias IA generativa cargas de trabalho

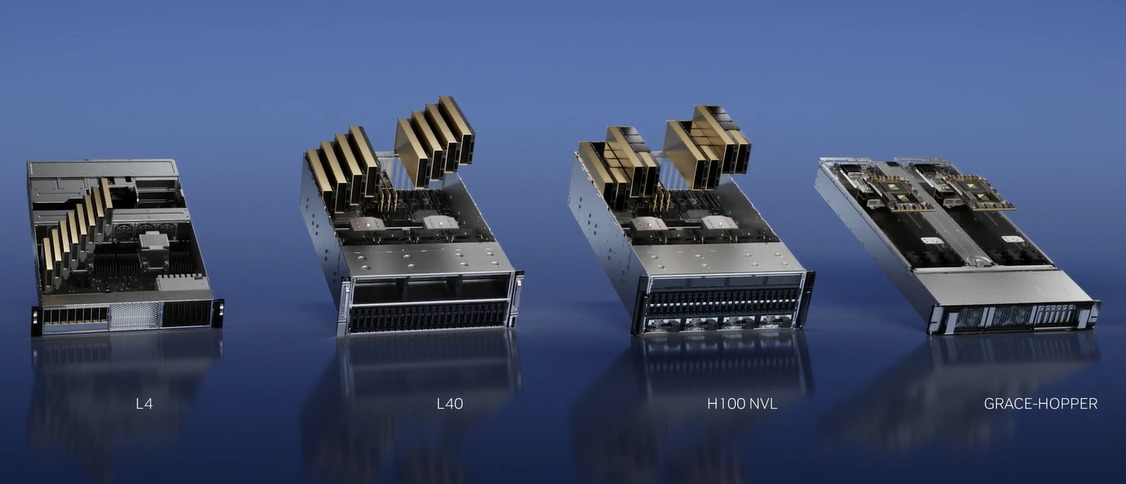

Para aumentar o esforço da NVIDIA para ajudar a criar modelos de IA generativos novos e emergentes por meio dos serviços de nuvem da NVIDIA Foundation, eles também lançaram uma série de novas GPUs e plataformas para ajudar os desenvolvedores a criar e potencializar esses novos aplicativos de IA baseados no NVIDIA Ada Lovelace, Processadores Hopper e Grace Hopper.

A ascensão da IA generativa está exigindo inferências mais poderosas e plataformas de computação. O número de aplicações para IA generativa é infinito, limitado apenas pela imaginação humana. Armar os desenvolvedores com a plataforma de computação de inferência mais poderosa e flexível acelerará a criação de novos serviços que melhorarão nossas vidas de maneiras ainda não imagináveis. – Jensen Huang, fundador e CEO da NVIDIA.

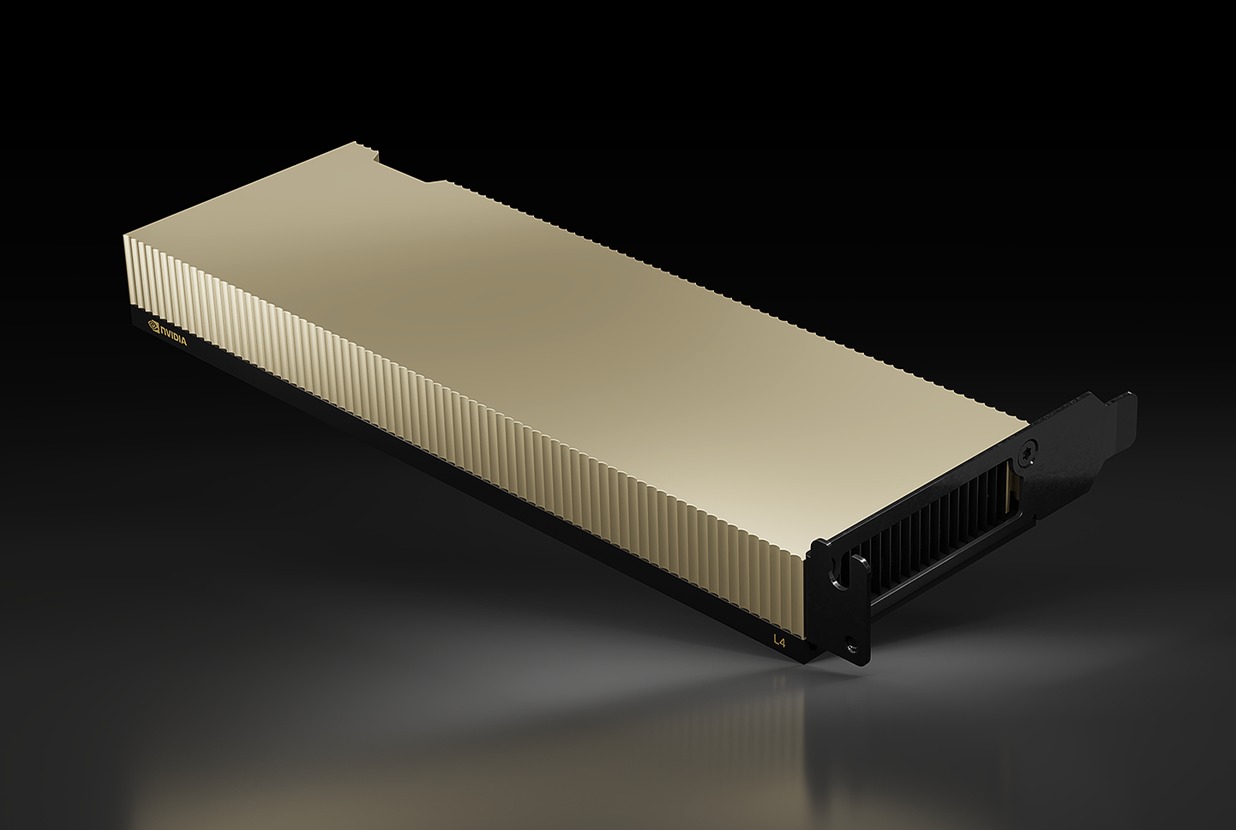

1) NVIDIA L4 para AI Video

O novo NVIDIA L4 é o substituto direto da popular GPU T4, que foi a primeira a usar Tensor Cores e projetada especificamente para cargas de trabalho de inferência de IA para analisar novas entradas de dados para prever e estimar um resultado desejado com base em modelos pré-treinados.

O T4 foi alimentado pela microarquitetura Turing, que foi a primeira a suportar e acelerar cargas de trabalho de rastreamento de raio. O novo L4, baseado na arquitetura de GPU Ada Lovelace (é isso que alimenta a série GeForce RTX 40) com suporte para DLSS 3 alimentado por IA, é classificado para oferecer mais de 4x de aceleração no desempenho de renderização em tempo real no Omniverse e é capaz de oferecer Desempenho ray tracing três vezes maior.

Com essa taxa de transferência aprimorada, a GPU L4 está posicionada para cargas de trabalho de vídeo AI para lidar com decodificação de vídeo em tempo real, transcodificação, moderação de conteúdo de vídeo, tradução de idiomas, recursos de aprimoramento de chamada de vídeo, como como substituição de fundo, reiluminação, contato visual, realidade aumentada e muito mais. Os codificadores AV1 duplos da nova GPU também são excelentes razões pelas quais o L4 é ideal para essas tarefas de vídeo AI. Na verdade, um único servidor L4 de 8 GPUs pode substituir mais de cem servidores de CPU de soquete duplo tradicionais no processamento de vídeo AI. Esta é uma enorme economia no custo total de propriedade em relação às infraestruturas mais antigas.

Melhor ainda, o L4 também foi projetado no mesmo fator de forma de baixo perfil e um envelope de potência ligeiramente inferior de 72 W, o que torna a atualização do T4 existente alimentado servidores com uma brisa L4, enquanto melhora a proeza de inferência AI por uma boa margem.

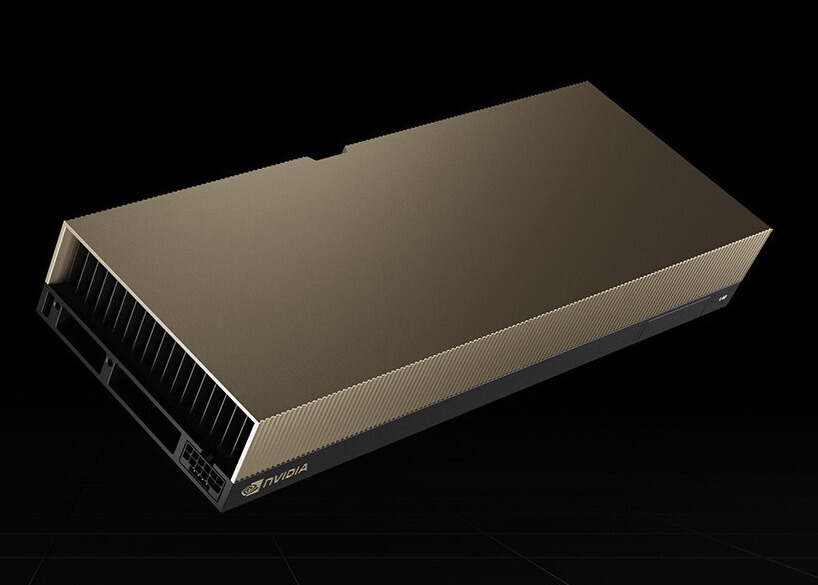

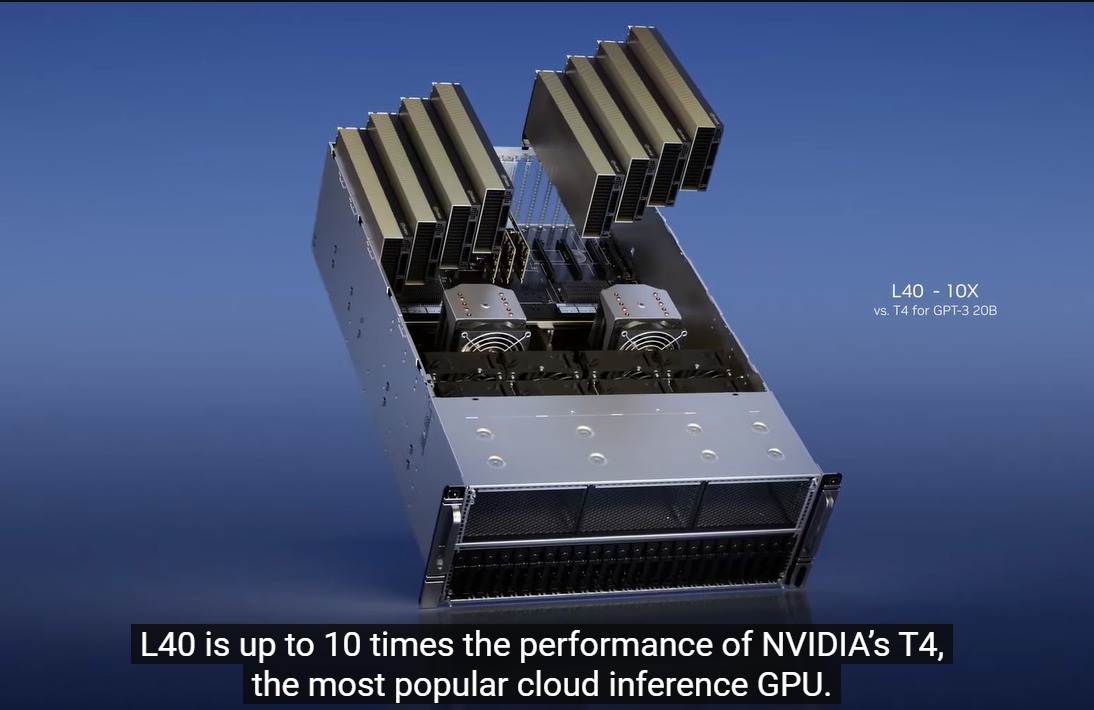

2) L40 para geração de imagens

O L40 foi realmente anunciado em 2022, mas não foi até recentemente que ele entrou em ação. Com base na GPU Ada Lovelace RTX com mais de 18.000 núcleos de processamento CUDA e 142 núcleos RT, o L40 oferece um grande impacto, pois essas especificações o colocam bem à frente do que o RTX 4090 oferece. Mas ao contrário do RTX 4090 que é otimizado para altas velocidades de clock, rasterização e desempenho de traçado de raio com resfriamento ativo e um orçamento de energia mais alto, o L40 é um design resfriado passivamente com um TDP de 300 W e destina-se a aproveitar os caminhos de fluxo de ar projetados dentro servidores em rack.

Os O L40 também inclui 48 GB de memória GDDR6 com ECC, perfeito para Omniverse Enterprise, renderização, gráficos 3D, estação de trabalho virtual NVIDIA RTX, treinamento de IA e ciência de dados. Na verdade, é a espinha dorsal do servidor NVIDIA OVX destinado à criação de gêmeos digitais Omniverse em grande escala.

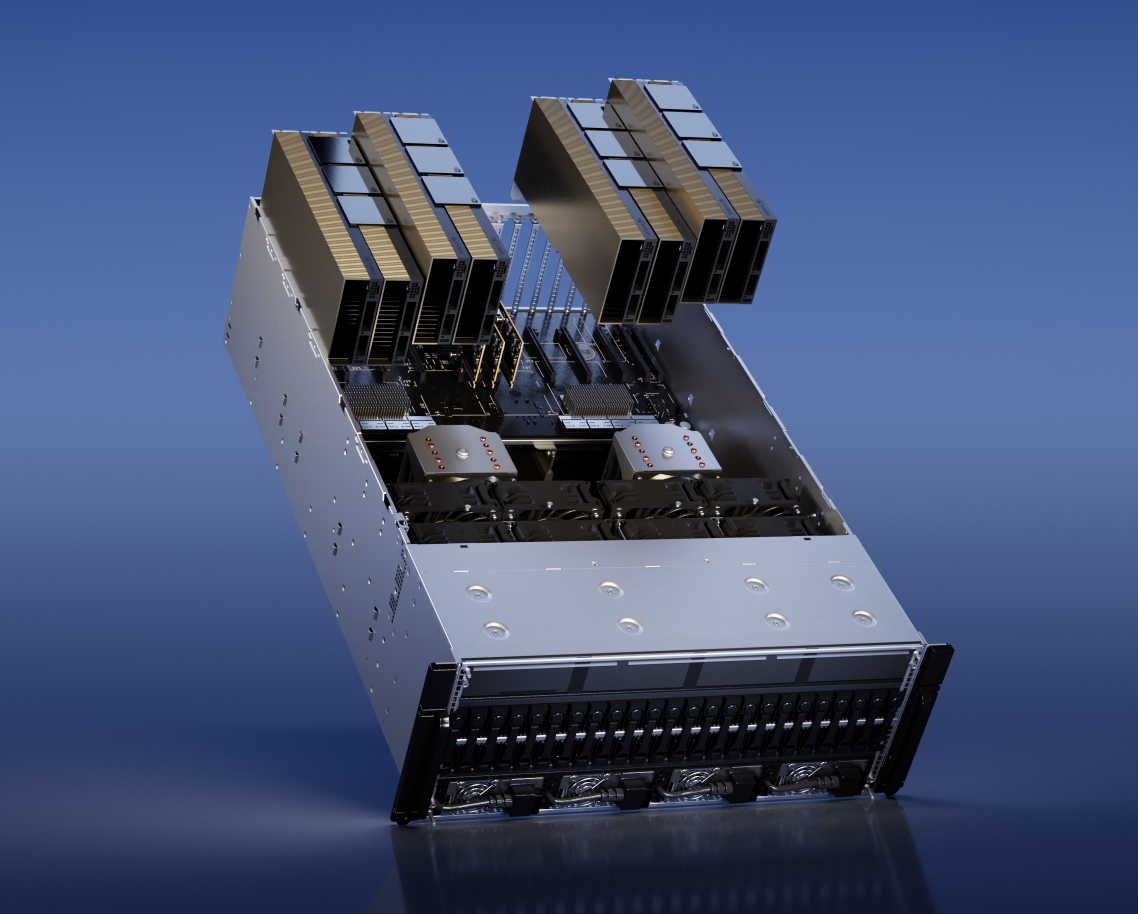

3) H100 NVL para implantação de modelo de linguagem grande (LLM)

A arquitetura de GPU Hopper baseada em H100 é um produto incrível focado em data center Aceleração de IA, pois dispensa RT Cores e inclui uma interface de memória muito mais rápida para conectar-se à memória HBM. Por mais rápido que o H100 seja, a NVIDIA já está ciente de que precisa fazer mais agora para ser o driver que impulsiona os serviços geradores de IA como o ChatGPT em escala. Na GTC 2023, a NVIDIA anunciou o H100 NVL baseado em placas PCIe duplas que são NVLink’ed entre si. Para torná-lo mais ideal do que dois produtos H100 PCIe existentes (eles embalam 80 GB de memória), os novos pacotes H100 NVL em 94 GB cada, para um total de 188 GB de memória gráfica, com gráficos de 7,8 TB/s Largura de banda de memória. Além disso, a configuração de GPU do H100NVL é idêntica ao H100 SXM SKU, portanto, o H100 NVL é muito mais rápido que o H100 PCIe, mesmo que este último tenha sido NVLink’ed.

De acordo com a NVIDIA, o H100 O servidor equipado com NVL (com quad H100 NVL) é 10x mais rápido do que um servidor HGX A100 (oito H100 SXM) processando GPT-3. Isso é um aumento fenomenal no processamento do modelo de linguagem.

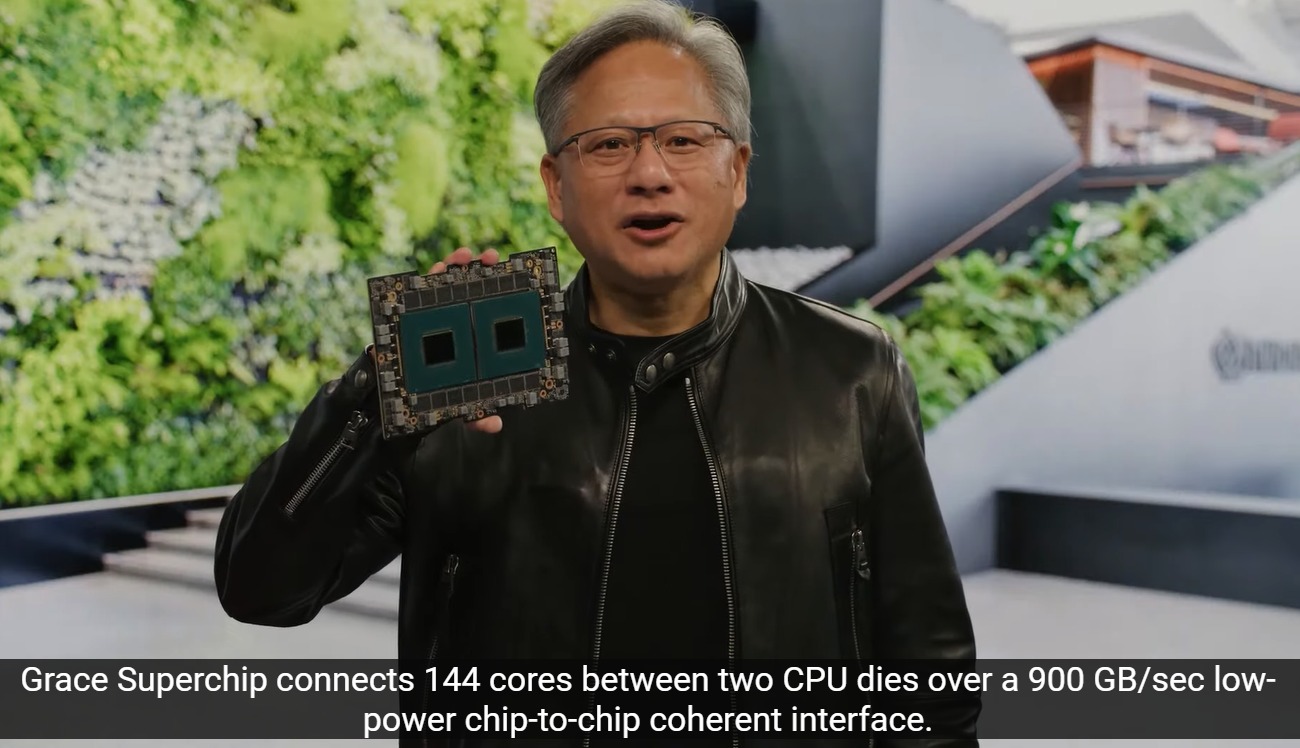

4) NVIDIA Grace Hopper para modelos de recomendação

Por fim, a NVIDIA também possui o superchip Grace Hopper para processar conjuntos de dados gigantes em bancos de dados de IA e modelos de recomendação de gráficos, onde o módulo é super rápido e baixo latência chip-to-chip O NVLink-C2C permite mais de 900 GB/s de largura de banda de interconexão entre o chip Grace baseado em ARM e a GPU Hopper. Isso permite que uma consulta gigante seja processada na CPU e imediatamente transferida para a GPU Hopper para processamento de inferência sete vezes mais rápido que o PCI Express 5.0.