A NVIDIA tem anunciou o H100 NVL, uma nova variante de sua GPU Hopper projetada especificamente para modelos de linguagem grande (LLMs) como o GPT-4 da OpenAI.

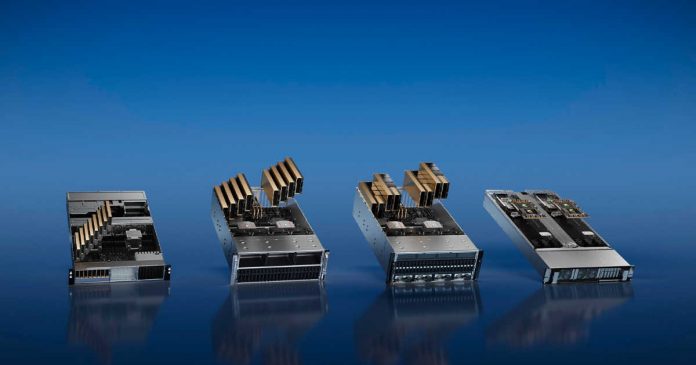

A placa GPU dupla tem duas placas H100 PCIe já interligadas e uma grande capacidade de memória, tornando-a a mais memória por GPU dentro da família H100 e de qualquer produto NVIDIA até o momento.

O H100 NVL destina-se a um mercado único de uso de modelo de linguagem em larga escala no movimento e para promover o sucesso da IA da NVIDIA. Grandes modelos de linguagem como a família GPT são, de várias maneiras, limitados na capacidade de memória. Até o acelerador H100 se enche rapidamente para manter todos os parâmetros (175B para o maior modelo GPT-3). Portanto, a NVIDIA desenvolveu novos SKUs H100 com mais memória por GPU do que as peças H100 normais com limite de 80 GB por GPU.

Todas as GPUs GH100 vêm com seis pilhas de memória HBM (HBM2e ou HBM3) com capacidade de 16 GB por pilha. No entanto, devido a preocupações com o rendimento, a NVIDIA envia apenas peças H100 regulares com cinco das seis pilhas HBM habilitadas, o que significa que cada GPU tem um valor nominal de 96 GB de VRAM, mas os SKUs regulares têm apenas 80 GB disponíveis.

O H100 NVL será um SKU especial com todas as seis pilhas habilitadas, oferecendo 14 GB de memória por GPU GH100, um aumento de memória de 17,5%. A GPU dupla/placa dupla H100 NVL se parece com a versão SXM5 do H100 disposta em uma placa PCIe. O H100 PCIe regular está sendo retido um pouco pelo uso mais lento da memória HBM2e, menos uso ativo de núcleos SM/tensor e velocidades de clock mais baixas, mas o Tensor Cores NVIDIA está apresentando para H100 NVL. Os números de desempenho estão todos no mesmo nível do H100 SXM5, indicando que esta placa não é mais reduzida como as placas PCIe comuns.

O grande recurso do H100 NVL é sua grande capacidade de memória, já que a placa GPU dupla oferece 188 GB de memória HBM3 (94 GB por cartão). Ele também tem uma largura de banda de memória total de 7,8 TB/s e 3,9 TB/s em placas individuais, tornando-o o maior memória por GPU dentro da família H100 e de qualquer produto NVIDIA até o momento.

O fornecimento deste SKU provavelmente antecipa o sucesso explosivo do ChatGPT e o rápido aumento na demanda de IA devido ao subsequente aparecimento do Bing e do Bard. O preço vai subir de acordo, mas dado o mercado de LLM em expansão, haverá demanda para pagar um prêmio alto o suficiente por um pacote GH100 quase perfeito.

Em conclusão, o H100 NVL é uma nova variante do GPU Hopper da NVIDIA projetada especificamente para modelos de linguagem grande (LLMs) como o GPT-4 da OpenAI. Sua grande capacidade o torna o mais memória por GPU dentro da família H100 e de qualquer produto NVIDIA. Sua maior capacidade de memória ajudará a aumentar ainda mais o sucesso da IA da NVIDIA. O H100 NVL é um avanço significativo no mercado de LLM e será interessante ver como ele se comporta quando comparado a outras GPUs no futuro.