A menos que hayas estado en un retiro en algún lugar remoto sin acceso a Internet durante los últimos meses, lo más probable es que estés al tanto de la exageración y el miedo que ha habido ChatGPT, el chatbot de inteligencia artificial (IA) desarrollado por OpenAI. Tal vez hayas visto artículos sobre académicos y maestros preocupados de que sea Hará que hacer trampa sea más fácil que nunca. En el otro lado de la moneda, es posible que haya visto los artículos que evangelizan todos los aplicaciones potenciales.

Alternativamente, es posible que le hayan gustado algunos de los ejemplos más esotéricos de personas que usan la herramienta. Un usuario, por ejemplo, consiguió que escribiera una guía de instrucciones para quitar sándwiches de mantequilla de maní de una videograbadora en el style of the King James Bible. Otro le pidió que escribiera una canción al estilo de Nick Cave; el cantante fue menos que entusiasmado con los resultados.

Pero en medio de toda esa exageración y discusión, no se ha prestado suficiente atención a los riesgos y recompensas que las herramientas de IA como ChatGPT presente en el campo de la ciberseguridad.

Comprender ChatGPT

Para tener una idea más clara de cómo son esos riesgos y recompensas, es importante comprender mejor qué es ChatGPT y qué es capaz de hacerlo.

ChatGPT (ahora en su última versión, ChatGPT-4, lanzada el 14 de marzo de 2023) es parte de una familia más grande de herramientas de IA desarrolladas por la empresa estadounidense OpenAI. Si bien se llama oficialmente chatbot, eso no cubre su versatilidad. Entrenado utilizando tanto supervisado como refuerzo técnicas de aprendizaje, puede hacer mucho más que la mayoría de los chatbots. Como parte de sus respuestas, puede generar contenido a partir de toda la información con la que fue capacitado. Esa información incluye conocimientos generales, así como lenguajes de programación y código. Como resultado, puede, por ejemplo, simule una sala de chat completa; jugar juegos como tic-tac-toe; y simule un cajero automático.

Más importante aún, para las empresas y otras organizaciones grandes, puede ayudar a mejorar el servicio al cliente de las empresas a través de mensajes más personalizados y precisos. Incluso puede escribir y depurar programas de computadora. Algunas de esas y otras características significan que podría ser tanto un aliado de ciberseguridad como una amenaza.

Educación, filtrado y refuerzo de defensas

On El frente positivo, hay mucho que decir sobre ChatGPT. Uno de los roles más valiosos que podría desempeñar es también uno de los más simples: detectar el phishing. Las organizaciones podrían afianzar el hábito de sus empleados mediante el uso de ChatGPT para determinar si algún contenido del que no están seguros es phishing o si se generó con intenciones maliciosas.

Eso es importante porque, a pesar de todos los avances tecnológicos realizados en los últimos años, los ataques de ingeniería social como el phishing siguen siendo una de las formas más efectivas de ciberdelincuencia. De hecho, la investigación muestra que, de los ataques cibernéticos identificados con éxito en el Reino Unido en 2022, 83 por ciento involucrado alguna forma de phishing.

Por supuesto, hay muchas otras formas en las que se puede usar ChatGPT para reforzar los esfuerzos de seguridad cibernética. Podría, por ejemplo, brindar cierto grado de asistencia a los trabajadores de seguridad más jóvenes, ya sea comunicando cualquier problema que puedan tener o ayudándolos a comprender mejor el contexto en el que deben trabajar en un momento dado. También podría ayudar a los equipos con recursos insuficientes a curar las últimas amenazas e identificar vulnerabilidades internas.

Los malos también lo están usando

Pero incluso como ciberseguridad los profesionales exploran formas de utilizar ChatGPT en su beneficio, los ciberdelincuentes también lo hacen. Podrían, por ejemplo, hacer uso de su capacidad para generar código malicioso. Alternativamente, podrían usarlo para generar contenido que parece ser generado por humanos, potencialmente usado para engañar a los usuarios para que hagan clic en enlaces maliciosos, lo que sin saberlo tiene consecuencias peligrosas.

Algunos incluso están usando ChatGPT para imitar de manera convincente a los asistentes legítimos de IA en los sitios web corporativos, abriendo una nueva vía en el frente de batalla de la ingeniería social. Recuerde, el éxito de los ciberdelincuentes depende en gran medida de poder atacar tantas vulnerabilidades posibles, con la mayor frecuencia y rapidez posibles. Las herramientas de IA como ChatGPT les permiten hacer eso actuando esencialmente como un asistente supercargado que puede ayudar a crear todos los activos necesarios para campañas maliciosas.

Use las herramientas disponibles

Debe quedar claro entonces que, si los ciberdelincuentes usan ChatGPT y otras herramientas de IA para mejorar sus ataques, su equipo de seguridad también debería usarlas para reforzar sus esfuerzos de ciberseguridad. Afortunadamente, no tiene que hacerlo solo.

El proveedor de seguridad adecuado no solo se involucrará en una investigación constante sobre cómo los ciberdelincuentes utilizan las últimas tecnologías para mejorar sus ataques, sino también cómo esas tecnologías pueden ser Se utiliza para mejorar la detección, prevención y defensa de amenazas. Y con el daño que un ataque de seguridad cibernética puede causar a su infraestructura crítica, es algo que también deberían informarle de manera proactiva.

ChatGPT-4

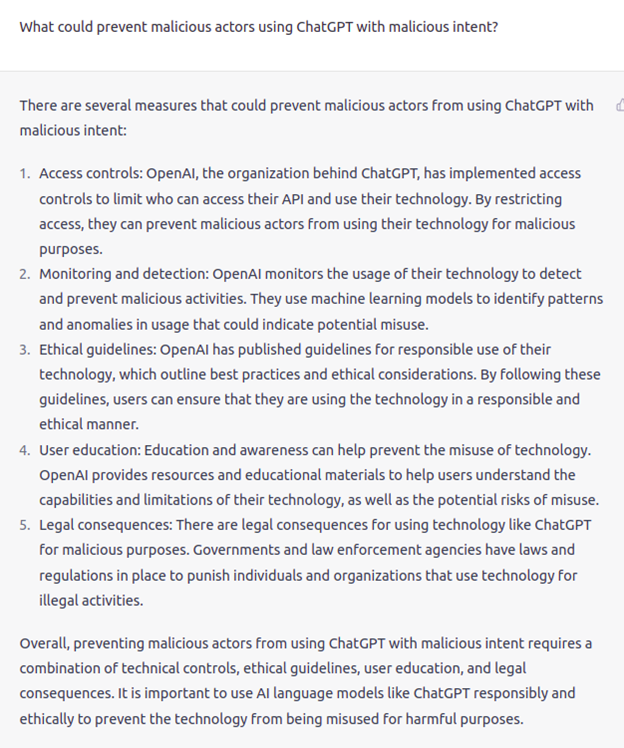

Con la última versión de ChatGPT (ChatGPT-4), OpenAI ha puesto a disposición el último y más poderoso modelo conversacional, y también ha introducido más controles para evitar su mal uso. Le preguntamos a ChatGPT”¿Qué podría evitar que los actores maliciosos usen ChatGPT con intenciones maliciosas?”y esta fue la respuesta:

Así que ChatGPT siguió adelante y enumeró todas las medidas que OpenAI ha tomado para evitar su mal uso. OpenAI en el blog de lanzamiento de ChatGPT-4 explicó cómo este modelo es supuestamente más seguro que sus predecesores:”Pasamos 6 meses fabricando GPT-4 es más seguro y más alineado. GPT-4 tiene un 82 % menos de probabilidades de responder a solicitudes de contenido no permitido y un 40 % más de probabilidades de producir respuestas fácticas que GPT-3.5 en nuestras evaluaciones internas”.

Así que todo indica que se siguen mejorando las medidas adecuadas para evitar su uso indebido, pero como todos sabemos, los malos seguirán encontrando formas de superar esas limitaciones a medida que el modelo se utilice y comprenda más ampliamente.

Crédito de la imagen: [email protected]/depositphotos.com

JP Perez-Etchegoyen es CTO de Onapsis.