NVIDIA tiene anunció el H100 NVL, una nueva variante de su GPU Hopper diseñada específicamente para modelos de lenguaje grande (LLM) como GPT-4 de OpenAI.

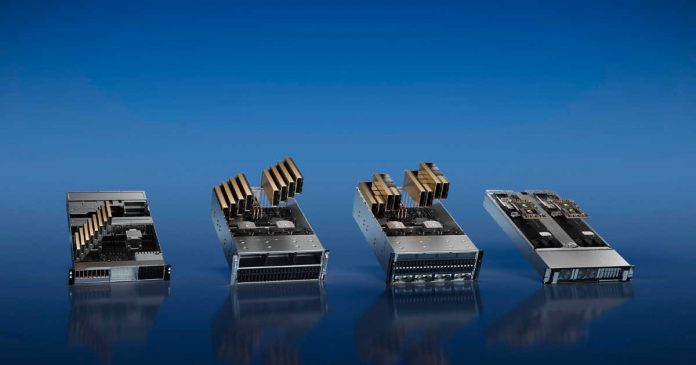

La tarjeta GPU doble tiene dos placas PCIe H100 ya unidas y una gran capacidad de memoria, lo que la convierte en la mayor cantidad de memoria por GPU dentro de la familia H100 y de cualquier producto NVIDIA hasta la fecha.

El H100 NVL está dirigido a un mercado único de uso de modelos de lenguaje a gran escala en el carro y para promover el éxito de la IA de NVIDIA. Los modelos de lenguajes grandes como la familia GPT están, en muchos sentidos, limitados en la capacidad de memoria. Incluso el acelerador H100 se llena rápidamente para mantener todos los parámetros (175B para el modelo GPT-3 más grande). Por lo tanto, NVIDIA ha desarrollado nuevos SKU H100 con más memoria por GPU que las piezas H100 normales que tienen un límite de 80 GB por GPU.

Todas las GPU GH100 vienen con seis pilas de memoria HBM (HBM2e o HBM3) con 16 GB de capacidad por pila. Sin embargo, debido a problemas de rendimiento, NVIDIA solo envía piezas regulares de H100 con cinco de las seis pilas HBM habilitadas, lo que significa que cada GPU tiene 96 GB nominales de VRAM, pero las SKU regulares solo tienen 80 GB disponibles.

El H100 NVL será un SKU especial con las seis pilas habilitadas y ofrecerá 14 GB de memoria por GPU GH100, un aumento de memoria del 17,5 %. La GPU dual/tarjeta dual H100 NVL se parece a la versión SXM5 de la H100 dispuesta en una tarjeta PCIe. El PCIe H100 regular se ve frenado un poco por el uso más lento de la memoria HBM2e, menos uso activo de núcleos SM/tensor y velocidades de reloj más bajas, pero Tensor Cores NVIDIA está presentando para H100 NVL. Las cifras de rendimiento están todas a la par con la H100 SXM5, lo que indica que esta tarjeta no se reduce más que las tarjetas PCIe normales.

La gran característica de la H100 NVL es su gran capacidad de memoria, ya que la tarjeta GPU dual ofrece 188 GB de memoria HBM3 (94 GB por tarjeta). También tiene un ancho de banda de memoria total de 7,8 TB/s y 3,9 TB/s en placas individuales, lo que lo convierte en la mayor cantidad de memoria por GPU dentro de la familia H100 y de cualquier producto NVIDIA hasta la fecha.

La disposición de este SKU probablemente se anticipe al éxito explosivo de ChatGPT y al rápido aumento de la demanda de IA debido a la posterior aparición de Bing y Bard. El precio subirá en consecuencia, pero dado el floreciente mercado LLM, habrá demanda para pagar una prima lo suficientemente alta por un paquete GH100 casi perfecto.

En conclusión, el H100 NVL es una nueva variante de GPU Hopper de NVIDIA diseñada específicamente para modelos de lenguaje grande (LLM) como GPT-4 de OpenAI. Su gran capacidad lo convierte en la mayor cantidad de memoria por GPU dentro de la familia H100 y de cualquier producto NVIDIA. Su mayor capacidad de memoria ayudará a promover el éxito de la IA de NVIDIA. La H100 NVL es un importante paso adelante en el mercado LLM y será interesante ver cómo se comporta en comparación con otras GPU en el futuro.