Parece que se ha tomado su buen tiempo para llegar aquí, pero hoy, Intel está lanzando oficialmente su línea Xeon de cuarta generación construida alrededor de la plataforma Sapphire Rapids. Esta línea incluye no solo los SKU escalables típicos que hemos visto de las generaciones anteriores, sino también una nueva serie”Max”, de la que Intel habló por primera vez hace unos meses.

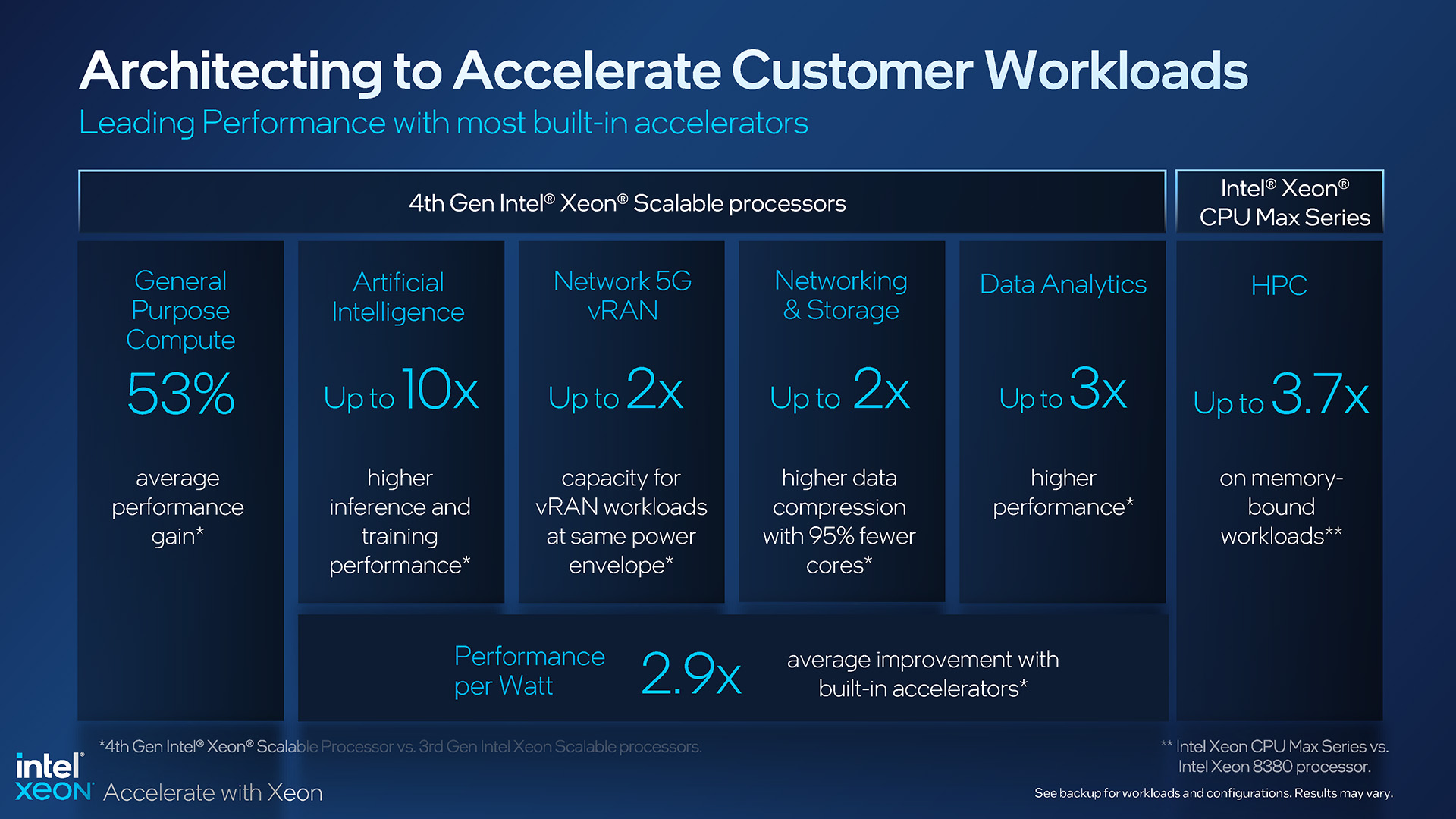

Con Sapphire Rapids, Intel dice que el último Xeon es el más sostenible hasta la fecha, y que también tiene la mayor cantidad de aceleradores integrados de cualquier procesador de servidor hasta la fecha. Ambas partes son creíbles, pero es la última la que va en serio, porque Intel ha incluido muchas ventajas de aceleración en estas CPU, algunas de las cuales requerirán que se actualice el software para aprovechar al máximo las ganancias potenciales.

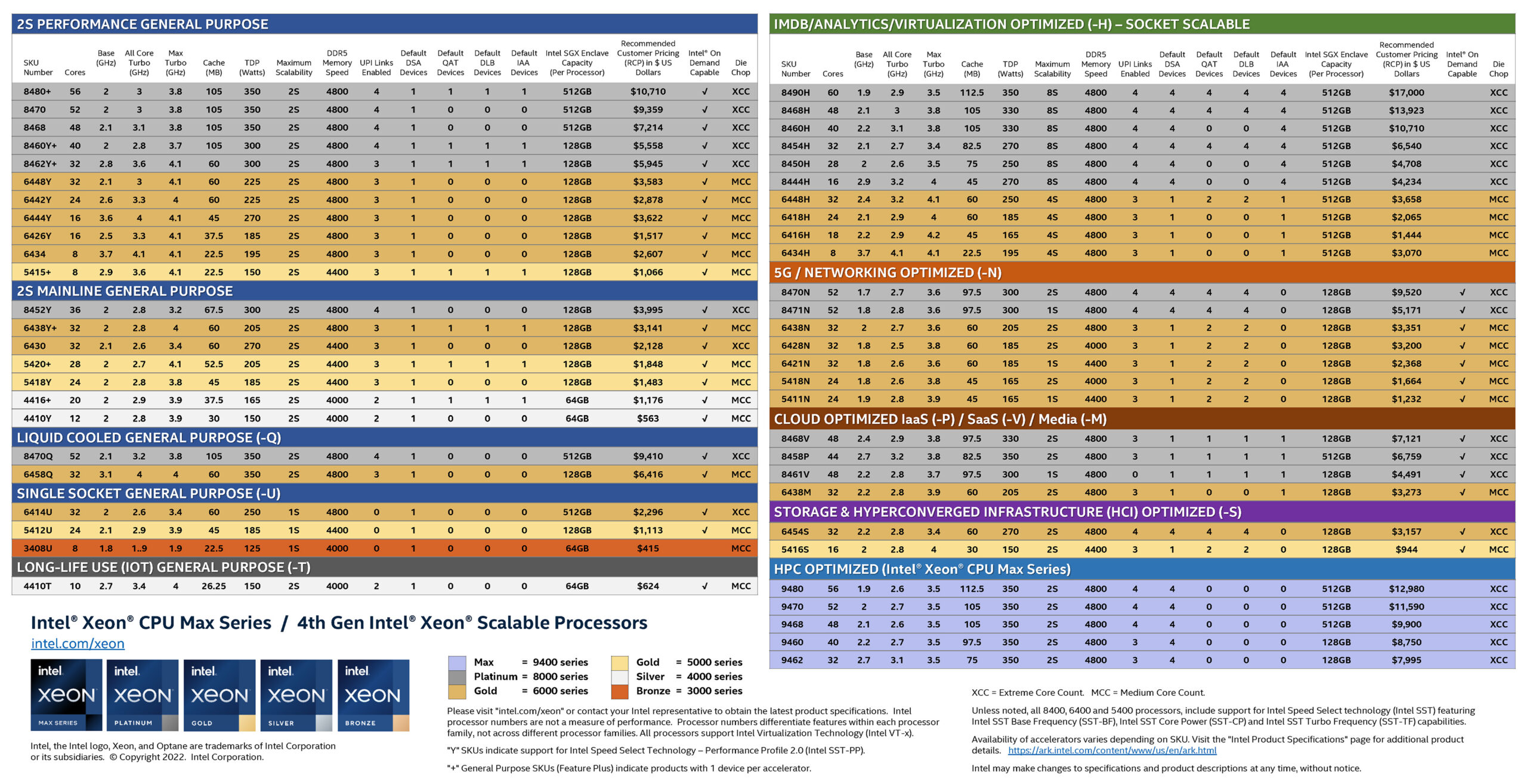

La gran cantidad de SKU de procesador que Intel ofrece casi alcanza niveles de humor de meme. Es lo mismo en el escritorio que en el servidor. ¿A quién no le encanta esta colorida hoja de SKU de servidor actualizada?

Línea de Intel Xeon Scalable y Xeon Max de cuarta generación

Con tantas opciones de Xeon, está claro que Intel está tratando de capturar la mayor parte de el mercado de servidores como puede con sus últimas ofertas. Si bien puede haber algunas áreas en las que podrían incluirse modelos adicionales, todavía se siente como una lista exhaustiva.

Si bien Intel ofrece Xeons para muchos propósitos diferentes, ninguno de ellos se desarrolla sin una buena razón. Es posible que observe las dos opciones de refrigeración líquida y se pregunte quién las usa realmente, pero Intel se ha esforzado mucho en hacer que esas CPU se destaquen, trabajando con socios de la industria para desarrollar mejores métodos para chips de servidor de refrigeración líquida y esforzándose tanto rendimiento de ellos como sea posible.

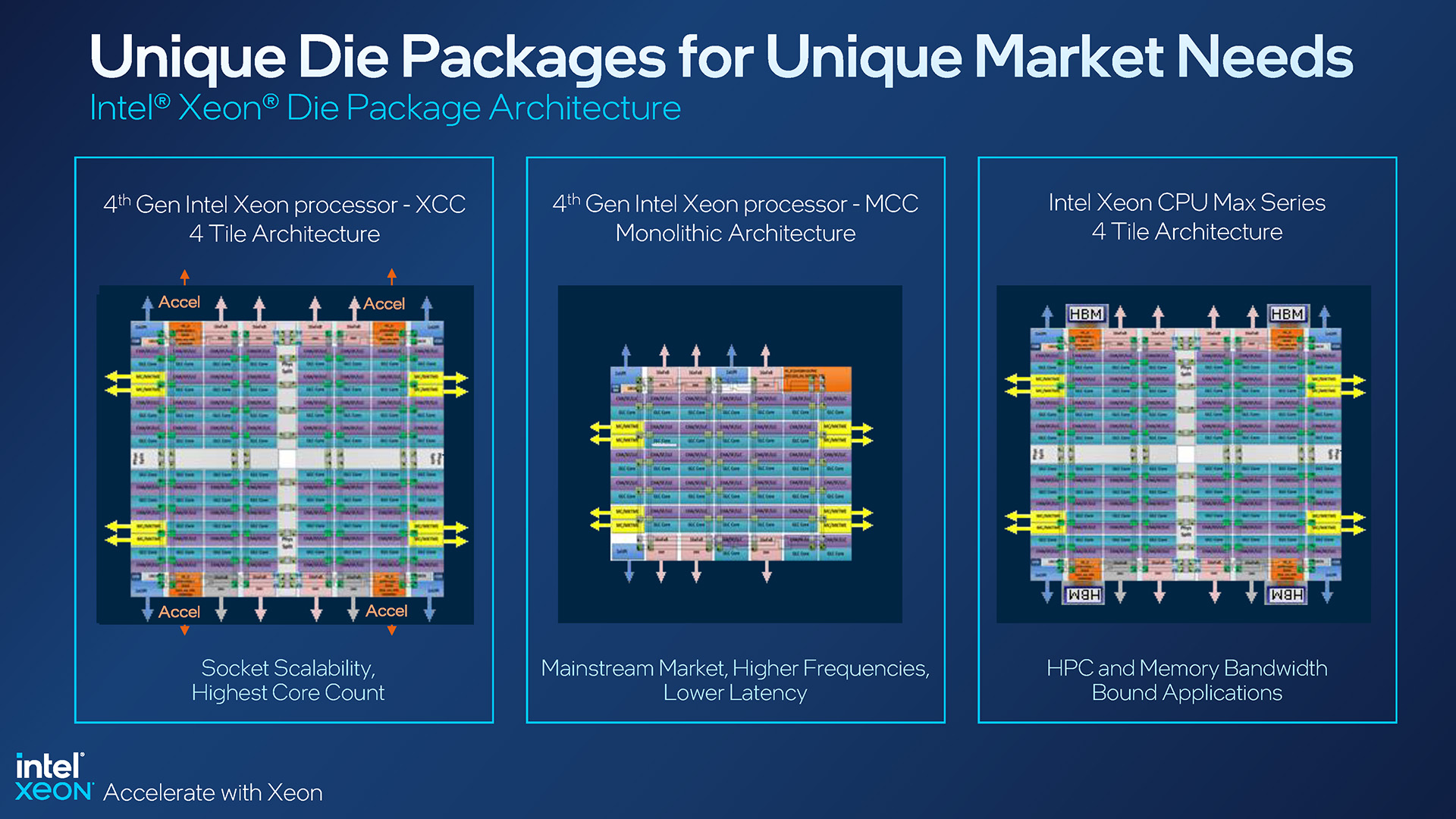

Hemos visto hojas de SKU como la de arriba desde el lanzamiento original de Xeon Scalable, pero esta tiene muchos detalles adicionales que vale la pena mencionar. Para comenzar, la configuración central aparecerá como XCC o MCC. XCC representa CPU con múltiples”mosaicos”en su interior, mientras que MCC es un diseño monolítico más tradicional:

Configuraciones del paquete Intel Xeon de 4.ª generación

Un diseño XCC es lo que ayuda a Intel a alcanzar una cantidad tan alta de núcleos en el gama alta, con esta generación de Xeon alcanzando un máximo de 60 núcleos con el 8490H. Los diseños de MCC de generación actual alcanzan un máximo de 32 núcleos, como con el 6448H optimizado para virtualización y el 6448Y con rendimiento limitado de 2S.

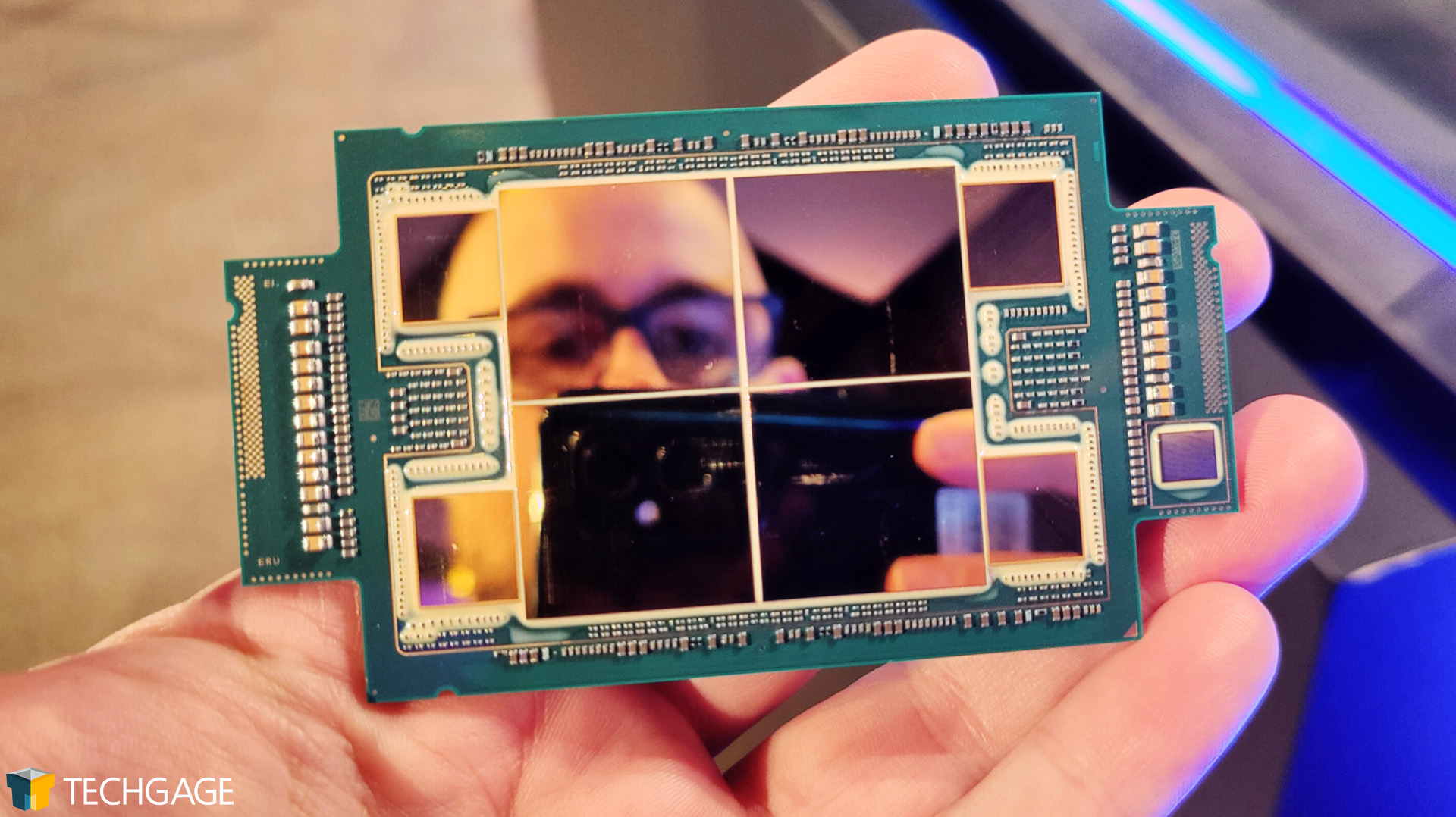

La serie Xeon Max representa el tercer diseño, uno que es efectivamente el mismo que XCC , pero con memoria HBM2e colocada alrededor de los troqueles. Fuimos”prácticos”con una CPU Max el mes pasado:

La 4.ª generación de Xeon Max de Intel es ideal para tomar selfies

Si bien las CPU Xeon Max ocupan solo cinco lugares en la línea general, se puede decir que son las más interesante del grupo. Estas CPU están equipadas con suficiente memoria integrada para permitir que un servidor funcione sin memoria adicional. Imagínese eso: un servidor arrancando, funcionando, con absolutamente ninguna de las ranuras de memoria ocupadas. Eso es deliciosamente geek.

Las CPU Xeon Max colocan chips HBM2e junto a cada mosaico, lo que finalmente ofrece una densidad total de 64 GB, hasta 1,14 GB por núcleo. Intel apunta directamente a estos Max SKU en el mercado de HPC, y aunque muchas cargas de trabajo de HPC requerirán mucha memoria, todavía hay muchas que pueden caber fácilmente en 64 GB. Por supuesto, puede construir sobre este HBM2e con DDR5-4800 en caso de que la densidad de 64 GB HBM2e no sea suficiente.

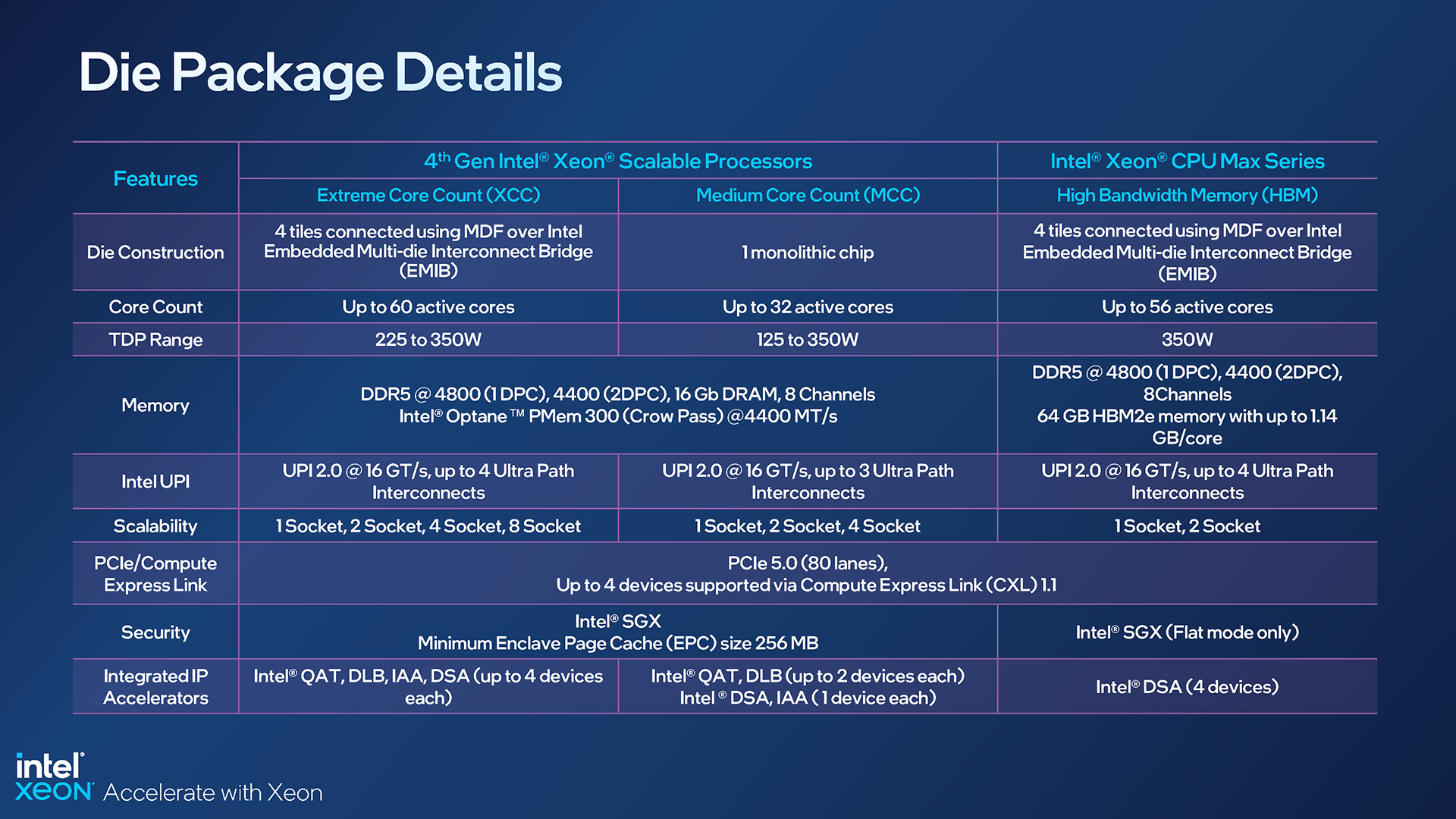

Aquí hay una descripción más detallada de las especificaciones indicadas para cada configuración de CPU:

Especificaciones de Intel Xeon de cuarta generación basadas en el paquete

La diapositiva anterior ayuda a resaltar otro ángulo que vale la pena mirar. En las CPU Max, muchas de las funciones que tenían las otras SKU ya no están, como la tecnología QuickAssist de Intel, el equilibrador de carga dinámico y el acelerador de análisis en memoria. Data Streaming Accelerator permanece, destacando una audiencia objetivo enfocada en láser para las CPU Max.

Esas tecnologías que no están integradas en Max nos llevan a otra diferencia en esta línea Xeon de última generación. Es posible que haya notado una nueva entrada arriba,”Intel On Demand Capable”; esto se refiere a las CPU que pueden comprarse sin todas las funciones premium, pero habilitarlas más tarde a través de los socios del sistema y el propio Intel.

Durante las sesiones informativas del mes pasado, el tema de On Demand pareció confundir a muchos, e incluso hoy, nos quedamos sin entender completamente la mecánica. On Demand suena como un DLC para CPU de servidor, pero debería permitir que algunos compren CPU a precios más justos debido a que no se utilizan tecnologías, y los clientes aún tendrán la opción de revertir el curso más tarde.

Otro ángulo podría Es posible que algunas de las tecnologías de Intel no se aprovechen adecuadamente en un entorno de trabajo, pero si se crea soporte, On Demand puede desbloquear la función desde una CPU. Por lo que entendemos, las CPU Xeon que tienen funciones bloqueadas no tendrán esas funciones contribuyendo a la carga de energía general. De hecho, están inactivos hasta que se desbloquean y activan.

Si vuelves a consultar la hoja de SKU compartida anteriormente, notarás que estas funciones afectadas por On Demand pueden variar mucho en la cantidad de dispositivos a través de el tablero. Los SKU optimizados para la nube, por ejemplo, tienen pocos dispositivos DSA, QAT, DLB e IAA, mientras que el 8490H de gama alta tiene muchos. Dependiendo de la carga de trabajo que busque, es posible que se sienta forzado a elegir el modelo que elija en última instancia.

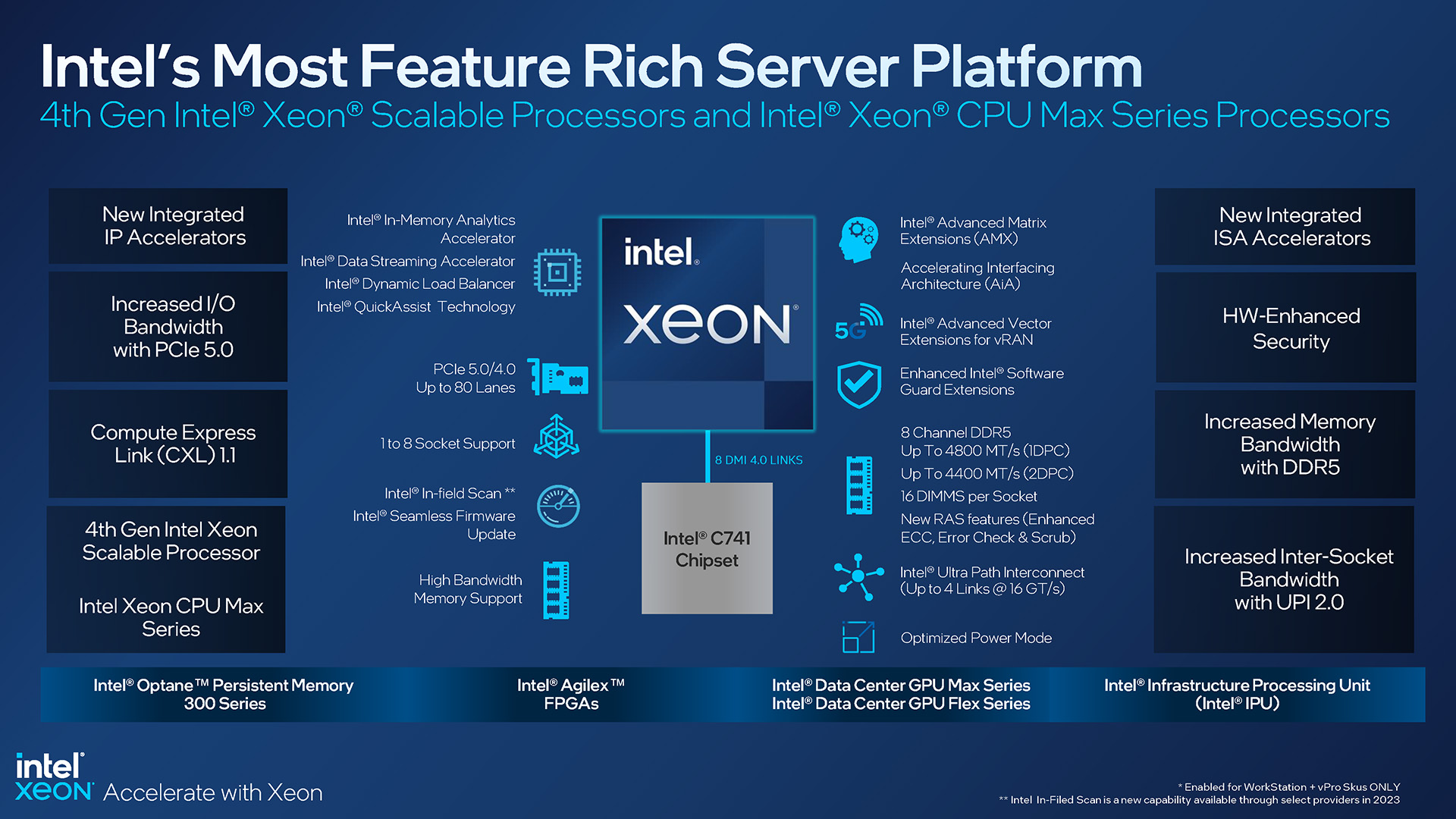

Aquí hay una descripción general de las funciones de Sapphire Rapids (ejem, Xeon de 4.ª generación), que ayuda a cubrir las cosas que Todavía tengo que:

Características de la plataforma Intel Xeon de 4.ª generación

Esta plataforma Xeon de última generación admite PCIe 5.0 y 4.0, así como DDR5 con frecuencias de hasta 4800 MHz. Como antes, esta plataforma tiene un controlador de memoria de 8 canales y, en última instancia, admite hasta 16 DIMM por zócalo.

Vale la pena señalar que Intel continúa admitiendo sus sistemas de 4 y 8 zócalos, lo cual es interesante. considerando su principal competencia, AMD EPYC, alcanza su punto máximo con configuraciones de 2 sockets. Intel dice que todavía ve demanda para estos servidores de muchas CPU, especialmente para el trabajo de inteligencia de bases de datos en memoria, almacenamiento y visualización de datos, consolidación de DC, etc.

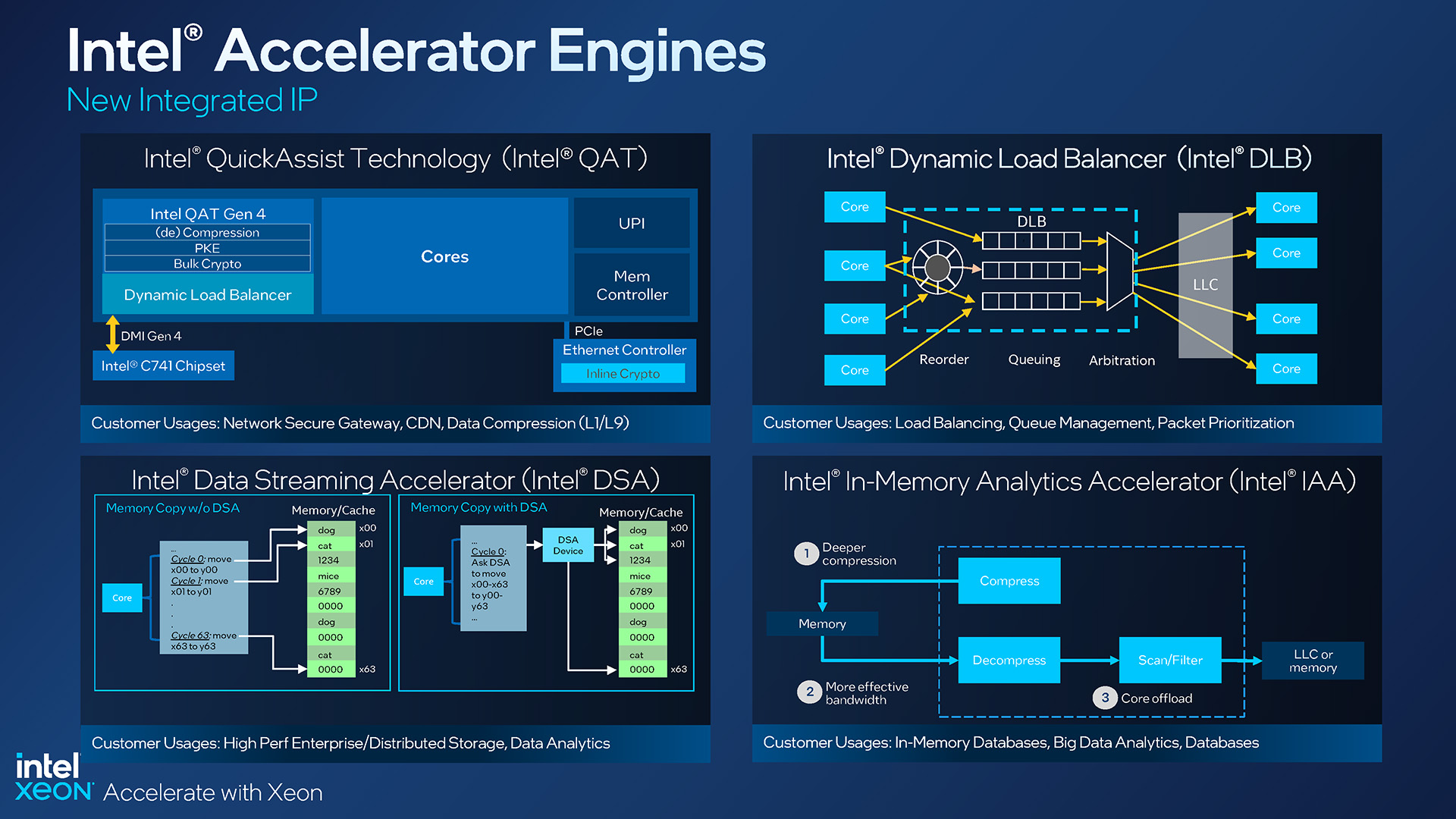

Motores aceleradores Xeon de cuarta generación de Intel

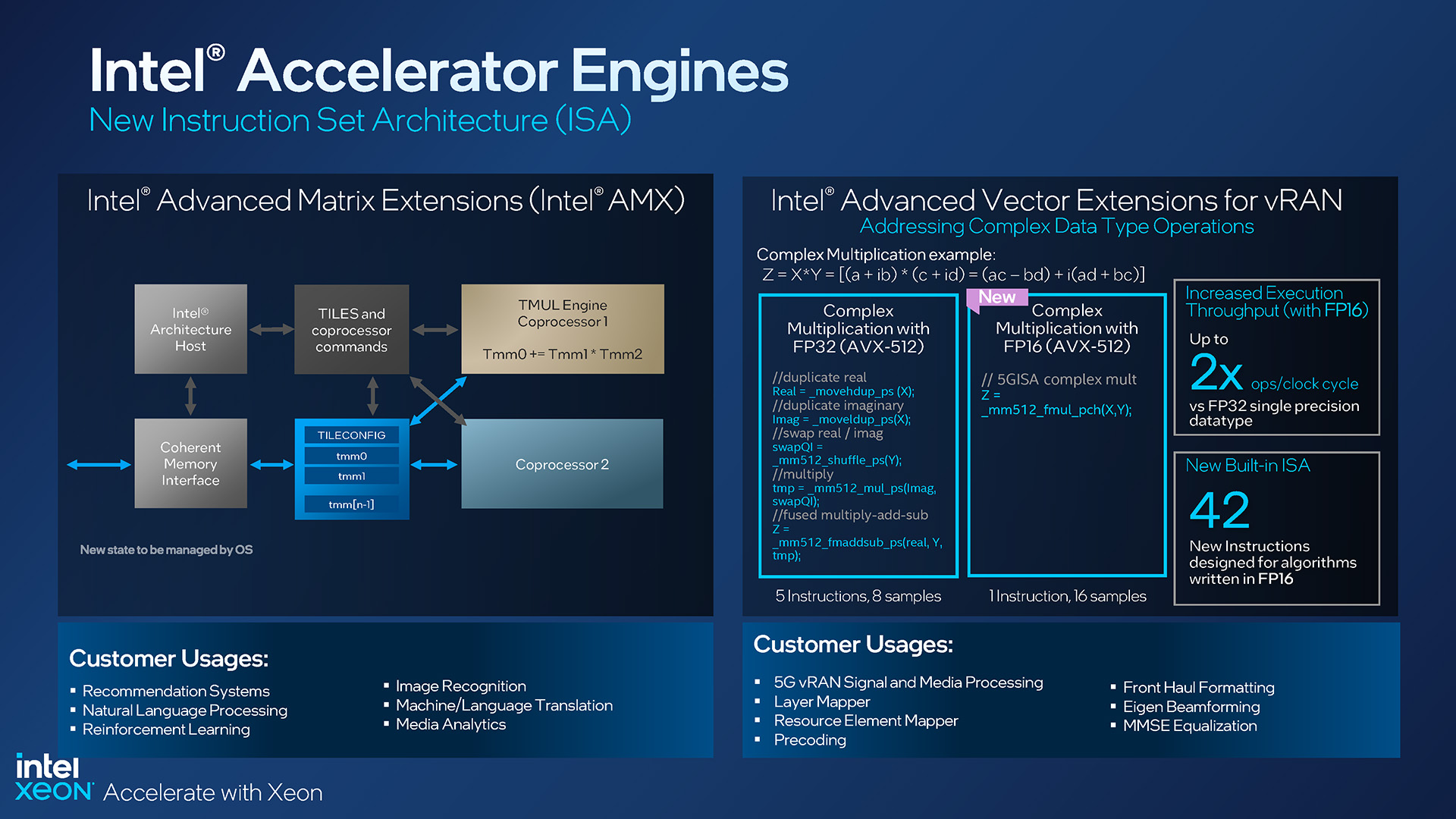

Al principio , mencionamos que los procesadores Xeon de cuarta generación incluyen aceleradores que pueden (o más exactamente, probablemente requerirán) actualizaciones para poder aprovecharlas al máximo. Si bien muchos procesadores Xeon Scalable y Max de cuarta generación cuentan con diferentes niveles de compatibilidad con DSA/QAT/DLB/IAA, todos ellos incluyen el nuevo acelerador de matriz AMX, el último participante en la ISA (arquitectura de conjunto de instrucciones) de Intel.

A Intel le encanta la IA y, con respecto a las CPU Xeon, ha estado hablando de ello durante bastante tiempo. Pero en un momento en que las GPU son tan rápidas en muchas cargas de trabajo de IA, ¿qué hace que Intel quiera implementar una solución como AMX aquí? Para empezar, donde la propia CPU también participa en gran medida en una carga de trabajo de IA, tener AMX justo al lado de los núcleos puede ofrecer un gran rendimiento, tal vez lo suficiente como para ni siquiera necesitar GPU discretas instaladas, dependiendo de la carga de trabajo general.

Intel afirma que su AMX es aproximadamente ocho veces más rápido en el cálculo de álgebra lineal en comparación con su motor vectorial, y los clientes objetivo incluyen esos sistemas de recomendación operativa, reconocimiento de imágenes, procesamiento de lenguaje natural, etc.

Extensiones vRAN y Xeon AMX de 4.ª generación de Intel

vRAN también se infundió con algunas actualizaciones de AVX, con 42 nuevas instrucciones agregadas que aprovechan los algoritmos escritos en FP16, con usos aquí dirigidos al procesamiento de señal y medios, formato de transporte frontal y mapeo de capas.

La aceleración realmente parece ser el nombre del juego con Sapphire Rapids. Se han implementado varios aceleradores para reducir la carga en la propia CPU y, en última instancia, hacer más en la misma cantidad de tiempo.

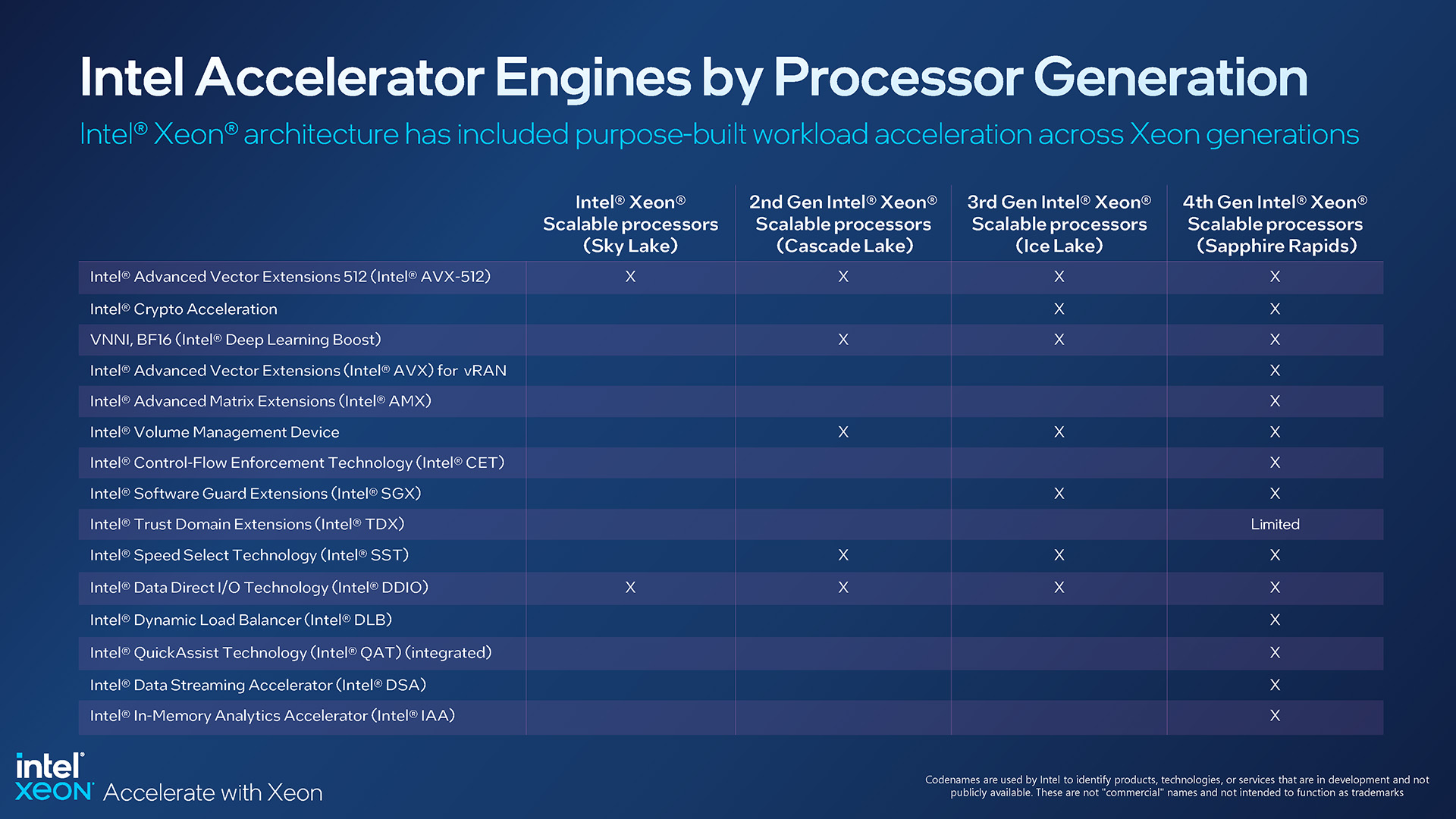

Motores aceleradores para cada generación Xeon Scalable

Afortunadamente, aunque ciertas características del acelerador están ausentes en SKU Xeon, AMX se está convirtiendo en un estándar de facto. Eso es importante, ya que sabemos que muchos proveedores de software necesitarán actualizar sus bits para aprovecharlo al máximo.

El soporte para todos puede no llegar tan rápido como nos gustaría verlo, pero debido a que AMX es un estándar, significa que los desarrolladores pueden sentirse seguros dedicando tiempo a desarrollarlo. Es más difícil de vender cuando una característica nueva y genial tiene un soporte limitado en toda la línea. En particular, tanto TensorFlow como PyTorch tienen soporte AMX incorporado, por lo que parece que hemos tenido un buen comienzo.

Además, todos estos motores aceleradores comparten un espacio de memoria compartido coherente entre los núcleos y los aceleradores. , destacando una vez más los esfuerzos de Intel para ofrecer una arquitectura lo más eficiente posible, con cuellos de botella mínimos.

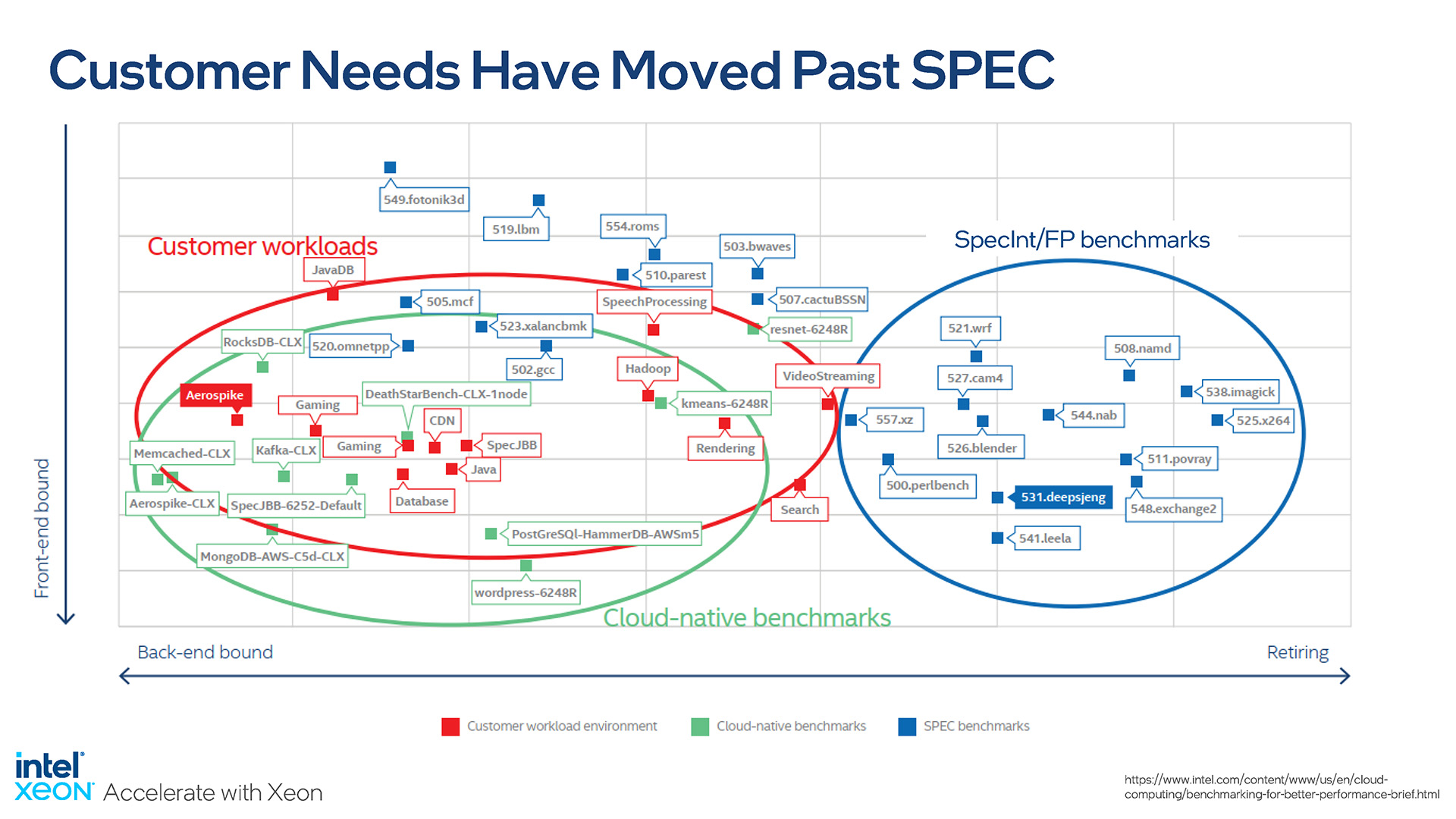

Hablando de rendimiento, Intel Senior Fellow Ronak Singhal realmente nos habló con su presentación, ya que señaló lo importante que es para comparar procesadores con pruebas relevantes. Los puntos de referencia preconstruidos y preajustados tienen su propósito, pero en última instancia, lo que importa a los clientes es cómo la nueva plataforma afecta su carga de trabajo específica.

Esta diapositiva lo dice todo:

Intel destaca la importancia del mundo real pruebas de rendimiento

SPEC es un consorcio que involucra a la mayoría de los jugadores de semiconductores más grandes de la industria, por lo que los puntos de referencia publicados tienden a ser acordados por todos; no habrá sesgo inherente en las pruebas. Sin embargo, estas pruebas son rígidas y sus resultados no reflejarán la mayoría de las cargas de trabajo. Intel mismo trabajó con los clientes para evaluar qué tan desconectados estaban la mayoría de los puntos de referencia de los escenarios en la práctica y, por lo tanto, enfatizar la necesidad de realizar pruebas con puntos de referencia relevantes.

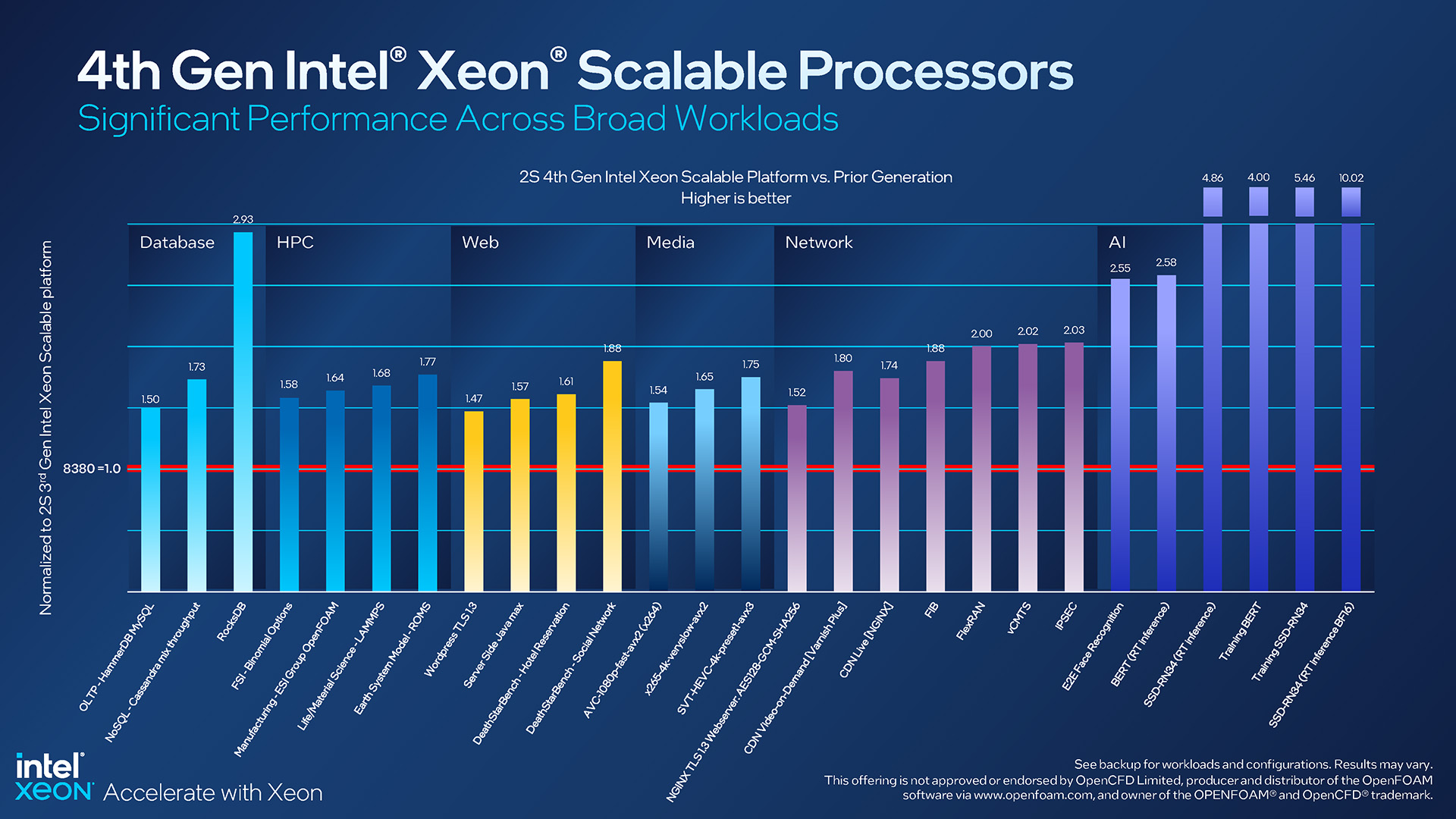

Con ese fin, en más pruebas del mundo real, Sapphire Rapids realiza bien en comparación con el Xeon 8380 de gama alta de la generación anterior:

Expectativas de rendimiento de Intel Xeon de 4.ª generación

Las mejoras de rendimiento observadas en todos los ámbitos son geniales de ver, pero, por supuesto, algunos de estos resultados destacan más que los demás. El RocksDB en particular es interesante, ya que destaca los beneficios con el Acelerador de análisis en memoria actualizado de Intel. Pero incluso las ganancias modestas siguen siendo impresionantes, como una mejora de ~50 % en el rendimiento de WordPress al usar TLS.

No podemos encontrar una mención explícita al respecto, pero tenemos que imaginar todas las cargas de trabajo de IA en el lado derecho de esa diapositiva han visto aumentos gigantescos gracias a la introducción de AMX. Mientras que las últimas cuatro barras se elevan hasta la cima, el resultado de la inferencia BF16 en tiempo real, alrededor de 10 veces, realmente se destaca.

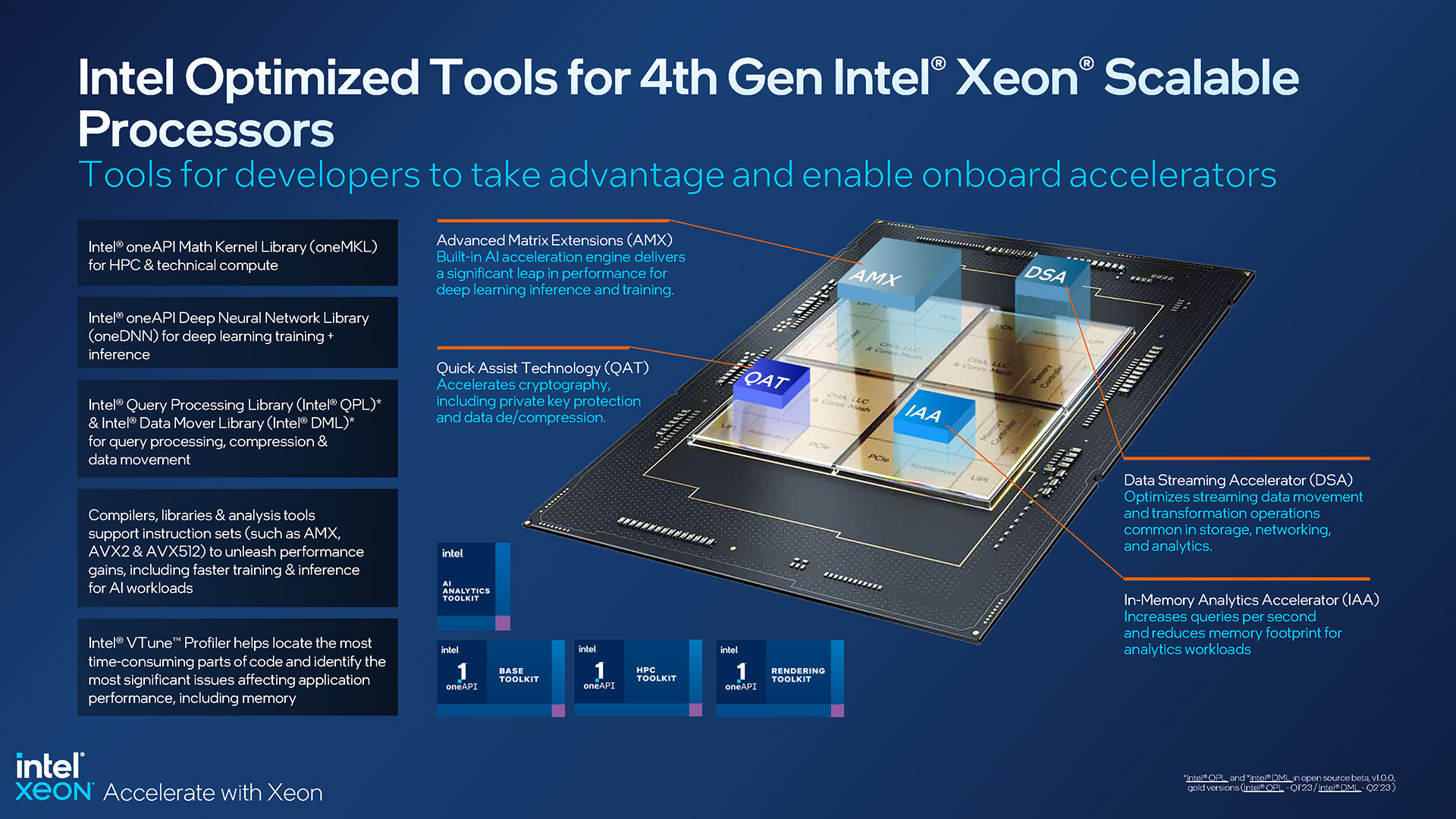

Las herramientas optimizadas ayudan a aprovechar al máximo los procesadores Intel Xeon Scalable y Max de cuarta generación

Porque Las CPU de Intel tienen tanto hardware único que la empresa hace todo lo posible para asegurarse de que todos tengan las herramientas y la información adecuadas para el trabajo. OneAPI de Intel se actualiza continuamente, al igual que muchas otras herramientas, como oneDNN, QPL y DML. La documentación también se actualiza con frecuencia.

Del mismo modo, Intel también sabe que para que los clientes aprovechen al máximo sus funciones de IA, se deben proporcionar ejemplos. Esta es la razón por la cual la empresa ofrece docenas de modelos de IA preentrenados, que la gente puede integrar directamente en sus proyectos o aprender de ellos.

Durante una presentación, Intel señaló que solo el 53 % de los proyectos de IA son rechazados. apaga y termina viendo la finalización, que es una tasa de falla bastante masiva. Con soluciones como oneAPI, que puede extraer potencia de procesamiento de la CPU o de los aceleradores integrados, el objetivo es asegurarse de que los usuarios puedan realizar sus cálculos de la manera más eficaz posible. Con el tiempo, esperamos ver un aumento del 53 %.

Reflexiones finales

Intel ha divulgado mucha información sobre su línea Xeon Scalable y Max de cuarta generación y, en última instancia, Acabo de arañar la superficie aquí, a pesar de que se discutió tanta información buena. Al alejarse de las sesiones informativas en persona el mes pasado, quedó claro que este lanzamiento es muy querido por Intel, y es por una buena razón. Hay mucho aquí que es nuevo e intrigante.

Como siempre, Intel ofrece muchas opciones; sin importar su caso de uso, seguramente encontrará una CPU que se ajuste a sus necesidades. En la parte inferior, hay un 3408U de 8 núcleos para uso general en una plataforma de 1 zócalo, y en la parte superior está el gigantesco 8490H de 60 núcleos que se puede usar en sistemas de 8 zócalos.

Ventajas de rendimiento para Sapphire Rapids de Intel frente a la generación anterior

Es cierto que es la serie Xeon Max la que más nos intriga. Tener 64 GB de memoria ultrarrápida integrada directamente en la CPU podría ser una gran ayuda para ciertas cargas de trabajo, y especialmente en escenarios en los que simplemente no se necesita mucha memoria. El hecho de que un servidor Xeon Max pueda iniciarse y funcionar con normalidad sin un solo DIMM instalado no solo es impresionante, sino también útil.

La forma en que Sapphire Rapids finalmente se compara con la competencia requerirá una evaluación comparativa exhaustiva de otros para averiguarlo, y estamos seguros de que se avecina mucho rendimiento. Dicho esto, no estamos completamente seguros de que el rendimiento de lanzamiento vaya a pintar la imagen más precisa, porque algunos rasgos de diseño de Sapphire Rapids requerirán que se realicen actualizaciones de software. Ya hemos discutido que PyTorch y TensorFlow son compatibles con AMX desde el principio, pero hay mucho más software dirigido a IA por ahí.

En última instancia, nos complace ver el lanzamiento de Sapphire Rapids. , ya que ha tardado mucho en llegar, y también nos complace que haya habido tanto interés de qué hablar. Al igual que con todo lo relacionado con el servidor, la entrada de nuevos productos en el ecosistema será lenta, por lo que será interesante ver cómo están las cosas a mediados y más adelante en el año.

¡Apoye nuestros esfuerzos! Con los ingresos publicitarios en su punto más bajo para los sitios web escritos, confiamos más que nunca en el apoyo de los lectores para ayudarnos a continuar poniendo tanto esfuerzo en este tipo de contenido. Puede apoyarnos convirtiéndose en un patrocinador o utilizando nuestros enlaces de afiliados de compras de Amazon que se enumeran a través de nuestros artículos. ¡Gracias por su apoyo!