¿Por qué la IA generativa es todo un alboroto ahora?

La IA generativa como Bing Ai, ChatGPT y, más recientemente, se han convertido en el centro de atención por usar algoritmos avanzados para generar nuevos datos, imágenes y más que se ven, se sienten y se leen como si fueran producidos por humanos. Las redes adversarias generativas (GAN) son ideales para crear contenido visual, mientras que los modelos de lenguaje preentrenado generativo (GPT) analizan los datos ya disponibles en Internet (u otros medios) para generar un resultado como una respuesta a una consulta, todo el camino. a la producción de artículos’nuevos’completos. El uso de IA para estos aspectos no es nuevo, pero los avances en la forma en que entiende estas consultas y produce resultados que son mucho más utilizables, legibles y identificables para el usuario promedio es lo que hace que la IA generativa sea una herramienta potente.

Las preocupaciones son, por supuesto, controvertidas y abundantes, pero aún es pronto. Sin embargo, la tecnología es muy ideal para crear más datos para entrenar y mejorar los diversos modelos que pueden acelerar varias tareas menores o mundanas que requieren algún tipo de inferencia para dar el siguiente mejor paso adelante, e incluso hacer realidad los automóviles completamente automotrices. donde un modelo de simulación de conducción automotriz se entrena continuamente a través de infinitas variedades de nuevos datos ambientales generados y entrenados virtualmente, construyendo así un modelo preentrenado cada vez más sólido.

Aquí hay más lecturas sobre este tema de la consultora global McKinsey & Company para más información y el varias industrias que pueden beneficiarse de la IA generativa.

Ingrese a NVIDIA AI Foundations: permitir a las empresas crear modelos de IA generativos personalizados internos

Ahora que sabemos por qué la IA generativa es tan valiosa e importante, eso nos lleva al gran presione para apoyar a las empresas con servicios en la nube para crear sus propios modelos de lenguaje grande personalizados (LLM, de los cuales ChatGPT es un excelente ejemplo) y modelos de generación visual para aplicaciones de IA. Más específicamente, estos modelos de IA generativos personalizados se desarrollan y entrenan con los propios datos de propiedad de la empresa para sus ofertas únicas específicas de dominio.

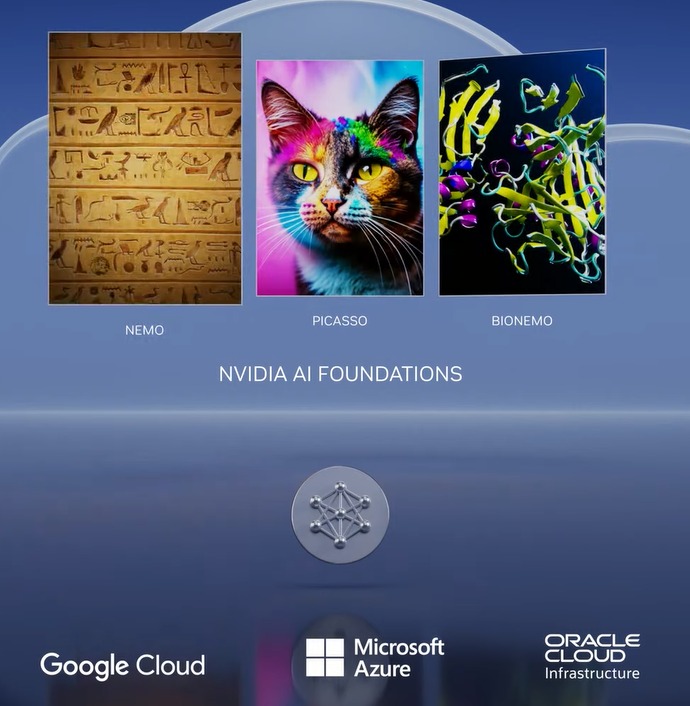

Esto es posible gracias a NVIDIA AI Foundations, que es un conjunto de servicios en la nube que permite a las empresas crear, perfeccionar y operar dichos LLM. y modelos generativos de IA.

El servicio en la nube NVIDIA NeMo permite a los desarrolladores hacer que los modelos de lenguaje extenso (LLM) sean más relevantes para las empresas al definir áreas de enfoque, agregar conocimientos específicos del dominio y enseñar habilidades funcionales.

NVIDIA Picasso es un servicio en la nube para crear e implementar aplicaciones generativas de imagen, video y 3D impulsadas por IA con capacidades avanzadas de texto a imagen, texto a video y texto a 3D. para impulsar la productividad para la creatividad, el diseño y la simulación digital a través de simples API en la nube.

NVIDIA BioNeMo es un nuevo servicio en la nube que debutó hoy para acelerar la investigación en ciencias de la vida, el descubrimiento de fármacos, la ingeniería de proteínas y la investigación en los campos de la genómica, la biología, la química y la dinámica modular.

Estos servicios se ejecutan en NVIDIA DGX Cloud, a la que se puede acceder a través de un navegador. Actualmente están disponibles para clientes de acceso anticipado y se encuentran en la etapa de vista previa privada. Los desarrolladores pueden usar estos modelos que se ofrecen en cada servicio a través de API simples y, cuando los modelos están listos para su implementación, las empresas pueden ejecutar cargas de trabajo de inferencia a escala utilizando los servicios en la nube NVIDIA AI Foundations.

Los líderes de la industria se asocian con NVIDIA para productividad avanzada para profesionales creativos

Adobe anunció hoy que ampliará su asociación de investigación y desarrollo de larga data para crear modelos de IA generativa de próxima generación con NVIDIA. Para acelerar los flujos de trabajo de creadores y especialistas en marketing, algunos de estos modelos se desarrollarán conjuntamente y se lanzarán al mercado a través de los productos insignia de Adobe Creative Cloud, como Photoshop, Premiere Pro y After Effects, así como a través de NVIDIA Picasso.

NVIDIA y Getty Images están colaborando para entrenar modelos básicos generativos responsables de texto a imagen y de texto a video. Los modelos permitirán la creación de imágenes y videos mediante indicaciones de texto simples y se entrenarán en los activos con licencia completa de Getty Images.

NVIDIA y Shutterstock están colaborando para entrenar un texto generativo modelo básico a 3D con el servicio NVIDIA Picasso para simplificar la creación de modelos 3D detallados y reducir el tiempo necesario para crear modelos 3D de días a minutos.

Las nuevas GPU potencian las plataformas de inferencia para abordar diversas IA generativas cargas de trabajo

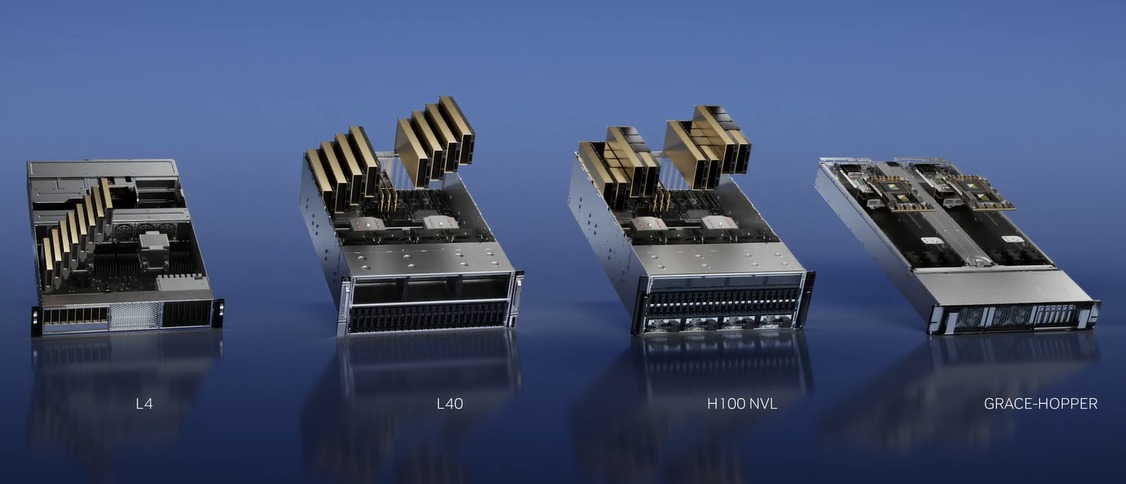

Para aumentar el impulso de NVIDIA para ayudar a crear modelos de IA generativos personalizados nuevos y emergentes a través de los servicios en la nube de NVIDIA Foundation, también lanzaron una gran cantidad de nuevas GPU y plataformas para ayudar a los desarrolladores a crear y potenciar estas nuevas aplicaciones de IA basadas en NVIDIA Ada Lovelace, Procesadores Hopper y Grace Hopper.

El auge de la IA generativa requiere una inferencia más poderosa y plataformas informáticas. La cantidad de aplicaciones para la IA generativa es infinita, limitada solo por la imaginación humana. Equipar a los desarrolladores con la plataforma informática de inferencia más poderosa y flexible acelerará la creación de nuevos servicios que mejorarán nuestras vidas de formas aún inimaginables. – Jensen Huang, fundador y director ejecutivo de NVIDIA.

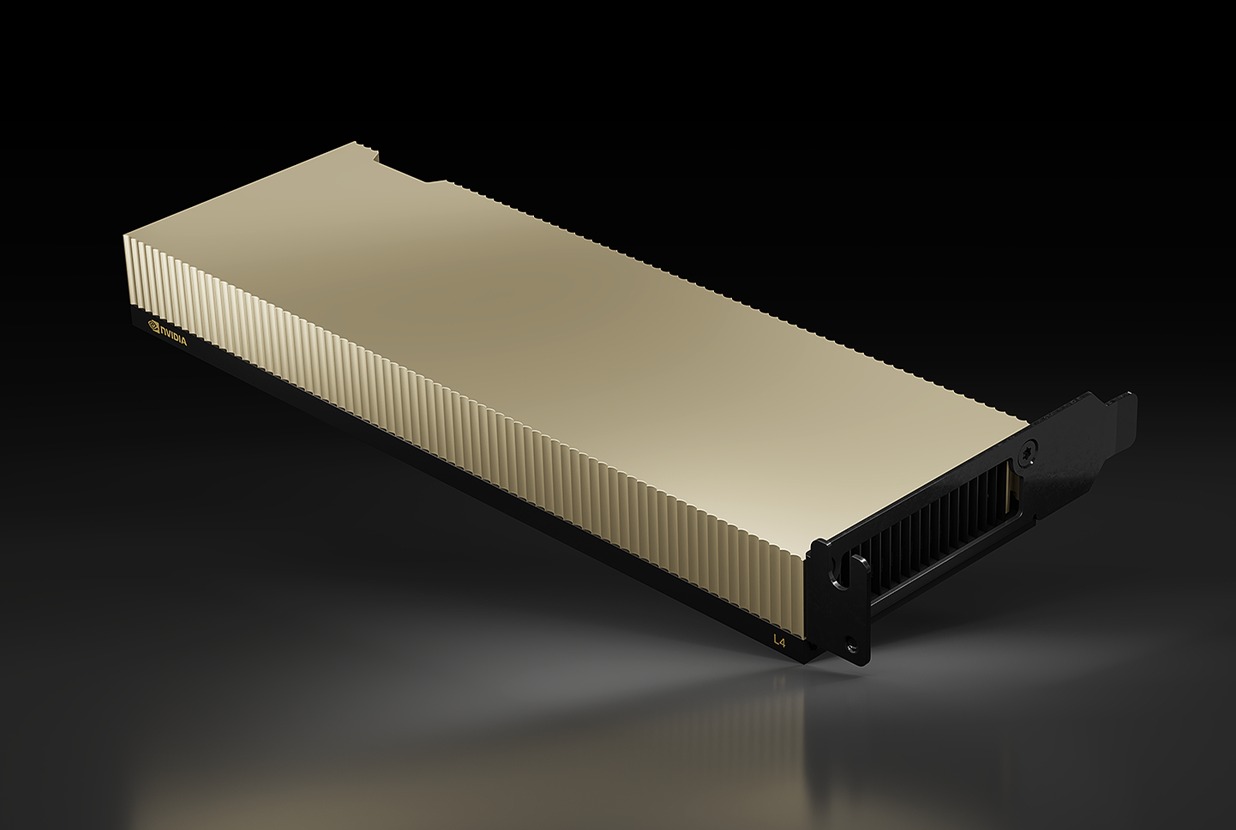

1) NVIDIA L4 para video AI

La nueva NVIDIA L4 es el reemplazo directo de la popular GPU T4, que fue la primera en usar Tensor Cores y se diseñó expresamente para cargas de trabajo de inferencia de IA para analizar nuevas entradas de datos para predecir y calcule un resultado deseado en función de modelos previamente entrenados.

El T4 fue impulsado por la microarquitectura de Turing, que fue la primera en admitir y acelerar las cargas de trabajo de trazado de rayos. El nuevo L4, basado en la arquitectura de GPU Ada Lovelace (esto es lo que impulsa la serie GeForce RTX 40) que admite DLSS 3 con tecnología de IA, está clasificado para ofrecer una aceleración de más de 4 veces en el rendimiento de renderizado en tiempo real sobre Omniverse, y es capaz de repartir Rendimiento de trazado de rayos 3 veces superior.

Con este rendimiento mejorado, la GPU L4 está posicionada para cargas de trabajo de video de IA para abordar la decodificación de video en tiempo real, la transcodificación, la moderación de contenido de video, la traducción de idiomas, funciones de mejora de videollamadas como como reemplazo de fondo, reiluminación, contacto visual, realidad aumentada y más. Los codificadores duales AV1 de la nueva GPU también son excelentes razones por las que el L4 es ideal para estas tareas de video de IA. De hecho, un solo servidor L4 de 8 GPU puede reemplazar a más de cien servidores tradicionales de CPU de doble socket en el procesamiento de video AI. Este es un ahorro masivo en el costo total de propiedad en comparación con las infraestructuras más antiguas.

Mejor aún, el L4 también está diseñado en el mismo factor de forma de perfil bajo y una envolvente de potencia de 72 W ligeramente inferior, lo que hace que la actualización del T4 existente servidores con un L4 muy fácil, al tiempo que mejora la destreza de inferencia de la IA por un buen margen.

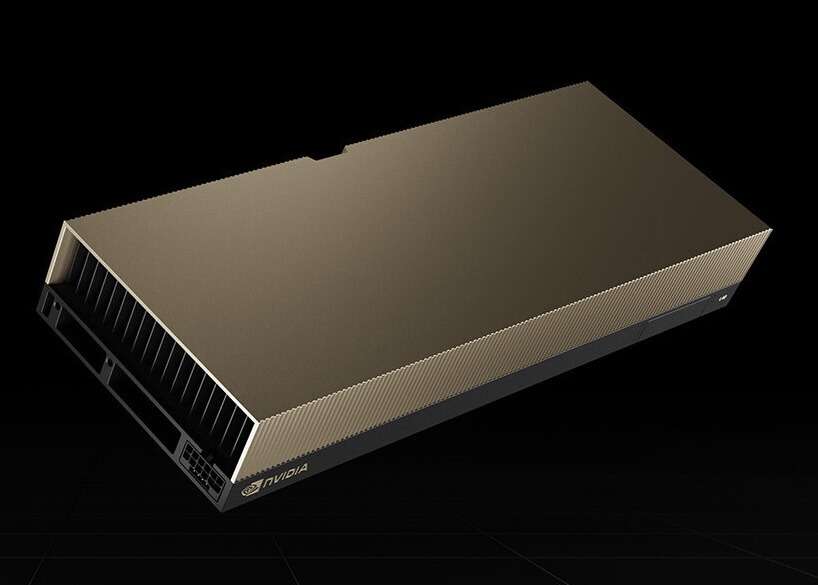

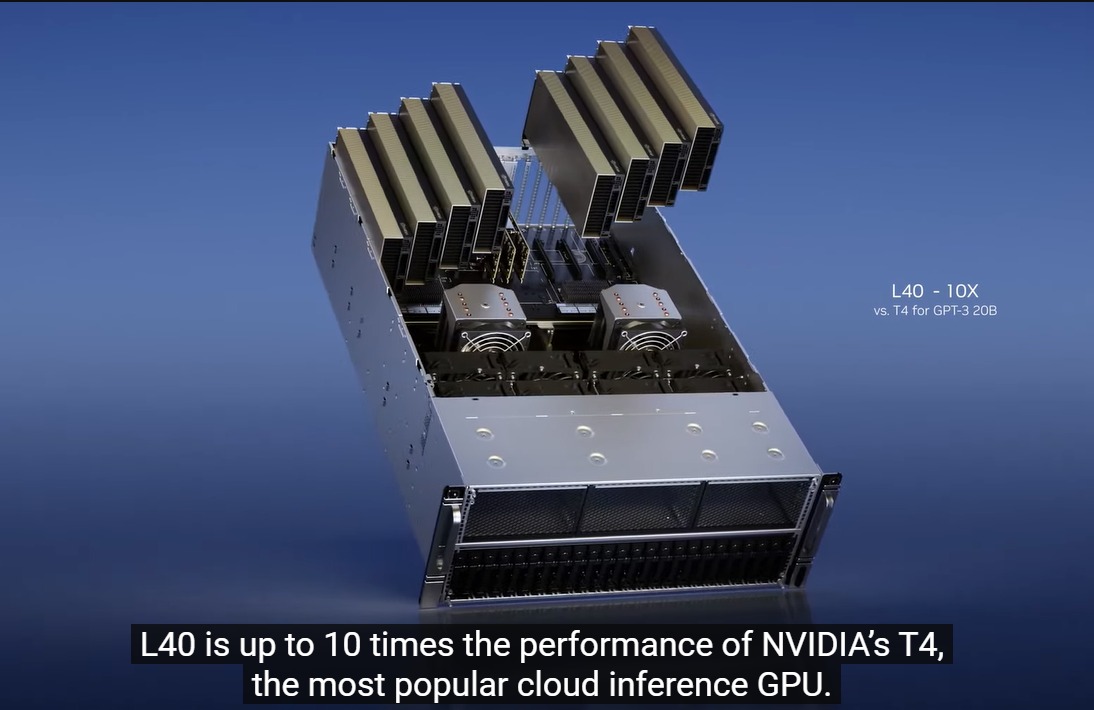

2) L40 para generación de imágenes

La L40 se anunció en 2022, pero no fue hasta hace poco que vio algo de acción. Basado en la GPU Ada Lovelace RTX con más de 18 000 núcleos de procesamiento CUDA y 142 núcleos RT, el L40 tiene un gran impacto, ya que estas especificaciones lo colocan muy por delante de los paquetes del RTX 4090. Pero a diferencia del RTX 4090 que está optimizado para altas velocidades de reloj, rasterización y rendimiento de trazado de rayos con enfriamiento activo y un mayor presupuesto de energía, el L40 tiene un diseño de enfriamiento pasivo con un TDP de 300 W y está destinado a aprovechar las rutas de flujo de aire diseñadas dentro servidores en rack.

El L40 también incluye 48 GB de memoria GDDR6 con ECC, perfecta para Omniverse Enterprise, renderizado, gráficos 3D, estación de trabajo virtual NVIDIA RTX, capacitación en IA y ciencia de datos. De hecho, es la columna vertebral del servidor NVIDIA OVX que está diseñado para construir gemelos digitales Omniverse a gran escala.

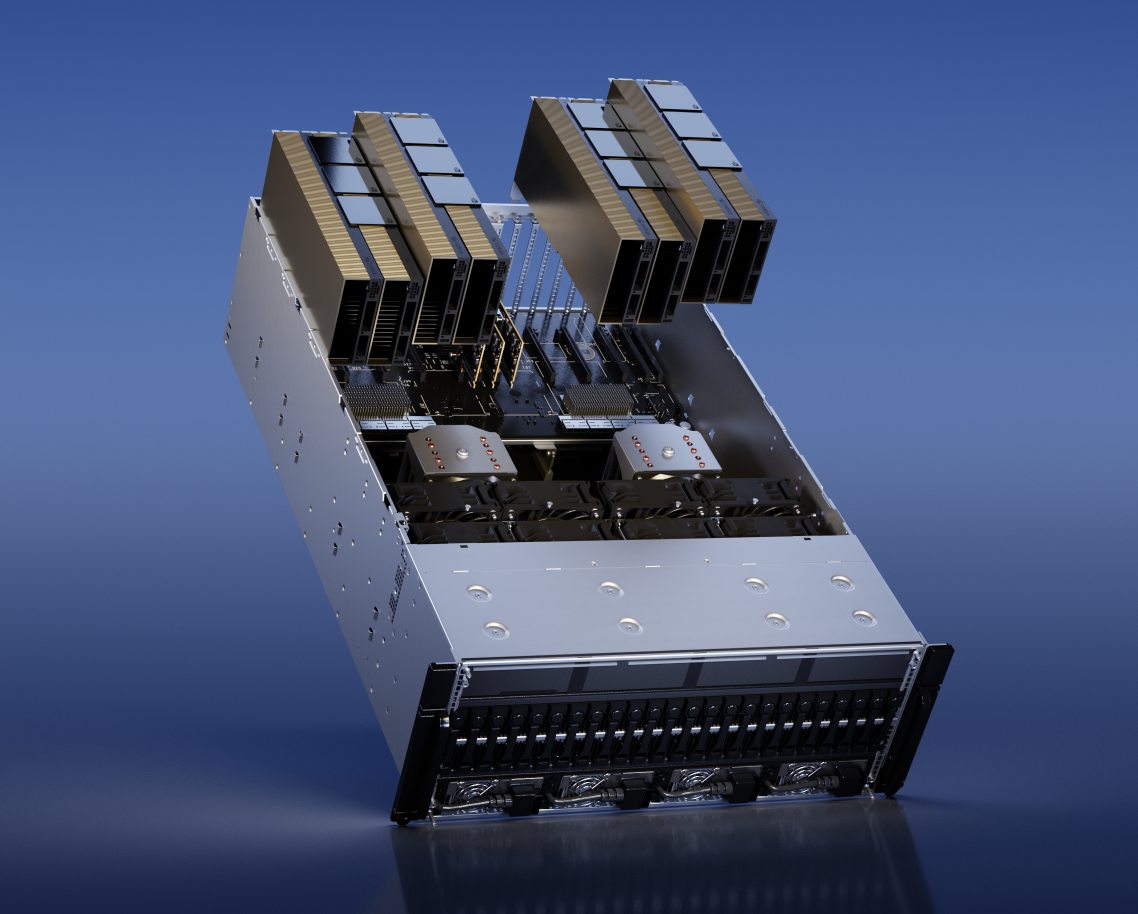

3) H100 NVL para implementación de modelo de lenguaje grande (LLM)

La arquitectura Hopper GPU basada en H100 es un producto increíble que está enfocado para el centro de datos Aceleración de IA, ya que renuncia a los núcleos RT y se empaqueta en una interfaz de memoria mucho más rápida para conectarse con la memoria HBM. Tan rápido como es el H100, NVIDIA ya es consciente de que necesita hacer más ahora para ser el impulsor de los servicios generativos de IA como ChatGPT a escala. En GTC 2023, NVIDIA anunció el H100 NVL basado en tarjeta PCIe dual que se conectan mediante NVLink entre sí. Para que sea más ideal que dos productos H100 PCIe existentes (contienen 80 GB de memoria), el nuevo H100 NVL incluye 94 GB cada uno, para un gran total de memoria gráfica de 188 GB, con gráficos de 7,8 TB/s. ancho de banda de memoria. Además, la configuración de la GPU del H100NVL es idéntica a la SKU del H100 SXM, por lo que el H100 NVL es mucho más rápido que el H100 PCIe, incluso si este último tenía NVLink.

Según NVIDIA, el H100 El servidor equipado con NVL (con cuatro H100 NVL) es más de 10 veces más rápido que un servidor HGX A100 (ocho H100 SXM) que procesa GPT-3. Eso es un aumento fenomenal en el procesamiento del modelo de lenguaje.

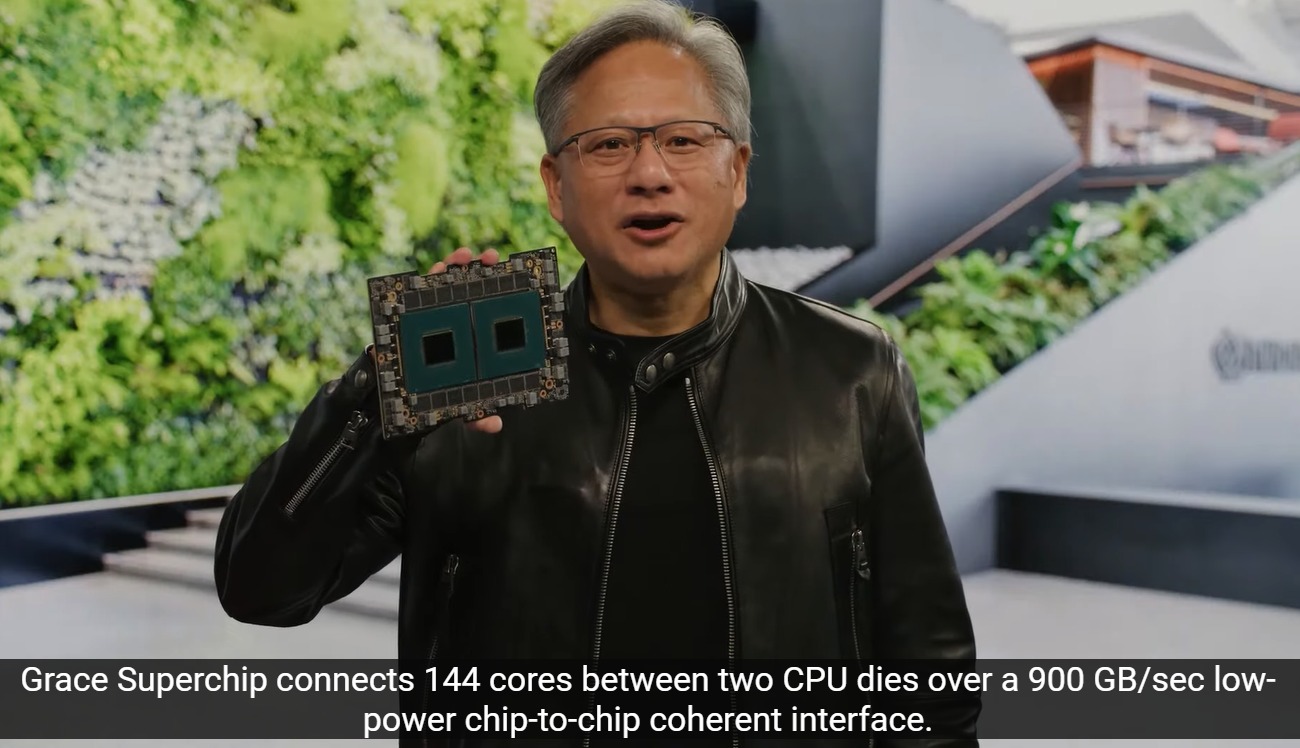

4) NVIDIA Grace Hopper para modelos de recomendación

Por último, NVIDIA también tiene el súper chip Grace Hopper para procesar conjuntos de datos gigantes en bases de datos de IA y modelos de recomendación de gráficos, donde el módulo es súper rápido y bajo. La latencia de chip a chip NVLink-C2C permite un ancho de banda de interconexión de más de 900 GB/s entre el chip Grace basado en ARM y la GPU Hopper. Esto permite que una consulta gigante se procese en la CPU y luego se transfiera inmediatamente a la GPU Hopper para un procesamiento de inferencia que es más de siete veces más rápido que PCI Express 5.0.