Pourquoi l’IA générative est-elle à la mode ?

L’IA générative comme Bing Ai, ChatGPT et plus récemment a été mise à l’honneur en raison de l’utilisation d’algorithmes avancés pour générer de nouvelles données et de nouveaux visuels et plus qui ressemblent, se sentent et se lisent comme s’ils avaient été produits par des humains. Les réseaux antagonistes génératifs (GAN) sont idéaux pour créer du contenu visuel, tandis que les modèles de langage pré-formés génératifs (GPT) analysent les données déjà disponibles sur Internet (ou d’autres moyens) pour générer une sortie telle qu’une réponse à une requête, jusqu’au bout. à la production de « nouveaux » articles entiers. L’utilisation de l’IA pour ces aspects n’est pas nouvelle, mais des percées dans la façon dont elle comprend ces requêtes et produisent des résultats beaucoup plus utilisables, lisibles et pertinents pour l’utilisateur moyen sont ce qui fait de l’IA générative un outil puissant.

Les préoccupations sont, bien sûr, controversées et nombreuses, mais ce n’est encore qu’un début. Pourtant, la technologie est très idéale pour créer plus de données pour former et améliorer les différents modèles qui peuvent accélérer plusieurs tâches subalternes ou banales qui nécessitent une certaine forme d’inférence pour faire le prochain meilleur pas en avant, et même faire des voitures entièrement automobiles une réalité, où un modèle de simulation de conduite automobile est continuellement formé grâce à une variété infinie de nouvelles données environnementales générées et formées virtuellement, créant ainsi un modèle pré-formé de plus en plus solide.

Voici plus de lecture sur ce sujet de la société de conseil mondiale McKinsey & Company pour plus d’informations, et le divers secteurs qui ont tout à gagner de l’IA générative.

Entrez NVIDIA AI Foundations : Permettre aux entreprises de créer des modèles d’IA générative personnalisés en interne

Alors, maintenant que nous savons pourquoi l’IA générative est si précieuse et importante, cela nous amène au grand projet de NVIDIA push pour aider les entreprises avec des services cloud à créer leurs propres grands modèles de langage personnalisés (LLM, dont ChatGPT est un excellent exemple) et des modèles de génération visuelle pour les applications d’IA. Plus précisément, ces modèles d’IA génératifs personnalisés sont développés et formés avec les propres données exclusives de l’entreprise pour leurs offres spécifiques à un domaine unique.

Cela est rendu possible grâce à NVIDIA AI Foundations, qui est un ensemble de services cloud permettant aux entreprises de créer, d’affiner et d’exploiter ces LLM et des modèles d’IA génératifs.

Le service cloud NVIDIA NeMo permet aux développeurs de rendre les grands modèles de langage (LLM) plus pertinents pour les entreprises en définissant des domaines d’intérêt, en ajoutant des connaissances spécifiques à un domaine et en enseignant des compétences fonctionnelles.

NVIDIA Picasso est un service cloud permettant de créer et de déployer des applications génératives d’image, de vidéo et de 3D alimentées par l’IA, avec des fonctionnalités avancées de conversion de texte en image, de texte en vidéo et de texte en 3D. pour booster la productivité de la créativité, de la conception et de la simulation numérique grâce à de simples API cloud.

NVIDIA BioNeMo est un nouveau service cloud qui a fait ses débuts aujourd’hui pour accélérer la recherche en sciences de la vie, la découverte de médicaments, l’ingénierie des protéines et la recherche dans les domaines de la génomique, de la biologie, de la chimie et de la dynamique modulaire.

Ces services s’exécutent sur NVIDIA DGX Cloud, accessible via un navigateur. Ils sont actuellement disponibles pour les clients à accès anticipé et sont en phase de prévisualisation privée. Les développeurs peuvent utiliser ces modèles proposés sur chaque service via des API simples et lorsque les modèles sont prêts à être déployés, les entreprises peuvent exécuter des charges de travail d’inférence à grande échelle à l’aide des services cloud NVIDIA AI Foundations.

Les leaders de l’industrie s’associent à NVIDIA pour faire progresser la productivité des professionnels de la création

Adobe a annoncé aujourd’hui qu’il allait étendre son partenariat de recherche et développement de longue date pour créer les modèles d’IA générative de nouvelle génération avec NVIDIA. Pour accélérer les flux de travail des créateurs et des spécialistes du marketing, certains de ces modèles seront développés et commercialisés conjointement via les produits phares d’Adobe Creative Cloud tels que Photoshop, Premiere Pro et After Effects, ainsi que via NVIDIA Picasso.

NVIDIA et Getty Images collaborent pour former des modèles de base génératifs responsables de conversion texte-image et texte-vidéo. Les modèles permettront la création d’images et de vidéos à l’aide de simples invites textuelles et seront entraînés sur les ressources entièrement sous licence de Getty Images.

NVIDIA et Shutterstock collaborent pour entraîner un texte génératif un modèle de base en 3D à l’aide du service NVIDIA Picasso pour simplifier la création de modèles 3D détaillés et réduire le temps nécessaire à la création de modèles 3D de quelques jours à quelques minutes.

Les nouveaux GPU alimentent les plates-formes d’inférence pour s’attaquer à diverses IA génératives charges de travail

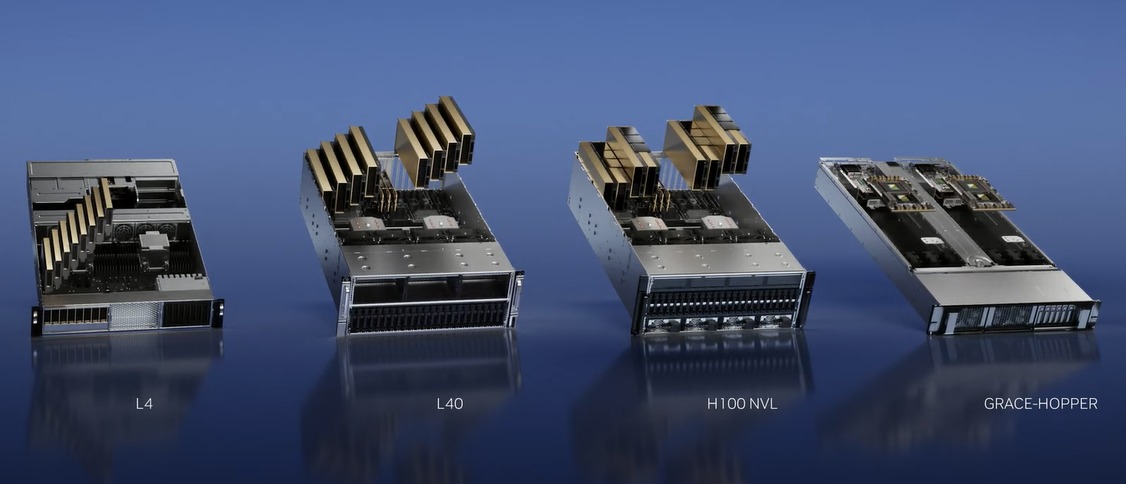

Pour renforcer les efforts de NVIDIA pour aider à créer de nouveaux modèles d’IA génératifs personnalisés via les services cloud de NVIDIA Foundation, ils ont également lancé une multitude de nouveaux GPU et plates-formes pour aider les développeurs à créer et à alimenter ces nouvelles applications d’IA basées sur NVIDIA Ada Lovelace, Processeurs Hopper et Grace Hopper.

L’essor de l’IA générative nécessite des inférences plus puissantes e plates-formes informatiques. Le nombre d’applications pour l’IA générative est infini, limité uniquement par l’imagination humaine. Armer les développeurs de la plate-forme informatique d’inférence la plus puissante et la plus flexible accélérera la création de nouveaux services qui amélioreront nos vies d’une manière encore inimaginable. – Jensen Huang, fondateur et PDG de NVIDIA.

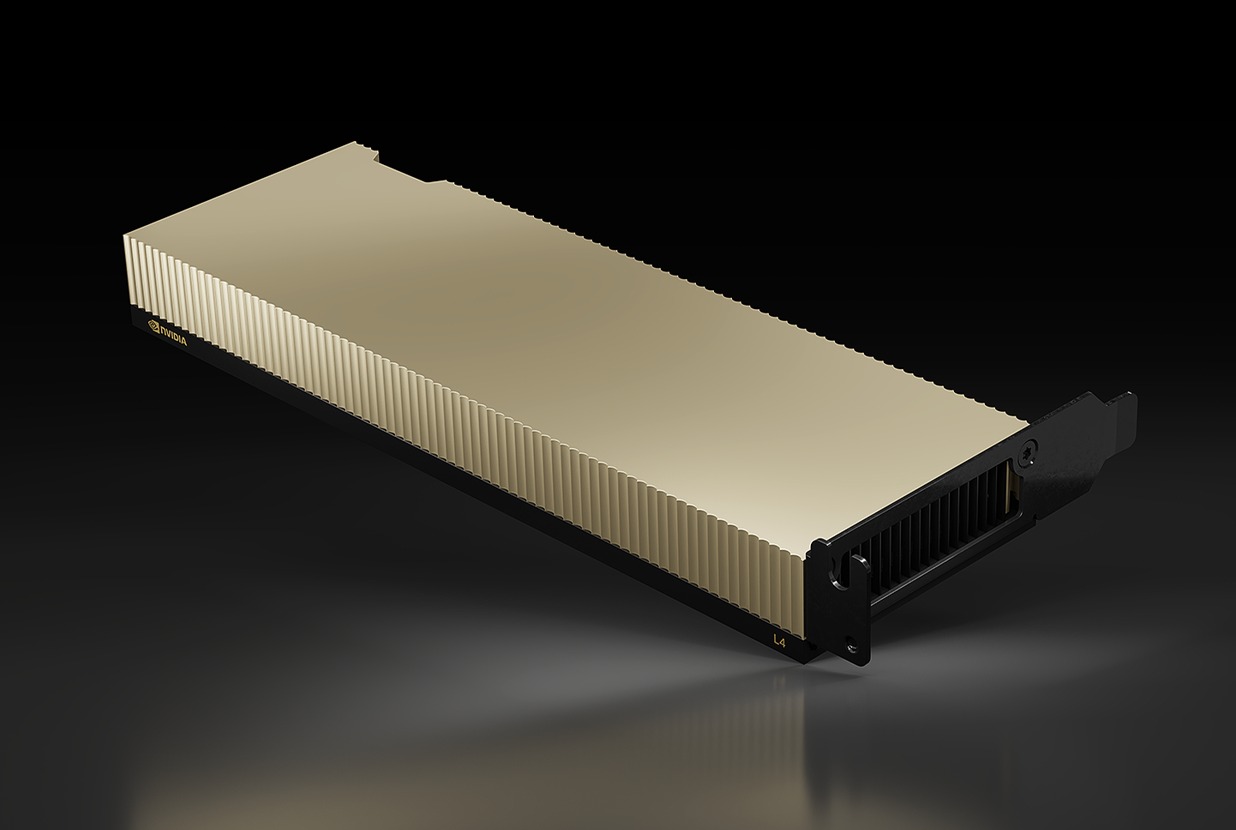

1) NVIDIA L4 pour la vidéo IA

Le nouveau NVIDIA L4 est le remplacement direct du populaire GPU T4, qui a été le premier à utiliser Tensor Cores et conçu expressément pour les charges de travail d’inférence d’IA afin d’analyser de nouvelles entrées de données pour prédire et estimer un résultat souhaité sur la base de modèles pré-entraînés.

Le T4 était alimenté par la microarchitecture de Turing, qui a été la première à prendre en charge et à accélérer les charges de travail tracées par rayons. Le nouveau L4, basé sur l’architecture GPU Ada Lovelace (c’est ce qui alimente la série GeForce RTX 40) prenant en charge le DLSS 3 alimenté par l’IA, est conçu pour offrir une accélération de plus de 4 fois les performances de rendu en temps réel sur Omniverse, et est capable de distribuer Performances de lancer de rayons 3 fois plus élevées.

Grâce à ce débit amélioré, le GPU L4 est positionné pour les charges de travail vidéo IA pour s’attaquer au décodage vidéo en temps réel, au transcodage, à la modération du contenu vidéo, à la traduction linguistique, aux fonctionnalités d’amélioration des appels vidéo telles que comme remplacement d’arrière-plan, rééclairage, contact visuel, réalité augmentée et plus encore. Les doubles encodeurs AV1 du nouveau GPU sont également d’excellentes raisons pour lesquelles le L4 est idéal pour ces tâches vidéo AI. En fait, un seul serveur L4 à 8 GPU peut remplacer plus d’une centaine de serveurs CPU traditionnels à double socket dans le traitement de la vidéo AI. Il s’agit d’une économie massive du coût total de possession par rapport aux infrastructures plus anciennes.

Mieux encore, le L4 est également conçu dans le même facteur de forme à profil bas et une enveloppe de puissance légèrement inférieure de 72 W, ce qui permet de mettre à niveau le T4 existant. serveurs avec un L4 un jeu d’enfant, tout en améliorant les prouesses d’inférence de l’IA par une bonne marge.

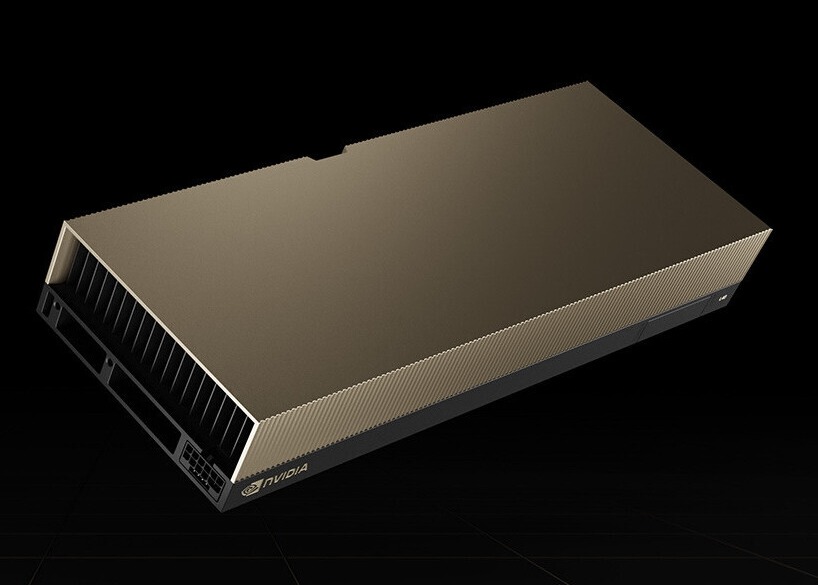

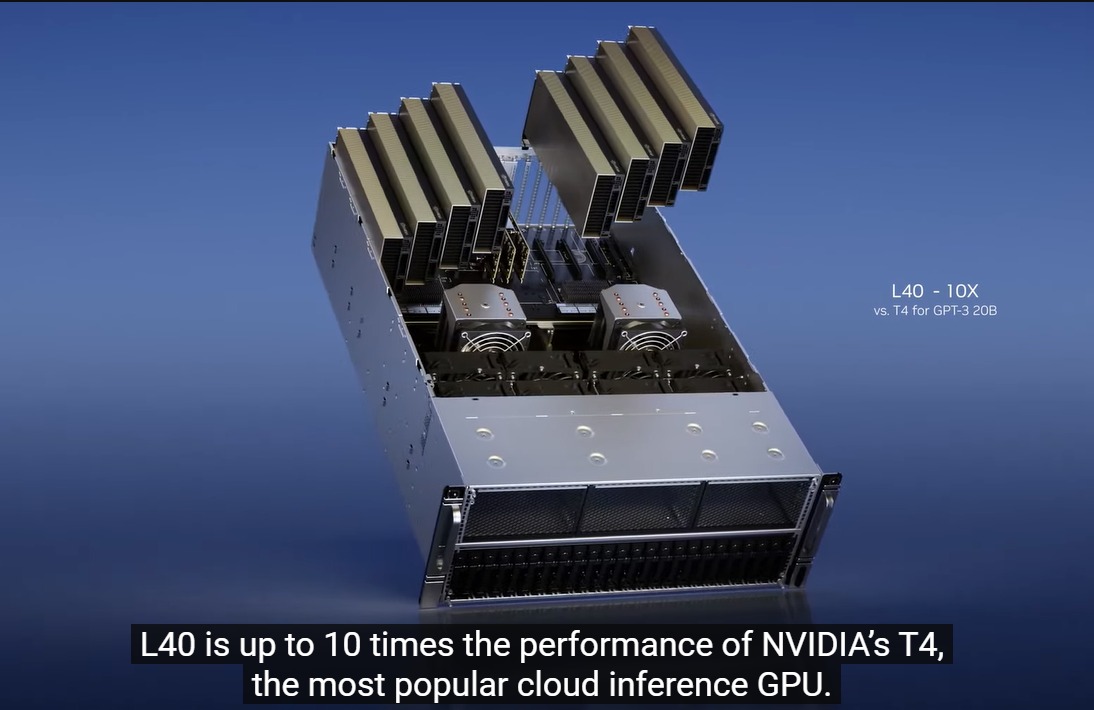

2) L40 pour la génération d’images

Le L40 a en fait été annoncé en 2022, mais ce n’est que récemment qu’il a vu une action. Basé sur le GPU Ada Lovelace RTX avec plus de 18 000 cœurs de traitement CUDA 142 cœurs RT, le L40 est assez puissant car ces spécifications le placent bien en avance sur ce que contient le RTX 4090. Mais contrairement au RTX 4090 qui est optimisé pour des vitesses d’horloge élevées, la rastérisation et les performances de lancer de rayons avec un refroidissement actif et un budget de puissance plus élevé, le L40 est une conception refroidie passivement avec un TDP de 300 W et est destiné à tirer parti des voies de circulation d’air conçues dans serveurs rack.

Le Le L40 contient également 48 Go de mémoire GDDR6 avec ECC, parfait pour Omniverse Enterprise, le rendu, les graphiques 3D, la station de travail virtuelle NVIDIA RTX, la formation à l’IA et la science des données. En fait, c’est l’épine dorsale du serveur NVIDIA OVX qui est destiné à la création de jumeaux numériques Omniverse à grande échelle.

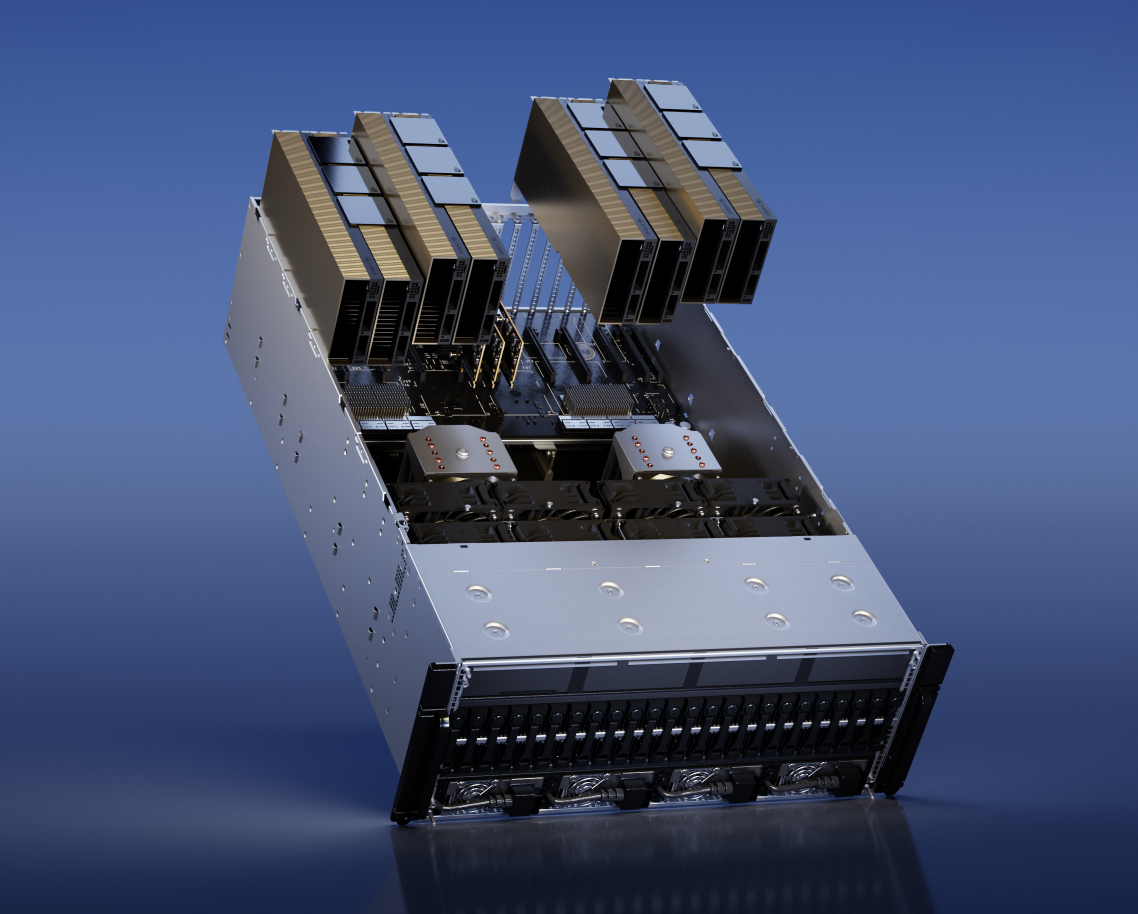

3) H100 NVL pour le déploiement de grands modèles de langage (LLM)

L’architecture GPU Hopper basée sur H100 est un produit génial qui se concentre sur les centres de données Accélération de l’IA car elle renonce aux cœurs RT et intègre une interface mémoire beaucoup plus rapide pour se connecter à la mémoire HBM. Aussi rapide que soit le H100, NVIDIA est déjà conscient qu’il doit faire plus maintenant pour être le moteur des services génératifs d’IA comme ChatGPT à grande échelle. Au GTC 2023, NVIDIA a annoncé la double carte PCIe H100 NVL qui sont NVLink’s l’une à l’autre. Pour le rendre plus idéal que deux produits H100 PCIe existants (ils contiennent 80 Go de mémoire), les nouveaux packs H100 NVL de 94 Go chacun, pour un grand total de 188 Go de mémoire graphique, avec une carte graphique de 7,8 To/s bande passante mémoire. De plus, la configuration GPU du H100NVL est identique à celle du SKU H100 SXM, ainsi le H100 NVL est beaucoup plus rapide que le H100 PCIe, même si ce dernier était NVLink.

Selon NVIDIA, le H100 Le serveur équipé de NVL (avec quad H100 NVL) est plus de 10x plus rapide qu’un serveur HGX A100 (huit H100 SXM) traitant GPT-3. C’est une augmentation phénoménale du traitement des modèles de langage.

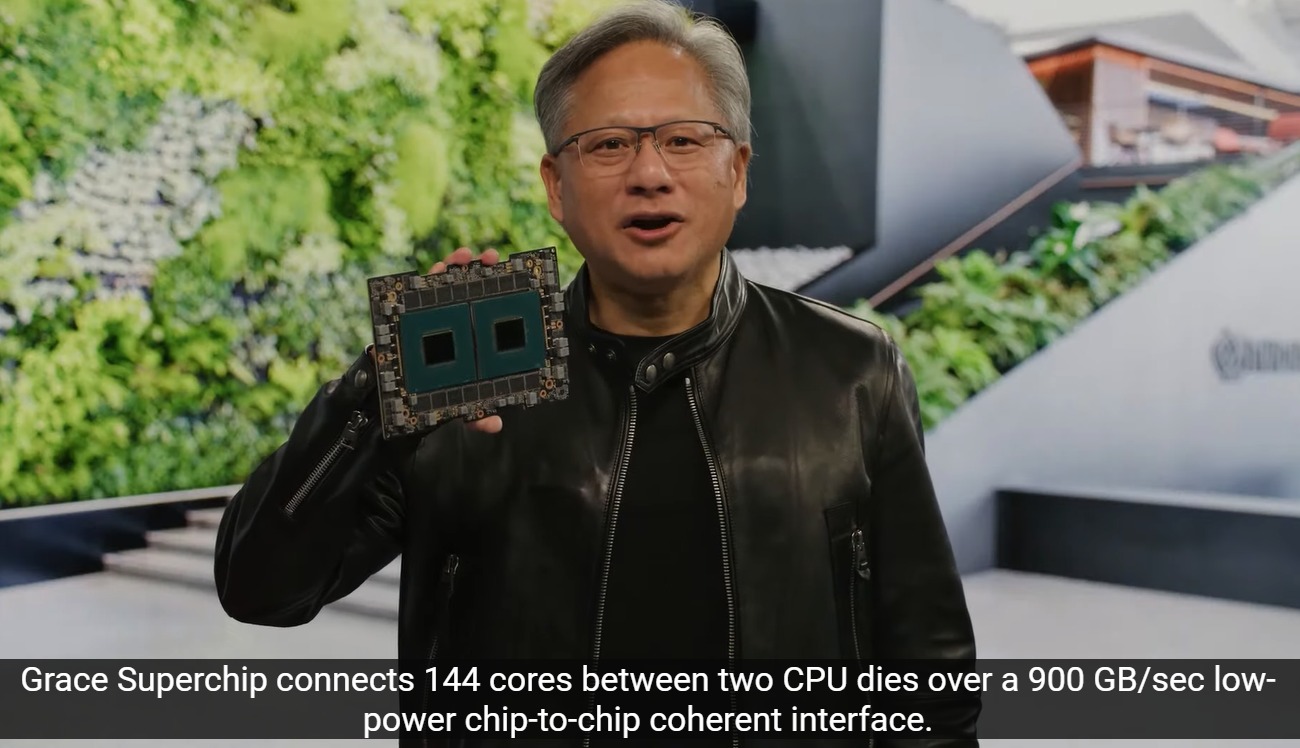

4) NVIDIA Grace Hopper pour les modèles de recommandation

Enfin, NVIDIA dispose également de la super puce Grace Hopper pour traiter des ensembles de données géants dans les bases de données d’IA et les modèles de recommandation de graphes, où le module est super rapide et bas-La latence NVLink-C2C puce à puce permet une bande passante d’interconnexion de plus de 900 Go/s entre la puce Grace basée sur ARM et le GPU Hopper. Cela permet à une requête géante d’être traitée sur le CPU, puis d’être immédiatement transférée vers le GPU Hopper pour un traitement d’inférence plus de sept fois plus rapide que PCI Express 5.0.