Cela semble avoir mis du temps à arriver ici, mais aujourd’hui, Intel lance officiellement sa gamme Xeon de 4e génération construite autour de la plate-forme Sapphire Rapids. Cette gamme comprend non seulement les SKU évolutifs typiques que nous avons vus des générations précédentes, mais également une toute nouvelle série”Max”, dont Intel a parlé pour la première fois il y a quelques mois.

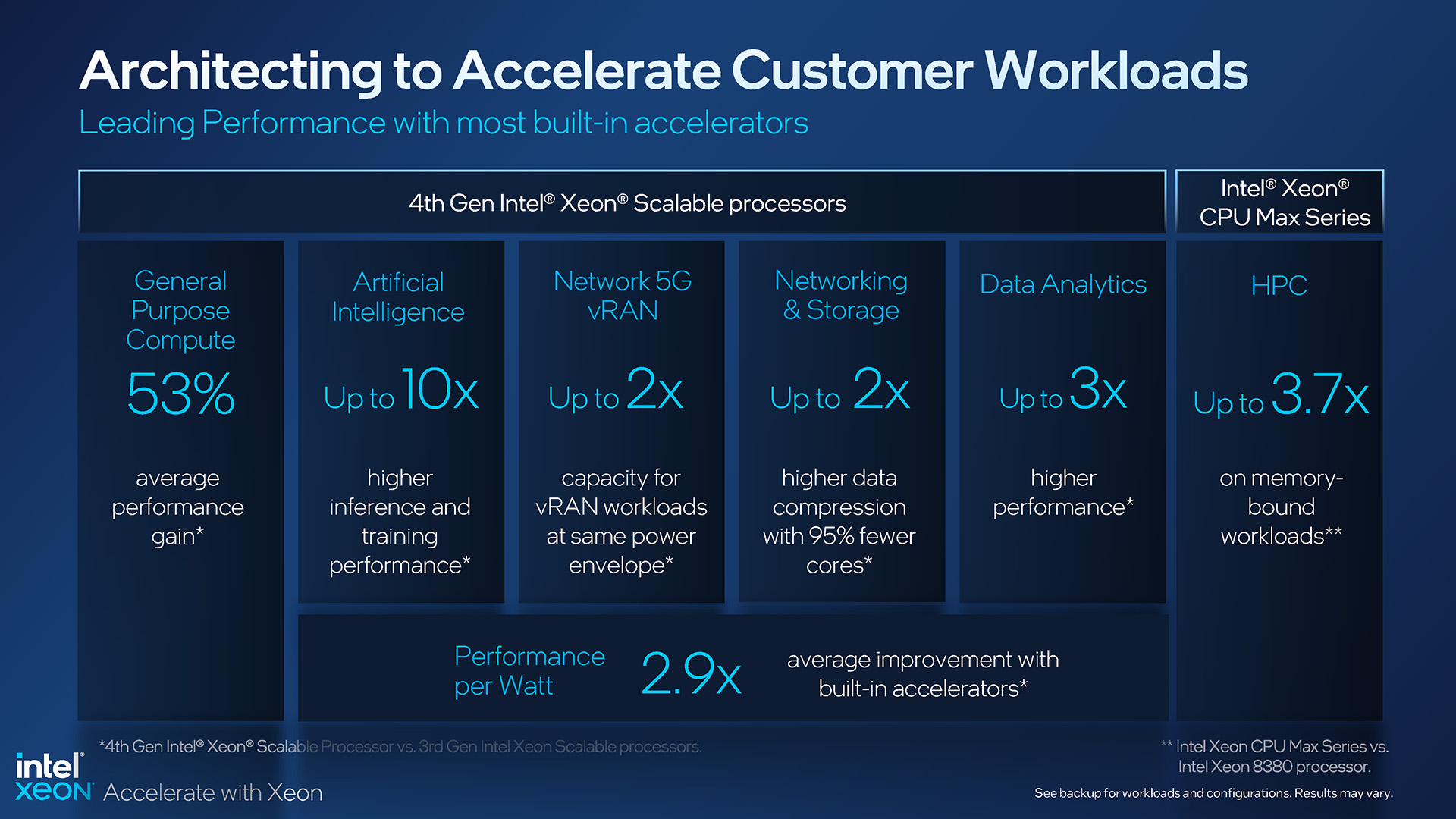

Avec Sapphire Rapids, Intel affirme que le dernier Xeon est le plus durable à ce jour et qu’il possède également les accélérateurs les plus intégrés de tous les processeurs de serveur à ce jour. Les deux parties sont crédibles, mais c’est la dernière qui signifie des affaires, car Intel a intégré de nombreuses qualités d’accélération dans ces processeurs, dont certains nécessiteront une mise à jour logicielle afin de tirer pleinement parti des gains potentiels.

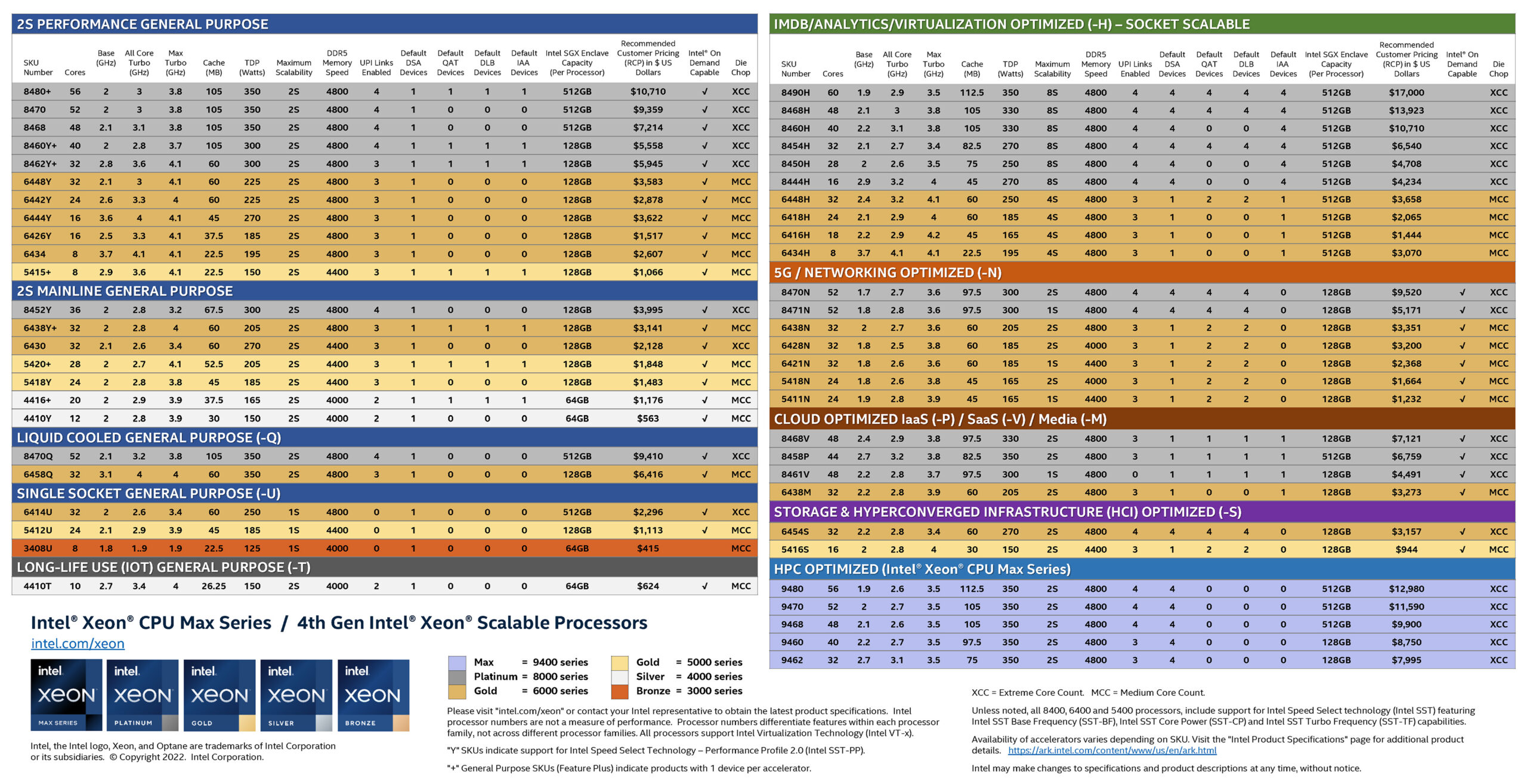

Le grand nombre de références de processeurs proposées par Intel atteint presque des niveaux d’humour similaires. C’est la même chose sur le bureau que sur le serveur. Qui n’aime pas cette fiche SKU de serveur colorée mise à jour ?

Gamme Intel Xeon Scalable et Xeon Max de 4e génération

Avec autant d’options Xeon, il est clair qu’Intel essaie de capturer autant de le marché des serveurs comme il peut avec ses dernières offres. Bien qu’il puisse y avoir des domaines dans lesquels des modèles supplémentaires pourraient se glisser, cela semble toujours être une liste exhaustive.

Bien qu’Intel propose des Xeons à de nombreuses fins différentes, aucun d’entre eux n’est développé sans une bonne raison. Vous pouvez regarder les deux options refroidies par liquide et vous demander qui les utilise réellement, mais Intel a déployé beaucoup d’efforts pour faire ressortir ces processeurs, en travaillant avec des partenaires de l’industrie pour développer de meilleures méthodes pour les puces de serveur à refroidissement liquide, et en faire autant performances optimales.

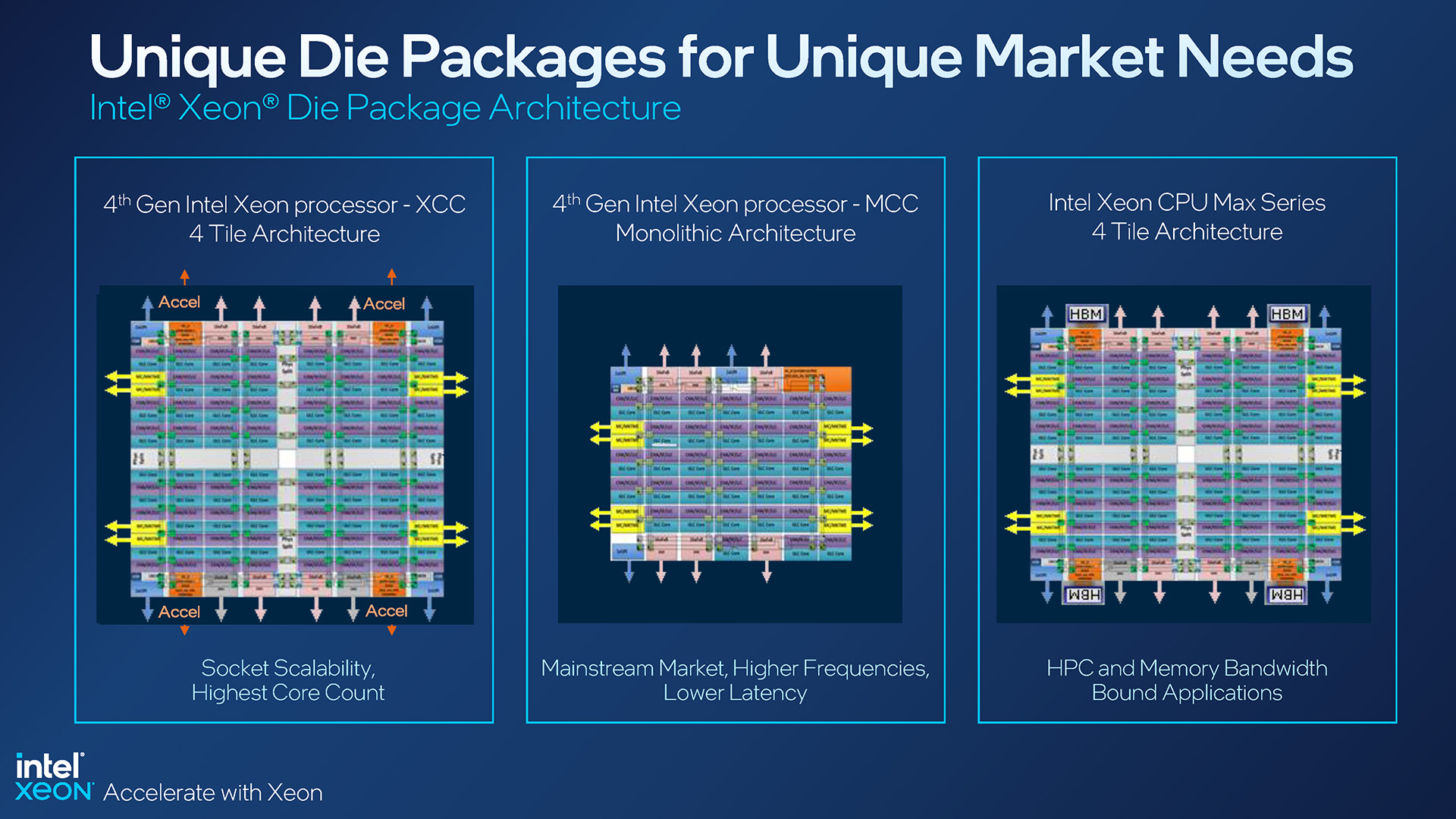

Nous avons vu des fiches SKU comme celle ci-dessus depuis le lancement original de Xeon Scalable, mais celle-ci contient de nombreux détails supplémentaires qui méritent d’être mentionnés. Pour commencer, la configuration de base sera répertoriée comme XCC ou MCC. XCC représente des processeurs avec plusieurs”tuiles”à l’intérieur, tandis que MCC est une conception monolithique plus traditionnelle :

Configurations du package Intel Xeon de 4e génération

Une conception XCC est ce qui aide Intel à atteindre un nombre de cœurs aussi élevé au haut de gamme, avec cette génération de Xeon culminant à 60 cœurs avec le 8490H. Les conceptions MCC de la génération actuelle maximisent 32 cœurs, comme avec le 6448H optimisé pour la virtualisation et le 6448Y axé sur les performances 2S.

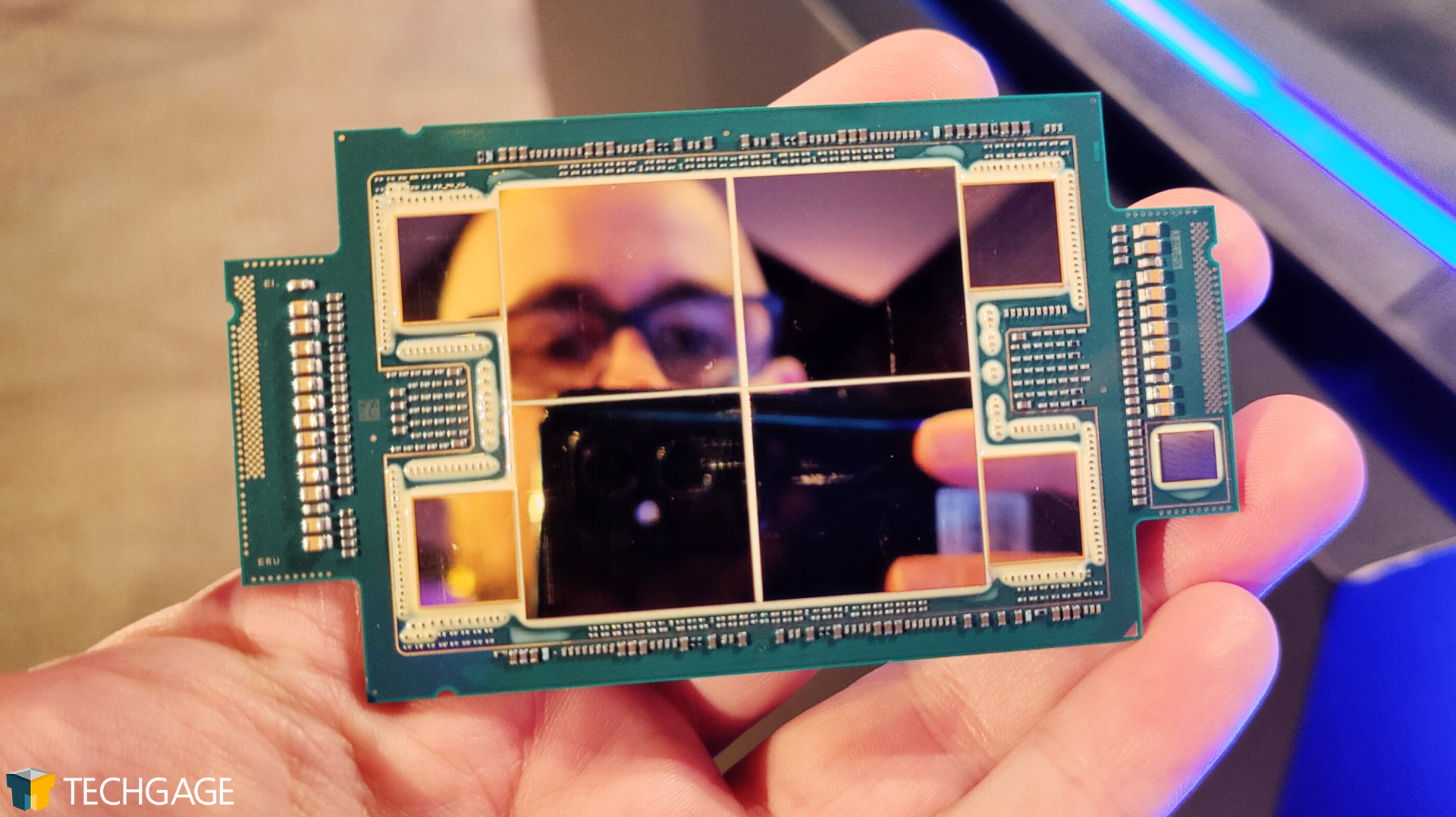

La série Xeon Max représente la troisième conception, celle qui est en fait la même que XCC , mais avec une mémoire HBM2e placée autour des matrices. Nous sommes allés”pratiquer”avec un processeur Max le mois dernier :

Le Xeon Max de 4e génération d’Intel est idéal pour prendre des selfies

Alors que les processeurs Xeon Max n’occupent que cinq places dans la gamme globale, ils sont sans doute les plus intéressant du groupe. Ces processeurs sont équipés de suffisamment de mémoire intégrée pour permettre à un serveur de fonctionner sans aucune mémoire supplémentaire. Imaginez cela-un serveur qui démarre, fonctionne, sans aucun emplacement de mémoire occupé. C’est délicieusement geek.

Les processeurs Xeon Max placent des puces HBM2e à côté de chaque tuile, offrant finalement une densité totale de 64 Go, jusqu’à 1,14 Go par cœur. Intel cible carrément ces SKU Max sur le marché HPC, et bien que de nombreuses charges de travail HPC nécessitent beaucoup de mémoire, il y en a encore beaucoup qui peuvent tenir facilement dans 64 Go. Bien sûr, vous pouvez construire sur ce HBM2e avec DDR5-4800 si la densité de 64 Go HBM2e n’est pas suffisante.

Voici un aperçu plus détaillé des spécifications indiquées pour chaque configuration de processeur :

Spécifications Intel Xeon de 4e génération basées sur le package

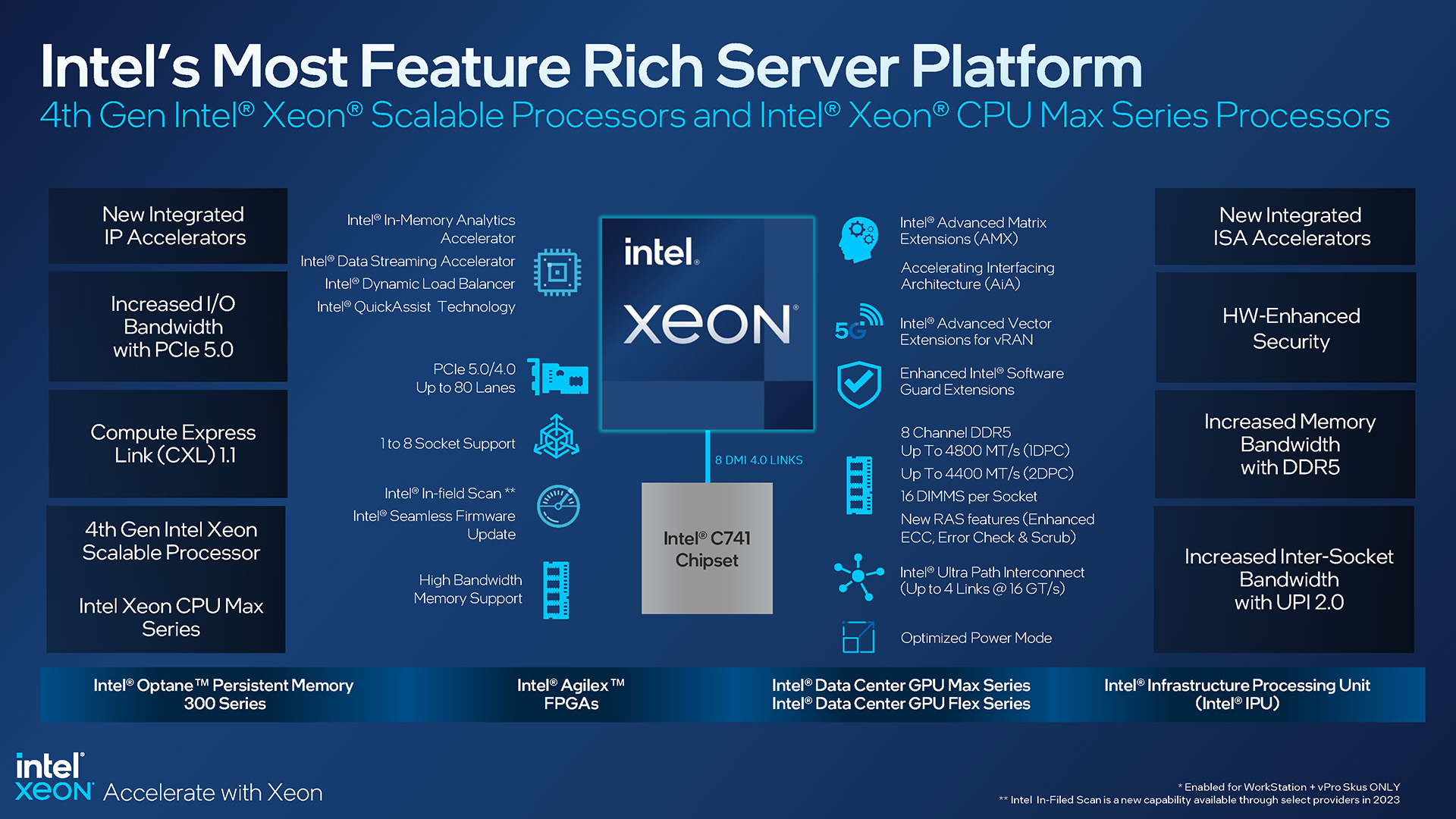

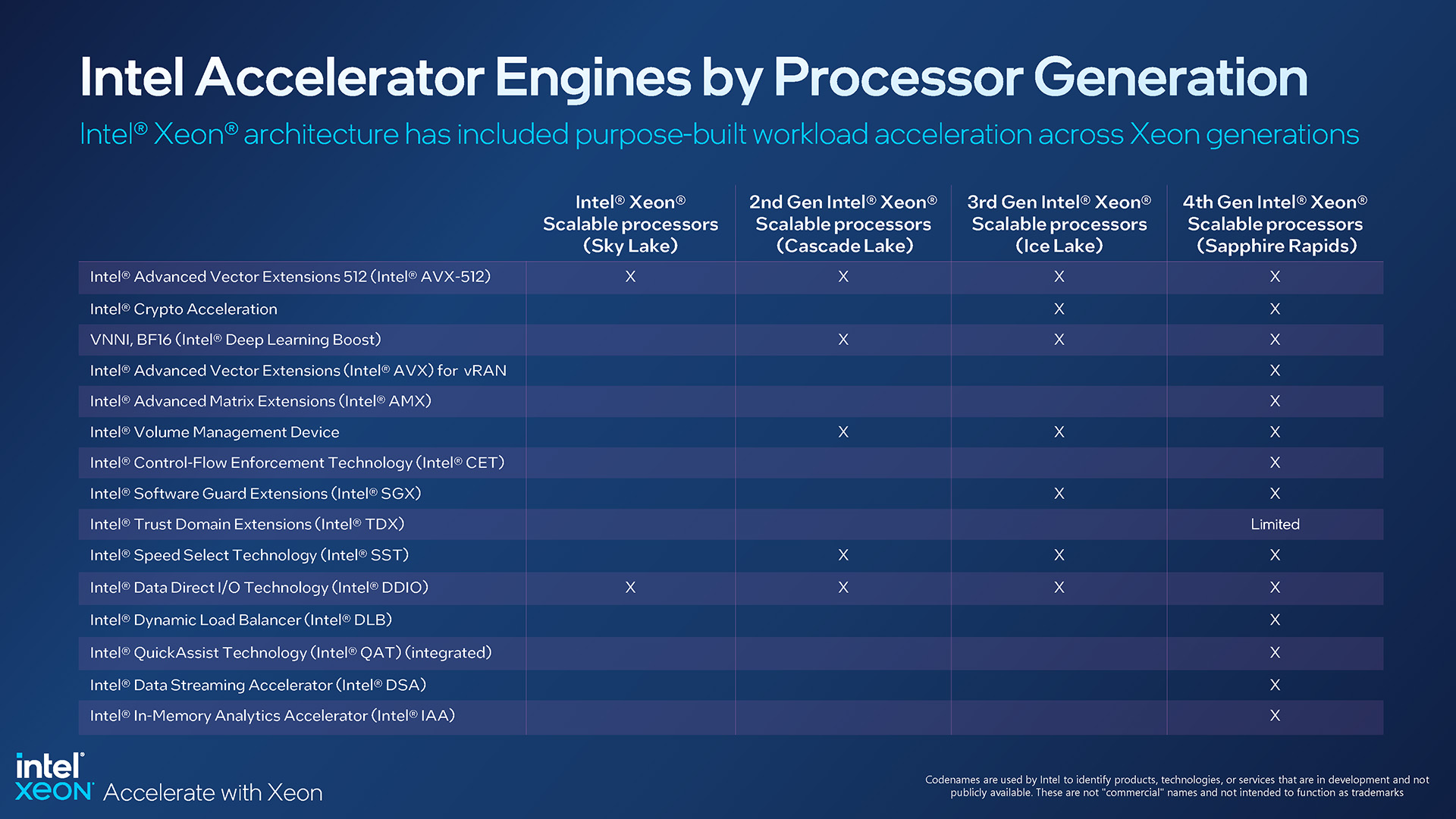

Cette diapositive ci-dessus permet de mettre en évidence un autre angle qui mérite d’être examiné. Sur les processeurs Max, de nombreuses fonctionnalités des autres SKU ont disparu, telles que la technologie Intel QuickAssist, Dynamic Load Balancer et In-Memory Analytics Accelerator. L’accélérateur de streaming de données reste, mettant en évidence un public cible axé sur le laser pour les processeurs Max.

Ces technologies non intégrées à Max nous amènent à une autre différence dans cette gamme Xeon de dernière génération. Vous avez peut-être remarqué une nouvelle entrée ci-dessus,”Intel On Demand Capable” ; cela fait référence aux processeurs qui pourraient être achetés sans toutes les fonctionnalités premium, mais les activer plus tard via les partenaires système et Intel lui-même.

Lors des briefings du mois dernier, le sujet de On Demand a semblé confondre beaucoup, et même aujourd’hui, nous ne comprenons pas complètement le mécanisme. On Demand ressemble à un DLC pour les processeurs de serveur, mais cela devrait permettre à certains d’acheter des processeurs à des prix plus équitables en raison des technologies non utilisées, et les clients auront toujours la possibilité de faire marche arrière plus tard.

Un autre angle pourrait être que certaines des technologies d’Intel pourraient ne pas être correctement exploitées dans un environnement de travail, mais si le support est construit, alors On Demand peut déverrouiller la fonctionnalité à partir d’un processeur. Pour autant que nous le comprenions, les processeurs Xeon dont les fonctionnalités sont verrouillées ne verront pas ces fonctionnalités contribuer à la charge électrique globale. Ils sont effectivement inactifs jusqu’à ce qu’ils soient déverrouillés et engagés.

Si vous vous référez à la fiche SKU partagée précédemment, vous remarquerez que ces fonctionnalités affectées à la demande peuvent varier considérablement en nombre d’appareils à travers le tableau. Les SKU optimisés pour le cloud, par exemple, ont peu d’appareils DSA, QAT, DLB et IAA, tandis que le 8490H haut de gamme en a beaucoup. En fonction de la charge de travail que vous recherchez, vous pouvez vous sentir coincé dans le modèle avec lequel vous optez finalement.

Voici un aperçu des fonctionnalités de Sapphire Rapids (ahem, Xeon de 4e génération), qui aide à couvrir les choses que nous Je n’ai pas encore :

Fonctionnalités de la plate-forme Intel Xeon de 4e génération

Cette plate-forme Xeon de dernière génération prend en charge PCIe 5.0 et 4.0, ainsi que DDR5 avec des fréquences allant jusqu’à 4800 MHz. Comme auparavant, cette plate-forme dispose d’un contrôleur de mémoire à 8 canaux et prend en charge jusqu’à 16 modules DIMM par socket.

Il convient de noter qu’Intel continue de prendre en charge ses systèmes à 4 et 8 sockets, ce qui est intéressant. compte tenu de son principal concurrent, AMD EPYC, culmine avec les configurations à 2 sockets. Intel affirme qu’il constate toujours une demande pour ces serveurs à plusieurs processeurs, en particulier pour le travail d’intelligence de base de données en mémoire, l’entreposage et la visualisation de données, la consolidation DC, etc.

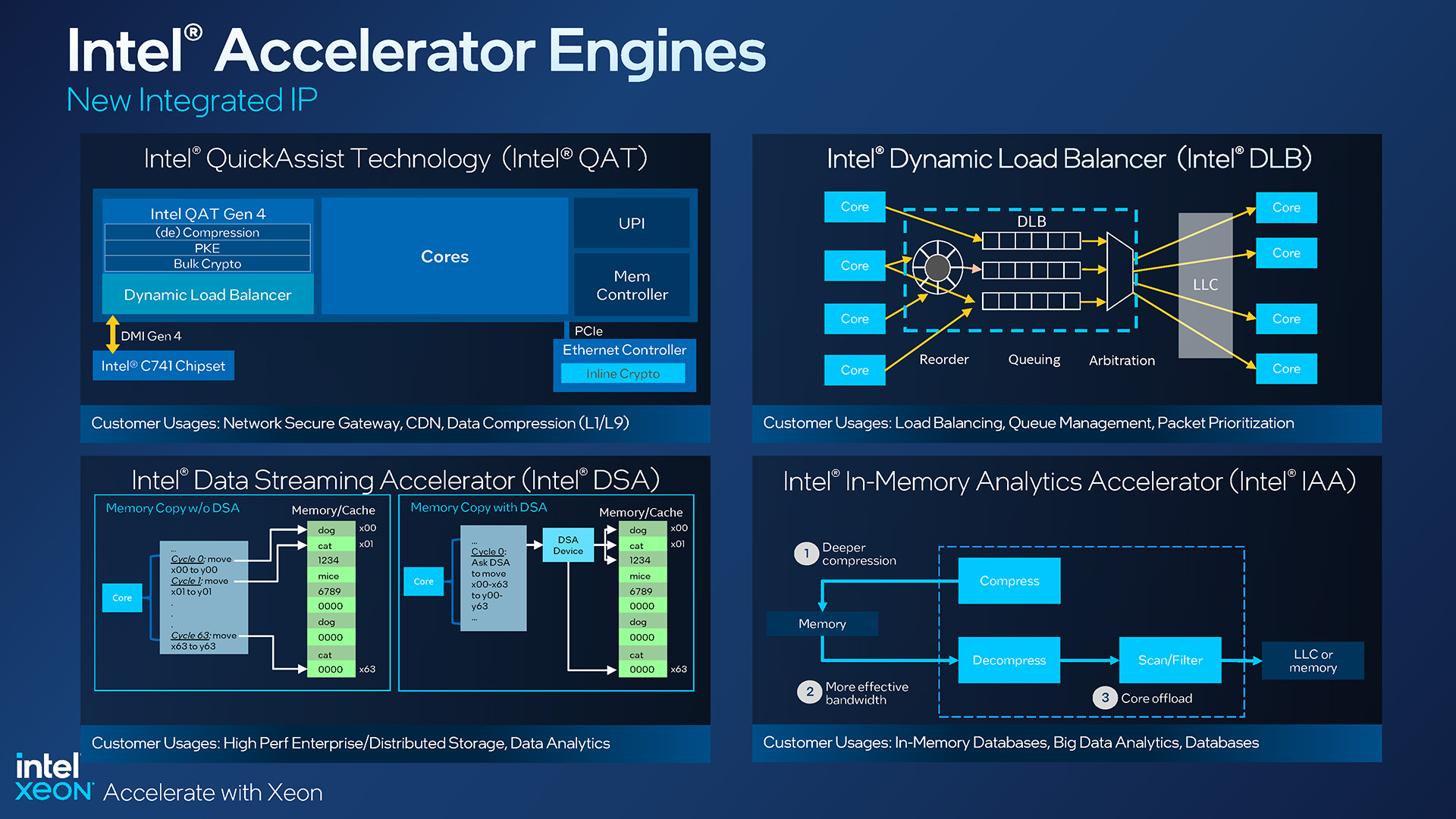

Les moteurs d’accélération Xeon de 4e génération d’Intel

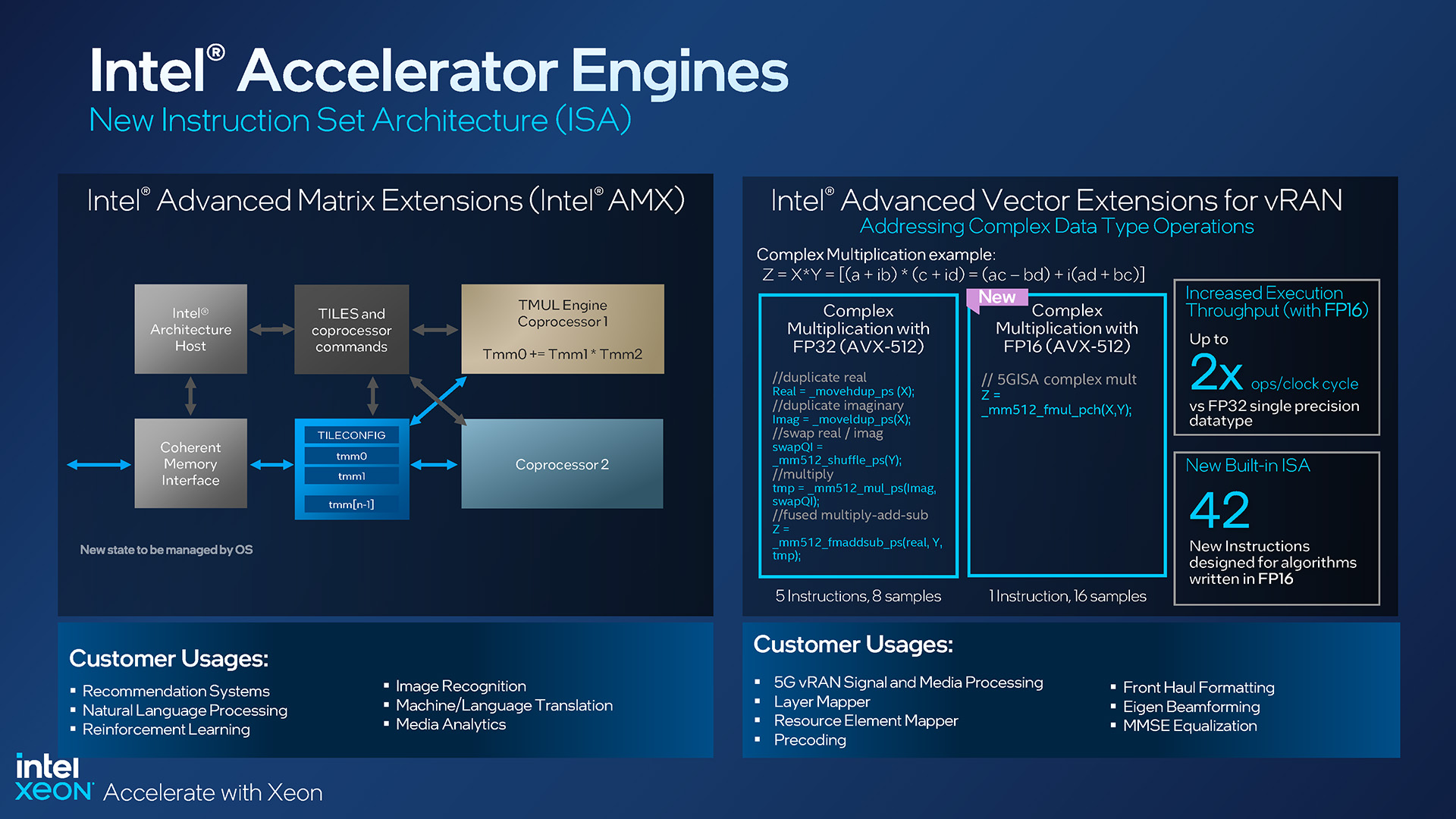

Au départ , nous avons mentionné que les processeurs Xeon de 4e génération incluent des accélérateurs qui peuvent (ou plus précisément, nécessiteront probablement) des mises à jour pour en tirer pleinement parti. Alors que de nombreux processeurs Xeon Scalable et Max de 4e génération offrent différents niveaux de prise en charge DSA/QAT/DLB/IAA, tous incluent le tout nouvel accélérateur matriciel AMX, le dernier venu de l’ISA (architecture de jeu d’instructions) d’Intel.

Intel aime l’IA, et en ce qui concerne les processeurs Xeon, cela fait un bon moment qu’on en parle. Mais à une époque où les GPU sont si rapides pour de nombreuses charges de travail d’IA, qu’est-ce qui pousse Intel à vouloir implémenter une solution comme AMX ici ? Pour commencer, où le processeur lui-même participe également fortement à une charge de travail d’IA, avoir AMX juste à côté des cœurs peut offrir d’excellentes performances-peut-être assez pour ne même pas avoir besoin de GPU discrets installés, en fonction de la charge de travail globale.

Intel affirme que son AMX est environ huit fois plus rapide pour calculer l’algèbre linéaire par rapport à son moteur vectoriel, et les clients cibles incluent les systèmes de recommandation d’exploitation, la reconnaissance d’images, le traitement du langage naturel, etc.

Extensions Xeon AMX et vRAN de 4e génération d’Intel

vRAN a également été infusé avec quelques mises à jour AVX, avec 42 nouvelles instructions ajoutées qui tirent parti des algorithmes écrits en FP16, avec des utilisations ciblant ici le traitement du signal et des médias, le formatage frontal et le mappage des couches.

L’accélération semble vraiment être le nom du jeu avec Sapphire Rapids. Plusieurs accélérateurs ont été implémentés pour réduire la charge sur le processeur lui-même, permettant finalement d’en faire plus dans le même laps de temps.

Moteurs d’accélération pour chaque génération Xeon Scalable

Heureusement, alors que certaines fonctionnalités d’accélération sont absentes dans certains SKU Xeon, AMX devient une norme de facto. C’est important, car nous savons que de nombreux éditeurs de logiciels devront mettre à jour leurs éléments afin d’en tirer pleinement parti.

Le support pour tout le monde peut ne pas venir aussi rapidement que nous le souhaiterions, mais Parce qu’AMX est un standard, cela signifie que les développeurs peuvent se sentir en sécurité en consacrant du temps à développer autour de lui. C’est plus difficile à vendre lorsqu’une nouvelle fonctionnalité intéressante a un support limité dans toute la gamme. Notamment, TensorFlow et PyTorch ont tous deux un support AMX intégré, donc nous semblons être sur la bonne voie.

De plus, tous ces moteurs d’accélérateur partagent un espace mémoire cohérent et partagé entre les cœurs et les accélérateurs , soulignant une fois de plus les efforts d’Intel pour fournir une architecture aussi efficace que possible, avec un minimum de goulots d’étranglement.

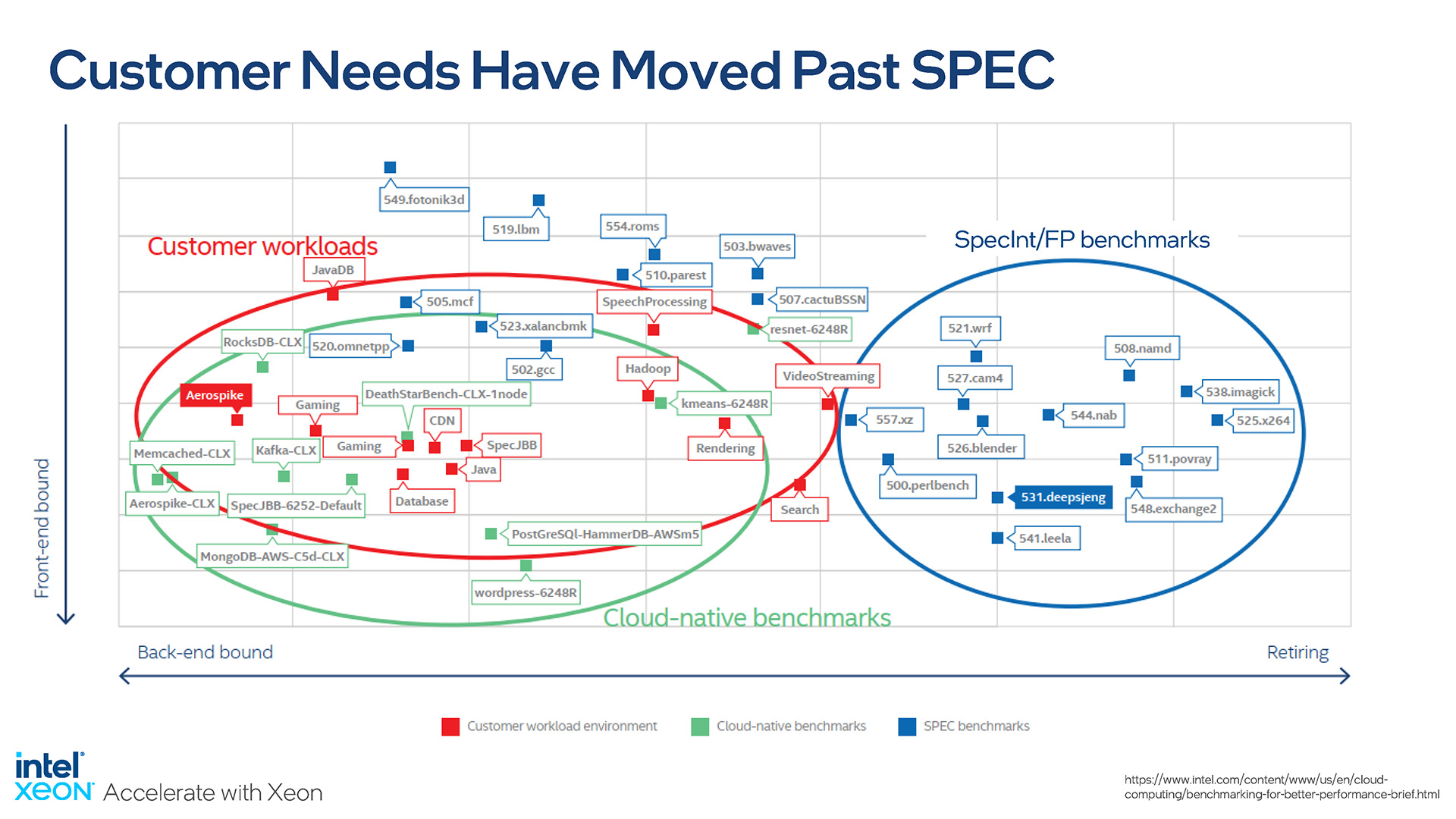

Parlant de performances, Intel Senior Fellow Ronak Singhal nous a vraiment parlé avec sa présentation, car il a souligné à quel point il est important pour comparer les processeurs avec des tests pertinents. Les benchmarks prédéfinis et pré-réglés ont leur raison d’être, mais en fin de compte, ce qui compte pour les clients, c’est la façon dont la nouvelle plate-forme affecte leur charge de travail spécifique.

Cette diapositive dit tout :

Intel souligne l’importance du monde réel tests de performance

SPEC est un consortium qui implique la plupart des plus grands acteurs du secteur des semi-conducteurs, de sorte que les références publiées ont tendance à être acceptées par tout le monde ; il n’y aura pas de biais inhérent dans les tests. Mais ces tests sont rigides et leurs résultats ne refléteront pas la plupart des charges de travail. Intel lui-même a travaillé avec des clients pour évaluer à quel point la plupart des benchmarks étaient déconnectés des scénarios pratiques, et ainsi souligner la nécessité de tester avec des benchmarks pertinents.

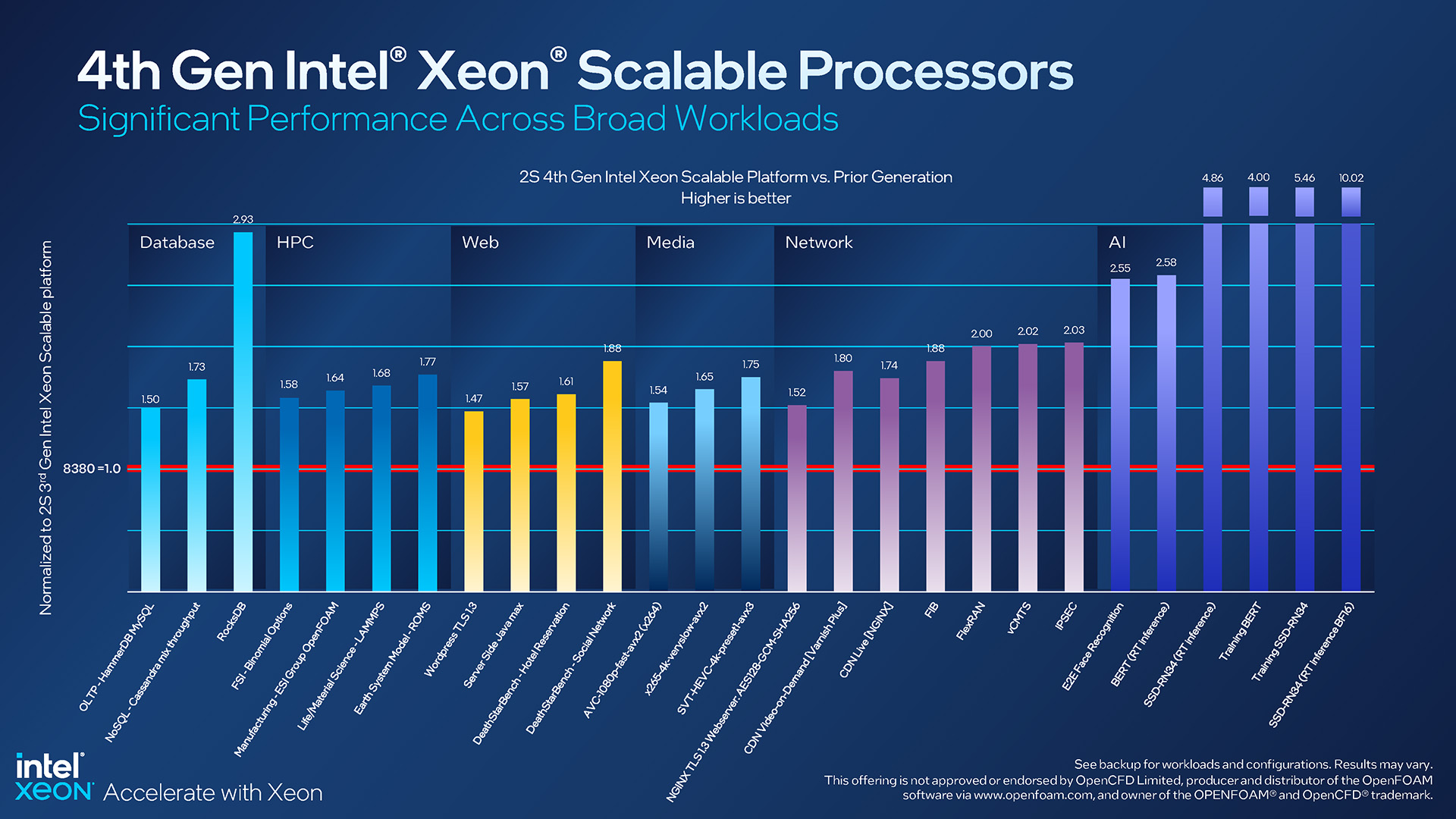

À cette fin, dans des tests plus réels, Sapphire Rapids effectue bien par rapport au Xeon 8380 haut de gamme de la génération précédente :

Attentes en matière de performances d’Intel Xeon de 4e génération

Les améliorations de performances observées à tous les niveaux sont excellentes à voir, mais bien sûr, certains de ces résultats se démarquent plus que les autres. Celui de RocksDB en particulier est intéressant, car il met en évidence les avantages de l’accélérateur d’analyse en mémoire mis à jour d’Intel. Mais même les gains modestes restent impressionnants, comme avec une amélioration d’environ 50 % des performances de WordPress lors de l’utilisation de TLS.

Nous ne pouvons pas en trouver une mention explicite, mais nous devons imaginer toutes les charges de travail de l’IA sur le côté droit de cette diapositive ont vu de tels boosts gigantesques grâce à l’introduction de l’AMX. Alors que les quatre dernières barres montent toutes vers le haut, le résultat de l’inférence en temps réel BF16, à environ 10x, se démarque vraiment.

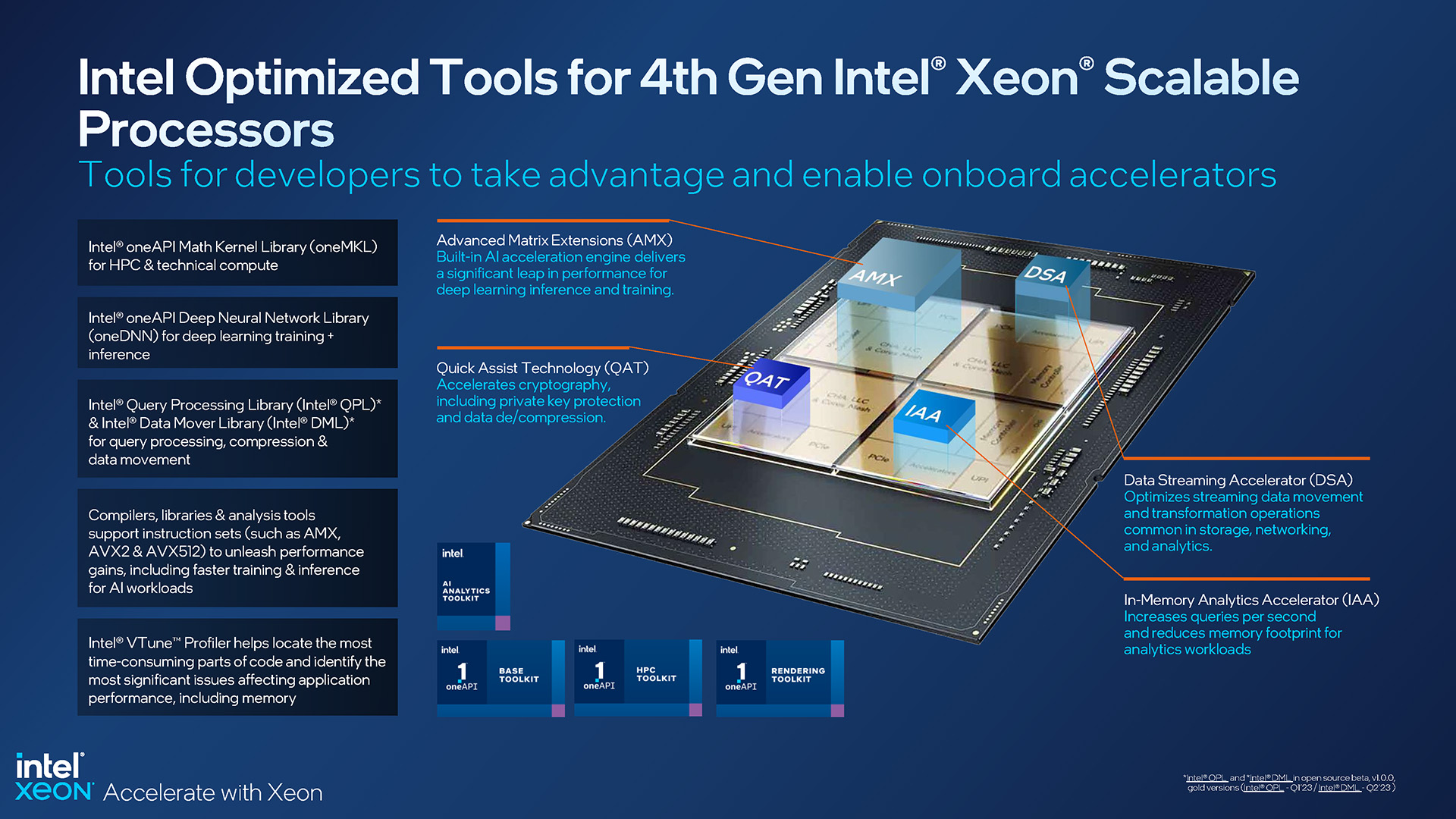

Des outils optimisés permettent de tirer le meilleur parti des processeurs Intel Xeon Scalable et Max de 4e génération

Parce que Les processeurs d’Intel ont tellement de matériel unique que la société se donne beaucoup de mal pour s’assurer que chacun dispose des bons outils et des bonnes informations pour le travail. OneAPI d’Intel est continuellement mis à jour, tout comme de nombreux autres outils, comme oneDNN, QPL et DML. La documentation est également souvent mise à jour.

De même, Intel sait également que pour que les clients tirent le meilleur parti de ses fonctionnalités d’IA, des exemples doivent être fournis. C’est pourquoi l’entreprise propose des dizaines de modèles d’IA pré-formés, que les gens peuvent intégrer directement dans leurs projets ou apprendre.

Au cours d’une présentation, Intel a noté que seuls 53 % des projets d’IA sont rejetés. off et finissent par voir l’achèvement, ce qui est un taux d’échec assez massif. Avec des solutions comme oneAPI, qui peuvent tirer la puissance de traitement du processeur ou des accélérateurs intégrés, l’objectif est de s’assurer que les utilisateurs peuvent effectuer leurs calculs de la manière la plus efficace possible. Avec le temps, nous espérons voir ce nombre augmenter de 53 %.

Réflexions finales

Intel a divulgué de nombreuses informations sur sa gamme Xeon Scalable et Max de 4e génération, et finalement, nous Je viens de gratter la surface ici, malgré tant de bonnes informations discutées. En s’éloignant des briefings en personne le mois dernier, il est devenu clair que ce lancement est cher au cœur d’Intel, et c’est pour une bonne raison. Il y a beaucoup de choses nouvelles et intrigantes ici.

Comme toujours, Intel offre de nombreuses options-quel que soit votre cas d’utilisation, vous trouverez forcément un processeur adapté à vos besoins. En bas, il y a un 3408U à 8 cœurs pour une utilisation générale dans une plate-forme à 1 socket, et en haut se trouve le géant 8490H à 60 cœurs qui peut être utilisé dans des systèmes à 8 sockets.

Avantages de performances pour les Sapphire Rapids d’Intel par rapport à la génération précédente

Certes, c’est la série Xeon Max qui nous intrigue le plus. Avoir 64 Go de mémoire ultra-rapide intégrée directement dans le processeur pourrait être une aubaine pour certaines charges de travail, et en particulier les scénarios où beaucoup de mémoire n’est tout simplement pas nécessaire. Le fait qu’un serveur Xeon Max puisse démarrer et fonctionner normalement sans qu’un seul module DIMM soit installé n’est pas seulement impressionnant, mais utile.

La façon dont Sapphire Rapids se compare finalement à la concurrence nécessitera une analyse comparative exhaustive des autres à comprendre, et nous sommes sûrs que de nombreuses performances sont à venir. Cela dit, nous ne sommes pas tout à fait sûrs que les performances de lancement brosseront le tableau le plus précis, car certaines caractéristiques de conception de Sapphire Rapids nécessiteront des mises à jour logicielles. Nous avons déjà discuté du fait que PyTorch et TensorFlow prennent en charge AMX de manière standard, mais il existe beaucoup plus de logiciels ciblés sur l’IA.

En fin de compte, nous sommes simplement ravis de voir le lancement de Sapphire Rapids , car cela a mis longtemps à venir, et nous sommes également ravis qu’il y ait eu autant d’intérêt à en parler. Comme pour tout ce qui concerne les serveurs, le flux de nouveaux produits dans l’écosystème sera lent, il sera donc intéressant de voir où en sont les choses à mi-parcours et plus tard dans l’année.

Soutenez nos efforts ! Les revenus publicitaires étant au plus bas pour les sites Web écrits, nous comptons plus que jamais sur l’assistance des lecteurs pour nous aider à continuer à consacrer autant d’efforts à ce type de contenu. Vous pouvez nous soutenir en devenant mécène ou en utilisant nos liens d’affiliation d’achat Amazon répertoriés dans nos articles. Merci pour votre soutien !