Es schien seine gute alte Zeit gedauert zu haben, aber heute bringt Intel offiziell seine Xeon-Reihe der 4. Generation auf den Markt, die auf der Sapphire Rapids-Plattform basiert. Diese Aufstellung umfasst nicht nur die typischen Scalable-SKUs, die wir von den vorherigen Generationen kennen, sondern auch eine brandneue „Max“-Serie, über die Intel vor einigen Monaten erstmals sprach.

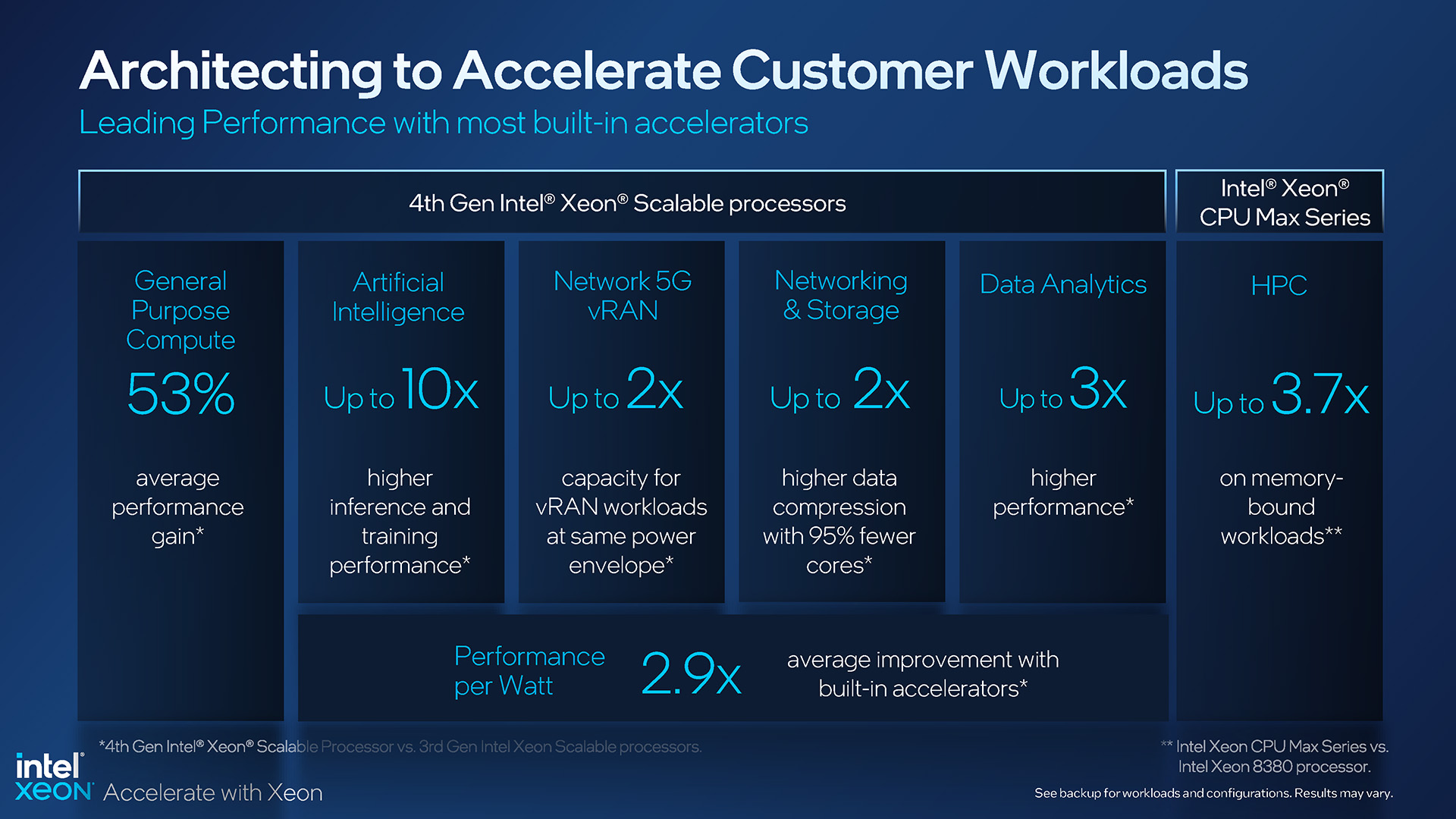

Mit Sapphire Rapids, Intel sagt, dass der neueste Xeon der bisher nachhaltigste ist und dass er auch die meisten integrierten Beschleuniger aller bisherigen Serverprozessoren hat. Beide Teile sind glaubwürdig, aber letzteres ist wichtig, denn Intel hat viel Beschleunigungsleistung in diese CPUs gepackt, von denen einige Software-Updates erfordern, um die potenziellen Vorteile voll auszuschöpfen.

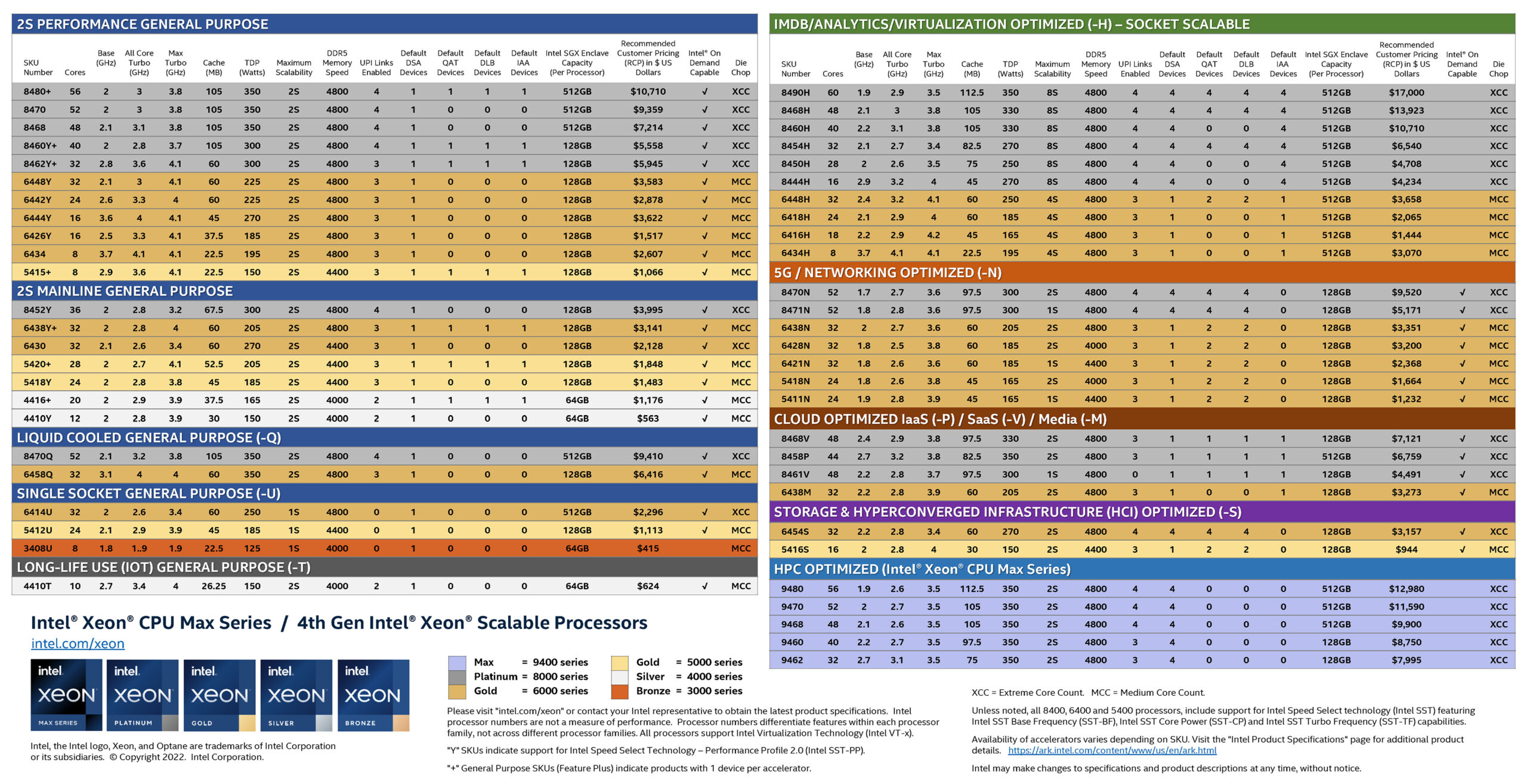

Die schiere Anzahl der Prozessor-SKUs, die Intel anbietet, erreicht fast Humor-Ebenen. Auf dem Desktop ist es dasselbe wie auf dem Server. Wer liebt dieses aktualisierte farbenfrohe Server-SKU-Blatt nicht?

Intels Xeon Scalable-und Xeon Max-Produktreihe der 4. Generation

Bei so vielen Xeon-Optionen ist es klar, dass Intel versucht, möglichst viele davon zu erfassen den Servermarkt mit seinen neuesten Angeboten so gut wie möglich. Obwohl es einige Bereiche geben könnte, in die zusätzliche Modelle hineinrutschen könnten, fühlt sich dies immer noch wie eine erschöpfende Liste an.

Während Intel Xeons für viele verschiedene Zwecke anbietet, wird keiner von ihnen ohne guten Grund entwickelt. Sie können sich die beiden flüssigkeitsgekühlten Optionen ansehen und sich fragen, wer sie tatsächlich verwendet, aber Intel hat viel Mühe darauf verwendet, diese CPUs hervorzuheben, indem es mit Industriepartnern zusammenarbeitet, um bessere Methoden für flüssigkeitsgekühlte Serverchips zu entwickeln, und das auch Leistung so gut wie möglich aus ihnen herauszuholen.

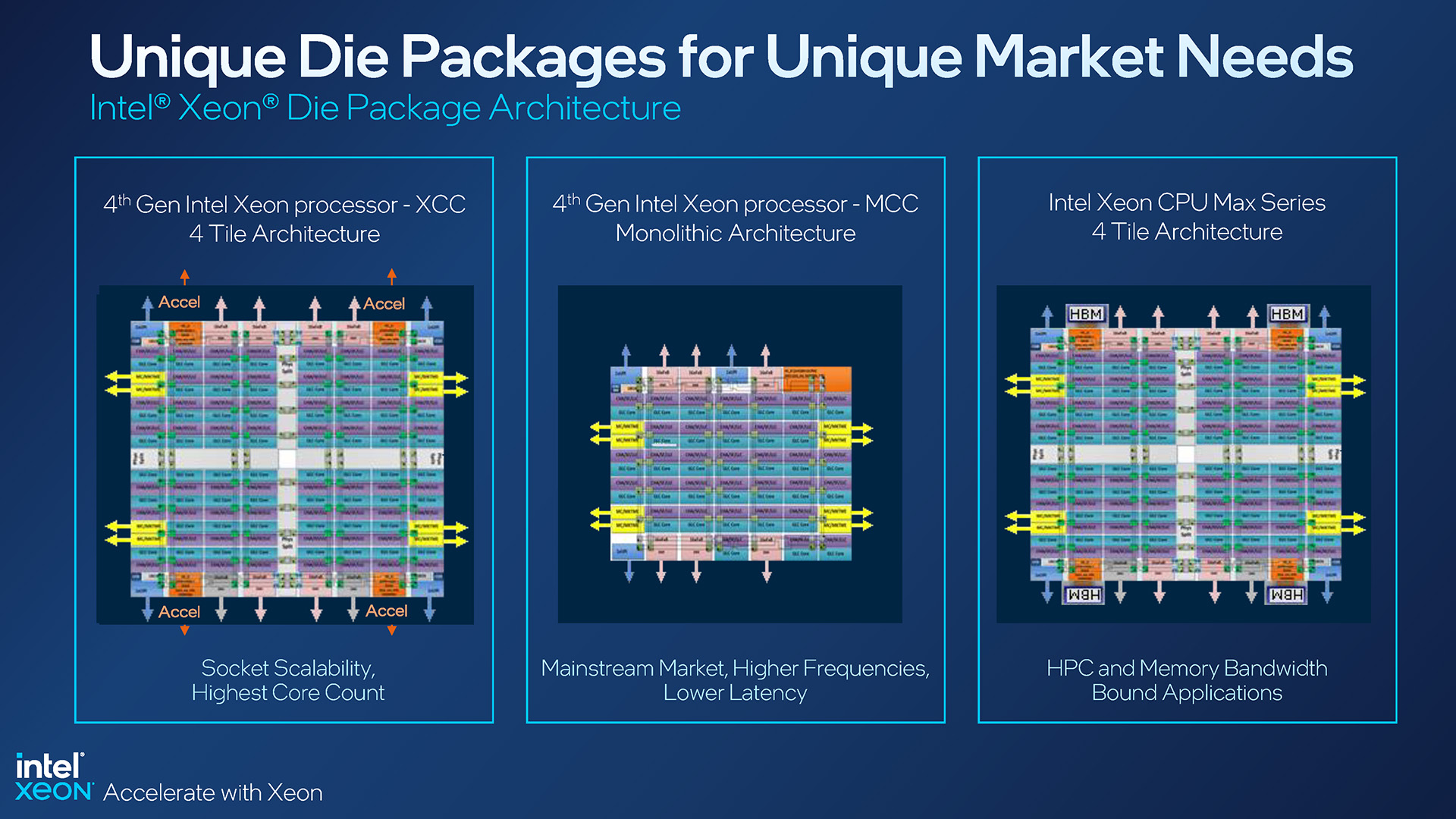

Wir haben SKU-Blätter wie das obige seit der ursprünglichen Einführung von Xeon Scalable gesehen, aber dieses hat viele zusätzliche Details, die es wert sind, erwähnt zu werden. Zu Beginn wird die Kernkonfiguration entweder als XCC oder MCC aufgeführt. XCC steht für CPUs mit mehreren „Kacheln“ im Inneren, während MCC ein monolithisches, traditionelleres Design ist:

Intel Xeon-Paketkonfigurationen der 4. Generation

Ein XCC-Design hilft Intel dabei, eine so hohe Anzahl an Kernen zu erreichen Spitzenklasse, wobei diese Xeon-Generation mit dem 8490H mit 60 Kernen ihren Höhepunkt erreicht. Die MCC-Designs der aktuellen Generation erreichen maximal 32 Kerne, wie z. B. der für Virtualisierung optimierte 6448H und der 2S-leistungsgebundene 6448Y.

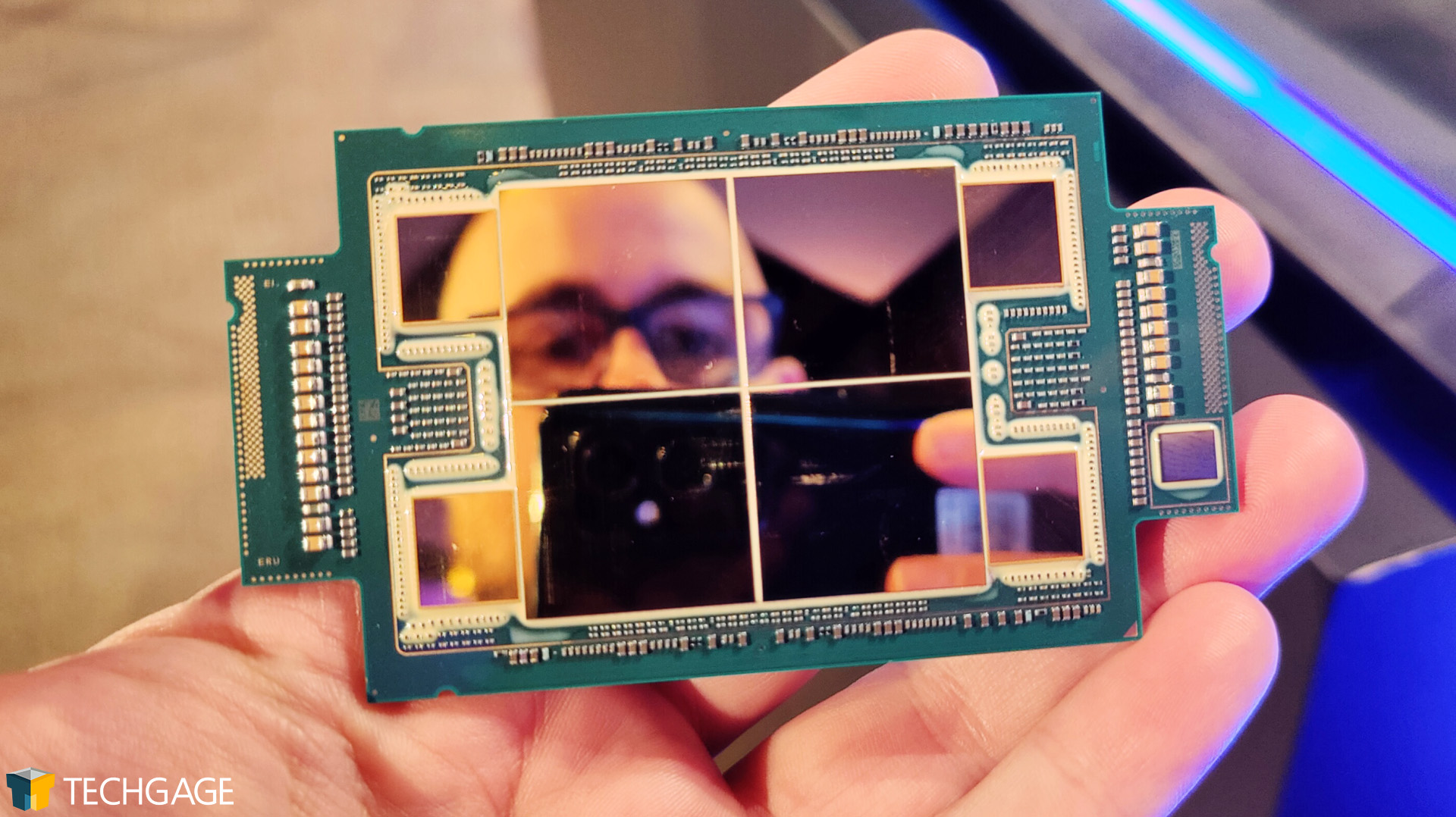

Die Xeon Max-Serie stellt das dritte Design dar, eines, das effektiv mit XCC identisch ist , aber mit HBM2e-Speicher, der um die Chips herum angeordnet ist. Wir haben letzten Monat mit einer Max-CPU „praktisch“ gearbeitet:

Intels Xeon Max der 4. Generation eignet sich hervorragend für Selfies

Während Xeon Max-CPUs nur fünf Plätze in der Gesamtaufstellung einnehmen, sind sie wohl die meisten interessant von der Menge. Diese CPUs sind mit genügend integriertem Speicher ausgestattet, damit ein Server ohne zusätzlichen Speicher ausgeführt werden kann. Stellen Sie sich das vor – ein Server, der hochfährt, in Betrieb ist und absolut keinen der Speichersteckplätze belegt. Das ist köstlich geeky.

Xeon Max-CPUs platzieren HBM2e-Chips neben jeder Kachel und liefern letztendlich eine Gesamtdichte von 64 GB, bis zu 1,14 GB pro Kern. Intel zielt mit diesen Max-SKUs direkt auf den HPC-Markt ab, und obwohl viele HPC-Workloads viel Arbeitsspeicher benötigen, gibt es immer noch viele, die problemlos in 64 GB passen. Natürlich können Sie auf dieser HBM2e mit DDR5-4800 aufbauen, falls die 64-GB-HBM2e-Dichte nicht ausreichen sollte.

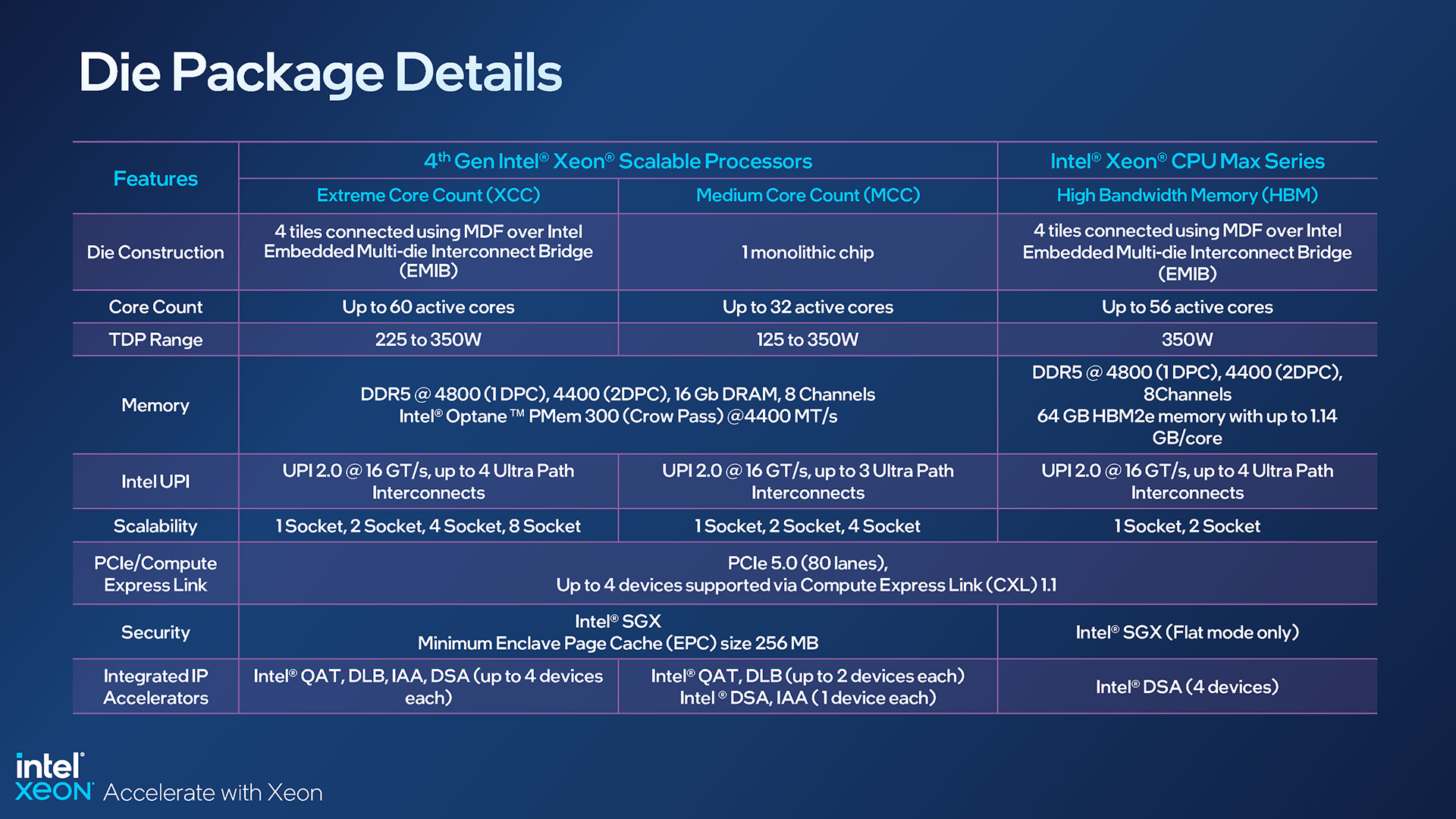

Hier ist ein detaillierterer Blick auf die angegebenen Spezifikationen für jede CPU-Konfiguration:

Intel Xeon-Spezifikationen der 4. Generation basierend auf dem Paket

Diese Folie oben hilft, einen weiteren Blickwinkel hervorzuheben, der einen Blick wert ist. Auf Max-CPUs sind viele der Funktionen der anderen SKUs weg, wie Intels QuickAssist-Technologie, Dynamic Load Balancer und In-Memory Analytics Accelerator. Der Data Streaming Accelerator bleibt erhalten und hebt eine laserfokussierte Zielgruppe für Max-CPUs hervor.

Diese nicht in Max integrierten Technologien führen uns zu einem weiteren Unterschied in dieser Xeon-Reihe der neuesten Generation. Möglicherweise ist Ihnen oben ein neuer Eintrag aufgefallen: „Intel On Demand Capable“; dies bezieht sich auf CPUs, die ohne jedes Premium-Feature gekauft werden konnten, aber später über Systempartner und Intel selbst aktiviert werden konnten.

Während der Briefings im letzten Monat schien das Thema On Demand viele zu verwirren, und sogar Heute verstehen wir die Mechanik nicht vollständig. On Demand klingt wie ein DLC für Server-CPUs, aber es sollte einigen ermöglichen, CPUs aufgrund nicht verwendeter Technologien zu faireren Preisen zu kaufen, und Kunden haben später immer noch die Möglichkeit, den Kurs umzukehren.

Ein anderer Aspekt könnte sein kann sein, dass einige der Technologien von Intel in einer Arbeitsumgebung möglicherweise nicht richtig genutzt werden, aber wenn Unterstützung vorhanden ist, kann On Demand die Funktion von einer CPU freischalten. Soweit wir es verstehen, tragen Xeon-CPUs mit gesperrten Funktionen nicht zur Gesamtstromlast bei. Sie sind praktisch inaktiv, bis sie entsperrt und aktiviert werden.

Wenn Sie sich das zuvor freigegebene SKU-Blatt ansehen, werden Sie feststellen, dass diese von On Demand betroffenen Funktionen in der Anzahl der Geräte stark variieren können Die Tafel. Cloud-optimierte SKUs haben zum Beispiel nur wenige DSA-, QAT-, DLB-und IAA-Geräte, während das Top-End 8490H viele hat. Abhängig von der Arbeitsbelastung, die Sie anstreben, fühlen Sie sich vielleicht in das Modell gedrängt, für das Sie sich letztendlich entscheiden.

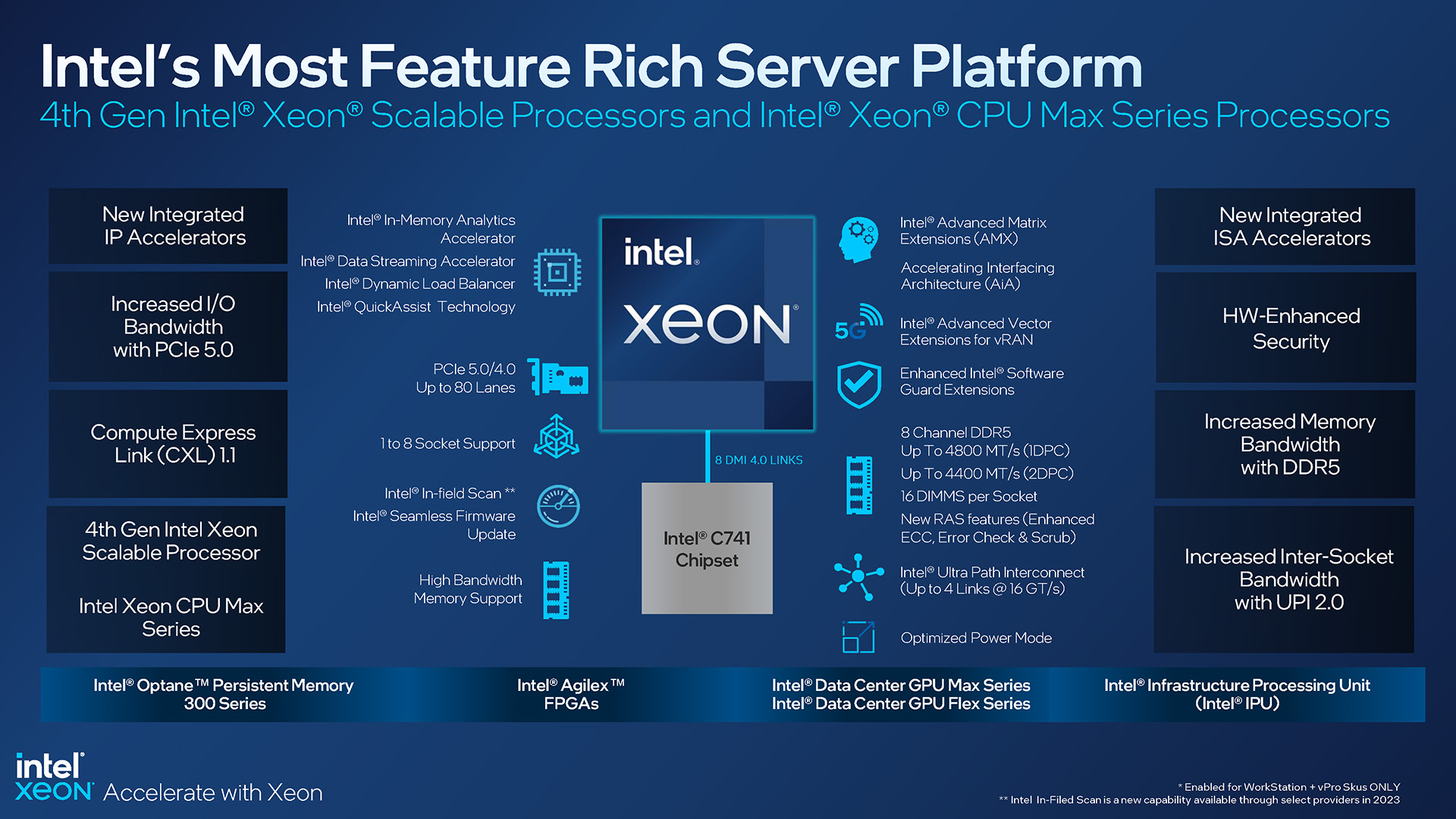

Hier ist eine Übersicht über die Funktionen von Sapphire Rapids (ähm, Xeon der 4. Generation), die uns dabei hilft, unsere Dinge abzudecken muss noch:

Funktionen der Intel Xeon-Plattform der 4. Generation

Diese Xeon-Plattform der neuesten Generation unterstützt sowohl PCIe 5.0 und 4.0 als auch DDR5 mit Frequenzen von bis zu 4800 MHz. Wie zuvor verfügt diese Plattform über einen 8-Kanal-Speichercontroller und unterstützt letztendlich bis zu 16 DIMMs pro Sockel.

Es ist erwähnenswert, dass Intel weiterhin seine 4-und 8-Sockel-Systeme unterstützt, was interessant ist In Anbetracht seines Hauptkonkurrenten AMD EPYC erreicht es Spitzenwerte mit 2-Sockel-Konfigurationen. Intel sagt, dass es immer noch Bedarf für diese Server mit vielen CPUs sieht, insbesondere für In-Memory-Datenbankintelligenzarbeit, Data Warehousing und Visualisierung, DC-Konsolidierung und so weiter.

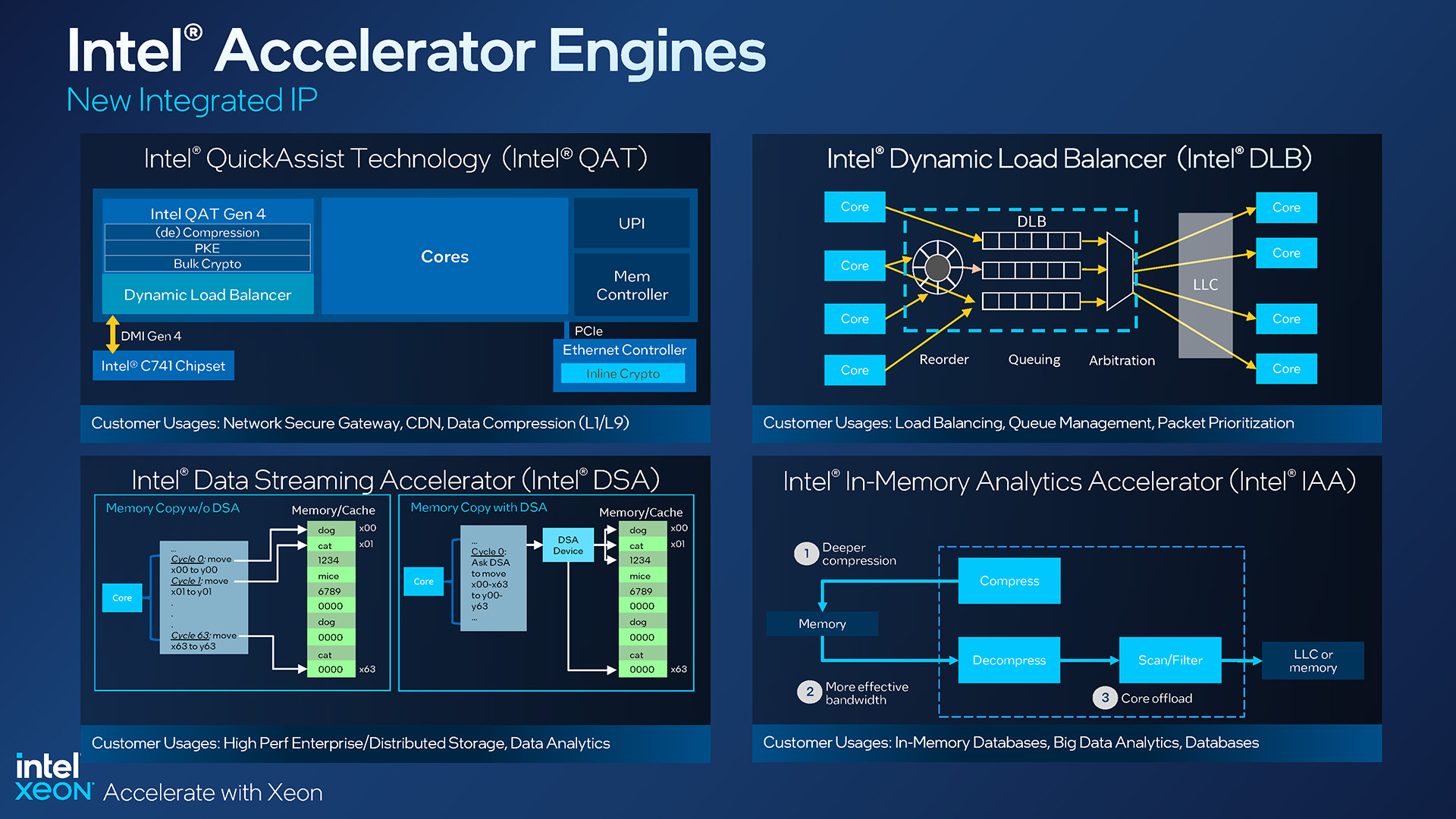

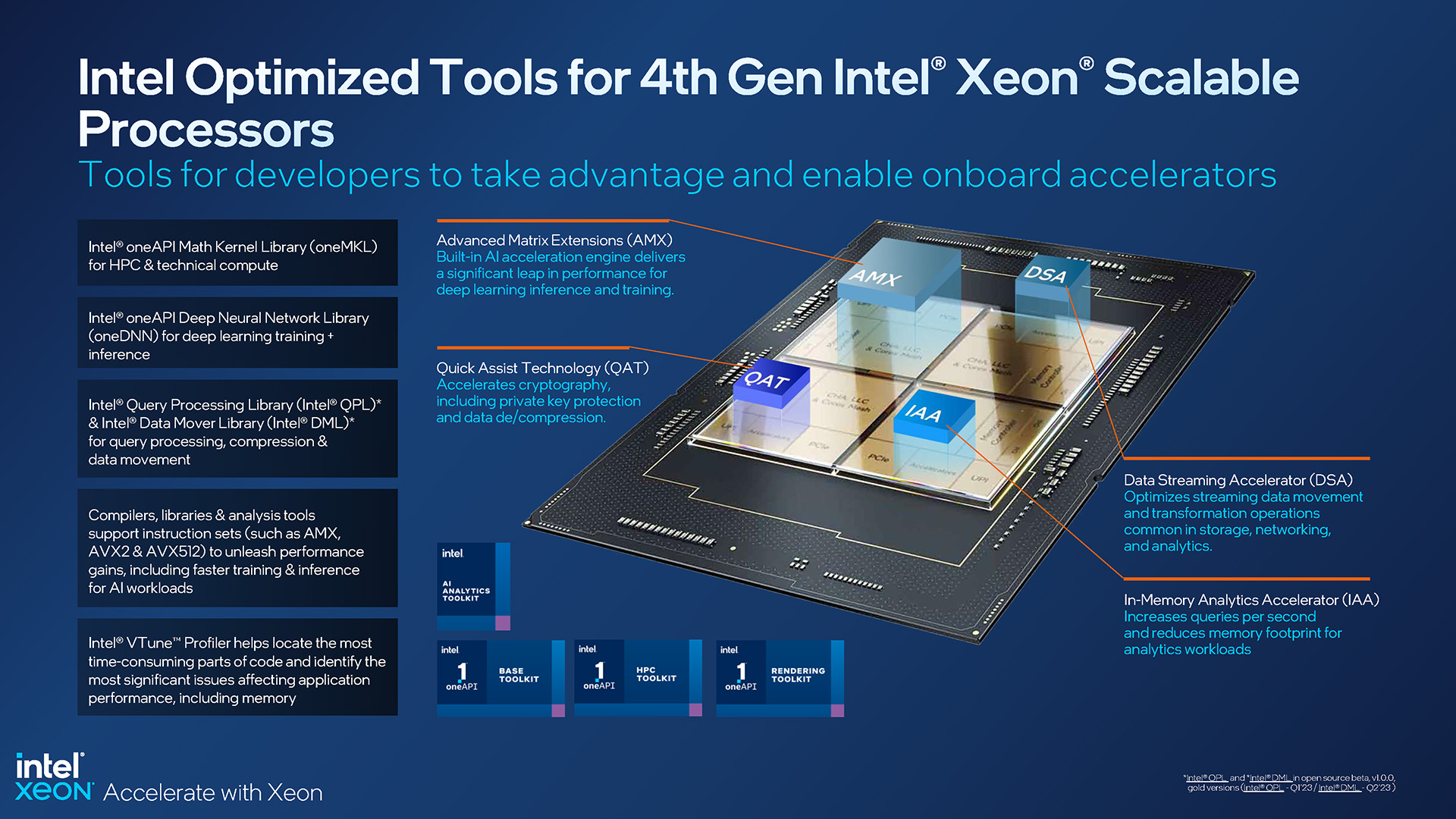

Die Xeon-Beschleuniger-Engines der 4. Generation von Intel

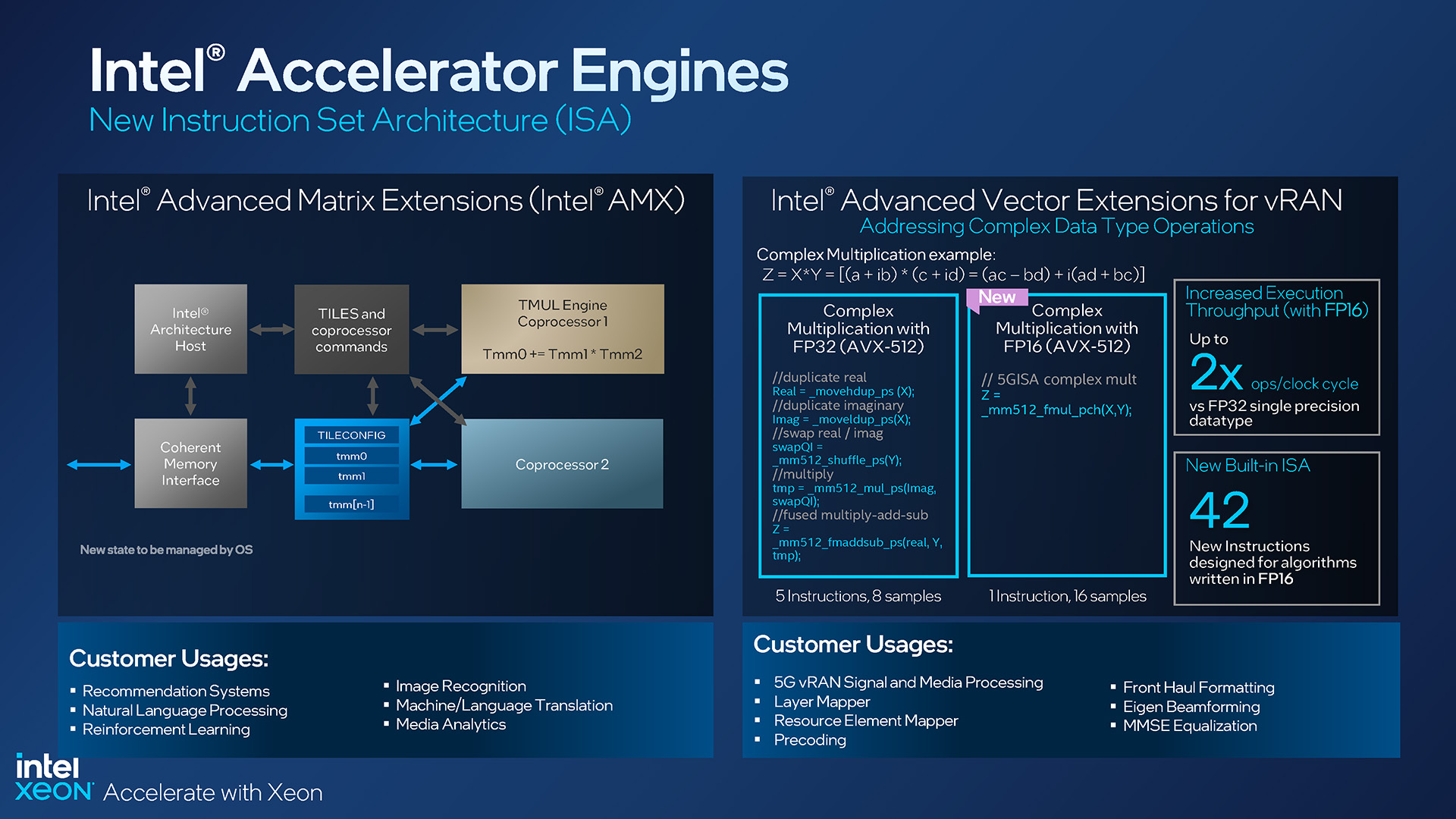

Zu Beginn , haben wir erwähnt, dass die Xeon-Prozessoren der 4. Generation Beschleuniger enthalten, die möglicherweise (oder genauer gesagt wahrscheinlich) aktualisiert werden müssen, um sie voll auszunutzen. Während viele Xeon Scalable-und Max-Prozessoren der 4. Generation unterschiedliche Ebenen der DSA/QAT/DLB/IAA-Unterstützung bieten, enthalten alle den brandneuen AMX-Matrix-Beschleuniger, den neuesten Zugang zu Intels ISA (Instruction Set Architecture).

Intel liebt KI und in Bezug auf Xeon-CPUs spricht man schon seit geraumer Zeit davon. Aber in einer Zeit, in der GPUs bei vielen KI-Workloads so schnell sind, was veranlasst Intel, hier eine Lösung wie AMX implementieren zu wollen? Für den Anfang, wo die CPU selbst auch stark an einer KI-Arbeitslast beteiligt ist, kann AMX direkt neben den Kernen eine großartige Leistung liefern – je nach Gesamtarbeitslast vielleicht genug, um nicht einmal diskrete GPUs installieren zu müssen.

Intel behauptet, dass sein AMX bei der Berechnung linearer Algebra im Vergleich zu seiner Vektor-Engine etwa achtmal schneller ist, und zu den Zielkunden gehören diejenigen, die Empfehlungssysteme, Bilderkennung, Verarbeitung natürlicher Sprache usw. betreiben.

Xeon AMX-und vRAN-Erweiterungen der 4. Generation von Intel

vRAN wurde auch mit einigen AVX-Updates ausgestattet, wobei 42 neue Anweisungen hinzugefügt wurden, die die Vorteile der in FP16 geschriebenen Algorithmen nutzen, wobei die Verwendungen hier auf Signal-und Medienverarbeitung, Front-Haul-Formatierung und Layer-Mapping abzielen.

Beschleunigung scheint wirklich der Name des Spiels bei Sapphire Rapids zu sein. Es wurden mehrere Beschleuniger implementiert, um die Belastung der CPU selbst zu reduzieren und letztendlich mehr in der gleichen Zeit zu erledigen.

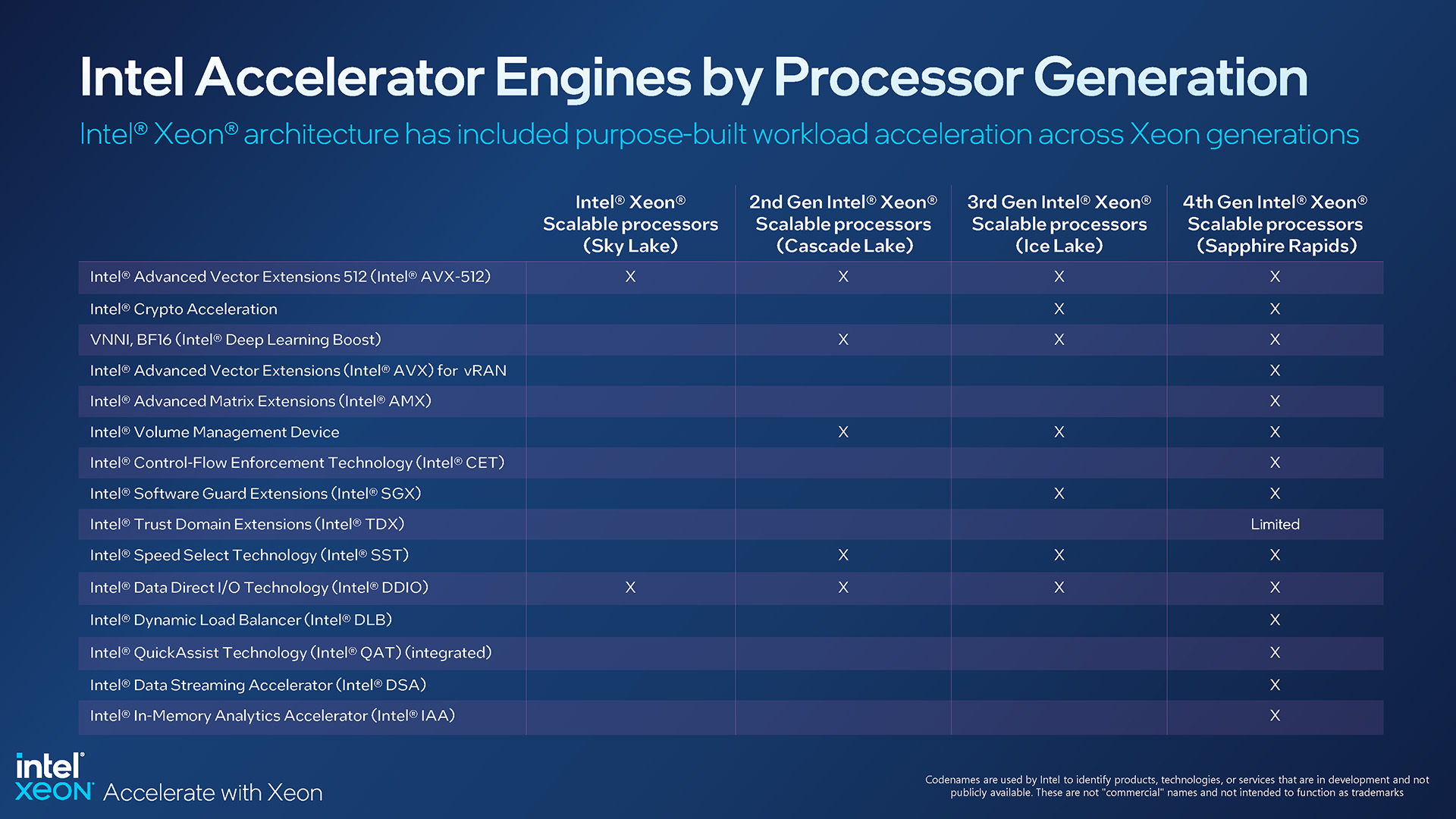

Beschleuniger-Engines für jede skalierbare Xeon-Generation

Glücklicherweise fehlen bestimmte Beschleunigerfunktionen in ausgewählten Xeon-SKUs wird AMX zum De-facto-Standard. Das ist wichtig, da wir wissen, dass viele Softwareanbieter ihre Bits aktualisieren müssen, um sie voll auszunutzen.

Der Support für alle kommt vielleicht nicht so schnell, wie wir es uns wünschen, aber Da AMX ein Standard ist, bedeutet dies, dass Entwickler sich sicher fühlen können, Zeit für die Entwicklung um ihn herum aufzuwenden. Es ist schwieriger, sich zu verkaufen, wenn eine coole neue Funktion in der gesamten Produktpalette nur begrenzt unterstützt wird. Bemerkenswert ist, dass sowohl TensorFlow als auch PyTorch AMX-Unterstützung integriert haben, also scheinen wir einen guten Start hingelegt zu haben.

Außerdem teilen sich alle diese Beschleuniger-Engines einen kohärenten, gemeinsam genutzten Speicherplatz zwischen den Kernen und Beschleunigern , was einmal mehr die Bemühungen von Intel unterstreicht, eine möglichst effiziente Architektur mit minimalen Engpässen zu liefern.

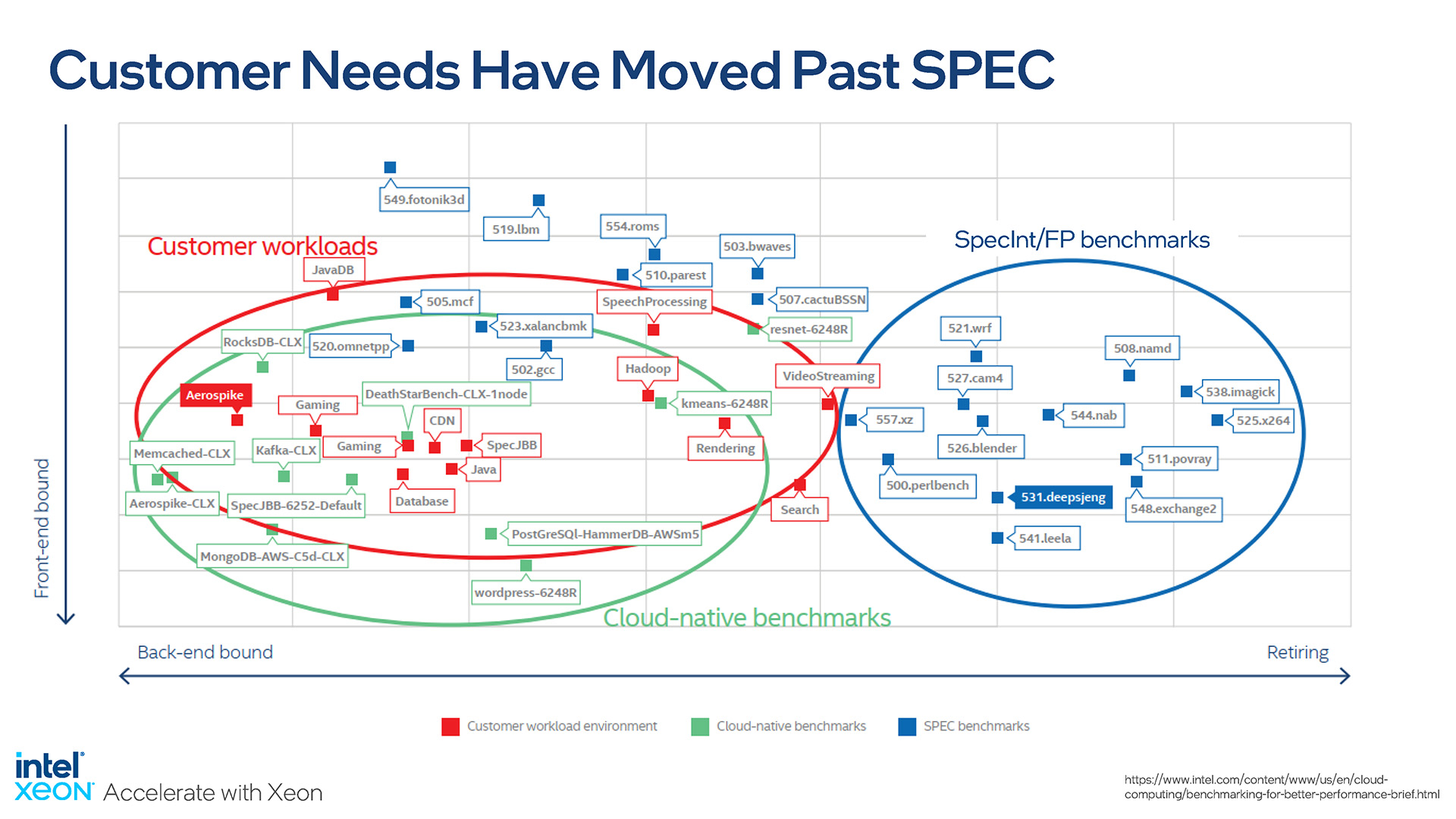

Apropos Leistung, Intel Senior Fellow Ronak Singhal sprach uns mit seiner Präsentation wirklich an, da er betonte, wie wichtig diese ist Benchmark-Prozessoren mit relevanten Tests. Vorgefertigte und voreingestellte Benchmarks haben ihren Zweck, aber letztendlich ist es für Kunden wichtig, wie sich die neue Plattform auf ihre spezifische Arbeitslast auswirkt.

Diese Folie sagt alles:

Intel betont die Bedeutung der realen Welt Leistungstests

SPEC ist ein Konsortium, an dem die meisten der größten Halbleiterunternehmen der Branche beteiligt sind, sodass freigegebene Benchmarks in der Regel von allen vereinbart werden – es gibt keine inhärente Voreingenommenheit in den Tests. Diese Tests sind jedoch starr und ihre Ergebnisse spiegeln die meisten Workloads nicht wider. Intel selbst hat mit Kunden zusammengearbeitet, um zu ermitteln, wie weit die meisten Benchmarks von Praxisszenarien entfernt waren, und betont daher die Notwendigkeit, mit relevanten Benchmarks zu testen.

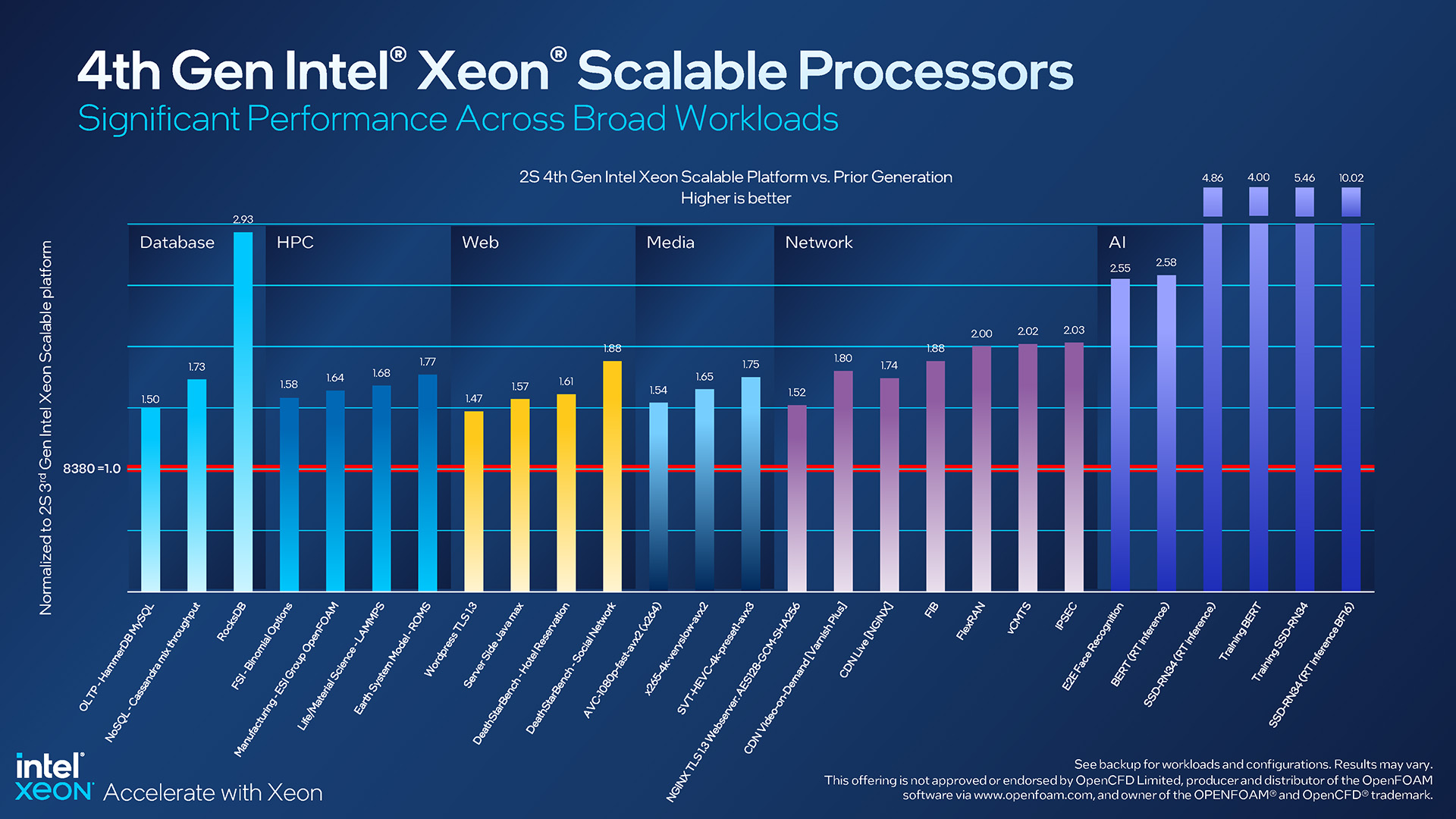

Zu diesem Zweck schneidet Sapphire Rapids in realeren Tests ab gut gegen den Top-End-Xeon 8380 der vorherigen Generation:

Intel Xeon-Leistungserwartungen der 4. Generation

Die allgemeinen Leistungsverbesserungen sind großartig zu sehen, aber natürlich stechen einige dieser Ergebnisse mehr als hervor die Anderen. Besonders die von RocksDB ist interessant, da sie die Vorteile von Intels aktualisiertem In-Memory Analytics Accelerator hervorhebt. Aber selbst die bescheidenen Gewinne bleiben beeindruckend, wie z. B. eine ~50%ige Verbesserung der WordPress-Leistung bei Verwendung von TLS.

Wir können keine explizite Erwähnung davon finden, aber wir müssen uns alle KI-Arbeitslasten vorstellen auf der rechten Seite dieser Folie haben dank der AMX-Einführung solche Mammut-Boosts gesehen. Während die letzten vier Balken alle nach oben steigen, sticht das Echtzeit-Inferenz-BF16-Ergebnis mit etwa 10x wirklich hervor.

Optimierte Tools helfen dabei, die skalierbaren Xeon-und Max-Prozessoren der 4. Generation von Intel optimal zu nutzen

Weil Die CPUs von Intel haben so viel einzigartige Hardware, dass das Unternehmen große Anstrengungen unternimmt, um sicherzustellen, dass jeder die richtigen Tools und Informationen für den Job hat. Intels oneAPI wird ständig aktualisiert, ebenso wie viele andere Tools wie oneDNN, QPL und DML. Auch die Dokumentation wird häufig aktualisiert.

In ähnlicher Weise weiß Intel auch, dass Beispiele bereitgestellt werden sollten, damit Kunden die KI-Funktionen optimal nutzen können. Aus diesem Grund bietet das Unternehmen Dutzende von vortrainierten KI-Modellen an, die die Leute direkt in ihre Projekte integrieren oder von denen sie lernen können.

Während einer Präsentation stellte Intel fest, dass nur 53 % der KI-Projekte gekickt werden. ausschalten und am Ende den Abschluss sehen, was eine ziemlich massive Fehlerrate ist. Mit Lösungen wie oneAPI, die Verarbeitungsleistung von der CPU oder integrierten Beschleunigern beziehen können, besteht das Ziel darin, sicherzustellen, dass Benutzer ihre Berechnungen so effektiv wie möglich erledigen können. Mit der Zeit werden wir hoffentlich sehen, dass diese Zahl um 53 % steigt.

Abschließende Gedanken

Intel hat viele Informationen über seine Xeon Scalable-und Max-Reihe der 4. Generation preisgegeben, und letztendlich wir Ich habe hier nur an der Oberfläche gekratzt, obwohl so viele gute Informationen diskutiert werden. Als wir uns letzten Monat von den persönlichen Briefings verabschiedeten, wurde klar, dass diese Markteinführung Intel am Herzen liegt, und das aus gutem Grund. Hier gibt es viel Neues und Faszinierendes.

Wie immer bietet Intel viele Optionen – egal, welchen Anwendungsfall Sie haben, Sie werden mit Sicherheit eine CPU finden, die Ihren Anforderungen entspricht. Unten befindet sich ein 8-Kern-3408U für allgemeine Zwecke in einer 1-Sockel-Plattform, und oben ist der 60-Kern-Gigant 8490H, der in 8-Sockel-Systemen verwendet werden kann.

Leistungsvorteile für Intels Sapphire Rapids gegenüber der vorherigen Generation

Zugegeben, es ist die Xeon Max-Serie, die uns am meisten fasziniert. 64 GB superschneller Arbeitsspeicher direkt in die CPU integriert zu haben, könnte für bestimmte Workloads und insbesondere für Szenarien, in denen viel Arbeitsspeicher einfach nicht erforderlich ist, ein Segen sein. Die Tatsache, dass ein Xeon Max-Server ohne ein einziges installiertes DIMM hochfahren und normal funktionieren könnte, ist nicht nur beeindruckend, sondern auch nützlich.

Wie Sapphire Rapids letztendlich im Vergleich zur Konkurrenz abschneidet, erfordert umfassendes Benchmarking von anderen herauszufinden, und wir sind sicher, dass viel Leistung kommen wird. Wir sind uns jedoch nicht ganz sicher, ob die Startleistung das genaueste Bild zeichnen wird, da einige Designmerkmale von Sapphire Rapids Software-Updates erfordern. Wir haben bereits besprochen, dass PyTorch und TensorFlow AMX standardmäßig unterstützen, aber es gibt noch viel mehr auf KI ausgerichtete Software.

Letztendlich freuen wir uns einfach über den Start von Sapphire Rapids , denn es hat lange auf sich warten lassen, und wir freuen uns auch, dass es so viel Interessantes zu erzählen gab. Wie bei allen Servern wird das Eindringen neuer Produkte in das Ökosystem langsam sein, daher wird es interessant sein zu sehen, wo die Dinge Mitte und Ende des Jahres stehen.

Unterstützen Sie unsere Bemühungen! Da die Werbeeinnahmen für geschriebene Websites so niedrig wie nie zuvor sind, verlassen wir uns mehr denn je auf die Unterstützung unserer Leser, die uns dabei hilft, weiterhin so viel Mühe in diese Art von Inhalten zu stecken. Sie können uns unterstützen, indem Sie Patron werden oder unsere Amazon-Shopping-Affiliate-Links verwenden, die in unseren Artikeln aufgeführt sind. Vielen Dank für Ihre Unterstützung!