Snapdragon AR2-Plattform

Auf seinem letzten Snapdragon Summit kündigte Qualcomm seine erste speziell entwickelte Augmented-Reality-Plattform an: Snapdragon AR2 Gen 1. VR ist immersiv, aber Qualcomm glaubt, dass die Zukunft des Spatial Computing darin liegen wird sieht aus wie eine Weiterentwicklung von AR, da es die nahtlose Verschmelzung von physisch und virtuell ermöglicht. Sie können den ganzen Tag eine Brille tragen, haben aber den Vorteil, dass zusätzliche Informationen verfügbar sind und privat angezeigt werden.

Eine der größten Herausforderungen dabei ist die Integration aller notwendigen Features und Funktionen in ein klein genuges Paket, das es nicht ist nur angenehm zu tragen, sieht aber nicht aus wie ein Glasbaustein, der mit Klettverschluss ans Gesicht geschnallt wird. Die Leistung und Batterielebensdauer, die Kühlung des Prozessors, ein ausreichend großes Sichtfeld, die Benutzerfreundlichkeit, das Display, der Komfort, das Gewicht, die physische Anordnung und die Verkabelung der Komponenten; Der Versuch, all das in ein kleines Paket zu packen, ist eine große Herausforderung.

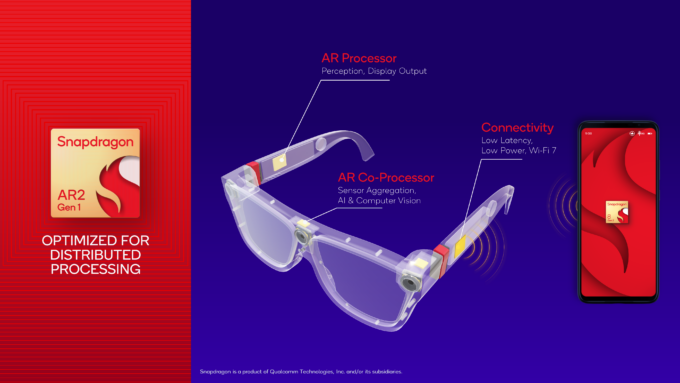

Qualcomm hat in der Vergangenheit mehrere XR-Plattformen veröffentlicht, die als Basisplattformen und Entwicklungskits für mehrere erfolgreiche VR-Headsets verwendet wurden. Diese neue Nur-AR-Plattform baut auf diesem Erfolg auf, konzentriert sich jedoch „von Grund auf“ auf AR. Es wird sich stark auf die KI-Technologien stützen, die in der Snapdragon 8 Gen 2-Version implementiert wurden, um ein besseres Edge-Computing zu erzielen. Es wurde auch für die verteilte Verarbeitung optimiert, indem die Last auf verschiedene Chips verteilt wird, um im Einklang zu arbeiten, anstatt als monolithischer Chip.

Dieser verteilte Ansatz ist aus mehreren Gründen notwendig. Ein einzelner monolithischer Chip nimmt mehr Platz in einem einzelnen Bereich ein und hat viel höhere thermische Anforderungen, macht die Implementierung jedoch einfacher und billiger. Diese lokalisierten Hotspots stehen jedoch im Konflikt mit dem, was AR braucht, um eine breiter akzeptierte, schlankere AR-Brille zu sein.

Die AR2-Plattform wird drei Chips enthalten: einen AR-Prozessor, einen Co-Prozessor und einen Konnektivitäts-Chip. Ein Großteil der schweren Arbeit muss immer noch von einem angebundenen Gerät wie einem Telefon oder einem Laptop erledigt werden, sodass es sich nicht um eigenständige Geräte handelt. Teil des Opfers bei der Schaffung eines viel schlankeren AR-Erlebnisses.

Der AR-Prozessor sitzt in einem der Bügel der Brille und ist dafür verantwortlich, Schlüsselinformationen an das angeschlossene Gerät zurückzusenden. Dies sind Dinge wie 6DoF (Bewegungsverfolgung), räumliche Informationen (kontextuelle Hervorhebung von Objekten und Verfolgung) und die Anzeige-Engine.

Der Co-Prozessor befindet sich in der Brücke der Brille und wird verwendet für sensorische Aggregation, KI und Computersehen. Der Konnektivitätschip verwendet das gleiche FastConnect-System wie die SD8gen2-Plattform und wird zusammen mit einem Akku im anderen Bügel der Brille platziert und betreibt die Wi-Fi 7-Verbindung mit geringer Latenz, um Daten zum und vom Host zu streamen.

Interessant wird es ab dem eher technischen Tiefgang. Der AR-Prozessor basiert auf einem 4-nm-Prozess und teilt einen Großteil der architektonischen Designphilosophie der mobilen Prozessoren. Es wird seinen eigenen Speicher, Spectra ISP, CPU, Adreno-Display, Sensor-Hub, Hexagon-und Adreno-Prozessoren haben, alles nur neu angeordnet und anders skaliert. Die neuen Funktionen sind jedoch die Reprojektions-Engine und die visuelle Analyse-Engine.

Die visuelle Analyse-Engine arbeitet in Verbindung mit dem 6DoF-Tracking, um wichtige Punkte von Interesse als Bezugsrahmen zu markieren, sodass das Tracking erhalten bleibt genau. Dies geschieht eher in Hardware als in Software, um die Bewegungsverfolgung zu beschleunigen und Bewegungslatenz zu beseitigen, die Hauptursache für Reisekrankheit bei diesen Setups.

Die Reprojektions-Engine übernimmt die schwere Arbeit beim Abgleich virtueller Objekte der realen Welt, unter Verwendung der Tracking-Informationen. Dies ist dafür verantwortlich, dass virtuelle Objekte relativ zur realen Welt statisch bleiben, sodass Spielzeug und virtuelle Displays an einem physischen Objekt verankert sind, selbst wenn Sie Ihren Kopf bewegen.

Der Co-Prozessor wurde entwickelt, um einen Teil der Sensorverfolgung zu verteilen und Kameraanschlüsse vom Zentralprozessor weg, sodass die Verkabelung und der thermische Fußabdruck von einer einzigen sperrigen Brücke oder dicken Bügeln an Brillen entfernt werden können, die sich nicht flach zusammenklappen lassen. Der andere Vorteil ist die Auslagerung von Eye-Tracking und Iris-Erkennung von der Haupt-CPU, wodurch der Stromverbrauch reduziert wird, da die Haupt-CPU für einfache Aufgaben nicht aufgeweckt werden muss.

Diese Aufteilung zwischen dem AR-Prozessor (10 mm x 12 mm ) und Co-Prozessor (4,2 mm x 6,2 mm) reduziert die PCB-Platzfläche um 40 % und die Anzahl der Drähte, die verlegt werden müssen, um 45 % im Vergleich zu einem einzelnen monolithischen Chip und einer PCB, was ein viel schlankeres und stylischere Brille.

Der andere große Vorteil dieser AR2-Plattform ist der Strombedarf. Mit einer Leistung von weniger als 1 Watt (wenn man die Leistungsanforderungen für das Display ausschließt) verbraucht AR2 50 % weniger Strom als die XR2-Plattform der vorherigen Generation.

Aus Leistungssicht liegt dieser große Fokus auf KI-Geschwindigkeiten Verbesserte Hand-und Objektverfolgung um das 2,5-fache im Vergleich zu XR2. Schnelleres Tracking bedeutet weniger Verarbeitungszeit und damit auch weniger Stromverbrauch.

Eine große Gruppe von Entwicklern und OEM-Anbietern hat sich bereits für AR2 angemeldet, darunter einige bekannte Namen wie Lenovo, LG, OPPO und mehr.

Snapdragon Compute

Qualcomm war führend in einer Generation von Arm-basierten Laptops, auf denen Microsoft Windows ausgeführt wird, und ein Hauptpartner für Microsoft Surface-Geräte. Diese Ultra-Low-Power-Laptops leiteten eine Generation von „always-on“-Geräten ein, bei denen Sie einen Laptop mit 20 Stunden Laufzeit für Fernreisen oder einen ganzen Monat Standby-Zeit haben konnten.

Was diese Geräte von früheren Arm-basierten Windows-Versuchen unterschied, war die Aufnahme eines in die Hardware integrierten x86-Kompatibilitätsmodus. Obwohl es nicht sehr effizient ist, ließ es zumindest die meisten 32-Bit-x86-Anwendungen laufen, wenn auch etwas langsam. Obwohl x86 langsam lief, war es zumindest eine Überbrückungsmaßnahme, um die Akzeptanz der Plattform zu fördern, und aus dieser Perspektive hat es gute Arbeit geleistet.

Das Problem hat Entwickler ermutigt, ihre Software neu zu erstellen native Arm-APIs für Windows und ermöglichen native Leistung für Schlüsselanwendungen. Einer der Hauptakteure in dieser Hinsicht war Adobe, da es ziemlich langsam war, Arm zu übernehmen, obwohl es 2019 ein Launch-Partner war. Es brachte zunächst native Versionen von Photoshop und Lightroom auf den Markt, hat aber seitdem in dieser Wartung geschwankt. Selbst dann läuft die native Version von Photoshop nicht optimal (um es milde auszudrücken). Auf dem Snapdragon Summit hat Adobe angekündigt, den Support fortzusetzen und sich für die Zukunft der nativen Arm-Unterstützung für seine Software zu verpflichten, indem es native Arm-Versionen von Fresco und Acrobat für 2023 ankündigt.

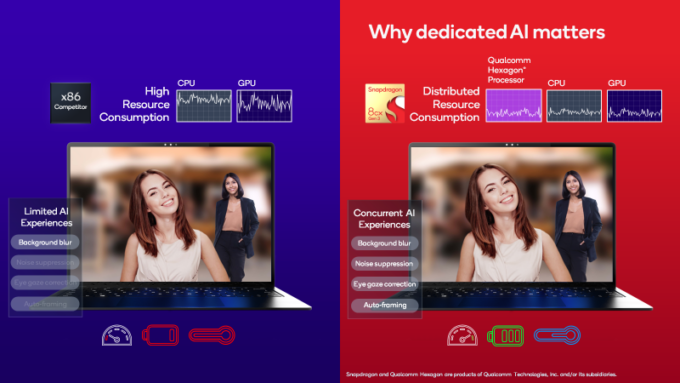

Qualcomm wollte auch über einige der Änderungen, die auf Laptops kommen, und dazu gehört auch die KI auf dem Gerät und ihre Bedeutung. Wir haben eine Phase der Hardwarebeschleunigung mit der GPU durchlaufen, wobei wir uns ihre massiv parallele Natur zunutze gemacht haben, aber in den letzten Jahren hat sich dieser Fokus nun auf mehr KI mit Tensor-Kernen verlagert.

Viel KI In den letzten Jahren ging es mehr um die Verbesserung von Spielen und Videos durch riesige GPUs. Der Großteil der Arbeit wurde im Voraus erledigt, indem die KI mit Cloud-Computing und riesigen Rechenzentren trainiert wurde. Auf dem Gerät selbst wurde nicht viel KI verwendet. Voice-to-Text-Systeme haben zum größten Teil einfache alte Algorithmen verwendet, die einzige beteiligte KI war, nachdem der Text an das Rechenzentrum gesendet wurde, wo seine Engine für natürliche Sprache übernahm, um zu versuchen, zu schließen, was Sie gesagt und gemeint haben.

Was die Zeit gekostet hat, ist das Training und die Anwendung für Dinge, die wir jeden Tag tun. Ein Aspekt, der von vielen Menschen akzeptiert und sogar gefordert wird, ist das Arbeiten von zu Hause aus und die gefürchteten Konferenzmeetings. Belebte Hintergründe, zufällige Geräusche von den Mikrofonen der Leute; Leuten zu sagen, dass sie sich stumm schalten sollen, wenn sie nicht an einem Anruf teilnehmen, ist ein allgemeiner Ratschlag, dem anscheinend nur wenige folgen.

Wir haben NVIDIA Broadcast in Aktion gesehen und gesehen, wie es Hintergrundgeräusche auf Mikrofonen bereinigen kann, und zwar durch die Kraft der KI. Hintergrundunschärfe, sodass Gesichter in den Fokus rücken, und Hintergrundersetzung ohne Greenscreen dank KI möglich. Wir haben jetzt automatisches Framing und Zuschneiden, Bewegungsverfolgung, damit Sie immer im Bild und im Fokus bleiben. Helligkeits-und Farbkorrektur für dunkle Räume. Und jetzt mehrsprachige Übersetzung in Echtzeit mit Transkripten und Untertiteln, alles dank KI. Wir konnten all dies sicher vor der KI tun, aber es war rechenintensiv. KI hat die Dinge einfach so viel schneller gemacht, dass wir jetzt alles gleichzeitig tun können, aber mit einem Bruchteil der Leistung. Genau das möchte Qualcomm in die nächste Generation von Snapdragon für Windows einbringen.

Teil dieser Bemühungen ist die Ankündigung des nächsten CPU-Projekts von Qualcomm namens Oryon (ausgesprochen Orion)… und dass es 2023 kommt, zusammen mit allen Details darüber, was diese CPU tun wird.

Snapdragon Sound und Spatial Audio

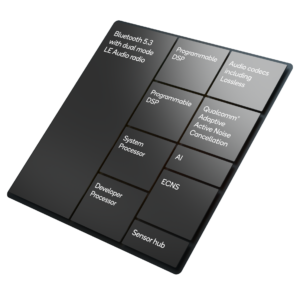

Ein weiteres Marktsegment, zu dem Qualcomm gehört, sind Audiotechnologien, die sich hauptsächlich auf Bluetooth und drahtloses Audio konzentrieren. Auf dem Snapdragon Summit 2022 wollte Qualcomm seine Fortschritte im Bereich räumliches Audio präsentieren, also die 3D-Verfolgung von Ton und Klanglandschaft.

Dies ist ein Effekt, mit dem mehrere andere Unternehmen in den letzten Jahren experimentiert haben , meist in Verbindung mit VR-Brillen. Wenn Sie Ihren Kopf bewegen, kommt der Ton mit unterschiedlichen Pegeln durch Ihren linken und rechten Lautsprecher, wodurch der Eindruck entsteht, dass der Ton von einem festen Punkt im Raum kommt. Im Rahmen der Qualcomm-Studie wünschten sich 41 % der befragten Personen diese Funktion und waren bereit, dafür mehr zu bezahlen. Diese Funktion wird im Rahmen der Markteinführung von Snapdragon 8 Gen 2 und der Snapdragon Sound S5-und S3 Gen 2-Plattformen verfügbar sein.

Dieses räumliche Tracking muss außerdem mit geringer Latenz erfolgen und kann drahtlos erfolgen sehr anspruchsvoll, besonders über Bluetooth. Qualcomm hat es geschafft, die Latenz auf seiner Soundplattform von 89 ms im letzten Jahr auf 48 ms zu senken, was im Vergleich zu den <8 ms, die die Leute von Displays erwarten (120 FPS+), ziemlich hoch erscheint. Unsere Ohren sind im Allgemeinen weniger empfindlich gegenüber Audioverzögerungen als beim Sehen und verursachen glücklicherweise normalerweise keine Übelkeit. Eine hohe Latenz im Audio kann jedoch sehr ablenkend sein, insbesondere bei Filmen und Spielen, daher wird jede Methode zur Reduzierung der Latenz sehr geschätzt.

Ein Element auf der Snapdragon Sound-Plattform, das bei bestimmten Massen wahrscheinlich ziemliches Interesse haben wird ist die Unterstützung für verlustfreies Audio sowohl auf Bluetooth Classic-als auch auf LE-Standards. Dies wird über den aptX Lossless-Standard bereitgestellt und ist eine Funktion, nach der Sie bei neuen Kopfhörern und Ohrstöpseln Ausschau halten sollten.

Eine neue Welle von Geräten wird ebenfalls bald angekündigt, wie z bringt aptX-Sound auf Lautsprecher und Premium-Funktionen wie verlustfreies Audio in preisgünstige Kopfhörer der Mittelklasse – sodass Sie möglicherweise nicht so viel Geld für verlustfreies Audio ausgeben müssen.

Adaptive Noise Cancelling (ANC) wird immer beliebter ein Update, und Sie können sehen, dass es auch auf mehr Geräten unterstützt wird. Es wurde optimiert, um Windgeheul besser zu blockieren, aber auch Stimmen besser zu erkennen, sodass Sie auf Wunsch auch mit aktiviertem ANC ein Gespräch führen können.

Es wird auch Unterstützung für das neue Auracast Broadcast-Audiosystem geben , in der Lage zu sein, Bluetooth-Audio gleichzeitig auf mehrere verbundene Geräte zu streamen.

Nach alledem lässt sich damit der Snapdragon Summit und das, was wir im neuen Jahr erwarten können, zusammenfassen. Sehen Sie sich unbedingt auch den Ersttags-Launch-Artikel von Qualcomm an, um zu sehen, was im Mobilsektor auf Sie zukommt.

Unterstützen Sie unsere Bemühungen! Mit Werbeeinnahmen auf einem Allzeittief für geschriebene Websites verlassen wir uns mehr denn je auf die Unterstützung durch Leser, die uns dabei hilft, weiterhin so viel Mühe in diese Art von Inhalten zu stecken. Sie können uns unterstützen, indem Sie Patron werden oder unsere Amazon-Shopping-Affiliate-Links verwenden, die in unseren Artikeln aufgeführt sind. Vielen Dank für Ihre Unterstützung!