NVIDIA hat heutzutage ein sehr großes und vielfältiges Portfolio, wenn es um Hochleistungscomputer geht. Wir haben bereits die Ankündigungen der GPUs der RTX 4000-Serie auf der Spieleseite gesehen, aber auf dem Unternehmensmarkt ist ein ganz anderes Ausmaß im Gange.

Wir haben einen Einblick in das bekommen, was kommen wird auf der jährlichen GTC-Veranstaltung von NVIDIA mit großartigen Neuigkeiten über die lang erwartete nächste Generation von GPUs in Form von Ada Lovelace, aber es war auch eine Gelegenheit, alle über einige der Unternehmens-und Inhaltserstellungsseiten von NVIDIAs Technologiearsenal zu informieren. Von Hopper bis NeMo, LLMs und IGX; es gab viel zu berichten.

Auf der SC22 sprach NVIDIA über seine High Performance Compute (HPC)-Plattform als Lösung für ein Full-Stack-Problem. Die Hardware, die Software, die Plattform und die Anwendungen müssen alle miteinander synchron sein, um die Leistung zu maximieren. Auf der Hardwareseite haben wir die H100-GPU und die beiden Grace-Plattformen. Auf Softwareebene gibt es die bekannten RTX, CUDA und PhysX, aber auch DOCA und Fleet Command. Auf der Plattformebene befassen wir uns mit NVIDIAs HPC-Plattformen wie DGX-Servern und-Racks, ihren KI-Frameworks und natürlich dem sich ständig verändernden und sich entwickelnden Omniverse. Auf der Anwendungsebene sehen wir eine ganze Reihe von Frameworks und KI-fähigen Suiten wie Holoscan, Modulus, CuQuantum und Large Language Models (LLMs).

H100-und HPC-Plattformen

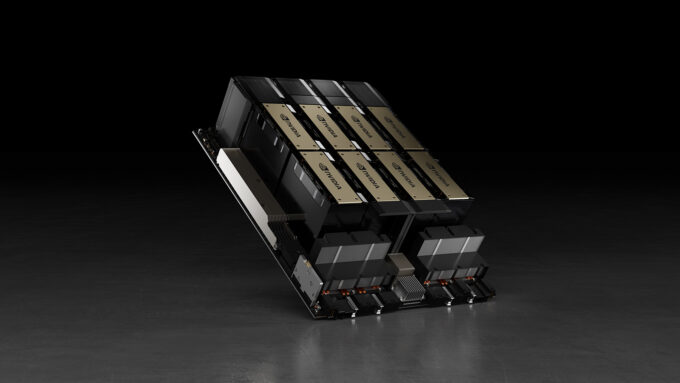

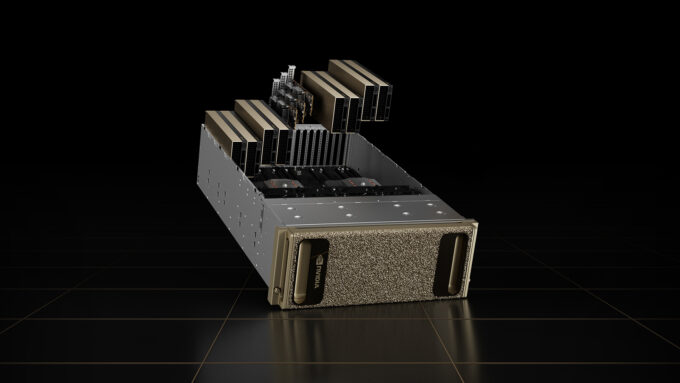

Wir haben einen Einblick bekommen bei den zukünftigen Tensor Core-Rechenkarten der nächsten Generation bei GTC, den GPUs der Hopper-Serie für Unternehmen, Computer und KI; der H100 ist das Flaggschiff der Generation. Für den H100 wurden mehrere verschiedene Plattformen angekündigt, angefangen mit nur einer einzigen PCIe-basierten Karte, einem DGX-Desktop-Supercomputer bis hin zu HGX-Rack-montierten Systemen, die NVIDIAs SXM-Formfaktor-Karten verwenden.

Diese Compute-Karten sind seit einiger Zeit auf LaunchPad verfügbar – probieren Sie es aus, bevor Sie kaufen, um Enterprise-Hardware von NVIDIA in einer Cloud-Infrastrukturumgebung zu testen, die auf denselben Technologien wie GeForce NOW basiert.

Der Unterschied in Die Verarbeitungsleistung des H100 im Vergleich zum im letzten Jahr eingeführten A100 ist beachtlich. Der A100 war keineswegs ein Schwachkopf, insbesondere wenn es um die KI-Leistung im Vergleich nicht nur zu CPUs, sondern auch zu anderen GPUs zu dieser Zeit ging. Das H100 ist ein weiterer Leistungssprung, der seinen eigenen tiefen Tauchgang rechtfertigt, aber das Wesentliche ist, dass die Energieeffizienz 3,5-mal besser ist und 5-mal weniger Verarbeitungsknoten benötigt, um mit einem gleichwertigen A100-Rechenzentrum mithalten zu können.

Das gab es Weitere H100-Ankündigungen konzentrierten sich auf Edge-AI mit den konvergierten CNX-Beschleunigern – PCIe-basierte GPUs mit integrierten 400-Gbit/s-Netzwerkverbindungen und verteilte Hyperscale-All-in-One-integrierte CPU/GPU/Netzwerk-„Superchips“, genannt NVIDIA Grace.

Auf der SC22 kündigte Microsoft seine Unterstützung für die neuen Quantum-2-Netzwerkschnittstellen, 400G-Infiniband-Verbindungen und H100-Tensor-Core-GPUs an, die jetzt in seiner Azure-Cloud-Infrastruktur bereitgestellt werden. Andere Plattformanbieter wie ASUS, Dell, HP, GIGABYTE, Lenovo und Supermicro zeigten ebenfalls ihre jeweiligen Lösungen für das H100 in seinen verschiedenen Varianten, darunter die PCIe-Karten, 4-Wege-und 8-Wege-H100-Lösungen sowie in Luft oder Flüssigkeit Kühlkonfigurationen.

Ein neues Niveau der KI

Auf der GTC 2022 widmete NVIDIA den Large Language Models (LLMs), extrem komplexen neuronalen Netzwerken, die auf Milliarden von Parametern und Hunderten von Parametern basieren, besondere Aufmerksamkeit Gigabyte an Text und/oder Grafiken zum Trainieren, wie z. B. Transformer, BERT, GPT-3 und in jüngerer Zeit die Explosion von KI-generierten Grafiken von Dall-E 2, Grafiken, die auf der Grundlage einfacher Wörter und Beschreibungen erstellt wurden. Dies ist nicht die KI, die wir bei Chatbots gesehen haben und die wir im Laufe der Jahre verspotten, sondern künstlerischer Ausdruck in Kunst und Musik, der durch von Benutzern übermittelte Eingabeaufforderungen generiert wird. Wie dieses KI-Kunstwerk erzeugt wird, wird jedoch zu einem heiß diskutierten Thema, das sich hauptsächlich auf die Datensätze konzentriert, aus denen die KI Beispiele zieht.

LLMs werden in großem Umfang in den Bereichen Chemie und Biomedizin eingesetzt, mit vielen Aufmerksamkeit bei der Proteinfaltung und-synthese. NVIDIA kündigte seinen NeMo-Service mit vortrainierten LLMs und damit seinen BioNeMo-Service an, einen vortrainierten LLM zur Vorhersage des Verhaltens von Molekülen, Proteinen und DNA. Wählen Sie einfach Ihr Modell aus, geben Sie Ihre Molekül-oder Proteinsequenz ein und lassen Sie die KI-Inferenz weg, um die Stabilität oder Löslichkeit vorherzusagen.

NVIDIA kündigte seine IGX-Plattform an. Diese IGX-Systeme verfügen über ein Orin-Modul der NVIDIA-Automobilsparte, ConnectX-7 400-GbE-Netzwerke, eine RTX-Ampere-GPU sowie Sicherheitsintegrationen. Der Hauptfokus von IGX liegt derzeit auf der Automatisierung von Fertigung, Logistik und Medizin. Siemens ist eines der ersten Unternehmen, das IGX in Verbindung mit der Omniverse-Plattform von NVIDIA für den Aufbau digitaler Zwillinge von Fabriken nutzt, sodass Entwickler und Ingenieure in einer digital identischen Fabrik experimentieren können, um KI und Automatisierung zu trainieren und dann Änderungen an Robotern vorzunehmen Fabrikhalle, um die Arbeiter zu unterstützen.

IGX wird auch für die medizinische Bildgebung in Echtzeit (Echtzeit, wie in der menschlichen Wahrnehmung, anstatt etwa als sicherheitskritisches System in Echtzeit) und Roboterunterstützung verwendet. NVIDIA Clara Holoscan setzt auf IGX für KI-unterstützte Bildgebung, Augmented/Extended Reality und Roboterintegration für hyperspektrale Endoskopie, chirurgische Assistenz und Telepräsenz für Chirurgen.

Was ist Omniverse?

Diese Frage ist schwer zu beantworten, da sich ihre Bedeutung je nach Kontext ständig ändert. Vor vielen Jahren war es ziemlich einfach, da es sich um ein schöpferorientiertes Aggregationstool zum Zusammenführen von 3D-Assets, Texturen, Modellen und dergleichen von verschiedenen Anwendungen und Anbietern handelte. Es sollte den 3D-Arbeitsbereich vereinheitlichen, damit Änderungen in einer Suite von Tools in anderen Anwendungen widergespiegelt werden. Diese Art der Workflow-Integration fand bereits zuvor im Hintergrund statt, beispielsweise die Adobe-Tool-Integration in Autodesk. Omniverse hat mit seinem eigenen SDK noch einen draufgesetzt, um diese Integration viel weiter zu verbreiten, in Spiele-Engines wie Unreal und Unity sowie andere Design-Suites.

Was sich im Laufe der Jahre geändert hat, ist der Umfang des Omniverse-Projekts. Es geht nicht mehr nur um die Integration von Texturen und 3D-Modellen, sondern um ganze Frameworks und statistische Modelle, multiräumliche Daten wie Animationen und zeitabhängige Daten wie Luftströmung und thermische Analyse. Omniverse ging noch weiter mit KI-Modellierungsschichten, die LLMs verwendeten, um die anderen Assets vorherzusagen, zu ändern und mit ihnen zu arbeiten. Diese große Änderung geschah aufgrund der Unterstützung des Formats Universal Scene Description (USD), das ursprünglich von Pixar entwickelt wurde. USD lässt sich am besten als HTML für 3D-Design beschreiben; Es vereint die Ressourcen vieler verschiedener Formate in einer Szene. Anstatt eine Webseite zu erstellen, erhalten Sie am Ende eine vollständig interaktive 3D-Umgebung, jedoch mit zusätzlichen Informationen wie Windgeschwindigkeit, Vorhersagemotoren und anderen Metainformationen.

Zur Verwirrung, NVIDIA hat jetzt verschiedene Arten von Omniverse, zu denen Omniverse Cloud, Omniverse Nucleus, Omniverse Farm, Omniverse Replicator und Omniverse Enterprise gehören, aber Sie können auch Isaac Sim und DRIVE Sim einwerfen, da sie auf der einen oder anderen Form von Omniverse aufgebaut sind. Es gibt auch OVX-oder Omniverse-Hardwareserver, die auf DGX-Systemen ausgeführt werden.

Omniverse umfasst im Grunde den gesamten Software-Integrationsstapel und führt Daten aus allen erdenklichen Quellen in einem riesigen „Blob“ zusammen, der zur Simulation verwendet werden kann ganze Ökosysteme, digitale Zwillinge der realen Welt oder virtuelle Umgebungen, um KI und Roboter zu trainieren, die in der realen Welt arbeiten. Es wird bereits für das Training autonomer Fahrzeuge und die medizinische Bildgebung verwendet.

Digitale Zwillinge und Omniverse Nucleus

Digitale Zwillinge ist ein Begriff, an den Sie sich in Zukunft gewöhnen sollten mit dem ganzen Konzept der Metaverse und Augmented Reality. Im Wesentlichen wird eine Umgebung digital neu erstellt, nicht nur als 3D-CAD mit Fotorealismus, sondern auch unter Einbeziehung von Metainformationen wie Heatmaps, Verkehrsmanagement, Windvektoren, statistischen Modellen und so weiter. Lowes kündigte sein Digital Twin-Projekt bereits in GTC an, um Lagerbestände zu visualisieren, das Ladenlayout zu optimieren und Produkte zu platzieren.

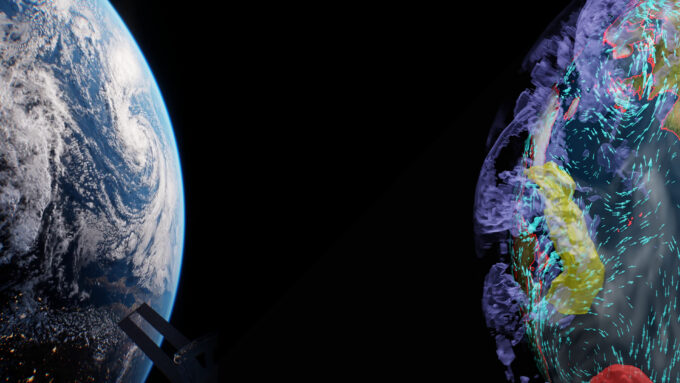

NVIDIAs Omniverse Nucleus entwickelt nun Wettersysteme für die US National Oceanic and Atmospheric Administration ( NOAA) mit Hilfe von Lockheed Martin und seiner Software OpenRosetta3D. Dies wird ein einzigartiges Projekt für die NOAA sein, um den Earth Observation Digital Twin zu erstellen. EODT wird Omniverse und OpenRosetta3D verwenden, um eine vollständige visuelle und statistische Karte der Erde zusammenzustellen, die aus Terabytes an geophysikalischen Daten, orthografischen Karten, atmosphärischen Daten und Weltraumdaten besteht. Sein Hauptziel wird es sein, Temperatur-und Feuchtigkeitsprofile, Meeresoberflächentemperaturen, Meereiskonzentrationen und Sonnenwinddaten zu visualisieren.

EODTs erste große Demonstration wird die Meeresoberflächentemperatur für September nächsten Jahres sein, da dies wahrscheinlich sein wird Helfen Sie Meteorologen, Entscheidungen über Hurrikanaktivitäten zu treffen, und der NASA mit Weltraumstartfenstern. Schließlich wird es auch zu Dürre-und Sturmvorhersagen führen. Dazu wird Omniverse verwendet, um USD-Datensätze in den Agatha 3D-Viewer von Lockheed zu überführen, der auf der Unity-Engine basiert, und es den Benutzern zu ermöglichen, die Sensordaten über eine interaktive 3D-Erde zu sehen.

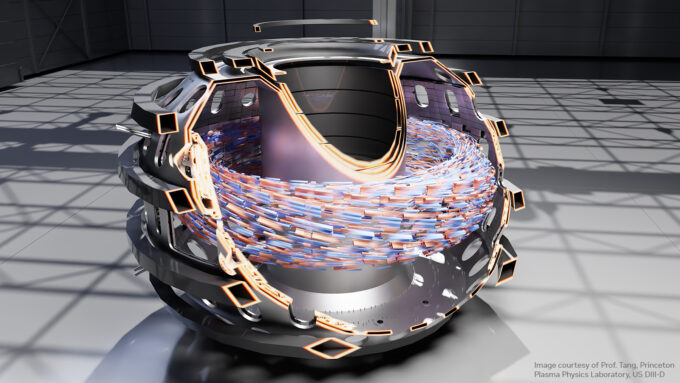

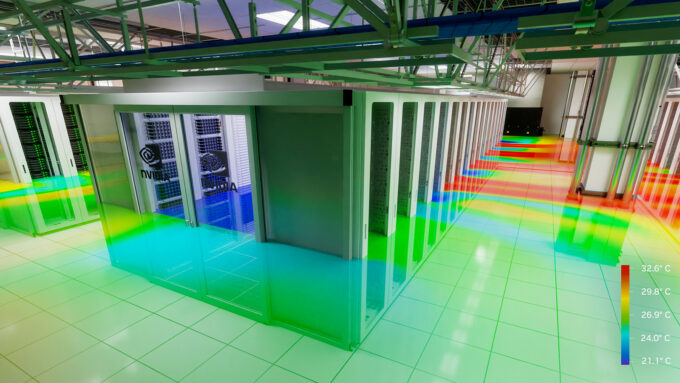

Auf der SC22 gab es eine Präsentation von NVIDIA Air, einem Rechenzentrumssimulator, der einen digitalen Zwilling mit Omniverse erstellt, der den Datenfluss überwacht und verwaltet, den gesamten Netzwerkstapel verwaltet und mit Cadence 6SigmaDCX Wärme-und Luftströme mit Computational Fluid Dynamics vorhersagt. Omniverse wurde verwendet, um beim Design eines der neuesten KI-Supercomputer von NVIDIA zu helfen, indem CAD-Daten von Autodesk Revit, PTC Creo und Trimble Sketchup zusammengeführt wurden, um das gesamte Rechenzentrum zu entwerfen.

PATCH MANAGER wurde dann verwendet, um das Kabelmanagement zu planen die Netzwerktopologie in einem Live-Modell und sehen Sie Abhängigkeiten. Sobald das Rechenzentrum fertiggestellt war, konnten die Echtzeit-Sensordaten wie Leistung und Temperatur in den in Omniverse integrierten digitalen Zwilling eingespeist werden, um eine Echtzeitüberwachung der Racks zu ermöglichen. Diese Daten könnten dann verwendet werden, um zukünftige Upgrades vorherzusagen und das physische Rechenzentrum vor der Bereitstellung zu validieren.

Bei SC22 passiert noch viel mehr, was wir nicht behandelt haben, sowie einige andere bevorstehende Ankündigungen für die Daten Center-und Supercomputer-Entwicklungen. Es gibt viel zu beachten und zu überdenken, insbesondere bei der Implementierung von Omniverse auf dem Metaversum, der Integration von Robotik und Konstruktion, da dies alles zur Entwicklung der automatisierten Weltraumforschung und anderer phantasievoller Ideen führen könnte. Es wird immer schwieriger, mit der KI und diesen gewaltigen Rechensprüngen Schritt zu halten, aber es ist auf jeden Fall faszinierend, die Entwicklung zu beobachten.

Unterstützen Sie unsere Bemühungen! Mit Werbeeinnahmen auf einem Allzeittief Bei geschriebenen Websites verlassen wir uns mehr denn je auf die Unterstützung durch Leser, die uns dabei hilft, weiterhin so viel Mühe in diese Art von Inhalten zu stecken. Sie können uns unterstützen, indem Sie Patron werden oder unsere Amazon-Shopping-Affiliate-Links verwenden, die in unseren Artikeln aufgeführt sind. Danke für deine Unterstützung!