NVIDIA hat kündigte die H100 NVL an, eine neue Variante ihrer Hopper-GPU, die speziell für Large Language Models (LLMs) wie OpenAIs GPT-4 entwickelt wurde.

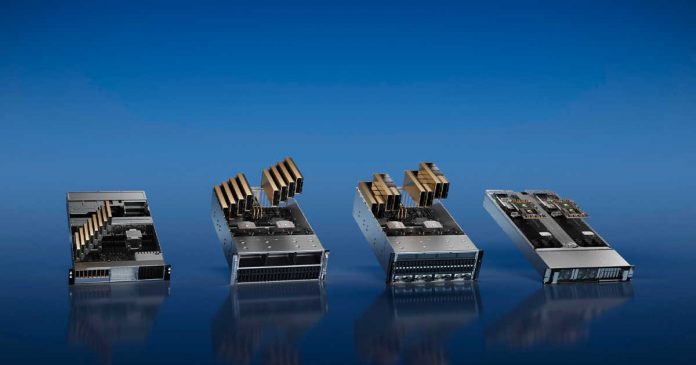

Die Dual-GPU-Karte verfügt über zwei H100-PCIe-Boards, die bereits miteinander verbunden sind, und eine große Speicherkapazität, was sie zum größten Speicher pro GPU innerhalb der H100-Familie und aller bisherigen NVIDIA-Produkte macht.

Das H100 NVL zielt auf einen einheitlichen Markt für die Verwendung von Sprachmodellen im großen Maßstab auf dem Zug ab und soll den KI-Erfolg von NVIDIA vorantreiben. Große Sprachmodelle wie die GPT-Familie sind in vielerlei Hinsicht in der Speicherkapazität eingeschränkt. Sogar der H100-Beschleuniger füllt sich schnell, um alle Parameter zu halten (175B für das größte GPT-3-Modell). Daher hat NVIDIA neue H100-SKUs mit mehr Speicher pro GPU entwickelt als die regulären H100-Teile, die auf 80 GB pro GPU begrenzt sind.

Alle GH100-GPUs werden mit sechs Stacks HBM-Speicher (HBM2e oder HBM3) mit 16 GB Kapazität pro Stack geliefert. Aufgrund von Bedenken hinsichtlich der Ausbeute liefert NVIDIA jedoch nur reguläre H100-Teile mit fünf der sechs aktivierten HBM-Stacks aus, was bedeutet, dass jede GPU über nominell 96 GB VRAM verfügt, die regulären SKUs jedoch nur über 80 GB verfügen.

Das H100 NVL wird eine spezielle SKU sein, bei der alle sechs Stacks aktiviert sind und 14 GB Speicher pro GH100-GPU bieten, was einer Speichersteigerung von 17,5 % entspricht. Die Dual-GPU/Dual-Karte H100 NVL sieht aus wie die SXM5-Version der H100, angeordnet auf einer PCIe-Karte. Reguläres H100 PCIe wird etwas durch langsamere HBM2e-Speichernutzung, weniger aktive SM/Tensor-Kernnutzung und niedrigere Taktraten zurückgehalten, aber NVIDIA präsentiert Tensor-Kerne für H100 NVL. Die Leistungszahlen sind alle auf Augenhöhe mit der H100 SXM5, was darauf hindeutet, dass diese Karte nicht weiter reduziert ist wie normale PCIe-Karten.

Das große Merkmal der H100 NVL ist ihre große Speicherkapazität, wie sie die Dual-GPU-Karte bietet 188 GB HBM3-Speicher (94 GB pro Karte). Es hat auch eine Gesamtspeicherbandbreite von 7,8 TB/s und 3,9 TB/s auf einzelnen Boards, was es zum größten Speicher pro GPU innerhalb der H100-Familie und aller bisherigen NVIDIA-Produkte macht.

Die Bereitstellung dieser SKU ist wahrscheinlich in Vorwegnahme des explosiven Hits von ChatGPT und der rasanten Zunahme der KI-Nachfrage aufgrund des anschließenden Erscheinens von Bing und Bard. Der Preis wird entsprechend steigen, aber angesichts des boomenden LLM-Marktes wird es eine Nachfrage geben, einen ausreichend hohen Aufpreis für ein nahezu perfektes GH100-Paket zu zahlen.

Abschließend ist der H100 NVL eine neue Variante von Die Hopper-GPU von NVIDIA, die speziell für Large Language Models (LLMs) wie GPT-4 von OpenAI entwickelt wurde. Seine große Kapazität macht es zum größten Speicher pro GPU innerhalb der H100-Familie und aller NVIDIA-Produkte. Die erhöhte Speicherkapazität wird dazu beitragen, den KI-Erfolg von NVIDIA weiter voranzutreiben. Der H100 NVL ist ein bedeutender Fortschritt auf dem LLM-Markt, und es wird interessant sein zu sehen, wie er in Zukunft im Vergleich zu anderen GPUs abschneidet.