Ultimo aggiornamento il 3 marzo 2023

CUDA di Nvidia (Compute Unified Device Architecture) i core sono le unità di elaborazione nelle unità di elaborazione grafica Nvidia ( GPU) progettate per gestire attività di elaborazione parallela. I core CUDA sono specificatamente ottimizzati per attività di elaborazione generiche che possono essere elaborate in parallelo, come calcoli matematici e simulazioni scientifiche.

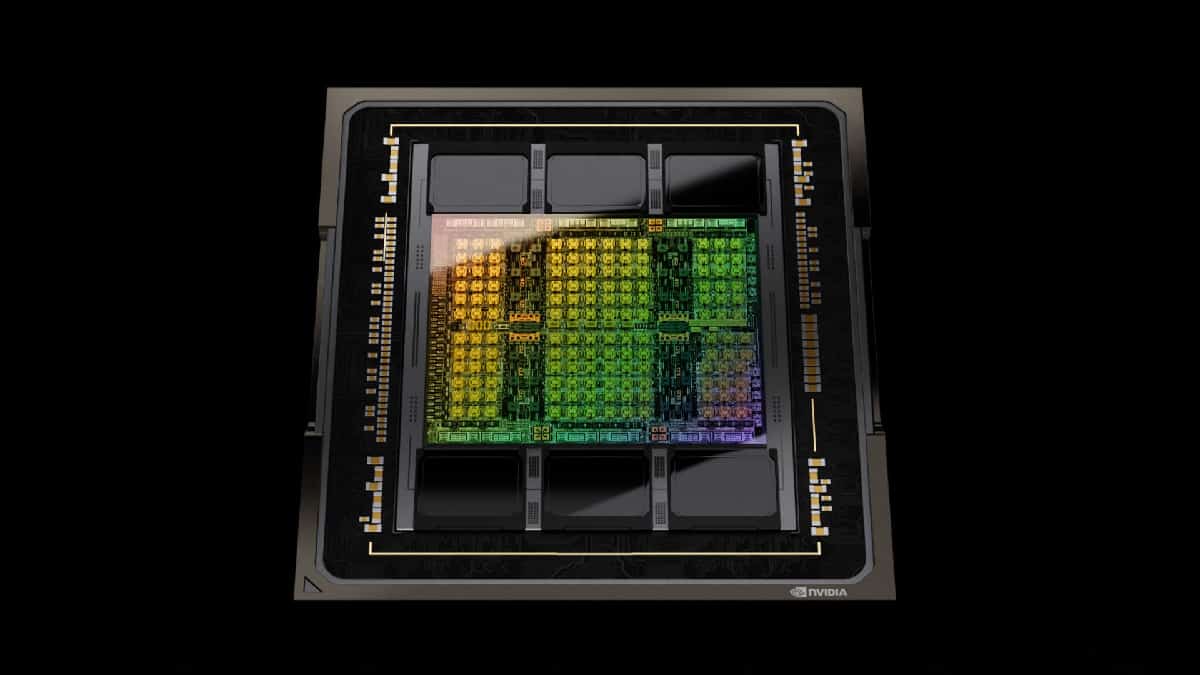

La GPU che ha il maggior numero di core CUDA al momento è l’RTX 4090. Il Nvidia RTX 4090 è la GPU più potente attualmente disponibile sul mercato, con l’incredibile cifra di 16.384 core CUDA. L’RTX 4090 si basa sull’architettura Ada di Nvidia, che presenta una serie di miglioramenti rispetto alla precedente architettura Ampere, tra cui un nuovo design multiprocessore di streaming (SM) e prestazioni migliorate di ray tracing e tensor core.

Oltre all’enorme numero di core CUDA, il RTX 4090 dispone anche di 328 Tensor Core, progettati per accelerare i carichi di lavoro di deep learning e AI. Dispone inoltre di 82 RT Core, specificamente ottimizzati per il ray tracing in tempo reale, che lo rendono adatto per giochi di fascia alta e applicazioni professionali come il rendering e l’animazione 3D.

L’RTX 4090 ha un velocità di clock di base di 1395 MHz e una velocità di clock boost di 1695 MHz, che la rendono una delle GPU più veloci attualmente disponibili. Ha anche un’enorme memoria GDDR6X da 24 GB, che fornisce un’elevata larghezza di banda e bassa latenza per carichi di lavoro impegnativi.

Grazie alle sue elevate prestazioni e all’enorme numero di core CUDA, l’RTX 4090 si rivolge principalmente agli utenti professionali ed è adatto per attività come simulazioni scientifiche, apprendimento automatico e editing video. Tuttavia, è anche una GPU di gioco altamente capace, in grado di offrire frame rate elevati e grafica ultra realistica nei giochi più esigenti sul mercato.

Cosa sono i CUDA core?

Ciascuno CUDA core è una piccola unità di elaborazione programmabile in grado di eseguire contemporaneamente un gran numero di semplici calcoli paralleli. Più core CUDA ha una GPU, più calcoli paralleli può eseguire contemporaneamente. Ciò rende i core CUDA adatti per attività che richiedono un’elevata potenza di calcolo, come l’apprendimento automatico, l’intelligenza artificiale e il calcolo scientifico.

I core CUDA possono essere programmati utilizzando il linguaggio di programmazione CUDA, che è un C-linguaggio basato che include estensioni per il calcolo parallelo. L’architettura CUDA include anche una serie di librerie e strumenti che semplificano agli sviluppatori la scrittura e l’ottimizzazione di programmi per GPU abilitate per CUDA.