Sembrava che ci fosse voluto del tempo per arrivare qui, ma oggi Intel lancia ufficialmente la sua gamma Xeon di quarta generazione basata sulla piattaforma Sapphire Rapids. Questa gamma include non solo le tipiche SKU scalabili che abbiamo visto nelle generazioni precedenti, ma anche una nuovissima serie”Max”, di cui Intel ha parlato per la prima volta una manciata di mesi fa.

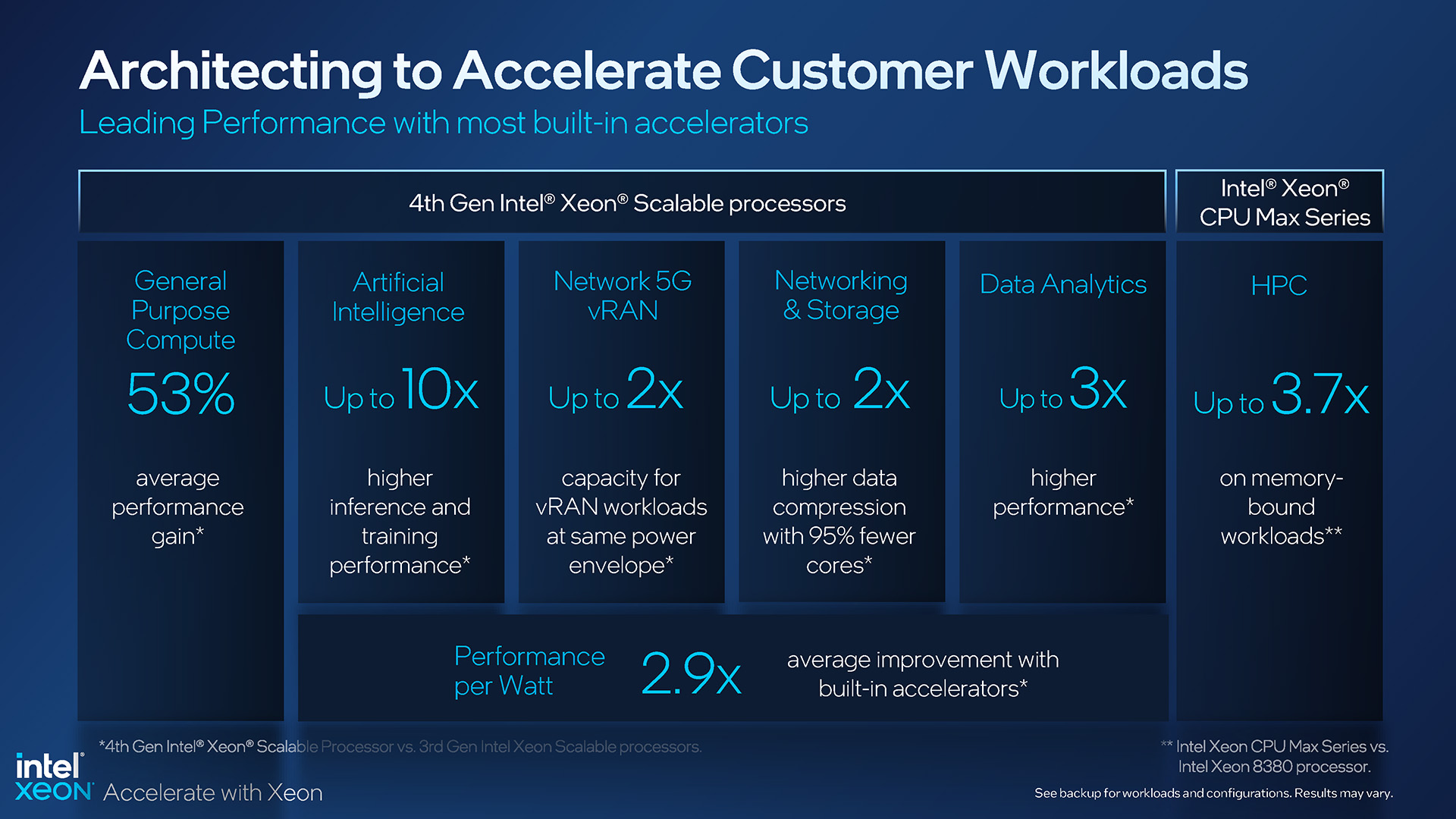

Con Sapphire Rapids, Intel afferma che l’ultimo Xeon è il più sostenibile fino ad oggi e che ha anche gli acceleratori più integrati di qualsiasi processore per server fino ad oggi. Entrambe le parti sono credibili, ma è quest’ultima che significa business, perché Intel ha racchiuso un sacco di bontà di accelerazione in queste CPU, alcune delle quali richiederanno l’aggiornamento del software per sfruttare appieno i potenziali guadagni.

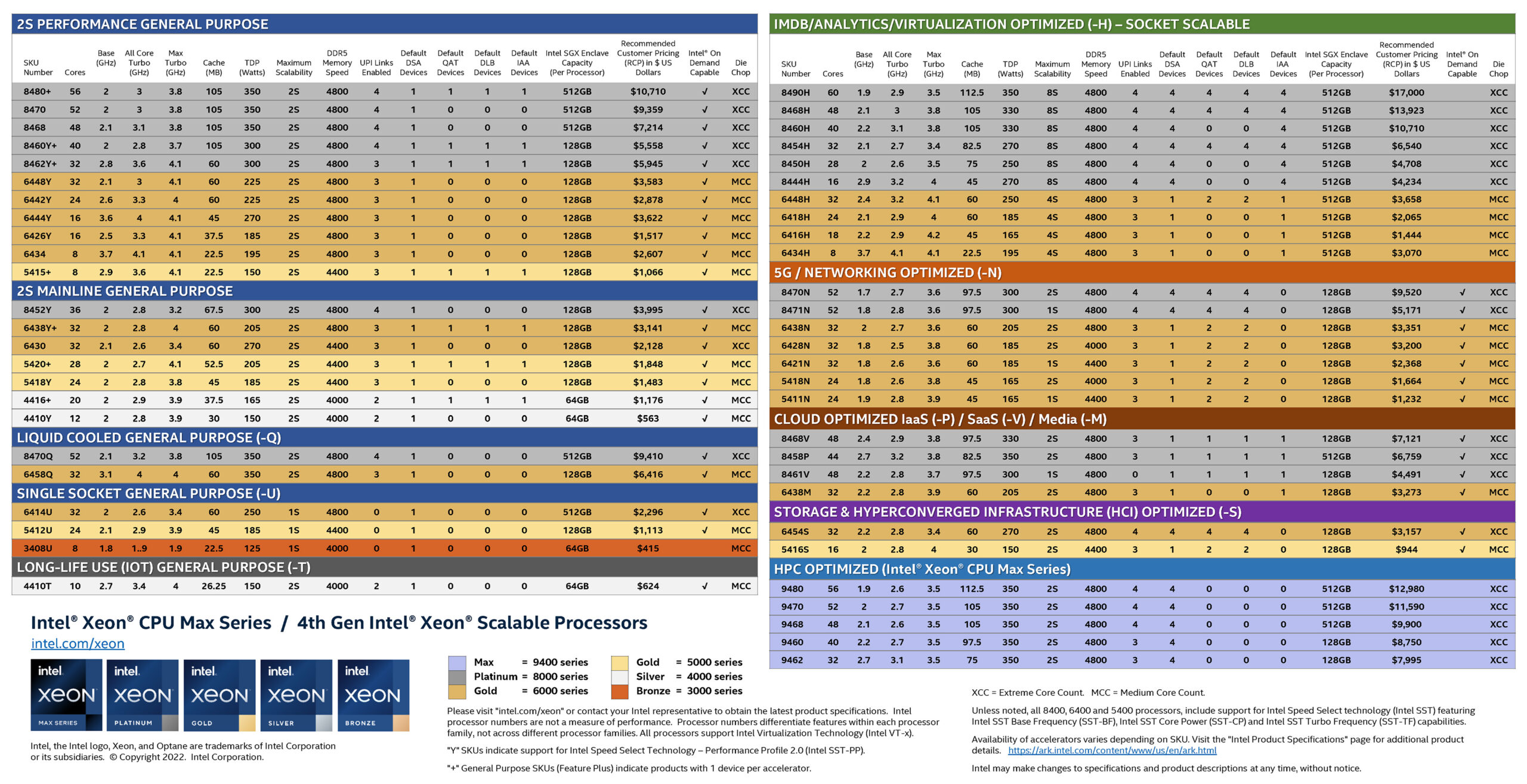

L’enorme numero di SKU di processori offerti da Intel raggiunge quasi livelli di umorismo da meme. È lo stesso sul desktop come sul server. Chi non ama questo colorato foglio SKU del server aggiornato?

Linea Intel Xeon Scalable e Xeon Max di quarta generazione

Con così tante opzioni Xeon, è chiaro che Intel sta cercando di acquisire il maggior numero di il mercato dei server come può con le sue ultime offerte. Sebbene possano esserci alcune aree in cui potrebbero inserirsi modelli aggiuntivi, questo sembra comunque un elenco esaustivo.

Sebbene Intel offra Xeon per molti scopi diversi, nessuno di essi viene sviluppato senza una buona ragione. Potresti guardare le due opzioni raffreddate a liquido e chiederti chi le utilizza effettivamente, ma Intel si è impegnata molto per far risaltare quelle CPU, collaborando con i partner del settore per sviluppare metodi migliori per i chip dei server con raffreddamento a liquido e guadagnando tanto prestazioni migliori possibili.

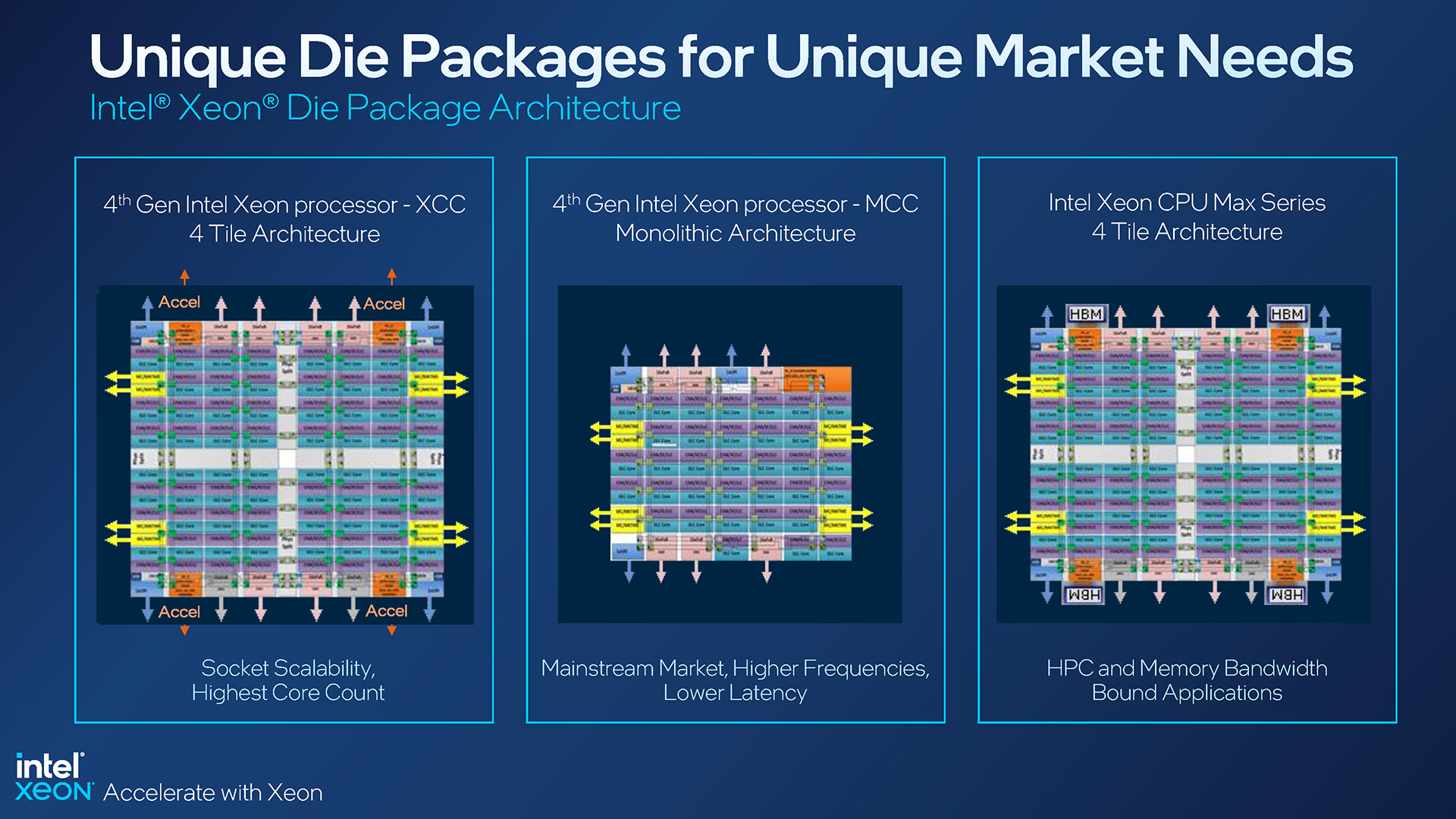

Abbiamo visto fogli SKU come quello sopra sin dal lancio originale di Xeon Scalable, ma questo ha molti dettagli extra che vale la pena menzionare. Per iniziare, la configurazione principale sarà elencata come XCC o MCC. XCC rappresenta CPU con più”riquadri”all’interno, mentre MCC è un design monolitico e più tradizionale:

Configurazioni dei pacchetti Intel 4th-gen Xeon

Un design XCC è ciò che aiuta Intel a raggiungere un numero così elevato di core al di fascia alta, con questa generazione di Xeon che raggiunge il picco di 60 core con l’8490H. I progetti MCC di ultima generazione arrivano al massimo a 32 core, ad esempio con il 6448H ottimizzato per la virtualizzazione e il 6448Y vincolato alle prestazioni 2S.

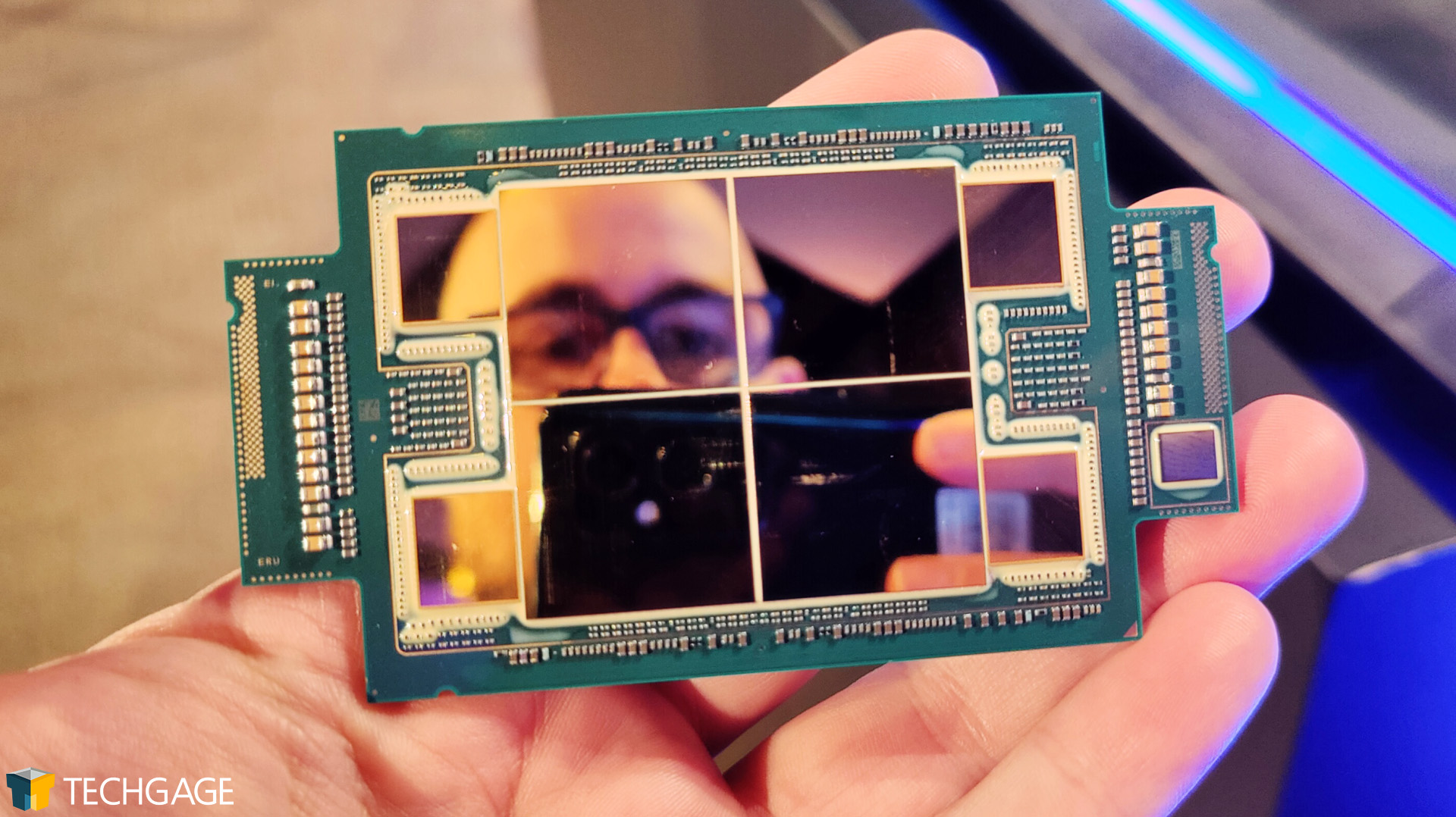

La serie Xeon Max rappresenta il terzo design, uno che è effettivamente lo stesso di XCC , ma con memoria HBM2e posizionata attorno agli stampi. Il mese scorso abbiamo fatto pratica con una CPU Max:

Xeon Max di quarta generazione di Intel è ottimo per scattare selfie

Sebbene le CPU Xeon Max occupino solo cinque posizioni nella gamma complessiva, sono probabilmente le più interessante del gruppo. Queste CPU sono dotate di memoria incorporata sufficiente per consentire a un server di funzionare senza alcuna memoria aggiuntiva. Immaginalo: un server che si avvia, funziona, senza assolutamente nessuno degli slot di memoria occupati. È deliziosamente geniale.

Le CPU Xeon Max posizionano i chip HBM2e accanto a ciascun riquadro, offrendo in definitiva una densità totale di 64 GB, fino a 1,14 GB per core. Intel sta prendendo di mira queste SKU Max direttamente sul mercato HPC e, sebbene molti carichi di lavoro HPC richiedano molta memoria, ce ne sono ancora molti che possono adattarsi facilmente a 64 GB. Naturalmente, puoi costruire sopra questo HBM2e con DDR5-4800 se la densità HBM2e da 64 GB non fosse sufficiente.

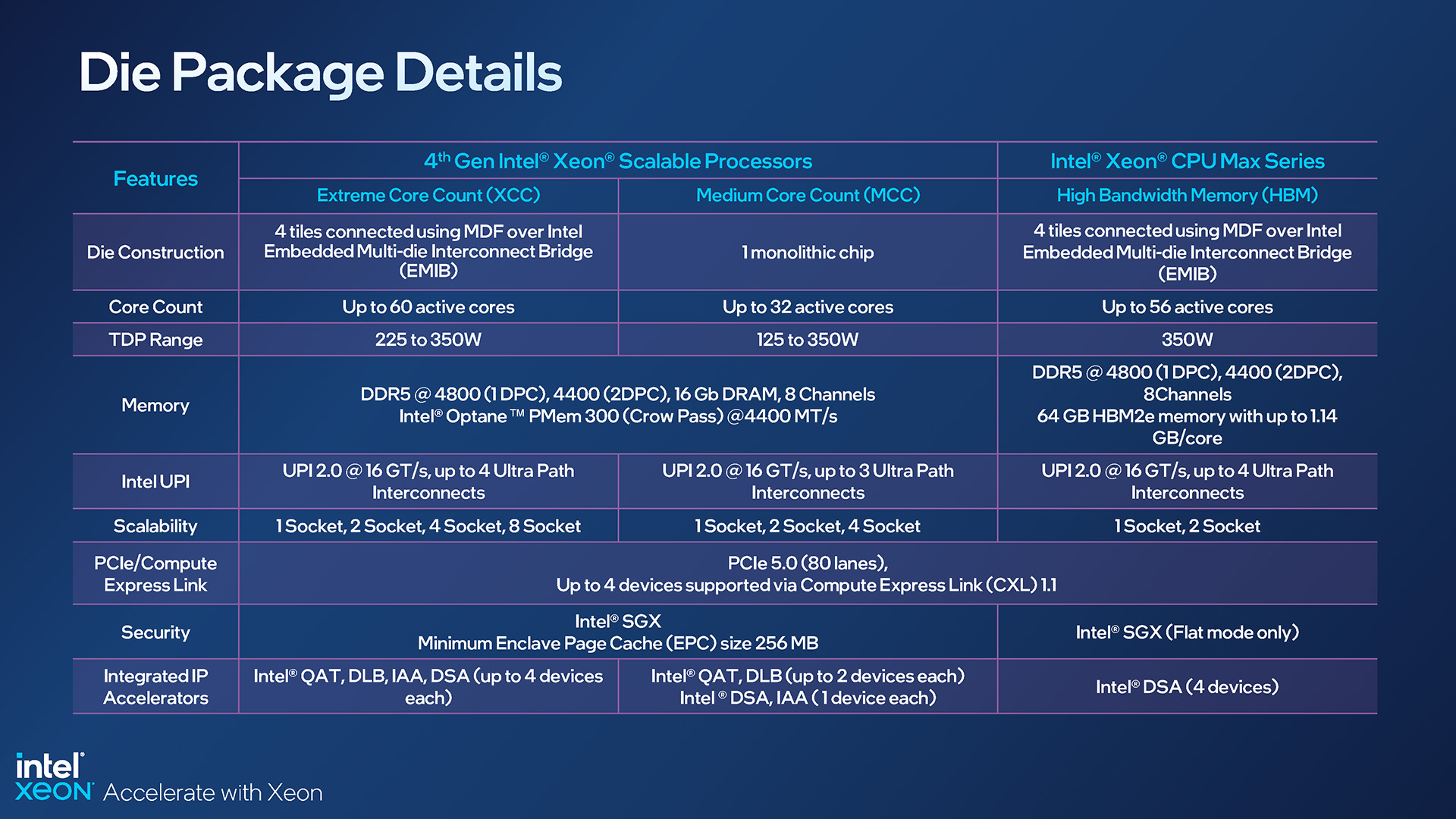

Ecco uno sguardo più dettagliato alle specifiche dichiarate per ciascuna configurazione della CPU:

Specifiche Intel Xeon di quarta generazione basate sul pacchetto

La diapositiva in alto aiuta a evidenziare un altro punto di vista che vale la pena guardare. Sulle CPU Max, molte delle funzionalità delle altre SKU sono scomparse, come la tecnologia QuickAssist di Intel, Dynamic Load Balancer e In-Memory Analytics Accelerator. Rimane il Data Streaming Accelerator, che mette in evidenza un pubblico mirato al laser per le CPU Max.

Quelle tecnologie non integrate in Max ci portano a un’altra differenza in questa gamma Xeon di ultima generazione. Potresti aver notato una nuova voce sopra,”Intel On Demand Capable”; questo si riferisce alle CPU che potrebbero essere acquistate senza tutte le funzionalità premium, ma abilitate successivamente tramite i partner di sistema e la stessa Intel.

Durante i briefing del mese scorso, l’argomento On Demand sembrava confondere molti, e persino oggi non riusciamo a comprendere appieno la meccanica. On Demand suona come un DLC per le CPU dei server, ma dovrebbe consentire ad alcuni di acquistare CPU a prezzi più equi a causa delle tecnologie non utilizzate, e i clienti avranno comunque la possibilità di invertire la rotta in un secondo momento.

Un altro punto di vista potrebbe essere essere che alcune delle tecnologie di Intel potrebbero non essere sfruttate adeguatamente in un ambiente di lavoro, ma se il supporto è costruito, On Demand può sbloccare la funzionalità da una CPU. Per quanto ne sappiamo, le CPU Xeon con funzioni bloccate non contribuiranno al carico energetico complessivo. Sono effettivamente dormienti fino a quando non vengono sbloccati e attivati.

Se fai riferimento al foglio SKU condiviso in precedenza, noterai che queste funzionalità interessate da On Demand possono variare notevolmente nel numero di dispositivi tra il bordo. Le SKU ottimizzate per il cloud, ad esempio, hanno pochi dispositivi DSA, QAT, DLB e IAA, mentre l’8490H di fascia alta ne ha molti. A seconda del carico di lavoro che stai cercando, potresti sentirti costretto a scegliere il modello che sceglierai.

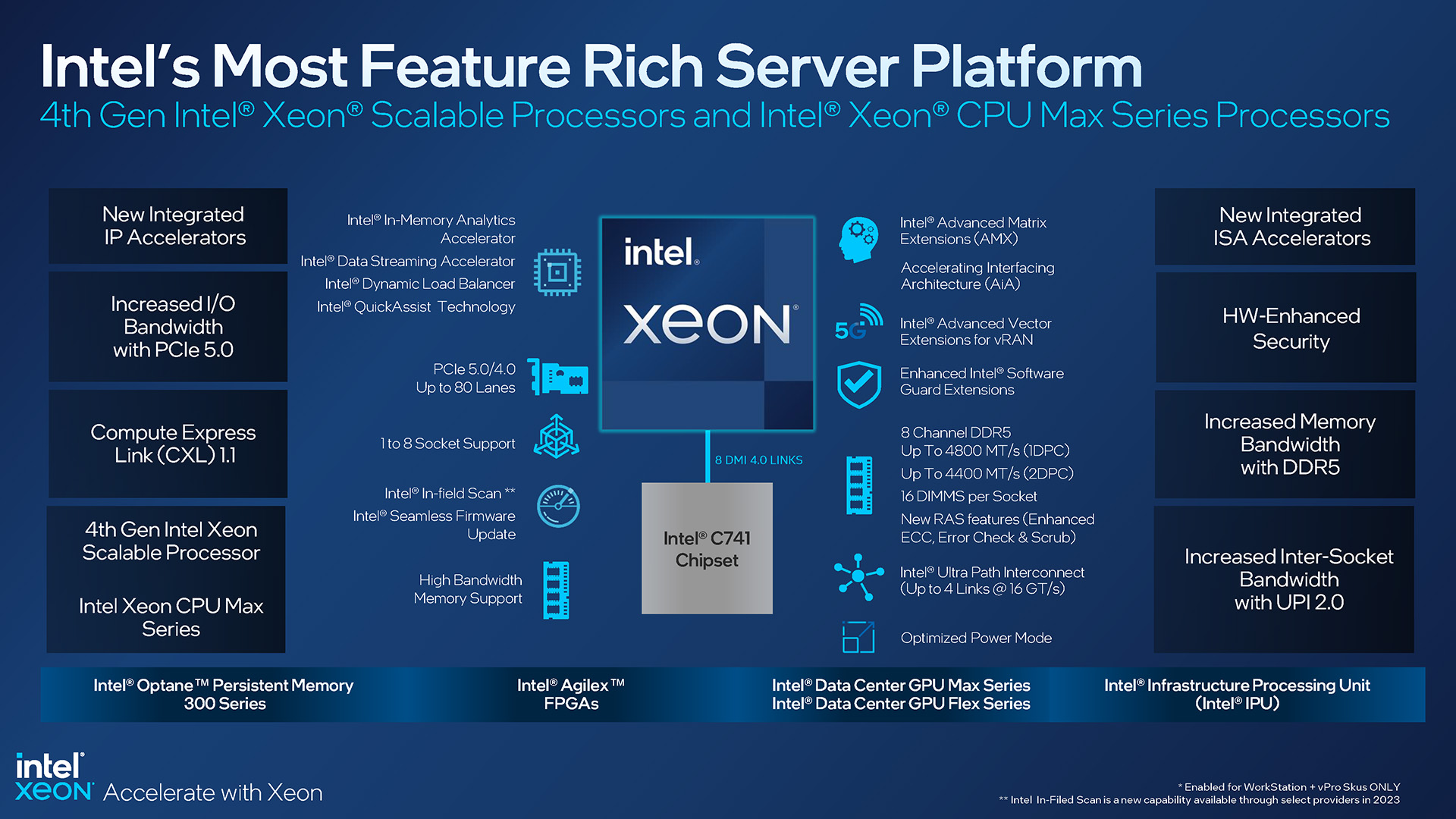

Ecco una panoramica delle funzionalità di Sapphire Rapids (ehm, Xeon di quarta generazione), che aiuta a coprire le cose che devo ancora:

Caratteristiche della piattaforma Intel Xeon di quarta generazione

Questa piattaforma Xeon di ultima generazione supporta sia PCIe 5.0 che 4.0, nonché DDR5 con frequenze fino a 4800 MHz. Come prima, questa piattaforma ha un controller di memoria a 8 canali e, in ultima analisi, supporta fino a 16 DIMM per socket.

Vale la pena notare che Intel continua a supportare i suoi sistemi a 4 e 8 socket, il che è interessante considerando il suo principale concorrente, AMD EPYC, raggiunge picchi con configurazioni a 2 socket. Intel afferma di vedere ancora la domanda per questi server con molte CPU, in particolare per il lavoro di intelligence del database in memoria, data warehousing e visualizzazione, consolidamento DC e così via.

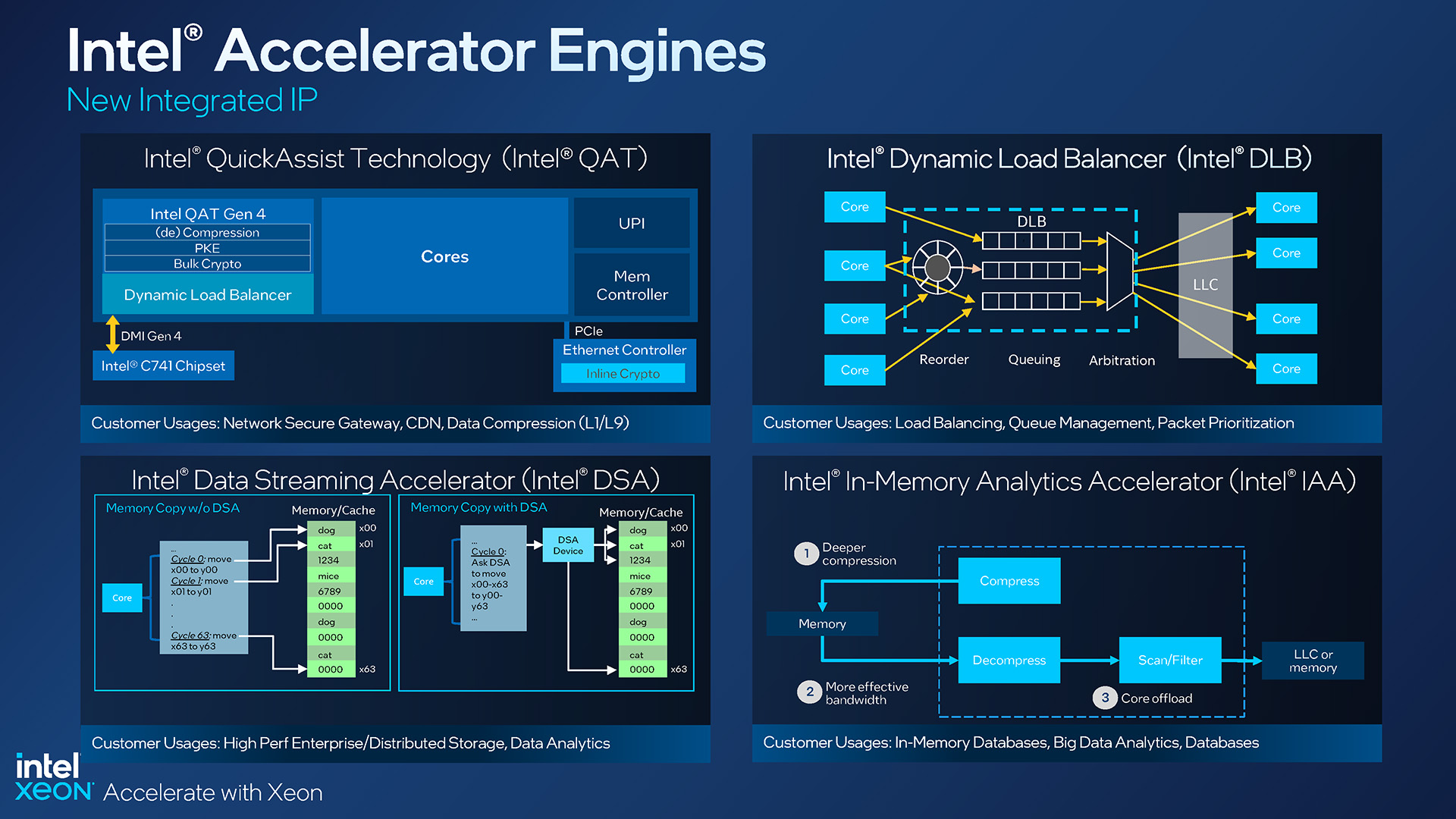

Motori di accelerazione Xeon di quarta generazione di Intel

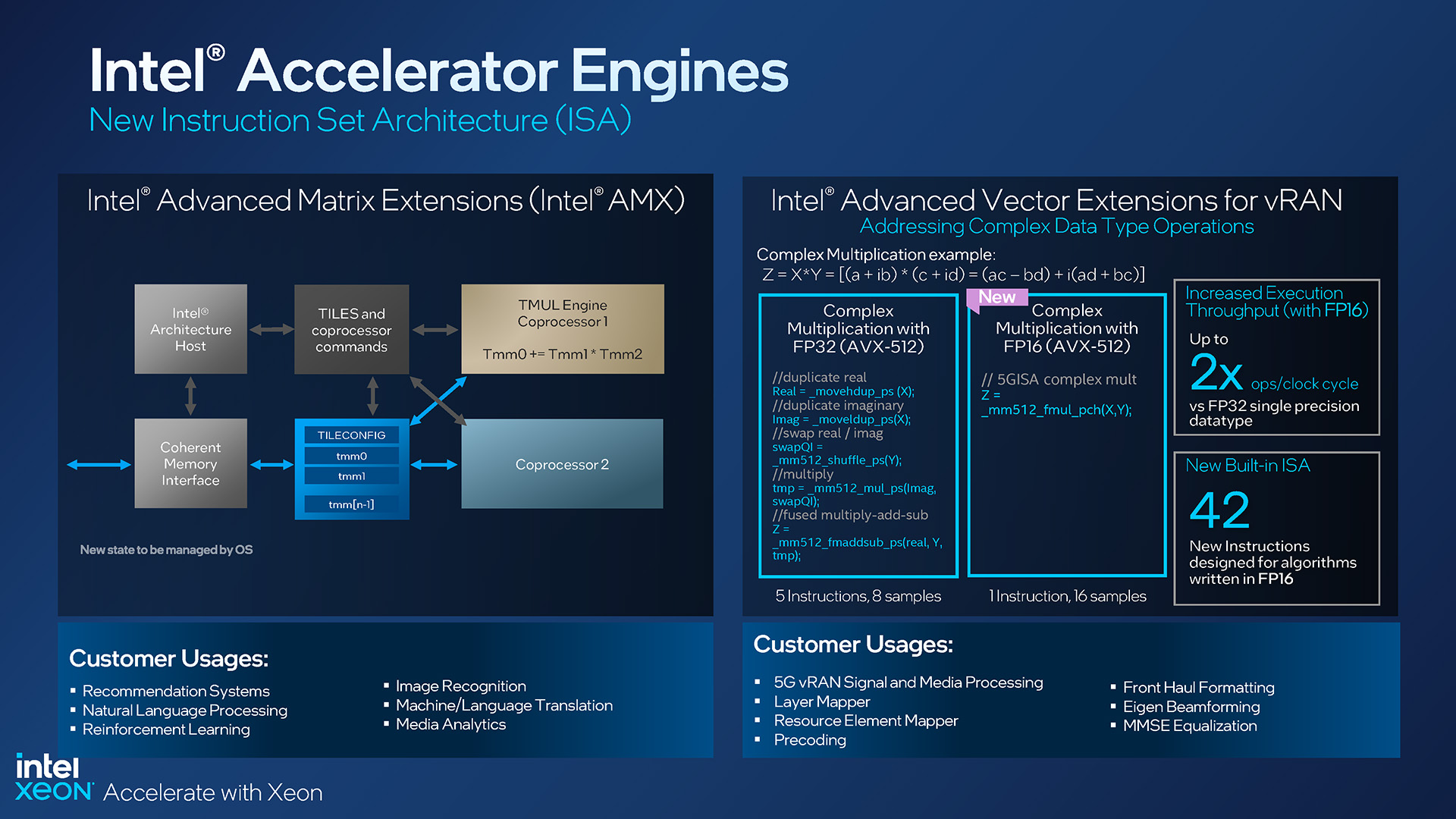

All’inizio , abbiamo accennato al fatto che i processori Xeon di quarta generazione includono acceleratori che potrebbero (o più precisamente, probabilmente richiederanno) aggiornamenti per trarne il massimo vantaggio. Sebbene molti processori Xeon Scalable e Max di quarta generazione offrano diversi livelli di supporto DSA/QAT/DLB/IAA, tutti includono il nuovissimo acceleratore a matrice AMX, l’ultimo concorrente dell’ISA (Instruction Set Architecture) di Intel.

Intel ama l’intelligenza artificiale e, per quanto riguarda le CPU Xeon, se ne parla da un po’. Ma in un momento in cui le GPU sono così veloci con molti carichi di lavoro IA, cosa spinge Intel a voler implementare qui una soluzione come AMX? Per cominciare, dove anche la CPU stessa partecipa pesantemente a un carico di lavoro AI, avere AMX proprio accanto ai core può offrire grandi prestazioni, forse abbastanza da non aver nemmeno bisogno di GPU discrete installate, a seconda del carico di lavoro complessivo.

Intel afferma che il suo AMX è circa otto volte più veloce nel calcolo dell’algebra lineare rispetto al suo motore vettoriale e i clienti target includono quei sistemi operativi di raccomandazione, riconoscimento delle immagini, elaborazione del linguaggio naturale e così via.

Estensioni Intel Xeon AMX e vRAN di quarta generazione

vRAN è stato anche integrato con alcuni aggiornamenti AVX, con l’aggiunta di 42 nuove istruzioni che sfruttano gli algoritmi scritti in FP16, con utilizzi qui mirati all’elaborazione di segnali e media, alla formattazione front-haul e alla mappatura dei livelli.

L’accelerazione sembra davvero essere il nome del gioco con Sapphire Rapids. Sono stati implementati più acceleratori per ridurre il carico sulla CPU stessa, ottenendo in definitiva più risultati nello stesso lasso di tempo.

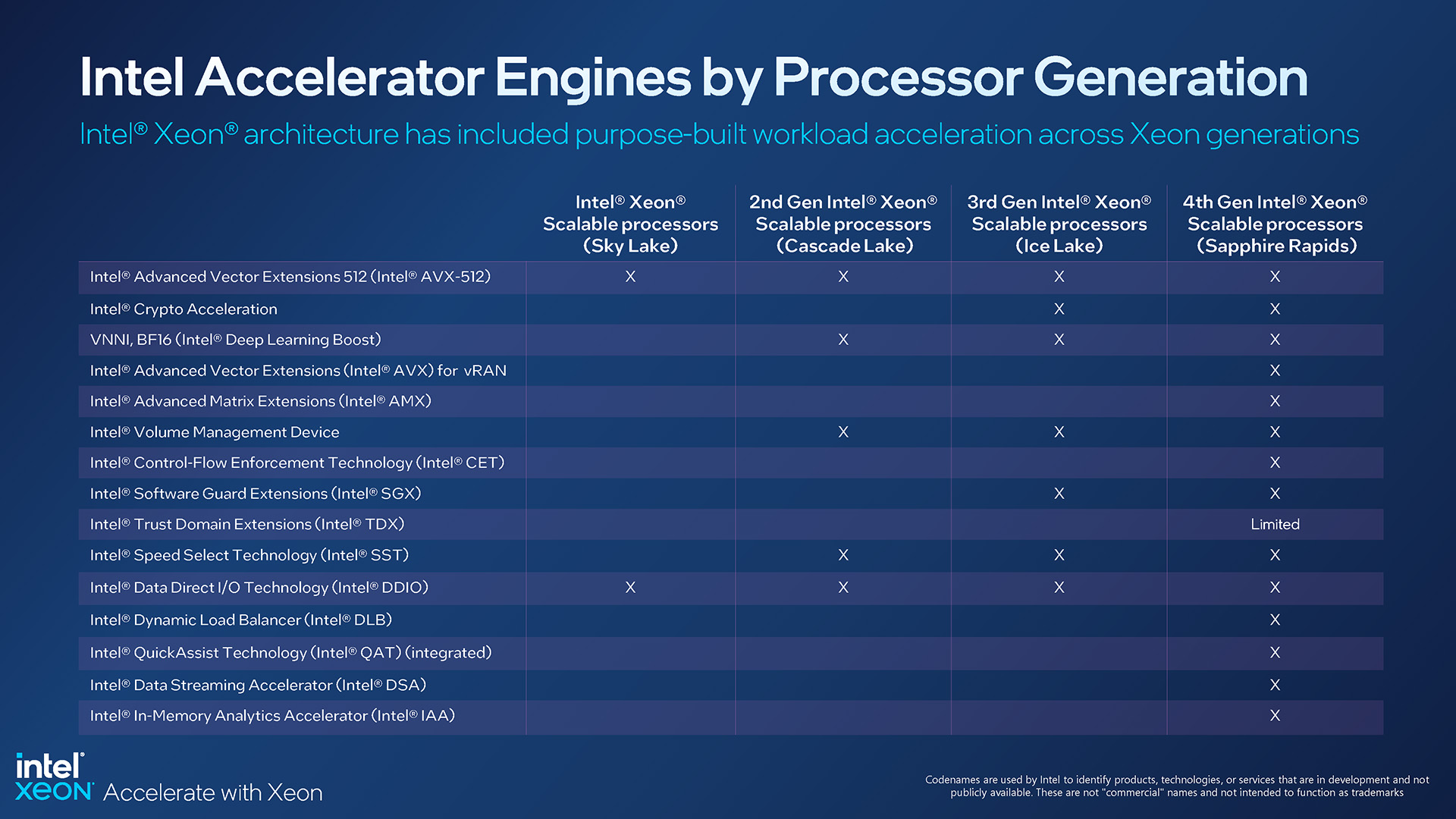

Motori di accelerazione per ogni generazione Xeon Scalable

Fortunatamente, sebbene alcune funzioni di accelerazione siano assenti in Xeon SKU, AMX sta diventando uno standard de facto. Questo è importante, poiché sappiamo che molti fornitori di software dovranno aggiornare i propri bit per trarne il massimo vantaggio.

Il supporto per tutti potrebbe non arrivare così rapidamente come vorremmo vederlo, ma poiché AMX è uno standard, significa che gli sviluppatori possono sentirsi al sicuro dedicando tempo allo sviluppo attorno ad esso. È una vendita più difficile quando una nuova fantastica funzionalità ha un supporto limitato in tutta la gamma. In particolare, sia TensorFlow che PyTorch hanno il supporto AMX integrato, quindi sembra che siamo partiti bene.

Inoltre, tutti questi motori di accelerazione condividono uno spazio di memoria coerente e condiviso tra i core e gli acceleratori , evidenziando ancora una volta gli sforzi di Intel per fornire un’architettura il più efficiente possibile, con colli di bottiglia minimi.

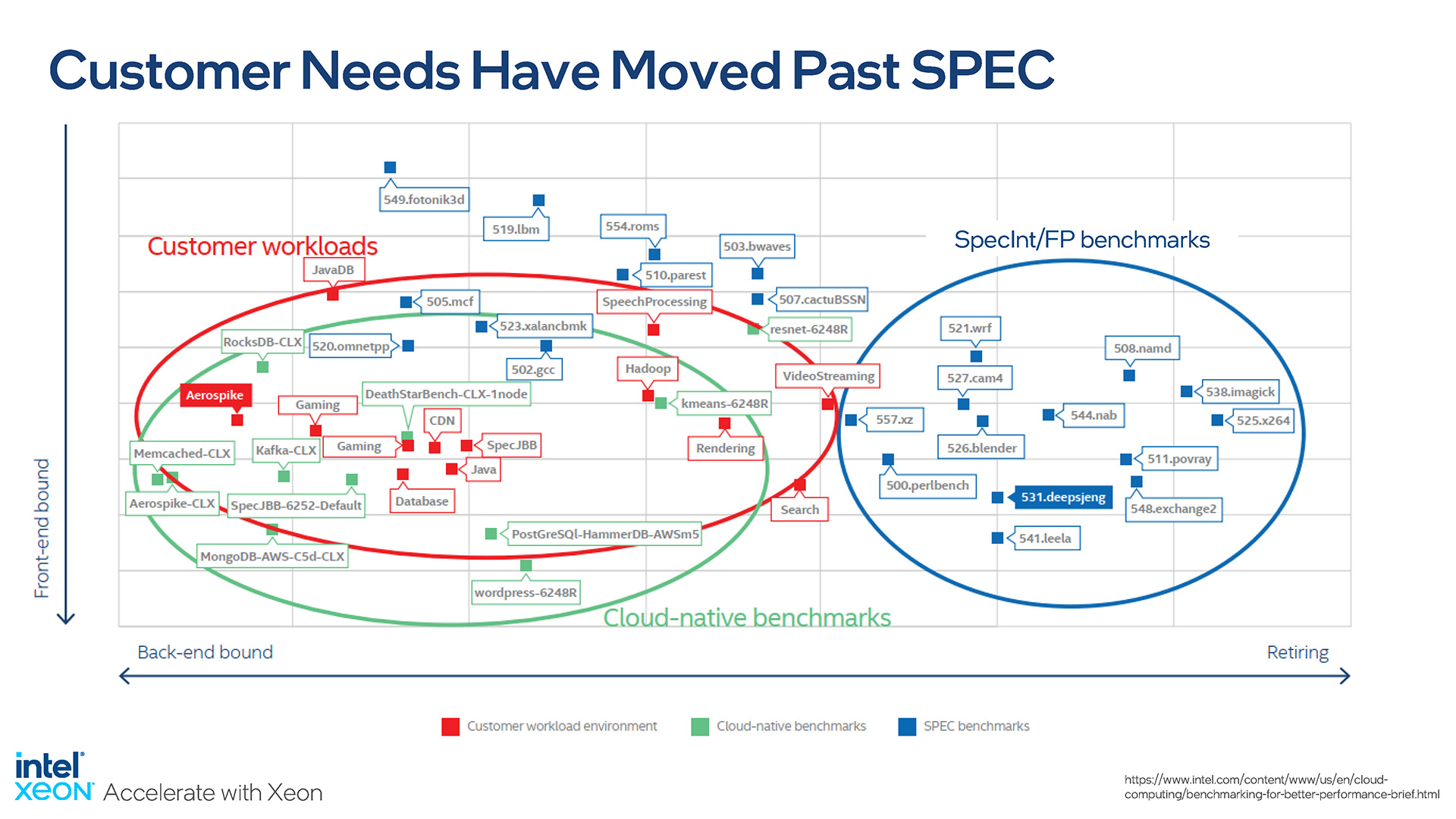

Parlando di prestazioni, Ronak Singhal, Intel Senior Fellow, ci ha davvero parlato con la sua presentazione, sottolineando quanto sia importante per confrontare i processori con test pertinenti. I benchmark predefiniti e preimpostati hanno il loro scopo, ma alla fine ciò che conta per i clienti è come la nuova piattaforma influisce sul loro carico di lavoro specifico.

Questa diapositiva dice tutto:

Intel sottolinea l’importanza del mondo reale test delle prestazioni

SPEC è un consorzio che coinvolge la maggior parte dei maggiori attori del settore dei semiconduttori, quindi i benchmark rilasciati tendono a essere concordati da tutti: non ci saranno pregiudizi intrinseci nei test. Tuttavia, questi test sono rigidi e i loro risultati non rifletteranno la maggior parte dei carichi di lavoro. La stessa Intel ha collaborato con i clienti per valutare quanto la maggior parte dei benchmark fosse disconnessa dagli scenari reali, sottolineando così la necessità di testare con benchmark pertinenti.

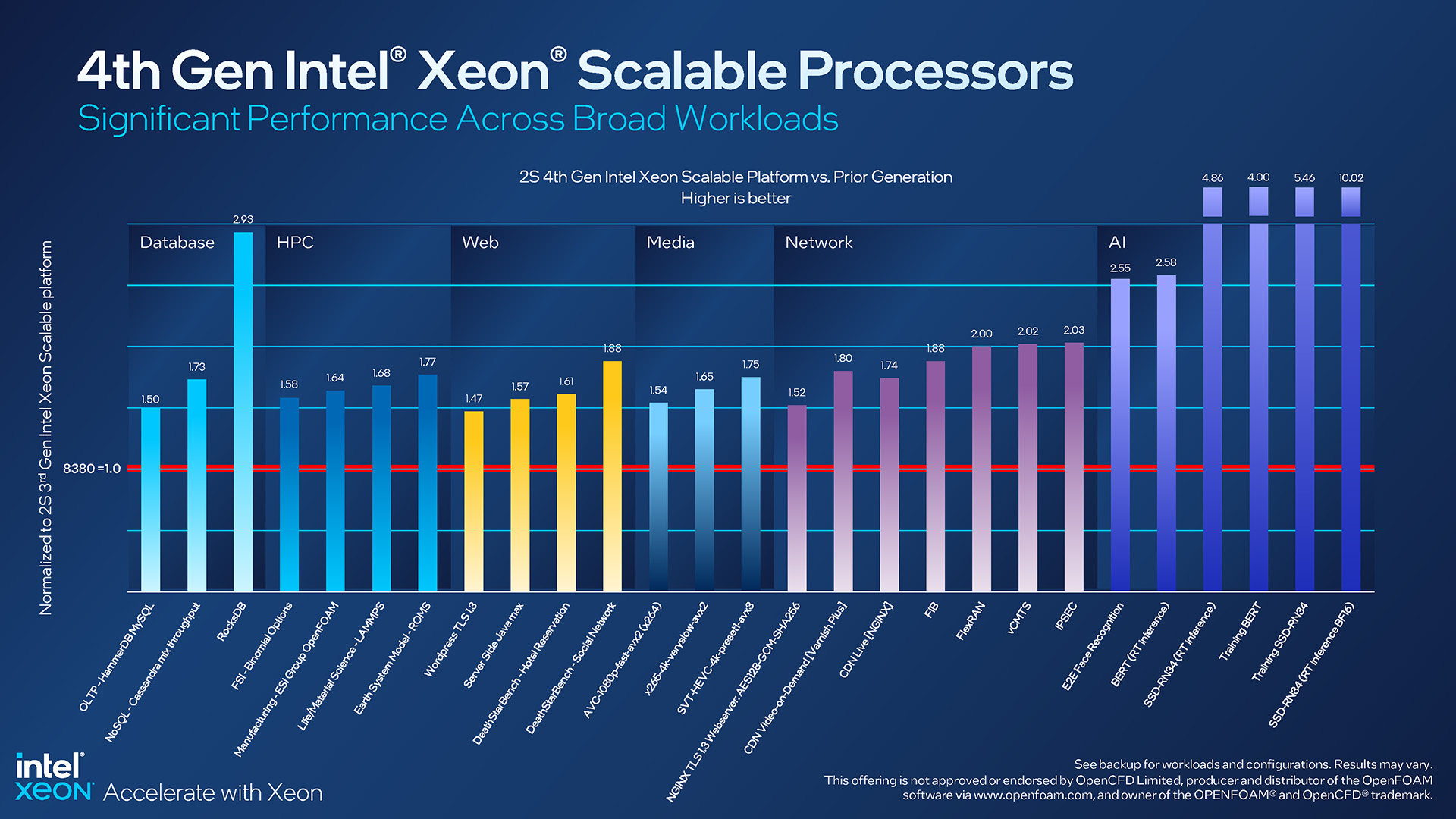

A tal fine, in più test del mondo reale, Sapphire Rapids si comporta bene bene rispetto allo Xeon 8380 di fascia alta della precedente generazione:

Aspettative sulle prestazioni di Intel Xeon di quarta generazione

I miglioramenti delle prestazioni osservati su tutta la linea sono fantastici da vedere, ma ovviamente alcuni di questi risultati si distinguono più di gli altri. Quello di RocksDB in particolare è interessante, in quanto evidenzia i vantaggi con l’acceleratore di analisi in memoria aggiornato di Intel. Ma anche i guadagni modesti rimangono impressionanti, ad esempio con un miglioramento delle prestazioni di WordPress di circa il 50% durante l’utilizzo di TLS.

Non riusciamo a trovarne menzione esplicita, ma dobbiamo immaginare tutti i carichi di lavoro dell’IA sul lato destro di quella diapositiva hanno visto tali potenziamenti giganteschi grazie all’introduzione di AMX. Mentre le ultime quattro barre salgono tutte verso l’alto, il risultato dell’inferenza in tempo reale BF16, a circa 10 volte, spicca davvero.

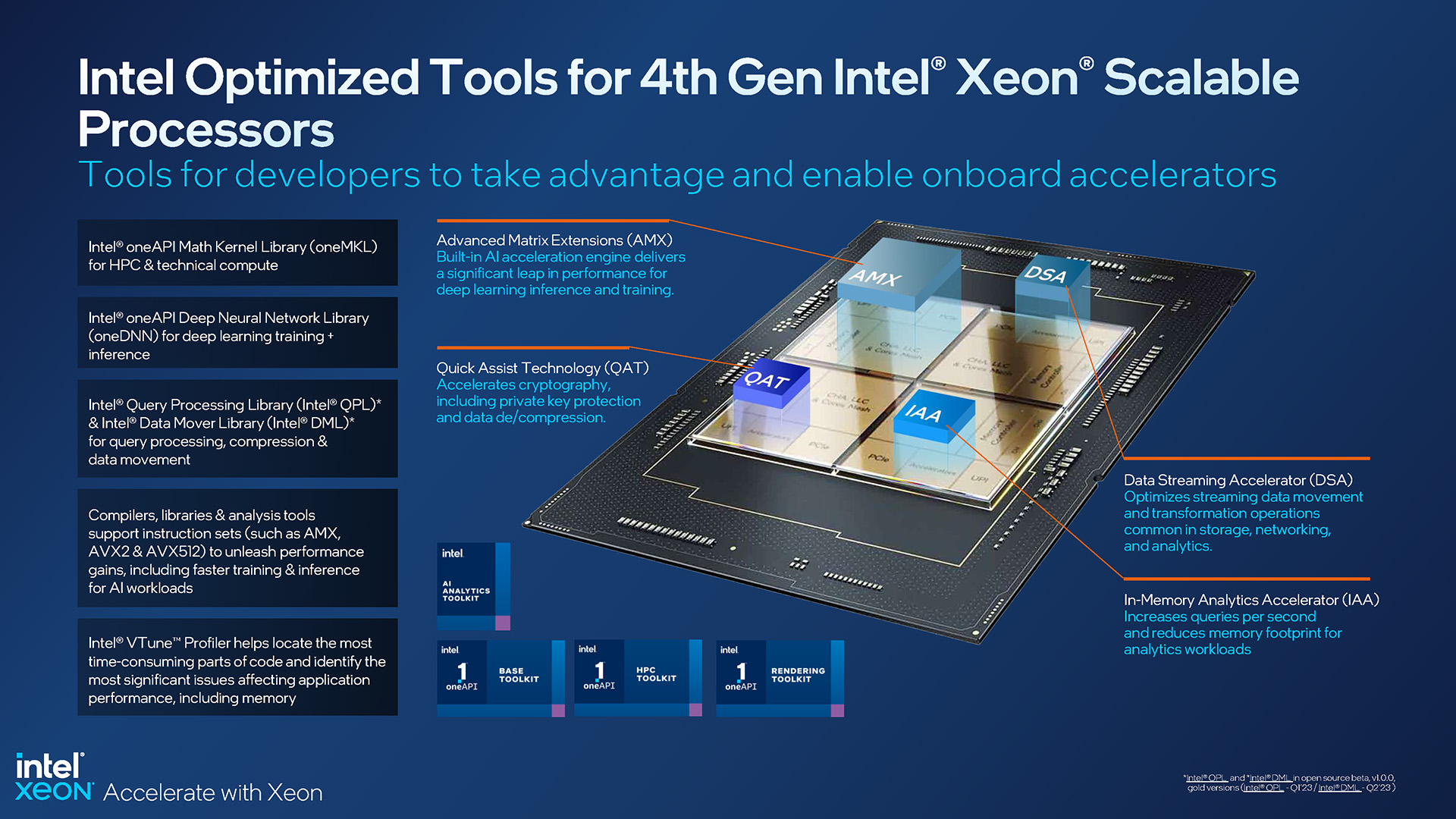

Gli strumenti ottimizzati aiutano a sfruttare al meglio i processori Intel Xeon Scalable e Max di quarta generazione

Perché Le CPU Intel hanno così tanto hardware unico che l’azienda fa di tutto per assicurarsi che tutti abbiano gli strumenti e le informazioni giusti per il lavoro. OneAPI di Intel viene continuamente aggiornata, così come molti altri strumenti, come oneDNN, QPL e DML. Anche la documentazione viene spesso aggiornata.

Allo stesso modo, Intel sa anche che per consentire ai clienti di sfruttare al meglio le sue funzionalità di intelligenza artificiale, dovrebbero essere forniti degli esempi. Questo è il motivo per cui l’azienda offre dozzine di modelli di intelligenza artificiale preaddestrati, che le persone possono integrare direttamente nei loro progetti o da cui imparare.

Durante una presentazione, Intel ha notato che solo il 53% dei progetti di intelligenza artificiale viene espulso-spento e finiscono per vedere il completamento, che è un tasso di fallimento piuttosto massiccio. Con soluzioni come oneAPI, che possono attingere potenza di elaborazione dalla CPU o dagli acceleratori integrati, l’obiettivo è assicurarsi che gli utenti possano eseguire i propri calcoli nel modo più efficace possibile. Con il tempo, si spera che il numero aumenti del 53%.

Considerazioni finali

Intel ha divulgato molte informazioni sulla sua gamma Xeon Scalable e Max di quarta generazione e, alla fine, noi ho appena scalfito la superficie qui, nonostante siano state discusse così tante buone informazioni. Allontanandosi dai briefing di persona il mese scorso, è diventato chiaro che questo lancio è caro al cuore di Intel, ed è per una buona ragione. Qui c’è molto di nuovo e intrigante.

Come sempre, Intel offre molte opzioni: indipendentemente dal tuo caso d’uso, troverai sicuramente una CPU adatta alle tue esigenze. In basso, c’è un 3408U a 8 core per uso generico in una piattaforma a 1 socket, e in cima c’è il colosso 8490H a 60 core che può essere utilizzato nei sistemi a 8 socket.

Vantaggi in termini di prestazioni per Sapphire Rapids di Intel rispetto alla generazione precedente

Certo, è la serie Xeon Max che ci ha maggiormente incuriosito. Avere 64 GB di memoria superveloce incorporata direttamente nella CPU potrebbe essere un vantaggio per determinati carichi di lavoro, e in particolare scenari in cui semplicemente non è necessaria molta memoria. Il fatto che un server Xeon Max possa avviarsi e funzionare normalmente senza un singolo DIMM installato non è solo impressionante, ma utile.

Il modo in cui Sapphire Rapids alla fine si distinguerà dalla concorrenza richiederà un benchmark esaustivo da parte di altri da capire, e siamo sicuri che ci saranno molte prestazioni in arrivo. Detto questo, non siamo del tutto sicuri che le prestazioni di lancio dipingeranno il quadro più accurato, perché alcuni tratti del design di Sapphire Rapids richiederanno aggiornamenti software. Abbiamo già discusso del fatto che PyTorch e TensorFlow supportino immediatamente AMX, ma c’è molto altro software mirato all’intelligenza artificiale là fuori.

In definitiva, siamo solo felici di vedere il lancio di Sapphire Rapids , poiché è passato molto tempo e siamo anche lieti che ci sia stato così tanto interesse di cui parlare. Come per tutto ciò che riguarda i server, il flusso di nuovi prodotti nell’ecosistema sarà lento, quindi sarà interessante vedere come stanno le cose a metà e più avanti nel corso dell’anno.

Sostieni i nostri sforzi! Con le entrate pubblicitarie ai minimi storici per i siti web scritti, ci affidiamo più che mai al supporto dei lettori per aiutarci a continuare a impegnarci così tanto in questo tipo di contenuto. Puoi sostenerci diventando un mecenate o utilizzando i nostri link di affiliazione per lo shopping Amazon elencati nei nostri articoli. Grazie per il tuo supporto!