Perché l’IA generativa è così complicata ora?

L’IA generativa come Bing Ai, ChatGPT e altre sono recentemente venute alla ribalta per l’utilizzo di algoritmi avanzati per generare nuovi dati, elementi visivi e altro ancora che sembrano, si sentono e si leggono come se fossero prodotti da esseri umani. I Generative Adversarial Network (GAN) sono ideali per la creazione di contenuti visivi, mentre i modelli di linguaggio Generative Pre-Trained (GPT) analizzano i dati già disponibili su Internet (o altri set di dati proprietari forniti) per generare un output come una risposta a una query, fino alla produzione di interi articoli”nuovi”. L’uso dell’IA per questi aspetti non è una novità, ma le scoperte nel modo in cui comprende queste query e produce un output molto più utilizzabile, leggibile e riconoscibile per l’utente medio sono ciò che rende l’IA generativa uno strumento potente.

Le preoccupazioni sono, ovviamente, controverso e abbondante, ma siamo ancora agli inizi. Tuttavia, la tecnologia è l’ideale per creare più dati per addestrare e migliorare i vari modelli in grado di seguire rapidamente diverse attività umili o banali che richiedono una qualche forma di inferenza per fare il prossimo miglior passo in avanti, e persino rendere le auto completamente automobilistiche una realtà, dove un modello di simulazione di guida automobilistica viene continuamente addestrato attraverso infinite varietà di nuovi dati ambientali generati e addestrati virtualmente, costruendo così un modello pre-addestrato sempre più solido.

Ecco altre letture su questo argomento dalla società di consulenza globale McKinsey & Company per ulteriori approfondimenti e varie industrie che trarranno vantaggio dall’IA generativa.

(E no, questo articolo non è stato agitato con l’IA generativa.)

Inserisci NVIDIA AI Foundations: consentire alle aziende di creare modelli di AI generativa personalizzati interni

Quindi, ora che sappiamo perché l’IA generativa è così preziosa e importante, questo ci porta alla grande spinta di NVIDIA per supportare le aziende con servizi cloud per creare i propri modelli di linguaggio di grandi dimensioni personalizzati (LLM, di cui ChatGPT è un ottimo esempio) e la generazione visiva modelli per applicazioni AI. Più specificamente, questi modelli di IA generativi personalizzati vengono sviluppati e addestrati con i dati proprietari dell’azienda per le loro esclusive offerte specifiche del dominio.

Ciò è reso possibile con NVIDIA AI Foundations, che è un insieme di servizi cloud per consentire alle aziende di creare, perfezionare e gestire tali LLM e modelli generativi di intelligenza artificiale.

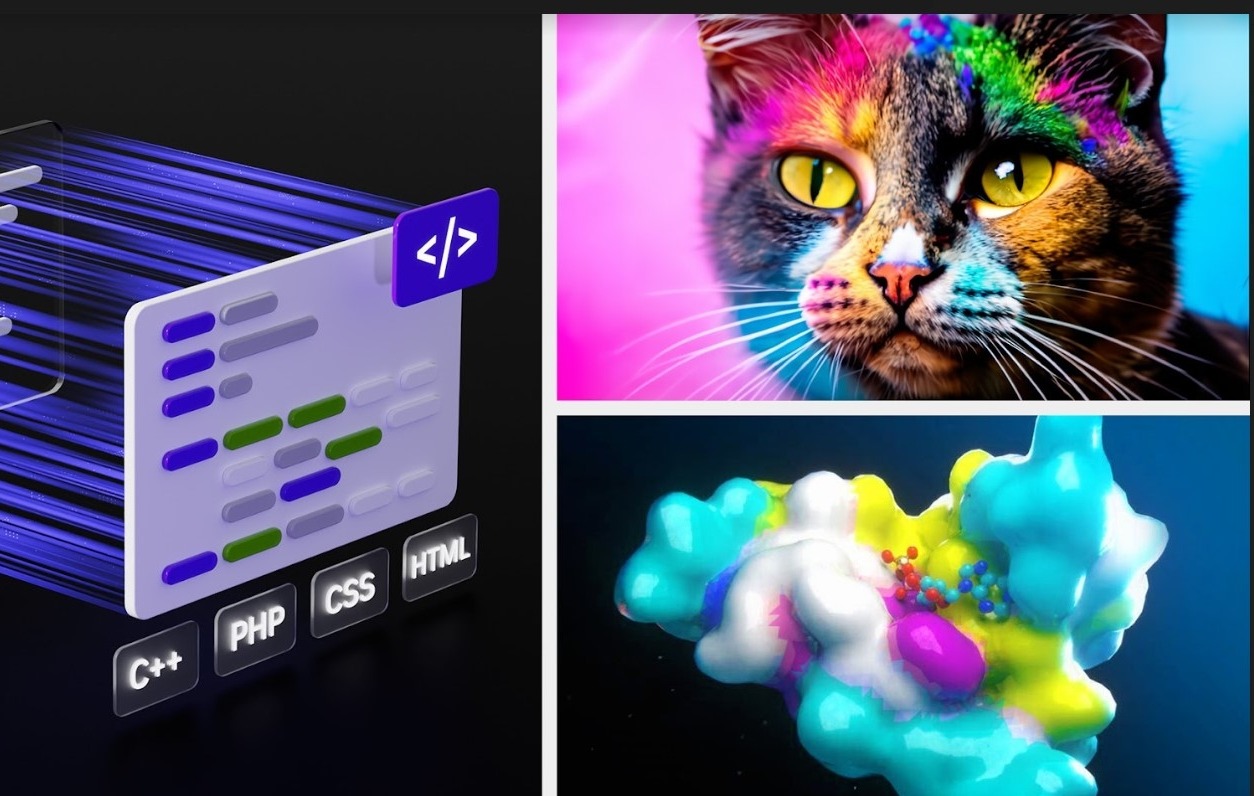

Il servizio cloud NVIDIA NeMo consente agli sviluppatori di rendere i modelli di linguaggio di grandi dimensioni (LLM) più pertinenti per le aziende definendo le aree di interesse, aggiungendo conoscenze specifiche del dominio e insegnando competenze funzionali.

NVIDIA Picasso è un servizio cloud per la creazione e l’implementazione di applicazioni generative di immagini, video e 3D basate sull’intelligenza artificiale con funzionalità avanzate di text-to-image, text-to-video e text-to-3D per potenziare la produttività per la creatività, il design e la simulazione digitale attraverso semplici API cloud.

NVIDIA BioNeMo è un nuovo servizio cloud che ha debuttato oggi per accelerare la ricerca nelle scienze della vita, la scoperta di farmaci, l’ingegneria delle proteine e la ricerca nei campi della genomica, della biologia, della chimica e della dinamica modulare.

Questi servizi vengono eseguiti su NVIDIA DGX Cloud, accessibile tramite un browser. Sono attualmente disponibili per i clienti con accesso anticipato e sono nella fase di anteprima privata. Gli sviluppatori possono utilizzare questi modelli offerti su ciascun servizio tramite API semplici e quando i modelli sono pronti per l’implementazione, le aziende possono eseguire carichi di lavoro di inferenza su larga scala utilizzando i servizi cloud NVIDIA AI Foundations.

I leader del settore collaborano con NVIDIA per produttività avanzata per i professionisti creativi

Adobe ha annunciato oggi che amplierà la sua partnership di ricerca e sviluppo di lunga data per creare i modelli di intelligenza artificiale generativa di prossima generazione con NVIDIA. Per accelerare i flussi di lavoro di creatori e operatori di marketing, alcuni di questi modelli saranno sviluppati congiuntamente e introdotti sul mercato tramite i prodotti di punta di Adobe Creative Cloud come Photoshop, Premiere Pro e After Effects, nonché tramite NVIDIA Picasso.

NVIDIA e Getty Images stanno collaborando per formare modelli di base generativi responsabili da testo a immagine e testo a video. I modelli consentiranno la creazione di immagini e video utilizzando semplici istruzioni di testo e saranno addestrati sulle risorse con licenza completa di Getty Images.

NVIDIA e Shutterstock stanno collaborando per addestrare un testo generativo-to-3D foundation model utilizzando il servizio NVIDIA Picasso per semplificare la creazione di modelli 3D dettagliati e ridurre il tempo necessario per creare modelli 3D da giorni a minuti.

Le nuove GPU alimentano le piattaforme di inferenza per affrontare varie IA generativa carichi di lavoro

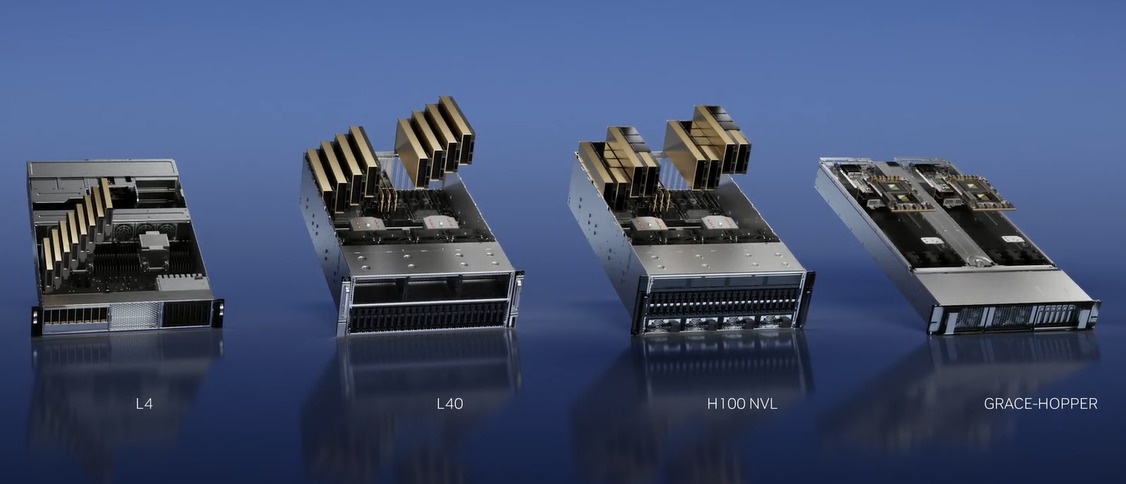

Per aumentare la spinta di NVIDIA a contribuire alla creazione di modelli IA generativi personalizzati nuovi ed emergenti tramite i servizi cloud NVIDIA Foundation, hanno anche lanciato una serie di nuove GPU e piattaforme per aiutare gli sviluppatori a creare e potenziare queste nuove applicazioni IA basate su NVIDIA Ada Lovelace, Processori Hopper e Grace Hopper.

L’ascesa dell’IA generativa richiede un’inferenza più potente e piattaforme informatiche. Il numero di applicazioni per l’IA generativa è infinito, limitato solo dall’immaginazione umana. Fornire agli sviluppatori la piattaforma di calcolo inferenziale più potente e flessibile accelererà la creazione di nuovi servizi che miglioreranno le nostre vite in modi non ancora immaginabili. – Jensen Huang, fondatore e CEO di NVIDIA.

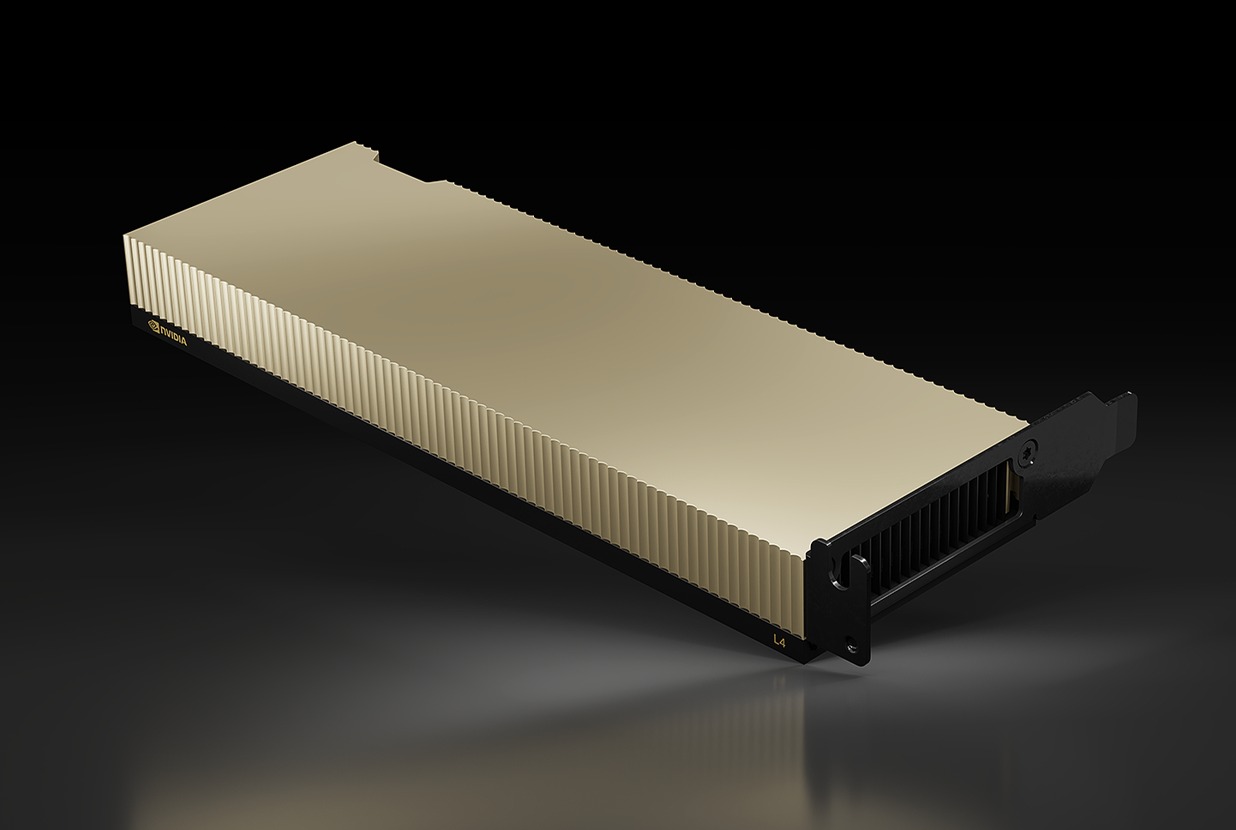

1) NVIDIA L4 per video AI

Il nuovo NVIDIA L4 è il sostituto diretto della popolare GPU T4, che è stata la prima a utilizzare Tensor Core e progettato espressamente per carichi di lavoro di inferenza AI per analizzare nuovi input di dati per prevedere e stimare un risultato desiderato sulla base di modelli preaddestrati.

Il T4 è stato alimentato dalla microarchitettura Turing, che è stata la prima a supportare e accelerare i carichi di lavoro con ray tracing. Il nuovo L4, basato sull’architettura GPU Ada Lovelace (questo è ciò che alimenta la serie GeForce RTX 40) che supporta DLSS 3 basato su AI, è valutato per offrire una velocità superiore a 4 volte nelle prestazioni di rendering in tempo reale su Omniverse ed è in grado di offrire Prestazioni di ray-tracing 3 volte superiori.

Con questo throughput migliorato, la GPU L4 è posizionata per i carichi di lavoro video AI per affrontare la decodifica video in tempo reale, la transcodifica, la moderazione dei contenuti video, la traduzione linguistica, le funzionalità di miglioramento delle videochiamate come come sostituzione dello sfondo, riilluminazione, contatto visivo, realtà aumentata e altro ancora. I doppi encoder AV1 della nuova GPU sono anche ottimi motivi per cui l’L4 è l’ideale per queste attività video AI. Infatti, un singolo server L4 a 8 GPU può sostituire oltre un centinaio di server CPU dual socket tradizionali nell’elaborazione di video AI. Si tratta di un enorme risparmio nel costo totale di proprietà rispetto alle infrastrutture meno recenti.

Ancora meglio, l’L4 è anche progettato con lo stesso fattore di forma a basso profilo e un involucro di potenza di 72 W leggermente inferiore, il che rende l’aggiornamento dell’alimentazione T4 esistente server con un L4 un gioco da ragazzi, migliorando al contempo l’abilità di inferenza AI con un buon margine.

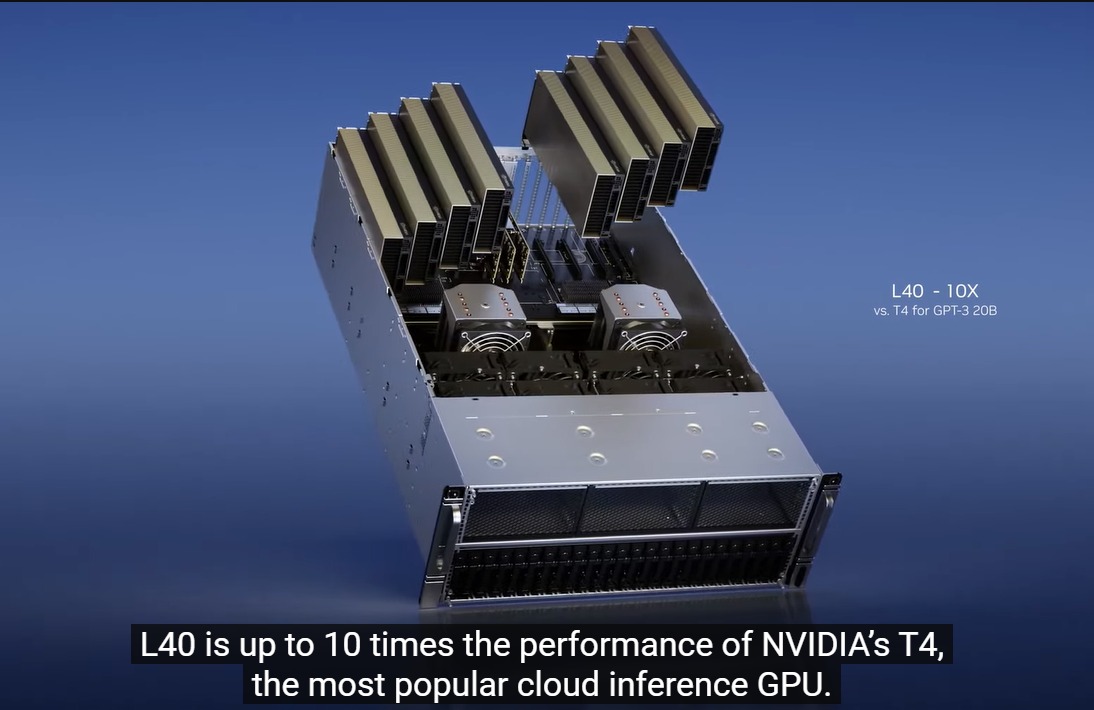

2) L40 per la generazione di immagini

L’L40 è stato effettivamente annunciato nel 2022, ma è stato solo di recente che ha visto un po’di azione. Basato sulla GPU Ada Lovelace RTX con oltre 18.000 core di elaborazione CUDA 142 RT Core, l’L40 offre un bel pugno in quanto queste specifiche lo collocano ben al di sopra di ciò che racchiude l’RTX 4090. Ma a differenza dell’RTX 4090 che è ottimizzato per alte velocità di clock, rasterizzazione e prestazioni ray-tracing con raffreddamento attivo e un budget energetico più elevato, l’L40 è un design raffreddato passivamente con un TDP di 300 W ed è pensato per sfruttare i percorsi del flusso d’aria progettati all’interno server rack.

Il L40 include anche 48 GB di memoria GDDR6 con ECC, perfetta per Omniverse Enterprise, rendering, grafica 3D, workstation virtuale NVIDIA RTX, formazione AI e scienza dei dati. In effetti, è la spina dorsale del server NVIDIA OVX pensato per la creazione di gemelli digitali Omniverse su larga scala.

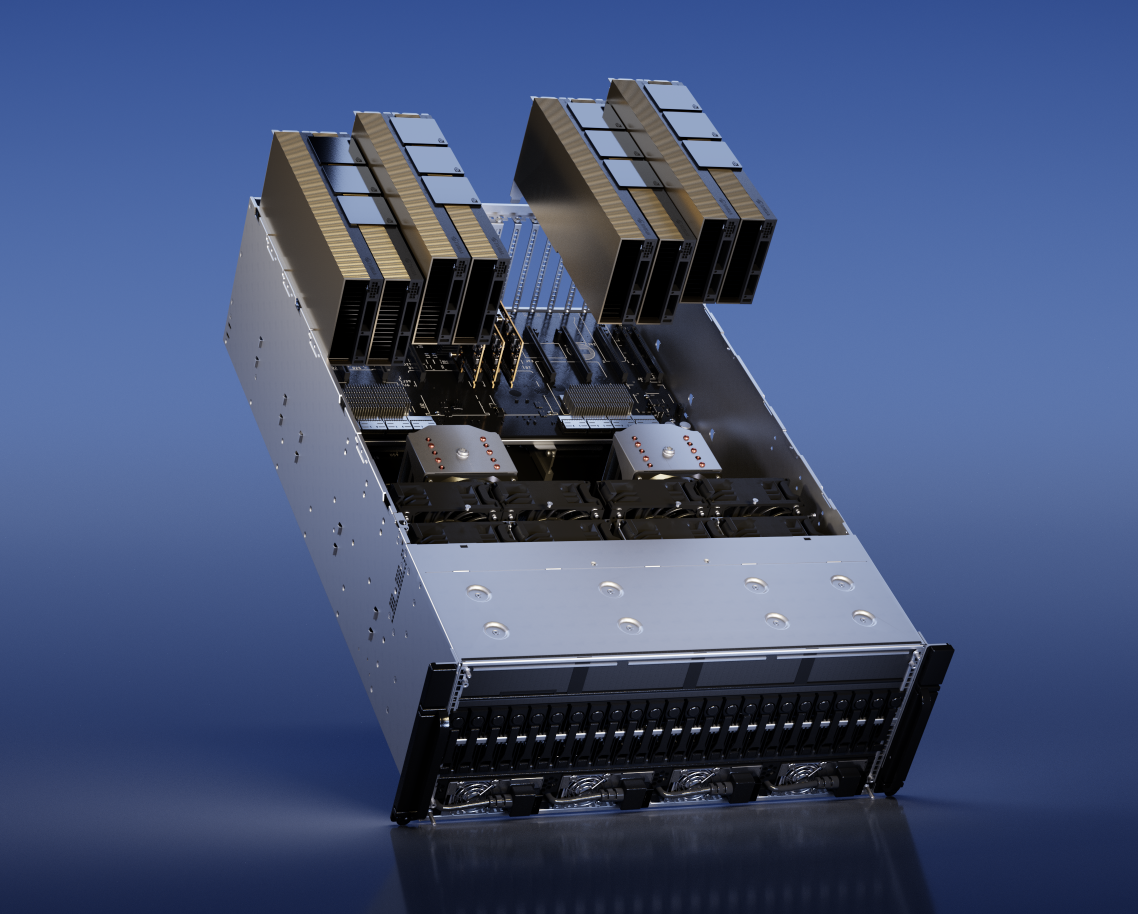

3) NVL H100 per l’implementazione LLM (Large Language Model)

L’architettura della GPU Hopper basata su H100 è un prodotto eccezionale focalizzato sui data center Accelerazione AI in quanto rinuncia ai core RT e integra un’interfaccia di memoria molto più veloce per connettersi con la memoria HBM. Per quanto veloce sia l’H100, NVIDIA è già consapevole che deve fare di più ora per essere il driver che alimenta servizi generativi di intelligenza artificiale come ChatGPT su larga scala. Al GTC 2023, NVIDIA ha annunciato la doppia scheda PCIe H100 NVL che sono NVLink tra loro. Per renderlo più ideale di due prodotti PCIe H100 esistenti (contengono 80 GB di memoria), i nuovi pacchetti H100 NVL in pacchetti da 94 GB ciascuno, per un totale complessivo di 188 GB di memoria grafica, con grafica da 7,8 TB/s Banda di memoria. Inoltre, la configurazione della GPU dell’H100NVL è identica alla SKU H100 SXM, quindi l’H100 NVL è molto più veloce dell’H100 PCIe, anche se quest’ultimo era dotato di NVLink.

Secondo NVIDIA, l’H100 Il server dotato di NVL (con quad H100 NVL) è oltre 10 volte più veloce di un server HGX A100 (otto H100 SXM) che elabora GPT-3. Si tratta di un aumento fenomenale nell’elaborazione del modello linguistico.

4) NVIDIA Grace Hopper per i modelli di raccomandazione