A meno che tu non sia stato in ritiro in un luogo remoto senza accesso a Internet negli ultimi mesi, è probabile che tu sia ben consapevole di quanto clamore e paura ci siano stati in giro ChatGPT, il chatbot di intelligenza artificiale (AI) sviluppato da OpenAI. Forse hai visto articoli su università e insegnanti preoccupandosi che sia Renderò l’imbroglio più facile che mai. Dall’altro lato della medaglia, potresti aver visto gli articoli che evangelizzano tutti i potenziali applicazioni.

In alternativa, potresti essere stato solleticato da alcuni degli esempi più esoterici di persone che utilizzano lo strumento. Un utente, ad esempio, è riuscito a scrivere una guida di istruzioni per rimuovere i panini al burro di arachidi da un videoregistratore nel style of the King James Bible. Un altro gli ha chiesto di scrivere una canzone nello stile di Nick Cave; il cantante era meno che entusiasta dei risultati.

Ma in mezzo a tutto quel clamore e discussione, non è stata prestata abbastanza attenzione ai rischi e ai benefici che gli strumenti di intelligenza artificiale come ChatGPT presente nell’arena della sicurezza informatica.

Comprendere ChatGPT

Per avere un’idea più chiara di quali sono questi rischi e vantaggi, è importante comprendere meglio cos’è ChatGPT e cosa è in grado di.

ChatGPT (ora nella sua ultima versione, ChatGPT-4, rilasciata il 14 marzo 2023) fa parte di una famiglia più ampia di strumenti di intelligenza artificiale sviluppati dalla società statunitense OpenAI. Sebbene sia ufficialmente chiamato chatbot, ciò non copre del tutto la sua versatilità. Formazione utilizzando sia il supervisionato che il rinforzo tecniche di apprendimento, può fare molto di più della maggior parte dei chatbot. Come parte delle sue risposte, può generare contenuti basati su tutte le informazioni su cui è stato addestrato. Tali informazioni includono conoscenze generali, linguaggi di programmazione e codice. Di conseguenza, può, ad esempio, simula un’intera chat room; giocare a giochi come il tris; e simulare un bancomat.

Ancora più importante, per le aziende e altre grandi organizzazioni, può aiutare a migliorare il servizio clienti delle aziende attraverso messaggi più personalizzati e accurati. Può persino scrivere ed eseguire il debug di programmi per computer. Alcune di queste e altre caratteristiche indicano che potrebbe essere sia un alleato della sicurezza informatica sia una minaccia.

Formazione, filtraggio e rafforzamento delle difese

On il fronte positivo, c’è molto da dire per ChatGPT. Uno dei ruoli più preziosi che potrebbe svolgere è anche uno dei più semplici: individuare il phishing. Le organizzazioni potrebbero radicare nei propri dipendenti l’abitudine di utilizzare ChatGPT per determinare se qualsiasi contenuto di cui non sono sicuri sia phishing o se sia stato generato con intenti dannosi.

Questo è importante perché, nonostante tutti i progressi tecnologici compiuti negli ultimi anni, gli attacchi di ingegneria sociale come il phishing rimangono una delle forme più efficaci di criminalità informatica. Infatti, la ricerca mostra che, degli attacchi informatici identificati con successo nel Regno Unito nel 2022, L’83% ha coinvolto qualche forma di phishing.

Naturalmente, ci sono numerosi altri modi in cui ChatGPT può essere utilizzato per rafforzare gli sforzi di sicurezza informatica. Potrebbe, ad esempio, fornire un certo grado di assistenza ai lavoratori della sicurezza più giovani, sia che si tratti di comunicare eventuali problemi che potrebbero avere o di aiutarli a comprendere meglio il contesto di ciò su cui dovrebbero lavorare in un dato momento. Potrebbe anche aiutare i team con risorse insufficienti a curare le minacce più recenti e a identificare le vulnerabilità interne.

Anche i malintenzionati lo usano

Ma anche come sicurezza informatica i professionisti esplorano i modi per utilizzare ChatGPT a proprio vantaggio, anche i criminali informatici lo fanno. Potrebbero, ad esempio, sfruttare la sua capacità di generare codice dannoso. In alternativa, potrebbero utilizzarlo per generare contenuti che sembrano essere generati dall’uomo, potenzialmente utilizzati per indurre gli utenti a fare clic su collegamenti dannosi, portando inconsapevolmente a conseguenze pericolose.

Alcuni utilizzano persino ChatGPT per imitare in modo convincente i legittimi assistenti di intelligenza artificiale sui siti Web aziendali, aprendo una nuova strada nel fronte della battaglia dell’ingegneria sociale. Ricorda, il successo dei criminali informatici dipende in gran parte dalla capacità di prendere di mira il maggior numero possibile di vulnerabilità, il più frequentemente e rapidamente possibile. Gli strumenti di intelligenza artificiale come ChatGPT consentono loro di farlo agendo essenzialmente come un assistente potenziato che può aiutare a creare tutte le risorse necessarie per le campagne dannose.

Utilizza gli strumenti disponibili

Dovrebbe essere chiaro quindi che, se i criminali informatici utilizzano ChatGPT e altri strumenti di intelligenza artificiale per potenziare i loro attacchi, anche il tuo team di sicurezza dovrebbe utilizzarli per rafforzare i tuoi sforzi di sicurezza informatica. Fortunatamente, non devi farlo da solo.

Il giusto fornitore di sicurezza non solo si impegnerà in una ricerca costante su come i criminali informatici utilizzano le ultime tecnologie per potenziare i loro attacchi, ma anche su come queste tecnologie possono essere utilizzato per migliorare il rilevamento, la prevenzione e la difesa delle minacce. E con il danno che un attacco di sicurezza informatica può causare alla tua infrastruttura critica, è qualcosa di cui anche loro dovrebbero parlarti in modo proattivo.

ChatGPT-4

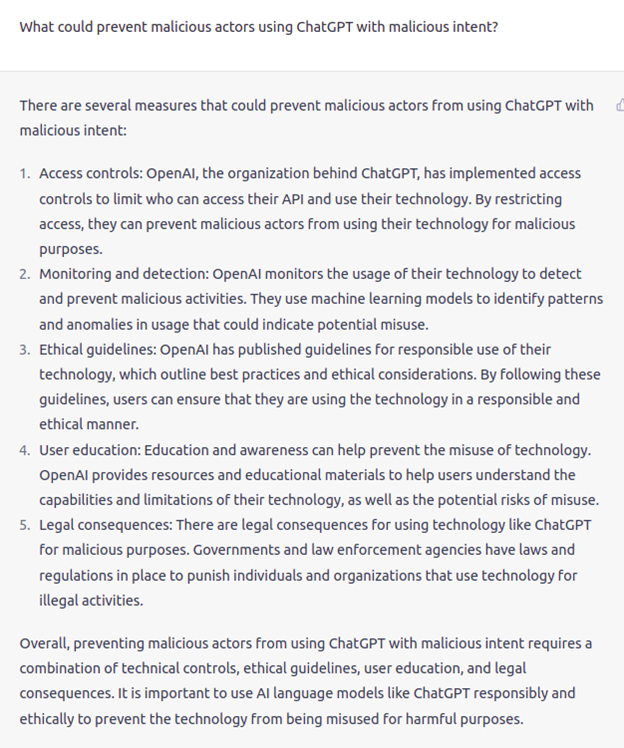

Con l’ultima release di ChatGPT (ChatGPT-4), OpenAI ha reso disponibile l’ultimo e più potente modello conversazionale, introducendo anche maggiori controlli per prevenirne l’uso improprio. Abbiamo chiesto a ChatGPT”Cosa potrebbe impedire agli attori malintenzionati di utilizzare ChatGPT con intenti dannosi”e questa è stata la risposta:

Quindi ChatGPT è andato avanti ed ha enumerato tutte le misure che OpenAI ha adottato per prevenirne l’uso improprio. OpenAI nel blog di rilascio di ChatGPT-4 ha spiegato come questo modello sia presumibilmente più sicuro dei suoi predecessori:”Abbiamo impiegato 6 mesi per realizzare GPT-4 più sicuro e più allineato. GPT-4 ha l’82% in meno di probabilità di rispondere alle richieste di contenuti non consentiti e il 40% in più di probabilità di produrre risposte fattuali rispetto a GPT-3.5 in base alle nostre valutazioni interne”.

Quindi tutto indica che le giuste misure continuano a essere migliorate per evitarne l’uso improprio, ma come tutti sappiamo i cattivi continueranno a trovare modi per superare tali limiti man mano che il modello è più ampiamente utilizzato e compreso.

Credito immagine: [email protetta]/depositphotos.com

JP Perez-Etchegoyen è CTO di Onapsis.