Nell’ecosistema dell’IA, i modelli di diffusione stanno determinando la direzione e il ritmo del progresso tecnologico. Stanno rivoluzionando il modo in cui affrontiamo complesse attività di intelligenza artificiale generativa. Questi modelli si basano sulla matematica dei principi gaussiani, sulla varianza, sulle equazioni differenziali e sulle sequenze generative. (Spiegheremo il gergo tecnico di seguito)

I moderni prodotti e soluzioni incentrati sull’intelligenza artificiale sviluppati da Nvidia, Google, Adobe e OpenAI hanno messo i modelli di diffusione al centro della ribalta. DALL.E 2, Diffusione Stabile a> e Midjourney sono esempi importanti di modelli di diffusione che stanno facendo il giro di Internet di recente. Gli utenti forniscono un semplice prompt di testo come input e questi modelli possono convertirli in immagini realistiche, come quella mostrata di seguito.

Un’immagine generata con Midjourney v5 utilizzando il prompt di input: vibranti papaveri della California. Fonte: Midjourney

Esploriamo i principi di funzionamento fondamentali dei modelli di diffusione e come stanno cambiando le direzioni e le norme del mondo come lo vediamo oggi.

Cosa sono i modelli di diffusione?

Secondo la pubblicazione di ricerca” Denoising Diffusion Probabilistic Models“, i modelli di diffusione sono definiti come:

“Un modello di diffusione o modello di diffusione probabilistica è una catena di Markov parametrizzata addestrata utilizzando l’inferenza variazionale per produrre campioni che corrispondono ai dati dopo un tempo finito ”

In poche parole, i modelli di diffusione possono generare dati simili a quelli su cui vengono addestrati. Se il modello si allena su immagini di gatti, può generare immagini realistiche simili di gatti.

Ora proviamo a scomporre la definizione tecnica menzionata sopra. I modelli di diffusione si ispirano al principio di funzionamento e al fondamento matematico di un modello probabilistico in grado di analizzare e prevedere il comportamento di un sistema che varia nel tempo, come la previsione del rendimento del mercato azionario o la diffusione della pandemia.

La definizione afferma che sono catene di Markov parametrizzate addestrate con inferenza variazionale. Le catene di Markov sono modelli matematici che definiscono un sistema che passa da uno stato all’altro nel tempo. Lo stato esistente del sistema può solo determinare la probabilità di transizione a uno stato specifico. In altre parole, lo stato corrente di un sistema contiene i possibili stati che un sistema può seguire o acquisire in un dato momento.

L’addestramento del modello utilizzando l’inferenza variazionale comporta calcoli complessi per le distribuzioni di probabilità. Ha lo scopo di trovare i parametri esatti della catena di Markov che corrispondono ai dati osservati (noti o effettivi) dopo un tempo specifico. Questo processo riduce al minimo il valore della funzione di perdita del modello, che è la differenza tra lo stato previsto (sconosciuto) e osservato (noto).

Una volta addestrato, il modello può generare campioni corrispondenti ai dati osservati. Questi campioni rappresentano possibili traiettorie o affermano che il sistema potrebbe seguire o acquisire nel tempo, e ogni traiettoria ha una diversa probabilità di verificarsi. Pertanto, il modello può prevedere il comportamento futuro del sistema generando una serie di campioni e trovando le rispettive probabilità (probabilità che questi eventi si verifichino).

Come interpretare i modelli di diffusione nell’IA?

I modelli di diffusione sono modelli generativi profondi che funzionano aggiungendo rumore (rumore gaussiano) ai dati di addestramento disponibili (noto anche come processo di diffusione in avanti) e quindi invertendo il processo (noto come denoising o processo di diffusione inversa) per recuperare i dati. Il modello impara gradualmente a rimuovere il rumore. Questo processo di denoising appreso genera nuove immagini di alta qualità da semi casuali (immagini rumorose casuali), come mostrato nell’illustrazione seguente.

Processo di diffusione inversa: un’immagine disturbata viene eliminata per recuperare l’immagine originale (o generare le sue variazioni) tramite un modello di diffusione addestrato. Fonte: Denoising Diffusion Probabilistic Models

3 categorie di modelli di diffusione

Ci sono tre strutture matematiche fondamentali che sono alla base della scienza alla base dei modelli di diffusione. Tutti e tre lavorano sugli stessi principi di aggiungere rumore e quindi rimuoverlo per generare nuovi campioni. Discutiamoli di seguito.

Un modello di diffusione aggiunge e rimuove rumore da un’immagine. Fonte: Modelli di diffusione nella visione: un sondaggio

1. Denoising Diffusion Probabilistic Models (DDPM)

Come spiegato sopra, i DDPM sono modelli generativi utilizzati principalmente per rimuovere il rumore dai dati visivi o audio. Hanno mostrato risultati impressionanti su varie attività di riduzione del rumore di immagini e audio. Ad esempio, l’industria cinematografica utilizza moderni strumenti di elaborazione di immagini e video per migliorare la qualità della produzione.

2. Modelli generativi basati su punteggio condizionato dal rumore (SGM)

Gli SGM possono generare nuovi campioni da una data distribuzione. Funzionano imparando una funzione del punteggio di stima che può stimare la densità logaritmica della distribuzione target. La stima della densità del registro presuppone che i punti dati disponibili facciano parte di un set di dati sconosciuto (set di test). Questa funzione di punteggio può quindi generare nuovi punti dati dalla distribuzione.

Ad esempio, i deep fake sono noti per la produzione di video e audio falsi di personaggi famosi. Ma sono per lo più attribuiti a Generative Adversarial Networks (GAN). Tuttavia, gli SGM hanno mostrato capacità simili, a volte migliori, nel generare volti di celebrità di alta qualità. Inoltre, gli SGM possono aiutare a espandere i set di dati sanitari, che non sono prontamente disponibili in grandi quantità a causa di normative e standard di settore rigorosi.

3. Equazioni differenziali stocastiche (SDE)

Le SDE descrivono i cambiamenti nei processi casuali relativi al tempo. Sono ampiamente utilizzati nei mercati fisici e finanziari che coinvolgono fattori casuali che hanno un impatto significativo sui risultati del mercato.

Ad esempio, i prezzi delle materie prime sono altamente dinamici e influenzati da una serie di fattori casuali. Le SDE calcolano i derivati finanziari come i contratti futures (come i contratti sul petrolio greggio). Possono modellare le fluttuazioni e calcolare i prezzi favorevoli in modo accurato per dare un senso di sicurezza.

Principali applicazioni dei modelli di diffusione nell’IA

Diamo un’occhiata ad alcune pratiche e usi ampiamente adattati dei modelli di diffusione nell’intelligenza artificiale.

Generazione di video di alta qualità

La creazione di video di fascia alta utilizzando il deep learning è impegnativa in quanto richiede un’elevata continuità dei fotogrammi video. È qui che i modelli di diffusione tornano utili in quanto possono generare un sottoinsieme di fotogrammi video da riempire tra i fotogrammi mancanti, ottenendo video fluidi e di alta qualità senza latenza.

I ricercatori hanno sviluppato il Modello di diffusione flessibile e Diffusione video residua per servire a questo scopo. Questi modelli possono anche produrre video realistici aggiungendo senza soluzione di continuità fotogrammi generati dall’intelligenza artificiale tra i fotogrammi effettivi.

Questi modelli possono semplicemente estendere gli FPS (fotogrammi al secondo) di un video FPS basso aggiungendo fotogrammi fittizi dopo aver appreso il modelli dai telai disponibili. Quasi senza perdita di fotogrammi, questi framework possono aiutare ulteriormente i modelli basati sul deep learning a generare da zero video basati sull’intelligenza artificiale che sembrano riprese naturali da configurazioni di cam di fascia alta.

Un’ampia gamma di straordinari video basati sull’intelligenza artificiale generators è disponibile nel 2023 per rendere la produzione e l’editing di contenuti video rapidi e semplici.

Generazione da testo a immagine

I modelli da testo a immagine utilizzano prompt di input per generare immagini di alta qualità immagini. Ad esempio, dando input”mela rossa su un piatto”e producendo un’immagine fotorealistica di una mela su un piatto. Diffusione combinata e unCLIP sono due esempi importanti di tali modelli che possono generare immagini altamente pertinenti e accurate in base all’input dell’utente.

Inoltre, GLIDE by OpenAI è un’altra soluzione ampiamente nota rilasciata nel 2021 che produce immagini fotorealistiche utilizzando l’input dell’utente. Successivamente, OpenAI ha rilasciato DALL.E-2, il suo modello di generazione di immagini più avanzato.

Allo stesso modo, Google ha anche sviluppato un modello di generazione di immagini noto come Imagen, che utilizza un modello di linguaggio di grandi dimensioni per sviluppare una profonda comprensione testuale del testo di input e quindi genera immagini fotorealistiche.

Abbiamo citato altri popolari strumenti di generazione di immagini come Midjourney e Diffusione stabile (DreamStudio) sopra. Dai un’occhiata a un’immagine generata utilizzando la diffusione stabile di seguito.

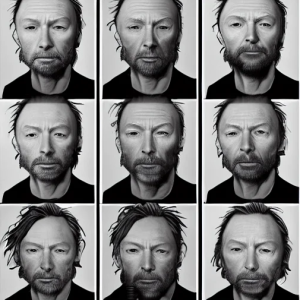

Un’immagine creata con Stable Diffusion 1.5 utilizzando il seguente prompt:”collage, iperrealistico, molte variazioni ritratto di thom yorke molto vecchio, variazioni del volto, cantautore, ( lato ) profilo, varie età, obiettivo macro, spazio liminale, di lee bermejo, alphonse mucha e greg rutkowski, barba grigia, viso liscio, zigomi”

Modelli di diffusione nell’IA: cosa aspettarsi in futuro?

I modelli di diffusione hanno rivelato un potenziale promettente come approccio solido alla generazione di campioni di alta qualità da complessi set di dati di immagini e video. Migliorando la capacità umana di utilizzare e manipolare i dati, i modelli di diffusione possono potenzialmente rivoluzionare il mondo come lo vediamo oggi. Possiamo aspettarci di vedere ancora più applicazioni dei modelli di diffusione diventare parte integrante della nostra vita quotidiana.

Detto questo, i modelli di diffusione non sono l’unica tecnica di IA generativa. I ricercatori utilizzano anche Generative Adversarial Networks (GAN), Variational Autoencoders e modelli generativi profondi basati sul flusso per generare contenuti AI. Comprendere le caratteristiche fondamentali che differenziano i modelli di diffusione da altri modelli generativi può aiutare a produrre soluzioni più efficaci nei prossimi giorni.