เหตุใด Generative AI จึงเป็นเรื่องยุ่งยากในตอนนี้

Generative AI เช่น Bing Ai, ChatGPT และล่าสุด ได้รับความสนใจจากการใช้อัลกอริทึมขั้นสูงเพื่อสร้างข้อมูล ภาพใหม่ และอีกมากมายที่ดู รู้สึก และอ่านได้ราวกับว่ามันถูกสร้างขึ้นโดยมนุษย์ Generative Adversarial Networks (GAN) เหมาะอย่างยิ่งสำหรับการสร้างเนื้อหาภาพ ในขณะที่โมเดลภาษา Generative Pre-Trained (GPT) จะแยกวิเคราะห์ข้อมูลที่มีอยู่แล้วบนอินเทอร์เน็ต (หรือวิธีอื่น) เพื่อสร้างเอาต์พุต เช่น คำตอบสำหรับคำถามตลอดทาง เพื่อผลิตบทความ’ใหม่’ทั้งหมด การใช้ AI สำหรับแง่มุมเหล่านี้ไม่ใช่เรื่องใหม่ แต่ความก้าวหน้าในการทำความเข้าใจข้อความค้นหาเหล่านี้และการสร้างผลลัพธ์ที่ใช้งานได้ง่ายขึ้น อ่านออกได้ง่าย และสัมพันธ์กับผู้ใช้ทั่วไปคือสิ่งที่ทำให้ AI เชิงสร้างสรรค์เป็นเครื่องมือที่มีศักยภาพ

แน่นอนว่าข้อกังวลเหล่านี้ยังเป็นที่ถกเถียงและมีอยู่มากมาย แต่นี่ยังเป็นแค่วันแรกๆ ถึงกระนั้น เทคโนโลยีนี้เหมาะอย่างยิ่งสำหรับการสร้างข้อมูลเพิ่มเติมเพื่อฝึกฝนและปรับปรุงโมเดลต่างๆ ที่สามารถติดตามงานที่ธรรมดาหรือธรรมดาหลายๆ อย่างได้อย่างรวดเร็ว ซึ่งต้องการการอนุมานในรูปแบบใดรูปแบบหนึ่งเพื่อก้าวไปสู่ขั้นต่อไปที่ดีที่สุด และแม้แต่การทำให้รถยนต์ยานยนต์เต็มรูปแบบเป็นจริงได้ ที่ซึ่งแบบจำลองการจำลองการขับขี่ยานยนต์ได้รับการฝึกอบรมอย่างต่อเนื่องผ่านการสร้างและฝึกอบรมข้อมูลด้านสิ่งแวดล้อมใหม่ๆ ที่หลากหลายแบบไม่รู้จบ ดังนั้นจึงสร้างแบบจำลองที่ได้รับการฝึกอบรมล่วงหน้าอย่างมั่นคงยิ่งขึ้น

อ่านข้อมูลเพิ่มเติมเกี่ยวกับเรื่องนี้จากบริษัทที่ปรึกษาระดับโลก McKinsey & Company สำหรับ ข้อมูลเชิงลึกเพิ่มเติม และ อุตสาหกรรมต่างๆ ที่ได้รับประโยชน์จาก AI กำเนิด

เข้าสู่ NVIDIA AI Foundations: ช่วยให้บริษัทต่างๆ สามารถสร้างโมเดล generative AI แบบกำหนดเองภายในบริษัทได้

ตอนนี้เรารู้แล้วว่าทำไม Generative AI จึงมีค่าและสำคัญมาก ซึ่งนำเราไปสู่ความยิ่งใหญ่ของ NVIDIA ผลักดันการสนับสนุนองค์กรด้วยบริการคลาวด์เพื่อสร้างโมเดลภาษาขนาดใหญ่ที่ปรับแต่งเอง (LLM ซึ่ง ChatGPT เป็นตัวอย่างที่สำคัญ) และโมเดลการสร้างภาพสำหรับแอปพลิเคชัน AI โดยเฉพาะอย่างยิ่ง โมเดล AI กำเนิดที่กำหนดเองเหล่านี้ได้รับการพัฒนาและฝึกฝนด้วยข้อมูลที่เป็นกรรมสิทธิ์ของบริษัทเองสำหรับข้อเสนอเฉพาะโดเมนของพวกเขา

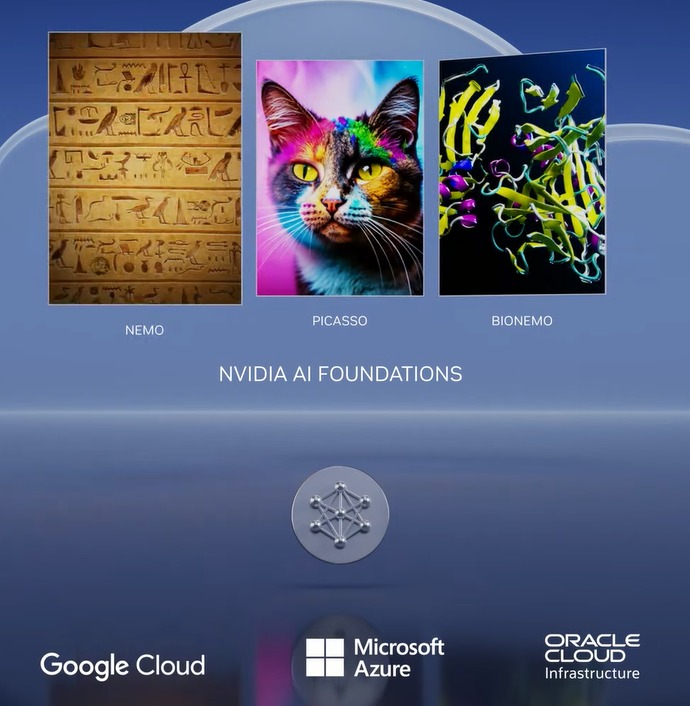

สิ่งนี้เกิดขึ้นได้ด้วย NVIDIA AI Foundations ซึ่งเป็นชุดบริการคลาวด์ที่ช่วยให้ธุรกิจสามารถสร้าง ปรับแต่ง และดำเนินการ LLM ดังกล่าวได้ และโมเดล AI เชิงกำเนิด

บริการคลาวด์ NVIDIA NeMo ช่วยให้นักพัฒนาสร้างโมเดลภาษาขนาดใหญ่ (LLM) ที่เกี่ยวข้องมากขึ้นสำหรับธุรกิจโดยการกำหนดจุดสนใจ เพิ่มความรู้เฉพาะโดเมน และสอนทักษะการทำงาน

NVIDIA Picasso เป็นบริการคลาวด์สำหรับสร้างและปรับใช้แอปพลิเคชันภาพ วิดีโอ และ 3 มิติที่ขับเคลื่อนด้วย AI พร้อมความสามารถในการแปลงข้อความเป็นรูปภาพ ข้อความเป็นวิดีโอ และข้อความเป็น 3 มิติขั้นสูง เพื่อเพิ่มผลผลิตให้กับความคิดสร้างสรรค์ การออกแบบ และการจำลองแบบดิจิทัลผ่าน Cloud API ที่เรียบง่าย

NVIDIA BioNeMo เป็นบริการคลาวด์ใหม่ที่เปิดตัวในวันนี้เพื่อเร่งการวิจัยด้านชีววิทยาศาสตร์ การค้นคว้ายา วิศวกรรมโปรตีน และการวิจัยในสาขาจีโนมิกส์ ชีววิทยา เคมี และไดนามิกแบบโมดูลาร์

บริการเหล่านี้ทำงานบน NVIDIA DGX Cloud ซึ่งสามารถเข้าถึงได้ผ่านเบราว์เซอร์ ขณะนี้มีให้สำหรับลูกค้าที่เข้าถึงก่อนใครและอยู่ในขั้นตอนการดูตัวอย่างส่วนตัว นักพัฒนาสามารถใช้โมเดลเหล่านี้ที่มีให้ในแต่ละบริการผ่าน API อย่างง่าย และเมื่อโมเดลพร้อมสำหรับการปรับใช้ องค์กรต่างๆ สามารถเรียกใช้เวิร์กโหลดการอนุมานตามขนาดโดยใช้บริการคลาวด์ NVIDIA AI Foundations

ผู้นำในอุตสาหกรรมร่วมมือกับ NVIDIA เพื่อ เพิ่มประสิทธิภาพการทำงานขั้นสูงสำหรับมืออาชีพด้านความคิดสร้างสรรค์

Adobe ประกาศในวันนี้ว่าพวกเขาจะขยายความร่วมมือด้านการวิจัยและพัฒนาที่มีมาอย่างยาวนานเพื่อสร้างโมเดล AI เจเนอเรทีฟเจเนอเรชันถัดไปด้วย NVIDIA เพื่อเร่งเวิร์กโฟลว์ของผู้สร้างและนักการตลาด โมเดลเหล่านี้บางรุ่นจะได้รับการพัฒนาร่วมกันและนำออกสู่ตลาดผ่านผลิตภัณฑ์หลักของ Adobe Creative Cloud เช่น Photoshop, Premiere Pro และ After Effects รวมถึงผ่าน NVIDIA Picasso

NVIDIA และ เก็ตตี้อิมเมจ กำลังทำงานร่วมกันเพื่อฝึกโมเดลพื้นฐานของการสร้างข้อความเป็นรูปภาพและข้อความเป็นวิดีโอที่มีความรับผิดชอบ แบบจำลองจะอนุญาตให้สร้างภาพและวิดีโอโดยใช้ข้อความแจ้งง่ายๆ และจะได้รับการฝึกอบรมเกี่ยวกับทรัพย์สินที่ได้รับอนุญาตอย่างเต็มรูปแบบของ Getty Images

NVIDIA และ Shutterstock กำลังทำงานร่วมกันเพื่อฝึกข้อความเชิงสร้างสรรค์-to-3D โมเดลพื้นฐานโดยใช้บริการ NVIDIA Picasso เพื่อลดความซับซ้อนของการสร้างโมเดล 3D ที่มีรายละเอียด และลดเวลาที่ต้องใช้ในการสร้างโมเดล 3D จากวันเหลือเป็นนาที

GPU ใหม่ขับเคลื่อนแพลตฟอร์มการอนุมานเพื่อจัดการกับ Generative AI ต่างๆ ปริมาณงาน

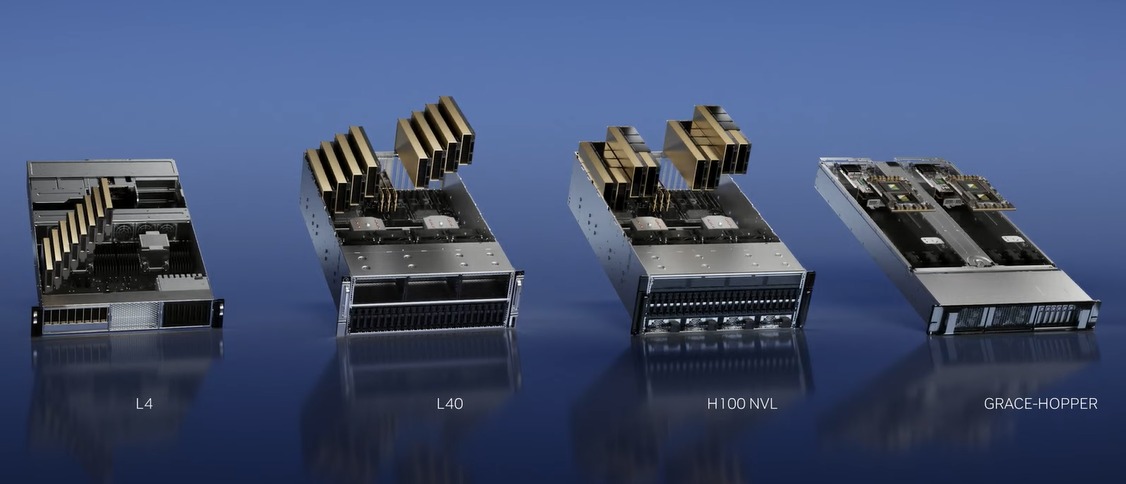

เพื่อเพิ่มแรงผลักดันของ NVIDIA ในการช่วยสร้างโมเดล AI แบบสร้างเองใหม่และเกิดใหม่ผ่านบริการคลาวด์ของ NVIDIA Foundation พวกเขายังได้เปิดตัว GPU และแพลตฟอร์มใหม่ๆ เพื่อช่วยนักพัฒนาในการสร้างและขับเคลื่อนแอพพลิเคชั่น AI ใหม่เหล่านี้โดยใช้ NVIDIA Ada Lovelace โปรเซสเซอร์ Hopper และ Grace Hopper

การเพิ่มขึ้นของ AI เชิงกำเนิดนั้นต้องการการอนุมานที่ทรงพลังมากขึ้น e แพลตฟอร์มคอมพิวเตอร์ จำนวนการใช้งานสำหรับ generative AI นั้นไม่มีที่สิ้นสุด ถูกจำกัดด้วยจินตนาการของมนุษย์เท่านั้น การติดอาวุธให้นักพัฒนาด้วยแพลตฟอร์มการคำนวณอนุมานที่ทรงพลังและยืดหยุ่นที่สุดจะช่วยเร่งการสร้างบริการใหม่ที่จะปรับปรุงชีวิตของเราในแบบที่ยังไม่สามารถจินตนาการได้ – Jensen Huang ผู้ก่อตั้งและ CEO ของ NVIDIA

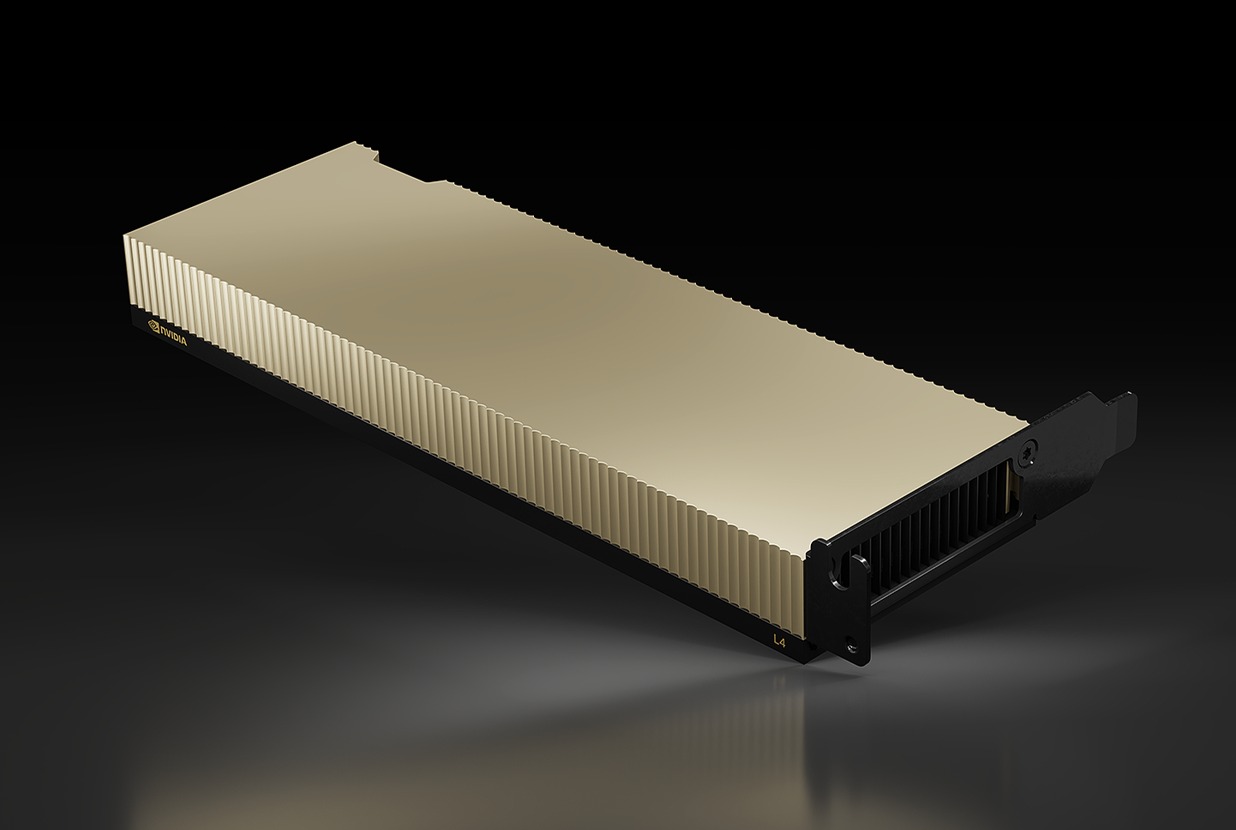

1) NVIDIA L4 สำหรับวิดีโอ AI

NVIDIA L4 ใหม่เป็นการแทนที่โดยตรงกับ T4 GPU ยอดนิยม ซึ่งเป็นรุ่นแรกที่ใช้ Tensor Cores และออกแบบมาโดยเฉพาะสำหรับเวิร์กโหลดการอนุมานของ AI เพื่อวิเคราะห์อินพุตข้อมูลใหม่เพื่อทำนายและ ประเมินผลลัพธ์ที่ต้องการตามแบบจำลองที่ได้รับการฝึกอบรมล่วงหน้า

T4 ขับเคลื่อนโดย Turing microarchitecture ซึ่งเป็นรุ่นแรกที่รองรับและเร่งความเร็วปริมาณงานแบบ ray traced L4 ใหม่ซึ่งใช้สถาปัตยกรรม Ada Lovelace GPU (ซึ่งเป็นขุมพลังของ GeForce RTX 40 ซีรีส์) ที่สนับสนุน DLSS 3 ที่ขับเคลื่อนด้วย AI ได้รับการจัดอันดับให้มอบประสิทธิภาพการเรนเดอร์ตามเวลาจริงที่เร็วขึ้นกว่า Omniverse ถึง 4 เท่า และสามารถทำลายล้าง ประสิทธิภาพการติดตามเรย์ที่สูงขึ้น 3 เท่า

ด้วยทรูพุตที่ได้รับการปรับปรุงนี้ GPU L4 จึงอยู่ในตำแหน่งสำหรับเวิร์กโหลดวิดีโอ AI สำหรับจัดการกับการถอดรหัสวิดีโอแบบเรียลไทม์ การแปลงรหัส การควบคุมเนื้อหาวิดีโอ การแปลภาษา ฟีเจอร์การปรับปรุงแฮงเอาท์วิดีโอ เช่น เป็นการเปลี่ยนพื้นหลัง การจัดแสงใหม่ การสบตา ความจริงเสริม และอื่นๆ ตัวเข้ารหัส AV1 คู่ของ GPU ใหม่ยังเป็นเหตุผลที่ยอดเยี่ยมว่าทำไม L4 จึงเหมาะสำหรับงานวิดีโอ AI เหล่านี้ ในความเป็นจริง เซิร์ฟเวอร์ 8-GPU L4 ตัวเดียวสามารถแทนที่เซิร์ฟเวอร์ซีพียูซ็อกเก็ตคู่แบบเดิมกว่าร้อยเซิร์ฟเวอร์ในการประมวลผลวิดีโอ AI นี่เป็นการประหยัดค่าใช้จ่ายโดยรวมในการเป็นเจ้าของได้อย่างมากเมื่อเทียบกับโครงสร้างพื้นฐานรุ่นเก่า

ยิ่งไปกว่านั้น L4 ยังได้รับการออกแบบในฟอร์มแฟกเตอร์ที่มีรายละเอียดต่ำแบบเดียวกันและมีกำลังไฟ 72W ที่ต่ำกว่าเล็กน้อย ซึ่งทำให้การอัพเกรด T4 ที่มีอยู่ เซิร์ฟเวอร์ที่มี L4 เป็นเรื่องง่าย ในขณะที่ปรับปรุงประสิทธิภาพการอนุมานของ AI ด้วยส่วนต่างที่ดี

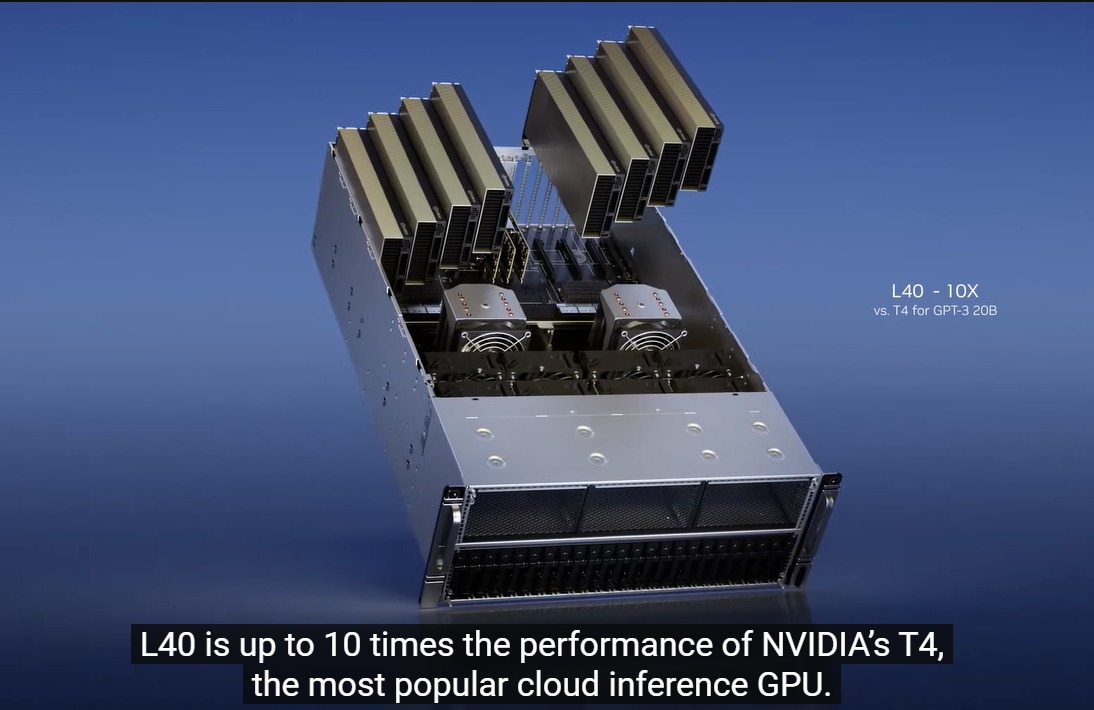

2) L40 สำหรับการสร้างอิมเมจ

L40 ได้รับการประกาศจริงในปี 2022 แต่เมื่อไม่นานมานี้มีการดำเนินการบางอย่าง จาก Ada Lovelace RTX GPU ที่มีคอร์ประมวลผลมากกว่า 18,000 CUDA และ 142 RT Cores ทำให้ L40 อัดแน่นไปด้วยคุณสมบัติที่เหนือกว่า RTX 4090 แต่แตกต่างจาก RTX 4090 ที่ได้รับการปรับให้เหมาะสมสำหรับความเร็วสัญญาณนาฬิกาสูง การแรสเตอร์และประสิทธิภาพการติดตามด้วยรังสีพร้อมการระบายความร้อนแบบแอคทีฟและงบประมาณด้านพลังงานที่สูงขึ้น L40 เป็นการออกแบบที่ระบายความร้อนแบบพาสซีฟด้วย 300W TDP และหมายถึงการใช้ประโยชน์จากเส้นทางการไหลของอากาศที่ออกแบบภายใน แร็คเซิร์ฟเวอร์

L40 ยังบรรจุหน่วยความจำ GDDR6 ขนาด 48GB พร้อม ECC ซึ่งสมบูรณ์แบบสำหรับ Omniverse Enterprise, การเรนเดอร์, กราฟิก 3D, เวิร์กสเตชันเสมือน NVIDIA RTX, การฝึกอบรม AI และวิทยาศาสตร์ข้อมูล อันที่จริงแล้ว มันคือแกนหลักของเซิร์ฟเวอร์ NVIDIA OVX ที่มีไว้สำหรับสร้าง Omniverse แฝดดิจิทัลขนาดใหญ่

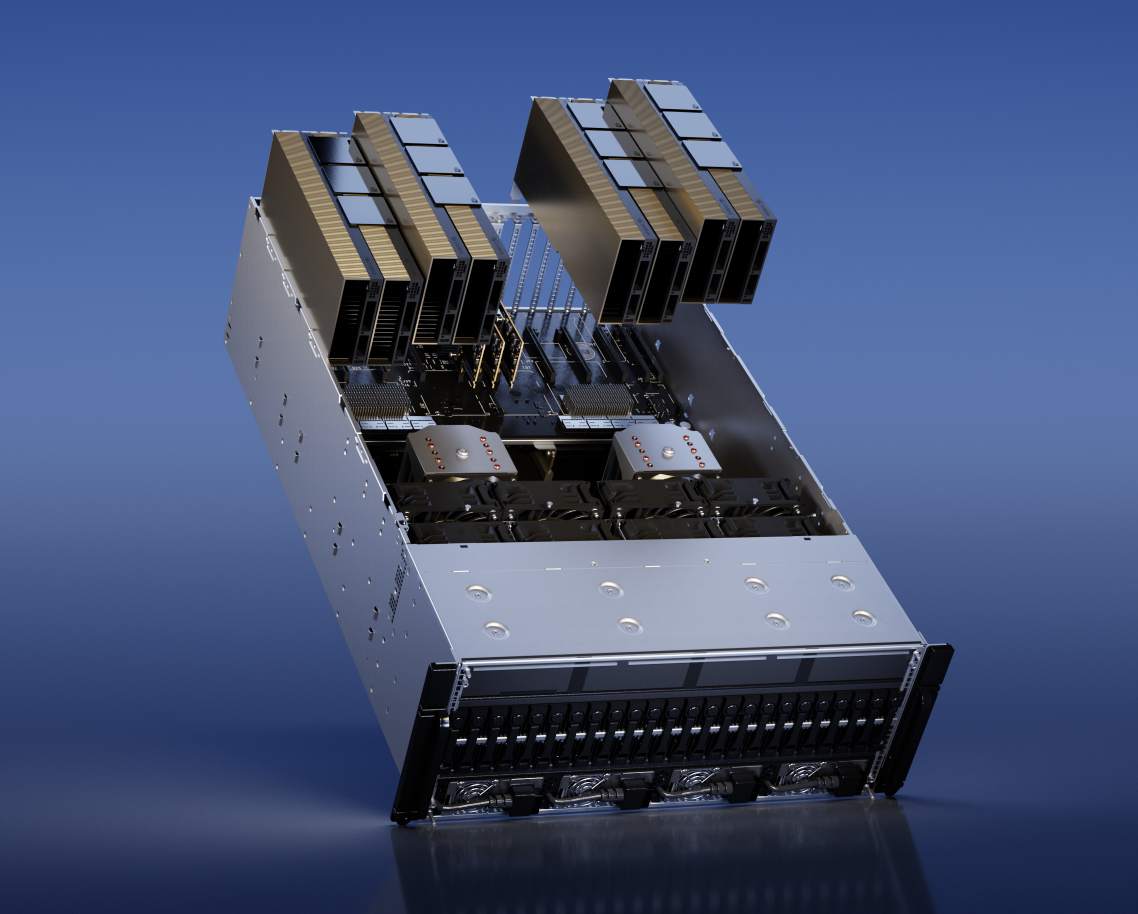

3) H100 NVL สำหรับการปรับใช้โมเดลภาษาขนาดใหญ่ (LLM)

สถาปัตยกรรม Hopper GPU ที่ใช้ H100 เป็นผลิตภัณฑ์ที่ยอดเยี่ยมที่เน้นสำหรับศูนย์ข้อมูล การเร่งความเร็วของ AI เนื่องจากไม่ต้องใช้ RT Core และบรรจุในอินเทอร์เฟซหน่วยความจำที่เร็วกว่ามากเพื่อเชื่อมต่อกับหน่วยความจำ HBM เร็วพอๆ กับ H100 NVIDIA ทราบดีอยู่แล้วว่าต้องทำอะไรมากกว่านี้เพื่อเป็นตัวขับเคลื่อนบริการสร้าง AI เช่น ChatGPT ในวงกว้าง ที่ GTC 2023 NVIDIA ได้ประกาศการ์ด PCIe คู่ที่ใช้ H100 NVL ซึ่งเป็น NVLink ซึ่งกันและกัน เพื่อให้เหมาะสมกว่าผลิตภัณฑ์ H100 PCIe ที่มีอยู่สองรายการ (บรรจุหน่วยความจำ 80GB) H100 NVL ใหม่บรรจุใน 94GB ต่อผลิตภัณฑ์ สำหรับ หน่วยความจำกราฟิกทั้งหมด 188GB ซึ่งมีกราฟิก 7.8TB/s แบนด์วิธของหน่วยความจำ นอกจากนี้ การกำหนดค่า GPU ของ H100NVL ยังเหมือนกับ H100 SXM SKU ดังนั้น H100 NVL จึงเร็วกว่า H100 PCIe มาก แม้ว่าอันหลังจะเป็น NVLink’ed ก็ตาม

ตามข้อมูลของ NVIDIA H100 เซิร์ฟเวอร์ที่ติดตั้ง NVL (พร้อม H100 NVL แบบ Quad) นั้น เร็วกว่า 10 เท่า กว่าเซิร์ฟเวอร์ HGX A100 (H100 SXM แปดตัว) ในการประมวลผล GPT-3 นั่นคือการประมวลผลโมเดลภาษาที่เพิ่มขึ้นอย่างน่าอัศจรรย์

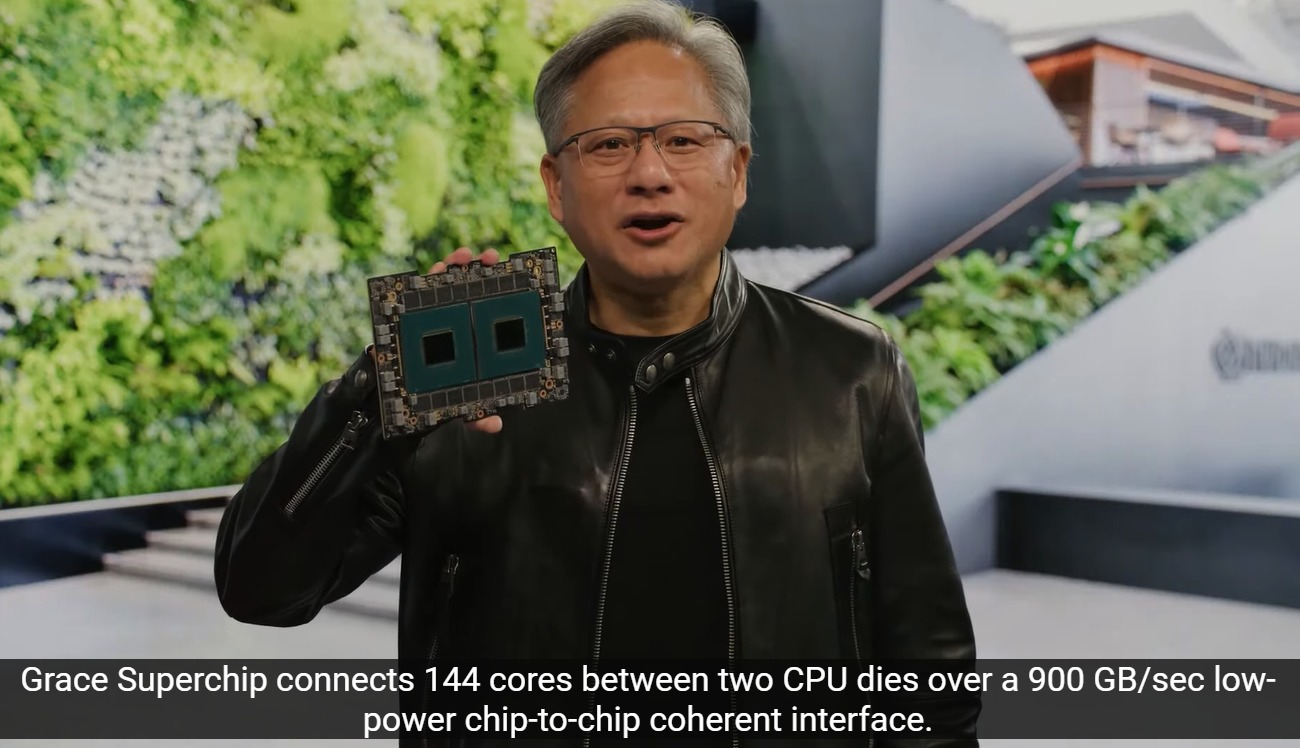

4) NVIDIA Grace Hopper สำหรับโมเดลคำแนะนำ

สุดท้าย NVIDIA ยังมีชิปพิเศษ Grace Hopper เพื่อประมวลผลชุดข้อมูลขนาดยักษ์ในฐานข้อมูล AI และแบบจำลองคำแนะนำกราฟ โดยที่โมดูลนี้เร็วมากและต่ำมาก-ความหน่วงแบบชิปต่อชิป NVLink-C2C ช่วยให้สามารถเชื่อมต่อแบนด์วิธได้มากกว่า 900GB/s ระหว่างชิป Grace ที่ใช้ ARM และ Hopper GPU ซึ่งช่วยให้สามารถประมวลผลการสืบค้นข้อมูลขนาดใหญ่บน CPU จากนั้นจึงถ่ายโอนไปยัง Hopper GPU ทันทีเพื่อการประมวลผลการอนุมานที่เร็วกว่า PCI Express 5.0 ถึง 7 เท่า